近年、医療や保険、行政の分野で「死亡リスク予測AI」という言葉を耳にする機会が増えました。AIが人の死を予言するかのような響きは、私たちに本能的な拒絶感や、SF映画のようなディストピア的な不安を抱かせます。しかし、この技術の是非を「感情的な善悪」や「精度の高さ」だけで議論していては、本質的な課題を見失うことになります。本記事では、この技術が実際に何をしているのかを紐解き、医療構造や意思決定の在り方という観点から、その有用性と危うさを構造的に整理していきます。

1. 導入:なぜ「死を予測するAI」に私たちは揺れるのか

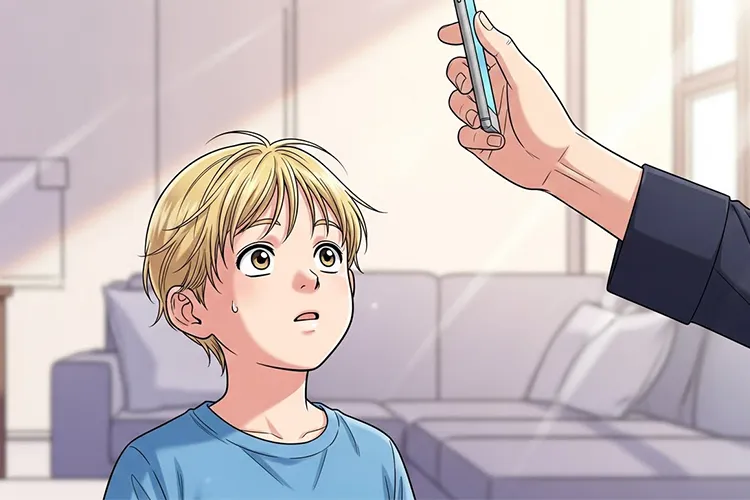

「あなたが5年以内に亡くなる確率は〇〇%です」。もしAIにこう告げられたら、私たちはどう感じるでしょうか。

現在、電子カルテの膨大な診療データや生活習慣のログを解析し、特定の病気による死亡率や、数年以内の生存確率を算出するアルゴリズムの開発が進んでいます。この技術が注目される背景には、慢性的な医療リソースの不足や、個別化医療(パーソナライズド・メディシン:患者一人ひとりの特性に合わせた医療)への期待があります。

一方で、この技術は常に「AIが人の生死を支配するのではないか」という恐怖や、「命に順位をつける道具になるのでは」という疑念を伴います。私たちが感じる違和感の正体は、AIの計算結果が「客観的な事実」として扱われ、人間の尊厳が数字に置き換えられてしまうことへの危惧にあるのかもしれません。まずは、このAIが「未来を予言する魔法の杖」ではないという事実から整理を始めましょう。

2. 死亡リスク予測AIは何をしているのか

「未来の的中」ではなく「過去の投影」

死亡リスク予測AIが算出しているのは、物理的な未来の予言ではありません。正体は、過去の膨大なデータに基づいた「統計的な相関関係の提示」です。

例えば、「Aという疾患があり、Bという数値が基準値を超え、Cという生活習慣を持つ集団」が、過去の統計で5年以内にどの程度の割合で亡くなったかを計算し、その傾向を目の前の個人に当てはめています。

※(図:死亡リスク予測AIの仕組み概念図)

個人予測と集団傾向の乖離

ここで重要なのは、AIが示す「死亡リスク80%」という数字の解釈です。これは「その人が8割の確率で死ぬ」という意味ではなく、「その人と似た属性を持つ100人のうち、80人が亡くなった」という集団的な傾向を指しています。

AIは生物学的なメカニズム(なぜ死に至るのか)を理解しているわけではなく、あくまでデータのパターンを見出しているに過ぎません。そのため、データの偏り(バイアス)があれば、予測結果も当然歪みます。精度が向上しても、それは「過去の再現」の精度が上がったのであり、個別の未来が確定したわけではないという構造的な限界を理解する必要があります。

3. 実際に役立つ場面と、その前提条件

では、この「確率の提示」は社会のどこで役立つのでしょうか。主な活用シーンは、個人の選別ではなく、「適切なリソース配置」と「意思決定の支援」にあります。

医療現場における「気づき」の提供

多忙な医療現場では、容体が急変する予兆を見落とすリスクが常にあります。AIがバイタルデータから「急変・死亡リスクの高まり」を検知しアラートを出すことで、医師が早期に介入し、救える命を救うためのトリアージ(治療優先度の判定)の補助として機能します。

制度設計と公衆衛生

行政レベルでは、地域ごとの死亡リスク傾向を分析することで、特定の疾患に対する予防策を重点的に配分するなどの政策判断に活用できます。これは「個人の死」を当てるためではなく、「集団の生存率」を上げるための戦略的なデータ活用です。

判断の主体はあくまで「人間」

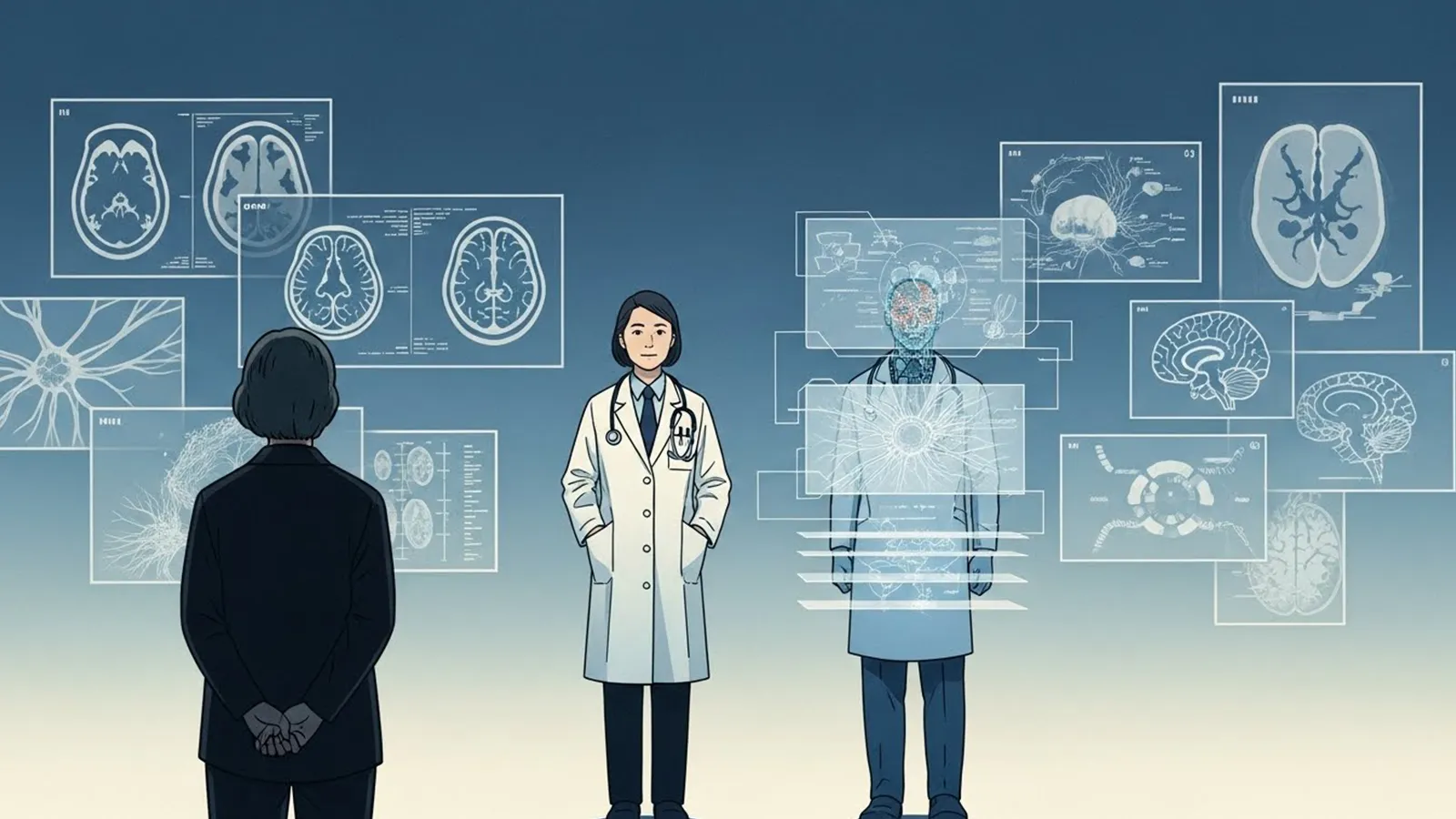

これらの活用における絶対的な前提は、「AIは情報提供者であり、決定権者ではない」という点です。AIの予測結果を、医師が患者と対話し、その人の価値観や生活背景を汲み取った上で最終的な治療方針を決めるための「材料の一つ」として扱う。この役割分担が維持される限り、AIは強力な味方となります。

※(図:AI予測と人間判断の役割分担イメージ)

4. 危険性が顕在化しやすい利用領域

しかし、AIの予測が「人間の判断」をバイパスし、直接的な不利益を生む領域では、そのリスクは一気に跳ね上がります。

保険とリソース配分のジレンマ

民間保険において、AIの予測に基づき「死亡リスクが高い」と判定された人の保険料が高騰したり、加入を拒否されたりする事態は容易に想像できます。また、高度な医療資源(移植手術や高額薬剤など)の配分をAIの生存予測スコアだけで機械的に決定するようになれば、それは「命の選別」そのものです。

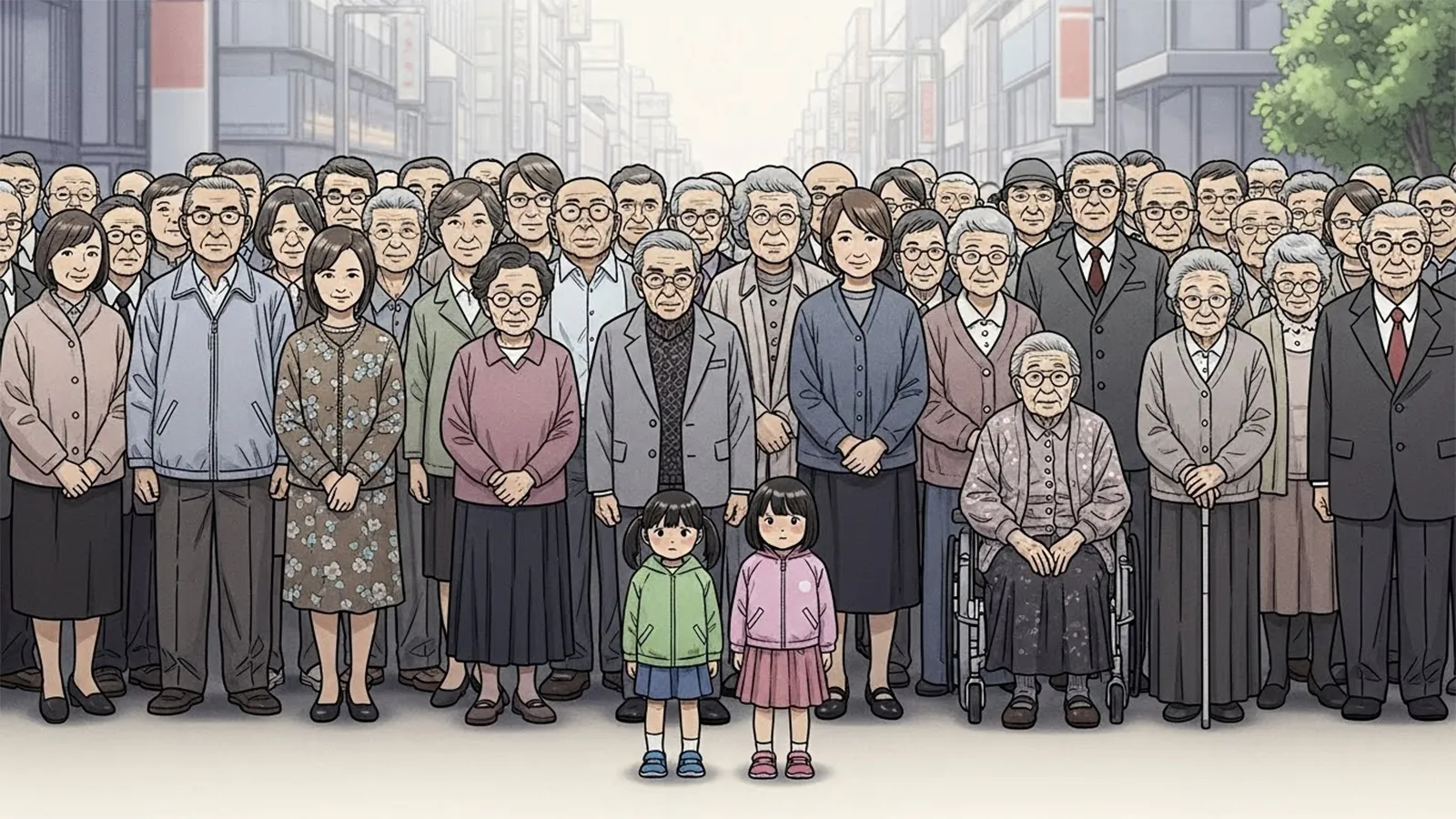

社会的弱者への不利益

AIの学習データに「経済的困窮者は死亡リスクが高い」という傾向が含まれていた場合、AIはその属性を持つ人に低い評価を下します。結果として、社会的な支援が必要な層が、AIの判断によってさらに公的サービスや医療から遠ざけられるという「負のフィードバック」が働く危うさがあります。ここで混同してはならないのは、「リスクの予測(計算)」と「誰を助けるべきかという価値判断(倫理)」は全く別物であるという点です。

5. 問題の本質はAIの精度ではない

多くの議論は「AIの精度をどこまで高められるか」に向けられがちですが、それは本質的な解決策ではありません。

精度が100%に近づくほど高まるリスク

皮肉なことに、AIの予測精度が上がれば上がるほど、人間はその判断を「不可避な運命」と捉え、抗うことをやめてしまうリスクが生じます。「AIがこう言っているから、この治療は無駄だ」という思考停止は、対話による合意形成を破壊します。

社会の価値観を「鏡」のように映し出す

AIは私たちが与えた過去のデータを学習します。もし過去の社会に差別や偏見、非効率な慣習があれば、AIはそれらを「正解」として学習し、より強固な形で出力します。つまり、死亡リスク予測AIの問題は、技術の問題ではなく「私たちがどのような価値基準で社会を運営したいか」という制度設計の問題なのです。誰が、どの立場で、どのように使うのかという設計の重要性こそが、精度議論よりも遥かに重要です。

6. まとめ:問い直される「人間の役割」

死亡リスク予測AIは、決して万能な予言者ではありません。しかし、人間の直感や経験では捉えきれないデータの相関を可視化し、より良い医療や社会制度を作るための強力なツールになり得るのも事実です。

この技術を社会に実装する上で問われているのは、AIのアルゴリズムではなく、それを使う私たちの「意志」です。「効率化」の名の下に判断をAIに丸投げするのか、それともAIが提示する数字を「人間がより深く、誠実に判断するための手がかり」として活用するのか。AIに何を任せ、何を人間が担い続けるのか。その境界線を、私たちは常に問い直し続けなければなりません。技術の進化は、私たちに「命の価値をどう定義するか」という、古くて新しい問いを突きつけているのです。

【テーマ】

医療・保険・行政などで活用が進みつつある

「死亡リスク予測AI」は本当に社会にとって役立つ技術なのか。

その有用性と限界、倫理的リスクについて、

精度論や感情論に偏らず、

医療構造・制度設計・意思決定の在り方という観点から

AIの視点で冷静かつ構造的に整理・考察してください。

【目的】

– 「AIは人の生死を決めるのか」といった過剰な恐怖論や陰謀論を避ける

– 死亡リスク予測AIが実際に“何をしている技術なのか”を正確に整理する

– 医療・保険・行政での活用が持つメリットと危うさを可視化する

– 読者が「AIに判断を委ねる」とはどういうことかを考えるための判断軸を提供する

【読者像】

– 一般社会人(20〜50代)

– 医療・保険・テクノロジーのニュースに関心はあるが専門家ではない層

– AIの進化に期待と不安の両方を感じている人

– 「効率化」と「人の尊厳」のバランスに違和感を覚えたことがある読者

【記事構成】

1. 導入(問題提起)

– 「AIが死亡リスクを予測する時代」という言葉が与える違和感を提示する

– なぜこの技術が注目され、不安や誤解を生みやすいのかを整理する

– 本記事では是非や善悪を即断せず、構造として考察する姿勢を示す

2. 死亡リスク予測AIは何をしているのか

– 「未来を当てるAI」ではないことを明確にする

– 過去データに基づく確率推定である点を説明する

– 個人予測と集団傾向の違いを整理する

– 精度の高さと限界が同時に存在する理由を構造的に説明する

3. 実際に役立つ場面と、その前提条件

– 医療現場での補助的利用(トリアージ、治療方針検討など)

– 公衆衛生・制度設計における集団レベルでの活用

– 「判断の主体が人間であること」が前提である点を明確にする

4. 危険性が顕在化しやすい利用領域

– 保険、医療資源配分、行政判断への直接利用の問題点

– 高齢者・持病者・社会的弱者が不利になりやすい構造

– 「予測」と「価値判断」が混同されるリスクを整理する

5. 問題の本質はAIの精度ではない

– なぜ精度議論だけでは不十分なのかを説明する

– 誰が、どの立場で、どのように使うのかという設計の重要性

– AIが社会の価値観を“反映してしまう”構造に触れる

6. まとめ

– 死亡リスク予測AIは万能でも無意味でもないことを再確認する

– 技術そのものよりも、使い方と制度設計が問われている点を強調する

– 読者が「AIに任せる判断」と「人が担う判断」を考える余白を残して締めくくる

【文体・トーン】

– です・ます調

– 煽情的・断定的にならず、冷静で構造的

– 専門用語は使用してよいが、必ず簡潔な補足説明を入れる

– 不安を煽るのではなく、思考材料を提供する文章とする

【執筆スタンス】

– 本記事は、特定の結論や是非を断定するものではない

– 技術・制度・倫理の複数要因を整理した「考察」として執筆する

– 読者が自分自身の立場で判断できる余白を重視する

【出力形式】

– Markdown形式で出力する

– 小見出し(###)を多めに使用する

– 文字数は2000〜2500字を目安とする

– 記事末尾に「タイトル案」を3つ提示する

【タイトル案に関する重要な指示(厳守)】

– タイトル案は必ず「主タイトルのみ」を出力すること

– サブタイトル・説明文・補足文は一切付けないこと

– 記号(―、──、—、:、| 等)による分割は禁止

– タイトルは1文構成とし、文を分割しないこと

– 説明的・総括的・煽情的な表現は禁止

– 「問い」の形を基本とし、読者に思考の余白を残すこと

– 文字数は25〜35文字程度を目安とする

– 抽象語のみで終わらず、問いの対象が分かる表現を必ず含めること

– 参考タイトルと同一、または類似度の高い表現は使用しないこと

– 条件を満たさないタイトルは出力しないこと

【補足指示】

– 構造整理が有効な箇所では、以下のようなコメントを挿入してよい

※(図:死亡リスク予測AIの仕組み概念図)

※(図:AI予測と人間判断の役割分担イメージ)

【参考タイトル(※構造参考のみ/出力・言い換え・再利用は禁止)】

「AIは人の生死を決められるのか」

【バージョン情報の出力】

記事本文・タイトル案のあとに、必ず以下の形式で

「AIバージョン情報」を追記してください。

(不明な項目は「不明」と記載すること)

—

AIバージョン情報

– ベンダー:

– モデル名:

– モデルバージョン:

– 回答日時:

「あなたが5年以内に亡くなる確率は〇〇%です」。もしAIにこう告げられたら、私たちはどう感じるでしょうか。

現在、電子カルテの膨大な診療データや生活習慣のログを解析し、特定の病気による死亡率や、数年以内の生存確率を算出するアルゴリズムの開発が進んでいます。この技術が注目される背景には、慢性的な医療リソースの不足や、個別化医療(パーソナライズド・メディシン:患者一人ひとりの特性に合わせた医療)への期待があります。

一方で、この技術は常に「AIが人の生死を支配するのではないか」という恐怖や、「命に順位をつける道具になるのでは」という疑念を伴います。私たちが感じる違和感の正体は、AIの計算結果が「客観的な事実」として扱われ、人間の尊厳が数字に置き換えられてしまうことへの危惧にあるのかもしれません。

まずは、このAIが「未来を予言する魔法の杖」ではないという事実から整理を始めましょう。

—

## 2. 死亡リスク予測AIは何をしているのか

### 「未来の的中」ではなく「過去の投影」

死亡リスク予測AIが算出しているのは、物理的な未来の予言ではありません。正体は、過去の膨大なデータに基づいた**「統計的な相関関係の提示」**です。

例えば、「Aという疾患があり、Bという数値が基準値を超え、Cという生活習慣を持つ集団」が、過去の統計で5年以内にどの程度の割合で亡くなったかを計算し、その傾向を目の前の個人に当てはめています。

※(図:死亡リスク予測AIの仕組み概念図)

### 個人予測と集団傾向の乖離

ここで重要なのは、AIが示す「死亡リスク80%」という数字の解釈です。これは「その人が8割の確率で死ぬ」という意味ではなく、**「その人と似た属性を持つ100人のうち、80人が亡くなった」**という集団的な傾向を指しています。

AIは生物学的なメカニズム(なぜ死に至るのか)を理解しているわけではなく、あくまでデータのパターンを見出しているに過ぎません。そのため、データの偏り(バイアス)があれば、予測結果も当然歪みます。精度が向上しても、それは「過去の再現」の精度が上がったのであり、個別の未来が確定したわけではないという構造的な限界を理解する必要があります。

—

## 3. 実際に役立つ場面と、その前提条件

では、この「確率の提示」は社会のどこで役立つのでしょうか。主な活用シーンは、個人の選別ではなく、**「適切なリソース配置」**と**「意思決定の支援」**にあります。

### 医療現場における「気づき」の提供

多忙な医療現場では、容体が急変する予兆を見落とすリスクが常にあります。AIがバイタルデータから「急変・死亡リスクの高まり」を検知しアラートを出すことで、医師が早期に介入し、救える命を救うためのトリアージ(治療優先度の判定)の補助として機能します。

### 制度設計と公衆衛生

行政レベルでは、地域ごとの死亡リスク傾向を分析することで、特定の疾患に対する予防策を重点的に配分するなどの政策判断に活用できます。これは「個人の死」を当てるためではなく、「集団の生存率」を上げるための戦略的なデータ活用です。

### 判断の主体はあくまで「人間」

これらの活用における絶対的な前提は、**「AIは情報提供者であり、決定権者ではない」**という点です。AIの予測結果を、医師が患者と対話し、その人の価値観や生活背景を汲み取った上で最終的な治療方針を決めるための「材料の一つ」として扱う。この役割分担が維持される限り、AIは強力な味方となります。

※(図:AI予測と人間判断の役割分担イメージ)

—

## 4. 危険性が顕在化しやすい利用領域

しかし、AIの予測が「人間の判断」をバイパスし、直接的な不利益を生む領域では、そのリスクは一気に跳ね上がります。

### 保険とリソース配分のジレンマ

民間保険において、AIの予測に基づき「死亡リスクが高い」と判定された人の保険料が高騰したり、加入を拒否されたりする事態は容易に想像できます。また、高度な医療資源(移植手術や高額薬剤など)の配分をAIの生存予測スコアだけで機械的に決定するようになれば、それは「命の選別」そのものです。

### 社会的弱者への不利益

AIの学習データに「経済的困窮者は死亡リスクが高い」という傾向が含まれていた場合、AIはその属性を持つ人に低い評価を下します。結果として、社会的な支援が必要な層が、AIの判断によってさらに公的サービスや医療から遠ざけられるという**「負のフィードバック」**が働く危うさがあります。

ここで混同してはならないのは、**「リスクの予測(計算)」と「誰を助けるべきかという価値判断(倫理)」は全く別物である**という点です。

—

## 5. 問題の本質はAIの精度ではない

多くの議論は「AIの精度をどこまで高められるか」に向けられがちですが、それは本質的な解決策ではありません。

### 精度が100%に近づくほど高まるリスク

皮肉なことに、AIの予測精度が上がれば上がるほど、人間はその判断を「不可避な運命」と捉え、抗うことをやめてしまうリスクが生じます。「AIがこう言っているから、この治療は無駄だ」という思考停止は、対話による合意形成を破壊します。

### 社会の価値観を「鏡」のように映し出す

AIは私たちが与えた過去のデータを学習します。もし過去の社会に差別や偏見、非効率な慣習があれば、AIはそれらを「正解」として学習し、より強固な形で出力します。つまり、死亡リスク予測AIの問題は、技術の問題ではなく**「私たちがどのような価値基準で社会を運営したいか」という制度設計の問題**なのです。

誰が、どのような目的でそのスコアを使い、その結果に対して誰が責任を負うのか。このガバナンス(統治)の設計こそが、精度議論よりも遥かに重要です。

—

## 6. まとめ:問い直される「人間の役割」

死亡リスク予測AIは、決して万能な予言者ではありません。しかし、人間の直感や経験では捉えきれないデータの相関を可視化し、より良い医療や社会制度を作るための強力なツールになり得るのも事実です。

この技術を社会に実装する上で問われているのは、AIのアルゴリズムではなく、それを使う私たちの「意志」です。「効率化」の名の下に判断をAIに丸投げするのか、それともAIが提示する数字を「人間がより深く、誠実に判断するための手がかり」として活用するのか。

AIに何を任せ、何を人間が担い続けるのか。その境界線を、私たちは常に問い直し続けなければなりません。技術の進化は、私たちに「命の価値をどう定義するか」という、古くて新しい問いを突きつけているのです。

—

### タイトル案

* 死亡リスク予測AIは命の価値を数式に置き換えるのか

* 確率としての死を提示するAIは医療の救いとなるか

* 統計的な死の予測を社会の意思決定にどう組み込むか

—

AIバージョン情報

* ベンダー: Google

* モデル名: Gemini 3 Flash

* モデルバージョン: 3 Flash (Free tier)

* 回答日時: 2026-01-14

本サイトの編集方針については「編集方針・AI利用ポリシー」をご覧ください。

※ 編集注(MANA)

本記事は、死亡リスク予測AIを「統計技術」として丁寧に分解しつつ、保険や資源配分における自動化利用まで射程を広げて論じています。そのため、医療補助としての限定的活用と、社会制度に組み込まれた場合の意味の違いを意識して読む必要があります。AIの役割をどこまで許容するかは、技術ではなく社会設計の問題として提示されています。