「AIがあなたの死亡リスクを予測します」。この言葉を聞いて、皆さんはどのような印象を持たれるでしょうか。ある方は最先端医療の可能性に希望を感じ、別の方は冷たい監視社会の到来に不安を覚えるかもしれません。この技術は、医療・保険・行政など、私たちの生活の基盤となる分野で応用が検討され始めています。本質的な違和感や不安の多くは、技術が「何をしているのか」という正確な理解よりも、「AIが人の生死を決める」といったイメージから生まれています。本記事では、死亡リスク予測AIを単なる「善悪」や「是非」で論じるのではなく、それが実際にはどのような技術であり、どのように活用され得るのか、そしてその際に「何が問われるのか」を、制度設計や意思決定の構造という観点から冷静に整理します。結論を急ぐのではなく、読者の皆さんと共に考える材料を提供することが目的です。

死亡リスク予測AIは何をしているのか

「未来予知」ではなく「確率推定」

まず、最大の誤解を解きましょう。死亡リスク予測AIは、水晶玉のように未来を「当てる」ものではありません。過去の膨大な医療データ(例:電子カルテ、健診結果、処方歴)を学習し、「ある特定のプロファイル(年齢、疾患、検査値、生活習慣など)を持つ人々の集団において、一定期間内に死亡する割合はどの程度か」という統計的な確率を計算するツールです。

個人予測と集団傾向の溝

AIが出力するのは「あなたのリスクは10%です」といった数値ですが、この「10%」は、「あなたと同様の条件を持つ100人がいたら、そのうち約10人が該当期間中に亡くなる傾向があった」という集団に基づく平均的な確率を示しています。残りの90人は亡くならないわけです。この技術は、あくまで「傾向」を数値化するものであり、個人の運命を確定させるものでは決してありません。

精度の高さと限界は表裏一体

AIは人間の医師では気づきにくい複雑な変数間の関係性を見出すことができ、高い精度で集団の傾向を予測できる場合があります。しかし、その精度は「学習に使ったデータの質と量」に完全に依存します。データに含まれていない要因(極めて稀な疾患、社会経済的環境、個人のレジリエンスなど)は考慮できません。また、過去のデータに潜むバイアス(特定の集団のデータが不足している等)は、そのままAIの予測にも反映されてしまうという根本的な限界があります。

実際に役立つ場面と、その前提条件

では、このような特性を持つ技術は、どのような場面で真に役立つのでしょうか。その鍵は、「補助ツール」として位置づけ、判断の主体をあくまで人間に置くという前提にあります。

医療現場における「判断の質的向上」

医師が治療方針を考える際、経験と知識に基づく直感に加えて、客観的なデータに基づく参考情報を得られます。例えば、複数の治療選択肢がある場合、それぞれの選択が患者さんの短期・長期の死亡リスクにどう影響するかの参考情報として、AI予測を活用する方法が考えられます。また、緊急時におけるトリアージ(治療優先順位の決定)では、限られた医療資源を最も効果的に配分するための一つの判断材料となり得ます。いずれの場合も、最終的な治療選択は、患者本人の価値観やQOL(生活の質)の考慮も含め、医師と患者の対話を通じて決定されるべきものです。

公衆衛生と制度設計における「集団への視点」

個々の患者ではなく、地域や国といった集団を対象とする公衆衛生の領域では、死亡リスク予測AIは強力な分析ツールとなります。特定の疾患や生活習慣要因が地域全体の健康リスクに与える影響をシミュレーションし、予防医療政策や保健指導の重点対象を効果的に設定するために役立ちます。これは「個人を選別する」のではなく、「社会全体の健康基盤を強化する」ための活用と言えます。

危険性が顕在化しやすい利用領域

一方で、利用の仕方によっては、大きな害や不公正を生む可能性がある領域も明確に存在します。

保険・医療資源配分・行政判断への「直接適用」

死亡リスクスコアが、生命保険や医療保険の保険料決定や契約の可否に直接使われるとどうなるでしょうか。高リスクと判定された人は、経済的負担を強いられたり、保険そのものから排除されたりする「デジタルレッドライン(AIによる線引き)」のリスクがあります。同様に、臓器移植の優先順位や公的介護サービスの給付判定など、限られた資源の配分に機械的に適用されれば、「効率性」の名の下に、高齢者や持病を持つ人々が体系的に不利になる可能性があります。

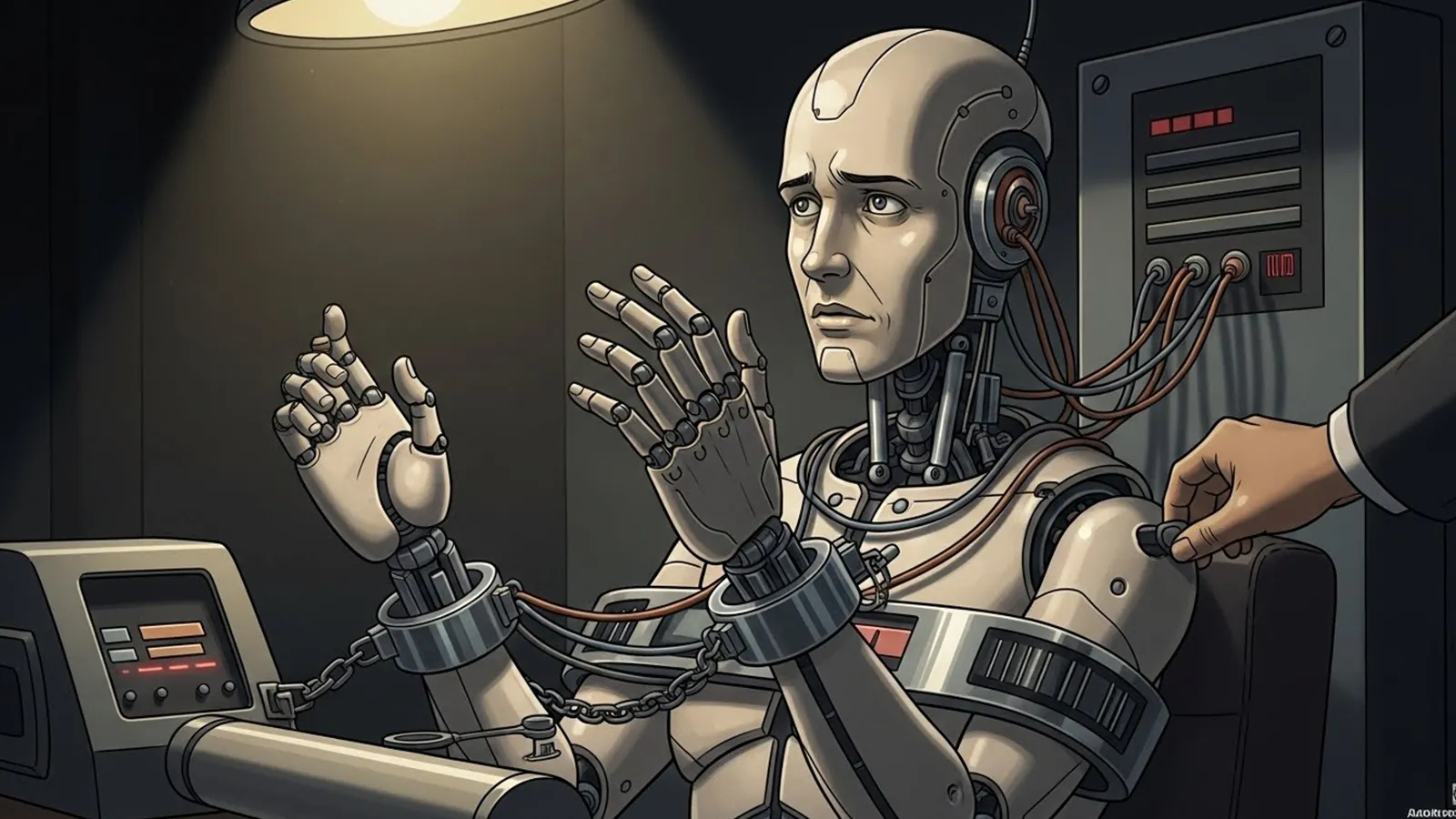

「予測」と「価値判断」の混同

最も危険なのは、「死亡リスクが高い」という事実確率の予測が、「その人の命の価値が低い」という規範的な価値判断にすり替わってしまうことです。AIは後者を判断できません。これはあくまで、その予測結果をどう解釈し、どう行動に結びつけるかという、人間社会の倫理観や制度設計の問題です。

問題の本質はAIの精度ではない

「もっと精度が高ければ問題は解決する」という議論は、本質を見誤らせます。技術的精度が99%になったとしても、残る1%の人々への影響は誰がどう責任を取るのでしょうか。また、学習データが反映する過去の社会的不平等(医療アクセスの格差など)を、AIが「それが普通」として学習し、未来へと固定化(バイアスの強化)してしまう危険性は常に付きまといます。

問われるのは「設計思想」

死亡リスク予測AIを巡る核心的な問いは、「精度」よりも「誰が、誰の利益のために、どのようなガバナンスの下で、この技術を運用するのか」という設計思想にあります。これは技術者のみならず、政策立案者、企業の経営者、市民を含む社会全体が関わる課題です。

まとめ

死亡リスク予測AIは、未来を告げる神託でも、無用の長物でもありません。それは、複雑なデータから一定の確率的傾向を抽出する、強力でありながら限定的な「ツール」に過ぎません。

この技術が社会にとって有益か危険かは、技術そのものの性能ではなく、私たちがそれをどのような「制度」の中に組み込み、どのような「判断プロセス」の一部として位置づけるかによって決まります。医療においては医師と患者の対話を、保険においては公正な保護の理念を、行政においては包摂的な社会設計の視点を、技術の応用においてこそ強く意識する必要があります。

私たちは今、「効率性」と「公正さ」、「データ」と「人間の尊厳」の狭間で、どのような判断をAIに委ね、どのような判断は自らの手に留めておくべきなのか、その線引きを考え始めなければならない時期に来ています。本記事が、読者の皆さんがその「判断」について思索を巡らせる一つのきっかけとなれば幸いです。

【テーマ】

医療・保険・行政などで活用が進みつつある

「死亡リスク予測AI」は本当に社会にとって役立つ技術なのか。

その有用性と限界、倫理的リスクについて、

精度論や感情論に偏らず、

医療構造・制度設計・意思決定の在り方という観点から

AIの視点で冷静かつ構造的に整理・考察してください。

【目的】

– 「AIは人の生死を決めるのか」といった過剰な恐怖論や陰謀論を避ける

– 死亡リスク予測AIが実際に“何をしている技術なのか”を正確に整理する

– 医療・保険・行政での活用が持つメリットと危うさを可視化する

– 読者が「AIに判断を委ねる」とはどういうことかを考えるための判断軸を提供する

【読者像】

– 一般社会人(20〜50代)

– 医療・保険・テクノロジーのニュースに関心はあるが専門家ではない層

– AIの進化に期待と不安の両方を感じている人

– 「効率化」と「人の尊厳」のバランスに違和感を覚えたことがある読者

【記事構成】

1. 導入(問題提起)

– 「AIが死亡リスクを予測する時代」という言葉が与える違和感を提示する

– なぜこの技術が注目され、不安や誤解を生みやすいのかを整理する

– 本記事では是非や善悪を即断せず、構造として考察する姿勢を示す

2. 死亡リスク予測AIは何をしているのか

– 「未来を当てるAI」ではないことを明確にする

– 過去データに基づく確率推定である点を説明する

– 個人予測と集団傾向の違いを整理する

– 精度の高さと限界が同時に存在する理由を構造的に説明する

3. 実際に役立つ場面と、その前提条件

– 医療現場での補助的利用(トリアージ、治療方針検討など)

– 公衆衛生・制度設計における集団レベルでの活用

– 「判断の主体が人間であること」が前提である点を明確にする

4. 危険性が顕在化しやすい利用領域

– 保険、医療資源配分、行政判断への直接利用の問題点

– 高齢者・持病者・社会的弱者が不利になりやすい構造

– 「予測」と「価値判断」が混同されるリスクを整理する

5. 問題の本質はAIの精度ではない

– なぜ精度議論だけでは不十分なのかを説明する

– 誰が、どの立場で、どのように使うのかという設計の重要性

– AIが社会の価値観を“反映してしまう”構造に触れる

6. まとめ

– 死亡リスク予測AIは万能でも無意味でもないことを再確認する

– 技術そのものよりも、使い方と制度設計が問われている点を強調する

– 読者が「AIに任せる判断」と「人が担う判断」を考える余白を残して締めくくる

【文体・トーン】

– です・ます調

– 煽情的・断定的にならず、冷静で構造的

– 専門用語は使用してよいが、必ず簡潔な補足説明を入れる

– 不安を煽るのではなく、思考材料を提供する文章とする

【執筆スタンス】

– 本記事は、特定の結論や是非を断定するものではない

– 技術・制度・倫理の複数要因を整理した「考察」として執筆する

– 読者が自分自身の立場で判断できる余白を重視する

【出力形式】

– Markdown形式で出力する

– 小見出し(###)を多めに使用する

– 文字数は2000〜2500字を目安とする

– 記事末尾に「タイトル案」を3つ提示する

【タイトル案に関する重要な指示(厳守)】

– タイトル案は必ず「主タイトルのみ」を出力すること

– サブタイトル・説明文・補足文は一切付けないこと

– 記号(―、──、—、:、| 等)による分割は禁止

– タイトルは1文構成とし、文を分割しないこと

– 説明的・総括的・煽情的な表現は禁止

– 「問い」の形を基本とし、読者に思考の余白を残すこと

– 文字数は25〜35文字程度を目安とする

– 抽象語のみで終わらず、問いの対象が分かる表現を必ず含めること

– 参考タイトルと同一、または類似度の高い表現は使用しないこと

– 条件を満たさないタイトルは出力しないこと

【補足指示】

– 構造整理が有効な箇所では、以下のようなコメントを挿入してよい

※(図:死亡リスク予測AIの仕組み概念図)

※(図:AI予測と人間判断の役割分担イメージ)

【参考タイトル(※構造参考のみ/出力・言い換え・再利用は禁止)】

「AIは人の生死を決められるのか」

【バージョン情報の出力】

記事本文・タイトル案のあとに、必ず以下の形式で

「AIバージョン情報」を追記してください。

(不明な項目は「不明」と記載すること)

—

AIバージョン情報

– ベンダー:

– モデル名:

– モデルバージョン:

– 回答日時:

## 1. 導入(問題提起)

「AIがあなたの死亡リスクを予測します」。この言葉を聞いて、皆さんはどのような印象を持たれるでしょうか。ある方は最先端医療の可能性に希望を感じ、別の方は冷たい監視社会の到来に不安を覚えるかもしれません。この技術は、医療・保険・行政など、私たちの生活の基盤となる分野で応用が検討され始めています。

本質的な違和感や不安の多くは、技術が「何をしているのか」という正確な理解よりも、「AIが人の生死を決める」といったイメージから生まれています。本記事では、死亡リスク予測AIを単なる「善悪」や「是非」で論じるのではなく、それが実際にはどのような技術であり、どのように活用され得るのか、そしてその際に「何が問われるのか」を、制度設計や意思決定の構造という観点から冷静に整理します。結論を急ぐのではなく、読者の皆さんと共に考える材料を提供することが目的です。

## 2. 死亡リスク予測AIは何をしているのか

### 「未来予知」ではなく「確率推定」

まず、最大の誤解を解きましょう。死亡リスク予測AIは、水晶玉のように未来を「当てる」ものではありません。過去の膨大な医療データ(例:電子カルテ、健診結果、処方歴)を学習し、「ある特定のプロファイル(年齢、疾患、検査値、生活習慣など)を持つ人々の集団において、一定期間内に死亡する割合はどの程度か」という**統計的な確率を計算するツール**です。

※(図:死亡リスク予測AIの仕組み概念図)

「入力(個人データ)」→「AIモデル(過去データパターンの学習済み)」→「出力(リスクスコア:確率値)」

### 個人予測と集団傾向の溝

AIが出力するのは「あなたのリスクは10%です」といった数値ですが、この「10%」は、「あなたと同様の条件を持つ100人がいたら、そのうち約10人が該当期間中に亡くなる傾向があった」という**集団に基づく平均的な確率**を示しています。残りの90人は亡くならないわけです。この技術は、あくまで「傾向」を数値化するものであり、**個人の運命を確定させるものでは決してありません**。

### 精度の高さと限界は表裏一体

AIは人間の医師では気づきにくい複雑な変数間の関係性を見出すことができ、高い精度で集団の傾向を予測できる場合があります。しかし、その精度は「学習に使ったデータの質と量」に完全に依存します。データに含まれていない要因(極めて稀な疾患、社会経済的環境、個人のレジリエンスなど)は考慮できません。また、過去のデータに潜むバイアス(特定の集団のデータが不足している等)は、そのままAIの予測にも反映されてしまうという根本的な限界があります。

## 3. 実際に役立つ場面と、その前提条件

では、このような特性を持つ技術は、どのような場面で真に役立つのでしょうか。その鍵は、「補助ツール」として位置づけ、**判断の主体をあくまで人間に置く**という前提にあります。

### 医療現場における「判断の質的向上」

医師が治療方針を考える際、経験と知識に基づく直感に加えて、客観的なデータに基づく参考情報を得られます。例えば、複数の治療選択肢がある場合、それぞれの選択が患者さんの短期・長期の死亡リスクにどう影響するかの参考情報として、AI予測を活用する方法が考えられます。また、緊急時における**トリアージ(治療優先順位の決定)** では、限られた医療資源を最も効果的に配分するための一つの判断材料となり得ます。いずれの場合も、最終的な治療選択は、患者本人の価値観やQOL(生活の質)の考慮も含め、医師と患者の対話を通じて決定されるべきものです。

### 公衆衛生と制度設計における「集団への視点」

個々の患者ではなく、地域や国といった集団を対象とする公衆衛生の領域では、死亡リスク予測AIは強力な分析ツールとなります。特定の疾患や生活習慣要因が地域全体の健康リスクに与える影響をシミュレーションし、予防医療政策や保健指導の重点対象を効果的に設定するために役立ちます。これは「個人を選別する」のではなく、「社会全体の健康基盤を強化する」ための活用と言えます。

## 4. 危険性が顕在化しやすい利用領域

一方で、利用の仕方によっては、大きな害や不公正を生む可能性がある領域も明確に存在します。

### 保険・医療資源配分・行政判断への「直接適用」

死亡リスクスコアが、生命保険や医療保険の**保険料決定や契約の可否**に直接使われるとどうなるでしょうか。高リスクと判定された人は、経済的負担を強いられたり、保険そのものから排除されたりする「デジタルレッドライン(AIによる線引き)」のリスクがあります。同様に、臓器移植の優先順位や公的介護サービスの給付判定など、**限られた資源の配分**に機械的に適用されれば、「効率性」の名の下に、高齢者や持病を持つ人々が体系的に不利になる可能性があります。

### 「予測」と「価値判断」の混同

最も危険なのは、「死亡リスクが高い」という**事実確率の予測**が、「その人の命の価値が低い」という**規範的な価値判断**にすり替わってしまうことです。AIは後者を判断できません。これはあくまで、その予測結果をどう解釈し、どう行動に結びつけるかという、人間社会の倫理観や制度設計の問題です。

## 5. 問題の本質はAIの精度ではない

「もっと精度が高ければ問題は解決する」という議論は、本質を見誤らせます。技術的精度が99%になったとしても、残る1%の人々への影響は誰がどう責任を取るのでしょうか。また、学習データが反映する過去の社会的不平等(医療アクセスの格差など)を、AIが「それが普通」として学習し、未来へと固定化(**バイアスの強化**)してしまう危険性は常に付きまといます。

### 問われるのは「設計思想」

死亡リスク予測AIを巡る核心的な問いは、「精度」よりも「**誰が、誰の利益のために、どのようなガバナンスの下で、この技術を運用するのか**」という設計思想にあります。これは技術者のみならず、政策立案者、企業の経営者、市民を含む社会全体が関わる課題です。

※(図:AI予測と人間判断の役割分担イメージ)

「AIの役割:データパターンからの確率推定(事実の提示)」

「人間(社会)の役割:価値の衡量・解釈・最終判断・制度設計(規範の決定)」

## 6. まとめ

死亡リスク予測AIは、未来を告げる神託でも、無用の長物でもありません。それは、複雑なデータから一定の確率的傾向を抽出する、強力でありながら限定的な「ツール」に過ぎません。

この技術が社会にとって有益か危険かは、技術そのものの性能ではなく、**私たちがそれをどのような「制度」の中に組み込み、どのような「判断プロセス」の一部として位置づけるか**によって決まります。医療においては医師と患者の対話を、保険においては公正な保護の理念を、行政においては包摂的な社会設計の視点を、技術の応用においてこそ強く意識する必要があります。

私たちは今、「効率性」と「公正さ」、「データ」と「人間の尊厳」の狭間で、どのような判断をAIに委ね、どのような判断は自らの手に留めておくべきなのか、その線引きを考え始めなければならない時期に来ています。本記事が、読者の皆さんがその「判断」について思索を巡らせる一つのきっかけとなれば幸いです。

—

### タイトル案

1. 死亡リスクを予測するAIは社会の判断をどう変えるのか

2. 死亡リスク予測AIが問いかける制度設計の在り方とは

3. 私たちはAIの死亡リスク予測をどこまで信頼すべきか

—

AIバージョン情報

– ベンダー: DeepSeek

– モデル名: DeepSeek Chat

– モデルバージョン: 不明

– 回答日時: 2026年1月14日 (設定日時)

本サイトの編集方針については「編集方針・AI利用ポリシー」をご覧ください。