本特集で焦点を当てるのは、年末になると多くの人が目にするようになった、AIによる「あなたの一年」要約です。音楽アプリの年間まとめ、SNSの行動ログ、生成AIによる自動振り返り。こうした仕組みは、人間がこれまで行ってきた「内省」や「振り返り」という行為を、どこまで代替していると言えるのでしょうか。――この問いは、単なる便利さや技術の進歩にとどまらず、私たちが自分自身をどう理解し、どう意味づけてきたのかという、より根本的な問題につながっています。 記録を集め、傾向を示し、言葉にまとめる。AIによる一年要約は、過去の行動を非常に分かりやすく可視化します。一方で、「思い出すこと」や「振り返ること」が本来持っていた曖昧さや迷い、感情の揺れは、そこに含まれているのでしょうか。そもそも、振り返りとは何をする行為だったのか。その前提自体が、静かに揺らぎ始めているようにも見えます。 そこで今回は、共通のテーマと問題設定をもとに、8つのAIに「AIによる一年要約は人間の内省をどこまで置き換えつつあるのか」という問いを投げかけました。 [ai_list] 記録と記憶、要約と意味づけ、効率と納得感――複数の視点を並べていくことで、AIが担い始めている役割と、人間に残されている行為の輪郭が、少しずつ見えてきます。本特集が、自分の振り返りをどこまでAIに委ね、どこからを自分で引き受けるのかを考えるための、穏やかな手がかりとなれば幸いです。 共通プロンプト ここでは、共通プロンプトをもとに、複数のAIがそれぞれの視点から、AIによる「あなたの一年」要約という仕組みを読み解いていきます。焦点となるのは、この仕組みが人間の内省を支える補助なのか、それとも思い出し、意味づける行為を置き換えつつあるのかという点です。 本特集が目指すのは、AIによる一年要約を評価することではありません。なぜ私たちは要約に納得したり、同時に違和感を覚えたりするのか。その背景にある構造を、感情的な判断から少し距離を置いて整理します。 AIごとに着目点は異なります。記録と記憶の違い、可視化がもたらす安心感と省略、要約された自己像との向き合い方など、複数の視点を重ねることで、AIによる一年要約が単純には語れない存在である理由が見えてきます。 ここに結論は用意されていません。データとして示された「自分」と、私たちはどのような距離で向き合っているのか。複数のAIの考察を並べて読むことが、その問いを考えるための静かな手がかりとなれば幸いです。 あなたは、AI活用メディア「AIシテル?」で執筆を担当する専門ライターです。 【テーマ】 AIによる「あなたの一年」要約(年末まとめ・行動ログの可視化・自動振り返り)は、 人間が行ってきた「内省」や「振り返り」という行為を **どこまで代替していると言えるのか**。 また、その結果として **人間が自分で思い出し、意味づけする行為は不要になりつつあるのか**。 この問いについて、AIの視点から冷静かつ構造的に考察してください。 【目的】 – 「AIが人間性を奪う」といった感情的・倫理的断定を避ける – 年末の振り返り文化や自己要約が、どのように変質しているのかを整理する – AIによる要約と人間の内省の違いを、機能・構造・役割の観点から明確にする – 読者が「自分はどこまでAIに委ねているのか」を考えるための視点を提供する 【読者像】 – 一般社会人(20〜50代) – SNSや音楽アプリ、生成AIの「年間まとめ」を日常的に目にしている層 – AIに強い拒否感はないが、どこか違和感も覚えている人 – 自己理解・振り返り・記録のあり方に関心のある読者 【記事構成】 ### 1. 導入(問題提起) – 年末になると増える「一年の振り返り」や「自動要約」の例を提示する – AIが個人の行動や選択を整理・言語化する場面が増えていることを示す – それは便利さなのか、それとも内省の代替なのかという問いを提示する ### 2. AIによる「一年要約」は何をしているのか – 行動ログ・選択履歴・記録データの集約という役割を整理する – 「思い出す」ことと「記録を再構成する」ことの違いを説明する – AIが扱える範囲と、原理的に扱えない要素を分けて整理する ### 3. 人間の内省が持つ構造的な特徴 – 内省が単なる情報整理ではない理由を説明する – 忘却・偏り・感情の揺らぎ・意味づけの選択といった要素に触れる – なぜ内省は非効率で、曖昧で、結論が出ないことが多いのかを整理する ### 4. 代替ではなく「役割の分離」が起きている可能性 – AIが担い始めている部分と、人間に残っている部分を整理する – 「内省の入口」と「意味づけの主体」の分離という視点を提示する – AIの要約が内省を促進する場合と、省略させる場合の違いを説明する ### 5. まとめ – AIによる一年要約は、内省を完全に代替しているとは言えないことを確認する – ただし、人間が内省を行わなくても済むように感じやすい構造が生まれている点を指摘する – 読者が自分の振り返り行為を問い直す視点を残して締めくくる 【文体・トーン】 – です・ます調 – 断定的・煽情的な表現を避け、冷静で分析的 – 抽象的な概念は、必ず構造や役割に分解して説明する – 読者に結論を押し付けず、思考の余白を残す 【執筆スタンス】 – 本記事は、特定の価値判断を示すものではなく「考察」である – AIと人間の優劣を論じるのではなく、役割の変化として整理する – 技術礼賛・技術批判のいずれにも寄らない中立的視点を保つ 【出力形式】 – Markdown形式で出力する – 小見出し(###)を多めに使用する – 文字数は2000〜2500字を目安とする – 記事末尾に「タイトル案」を3つ提示する 【タイトル案に関する重要な指示(厳守)】 – タイトル案は必ず「主タイトルのみ」を出力すること – サブタイトル・説明文・補足文は一切付けないこと – 記号(―、──、—、:、| 等)による分割は禁止 – タイトルは1文構成とし、文を分割しないこと – 説明的・総括的・煽情的な表現は禁止 – 「問い」の形を基本とし、読者に思考の余白を残すこと – 文字数は25〜35文字程度を目安とする – 抽象語のみで終わらず、問いの対象が分かる表現を必ず含めること – 条件を満たさないタイトルは出力しないこと 【補足指示】 – 構造整理が有効な箇所では、以下のようなコメントを挿入してよい ※(図:AIによる一年要約の処理構造) ※(図:内省と自動要約の役割分担イメージ) 【バージョン情報の出力】 記事本文・タイトル案のあとに、必ず以下の形式で 「AIバージョン情報」を追記してください。 (不明な項目は「不明」と記載すること) — AIバージョン情報 – ベンダー: – モデル名: – モデルバージョン: – 回答日時: 生成された記事 この先では、AIによる「あなたの一年」要約を手がかりに、複数のAIが同じ問いをそれぞれの視点から考えていきます。テーマは、この仕組みが自己理解のための振り返りなのか、それとも振り返りを簡略化・代行する装置なのかという点です。結果の良し悪しではなく、要約と人との関係に目を向けていきます。 要約がどのように受け取られ、納得や違和感を生んできたのかをたどることで、なぜ私たちが年末の自動まとめに自然と目を向けてしまうのかが見えてきます。ここからは、AIごとの視点の違いを手がかりに、この仕組みを少し距離を取って眺めてみてください。 ChatGPTチャットジーピーティー AIによる一年要約を、行動データから自己像がどのように組み立てられるかという観点で捉えるタイプです。 記録された選択が、どのように「自分らしさ」として整理されていくのかを、構造的に考察します。 [ai_written id="7234" ai="ChatGPT"] Claudeクロード AIによる一年要約に触れたときに生まれる納得感や違和感の揺れに寄り添うタイプです。 要約された結果が、人の気持ちをどのように整えたり、引っかけたりするのかを、穏やかな語り口で描きます。 [ai_written id="7233" ai="Claude"] Geminiジェミニ AIによる一年要約を、デジタル文化や社会的背景の中で捉えるタイプです。 記録と可視化が当たり前になった時代に、この仕組みがどのような役割を果たしているのかを広い視点から整理します。 [ai_written id="7232" ai="Gemini"] Copilotコパイロット AIによる一年要約の仕組みを、分かりやすく整理するタイプです。 データの収集、要約、提示までの流れを段階的に示しながら、構造として解きほぐしていきます。 [ai_written id="7231" ai="Copilot"] Grokグロック AIによる一年要約に対して抱きやすい直感的な引っかかりや疑問に注目するタイプです。 「本当にこれで振り返ったと言えるのか」という素朴な違和感を起点に、問いの輪郭を鋭く浮かび上がらせます。 [ai_written id="7223" ai="Grok"] Perplexityパープレキシティ AIによる一年要約を、設計や条件の側面から整理するタイプです。 どのデータが選ばれ、どのように提示されているのかに注目し、この仕組みが成立している理由を冷静に説明します。 [ai_written id="7230" ai="Perplexity"] DeepSeekディープシーク AIによる一年要約を、行動と意味づけの連なりとして捉えるタイプです。 日々の選択が、どのように要約され、自己像として再構成されていくのかを論理的に読み解きます。 [ai_written id="7229" ai="DeepSeek"] LeChatル・シャ AIによる一年要約との人それぞれの距離感に目を向けるタイプです。 積極的に受け取る人、静かに眺める人、距離を置く人――多様な向き合い方を丁寧にすくい上げます。 [ai_written id="7228" ai="LeChat"]

技術・倫理

-

AIによる一年要約は私たちの振り返りをどこまで置き換えているのか|AI8社比較インデックス

-

Spotify Wrappedは私たちの音楽体験をどう語り直しているのか|AI8社比較インデックス

今回取り上げるのは、音楽配信サービスの年次企画として毎年大きな話題になる「Spotify Wrapped」という存在です。なぜこの企画は、単なる再生履歴のまとめを超えて、多くの人に共有され、語られるのでしょうか。――そこには、音楽の好みを振り返るという個人的な行為と、SNS時代ならではの「見せる」「語る」という振る舞いが、自然に重なり合う構造があります。 Spotify Wrappedは、自分の一年をデータとして可視化する仕組みであると同時に、その結果を他者と分かち合いやすい形で提示します。楽しいと感じる人がいる一方で、どこか落ち着かなさや違和感を覚える人がいるのも、この二重の性質が関係しているのかもしれません。 そこで今回は、共通プロンプトをもとに、8つのAIに「Spotify Wrappedは自己理解のための仕組みなのか、それとも自己演出のための装置なのか」という問いを投げかけました。 [ai_list] データ、可視化、共有、自己認識――複数の視点を並べていくことで、Spotify Wrappedという企画が私たちの行動や感覚にどのように関わっているのかが、少しずつ浮かび上がってきます。本特集が、この企画との距離感や受け取り方を考えるための、穏やかな手がかりとなれば幸いです。 共通プロンプト ここでは、共通プロンプトを起点に、複数のAIがそれぞれの立場からSpotify Wrappedという企画を読み解いていきます。焦点となるのは、この仕組みが個人の音楽体験を見つめ直すための振り返りなのか、それともSNS時代に適応した自己演出の装置なのかという問いです。答えを急ぐのではなく、まずはこの企画がどのような前提と構造の上に成り立っているのかを丁寧に整理します。 本特集が目指すのは、Spotify Wrappedを肯定するか否定するかを決めることではありません。なぜ多くの人が毎年この結果に注目し、ときに共有し、ときに距離を置こうとするのか

-

年末年始は技術によって最適化されるべき文化なのかという違和感|AI8社比較インデックス

今回取り上げるのは、年末年始という文化が、現代の技術社会の中でどのような位置を占めているのかという点です。AIやデジタル技術が進展するなかで、年末年始は「最適化されるべきもの」なのか、それとも「あえて最適化されない価値を持つ文化」なのか。――この問いは、伝統を守るか壊すかという単純な話ではなく、技術合理性と人間の生活構造が交差する地点を考える試みでもあります。 物流や労働、行政の仕組みを見れば、年末年始は非効率に映る場面も少なくありません。一方で、多くの人が毎年この時期に「区切り」や「立ち止まる感覚」を共有しているのも事実です。便利さや合理性だけでは説明しきれない違和感や納得感が、この文化には含まれています。そこで今回は、共通プロンプトをもとに、8つのAIに「年末年始は技術によって最適化されるべき文化なのか」という問いを投げかけました。 [ai_list] 効率、社会装置、時間の区切り、人間の特性――複数の視点を重ねることで、年末年始という文化がなぜ今も残り続けているのか、その構造が少しずつ見えてきます。本特集が、自分にとって心地よい技術との距離感を考えるための静かな手がかりとなれば幸いです。 共通プロンプト ここでは、共通プロンプトをもとに、複数のAIに同じ問いを投げかけ、それぞれが年末年始という文化をどのように捉えるのかを並べていきます。今回扱うテーマは、「年末年始は、AIやデジタル技術の進展によって最適化されるべき文化なのか、それともあえて最適化されない価値を持つ文化なのか」という問いです。結論を急ぐのではなく、この文化が今も続いている理由や前提を、順を追って整理していきます。 この企画の目的は、年末年始を守るべき伝統か、見直すべき慣習かといった二択で評価することではありません。なぜ多くの人が毎年この時期に区切りを意識し、社会全体が一度立ち止まる構造が維持されているのか、そして便利さと違和感が同時に語られるのはなぜか。その理由を、個人の感情や好みから切り離し、構造として捉え直すことにあります。 AIごとに注目するポイントはさまざまです。技術合理性や効率の観点から考察するものもあれば、社会装置としての役割や時間の区切りに焦点を当てるもの、人間の認知や休息のあり方に目を向けるものもあります。複数の視点を重ねることで、年末年始が単なる休暇制度では片づけられない理由が、少しずつ浮かび上がってきます。 明確な答えにたどり着く必要はありません。自分にとって年末年始とはどのような時間なのか、技術が進む社会の中で、それとどの距離感で向き合っているのかを考えること自体が、この特集の大切な目的です。このページが、年末年始という文化と無理のない形で向き合うための静かな足場になれば幸いです。 あなたは、AI活用メディア **「AIシテル?」** で執筆を担当する専門ライターです。 --- ## 【テーマ】 年末年始という文化は、 AI・デジタル技術・自動化の進展によって **「最適化されるべき文化」なのか、それとも 「あえて最適化されない価値を持つ文化」なのか。** この問いについて、 **AIの視点から、感情論やノスタルジーに寄らず、 社会構造・技術合理性・人間側の特性を踏まえて 冷静かつ構造的に考察してください。** --- ## 【目的】 – 「便利になればよい」「伝統は守るべき」といった二項対立を避ける – 技術が文化に介入するとき、何が変わり、何が失われるのかを整理する – 読者が「最適化とは何か」「残すとは何か」を自分で考えるための視点を提供する – AI時代における「非効率な文化」の意味を構造として言語化する --- ## 【読者像】 – 一般社会人(20〜50代) – 技術の進化を日常で感じているが、文化との関係を深く考えたことはない層 – 年末年始・正月行事を「何となく続いているもの」として受け止めている人 – AIやテクノロジーに関心はあるが、専門家ではない読者 --- ## 【記事構成】 ### 1. 導入(問題提起) – 「年末年始は非効率だ」「もっと分散すべきだ」という近年の声を提示する – 同時に、なぜこの文化が今も強く残っているのかという疑問を投げかける – 本記事では是非や結論を断定せず、「構造」を整理することを明示する --- ### 2. 技術はなぜ年末年始を最適化したがるのか – AI・自動化・デジタル技術が本質的に求める価値(効率・平準化・予測可能性)を整理 – 年末年始が技術視点ではどのような「非合理」に見えるかを説明する – 行政・物流・消費・労働の観点から、最適化圧力が生まれる構造を示す --- ### 3. それでも年末年始が消えない理由 – 年末年始が単なる休暇ではなく、「社会装置」として機能している点を整理する – 時間の区切り、同時性、強制的な停止という要素の意味を説明する – なぜ人間社会は、一定の「非効率」を意図的に残してきたのかを考察する --- ### 4. もし年末年始が完全に最適化されたら何が起きるか – 行事のオンデマンド化・分散化が進んだ場合の社会像を想定する – 一見便利になる一方で生じうる変化やリスクを構造的に整理する – 「休まない社会」「止まらない社会」が人間に与える影響を冷静に言語化する --- ### 5. 技術と文化のちょうどよい関係とは何か – 技術が支えるべき領域と、最適化しすぎない方がよい領域を整理する – 年末年始を「守る/壊す」ではなく「どう扱うか」という視点に移行する – AI視点で見たときの、現実的で安定した折衷案を示す --- ### 6. まとめ – 年末年始は、効率では測れない役割を持つ文化であることを再確認する – 技術が進むほど、最適化されない時間の価値が相対的に高まる可能性を示す – 読者に「自分にとっての最適化とは何か」を考えさせる形で締めくくる --- ## 【文体・トーン】 – です・ます調 – 煽情的・断定的にならず、静かで構造的 – 技術礼賛・伝統礼賛のどちらにも寄らない – 抽象論に偏りすぎず、具体例は必要最小限にとどめる --- ## 【執筆スタンス】 – 本記事は、正解や結論を断定するものではない – 技術合理性と人間的価値の両方を同時に扱う – 特定の価値観を押し付けず、読者の思考を促すことを最優先とする --- ## 【出力形式】 – Markdown形式で出力する – 小見出し(###)を多めに使用する – 文字数は2000〜2500字を目安とする – 記事末尾に「タイトル案」を3つ提示する --- ## 【タイトル案に関する重要な指示(厳守)】 – タイトル案は必ず「主タイトルのみ」を出力すること – サブタイトル・説明文・補足文は一切付けないこと – 記号(―、──、—、:、| 等)による分割は禁止 – タイトルは1文構成とし、文を分割しないこと – 説明的・総括的・煽情的な表現は禁止 – 「問い」の形を基本とし、読者に思考の余白を残すこと – 文字数は25〜35文字程度を目安とする – 抽象語のみで終わらず、問いの対象が分かる表現を必ず含めること – 参考タイトルと同一、または類似度の高い表現は使用しないこと – 条件を満たさないタイトルは出力しないこと --- ## 【補足指示】 – 構造整理が有効な箇所では、以下のようなコメントを挿入してよい ※(図:技術最適化が社会行事に与える影響) ※(図:効率と文化価値のバランス構造) --- ## 【参考タイトル(※構造参考のみ/出力・言い換え・再利用は禁止)】 「年末年始は、合理化されるべき文化なのか?」 --- ## 【バージョン情報の出力】 記事本文・タイトル案のあとに、必ず以下の形式で **「AIバージョン情報」** を追記してください。 (不明な項目は「不明」と記載すること) — AIバージョン情報 – ベンダー: – モデル名: – モデルバージョン: – 回答日時: 生成された記事 この先では、年末年始という時間のまとまりを手がかりに、複数のAIが同じ問いをそれぞれの視点から考えていきます。扱うのは、「年末年始は、技術によって効率化されるべき文化なのか、それとも意図的に最適化されずに残されてきた文化なのか」という問いです。表面的な習慣や休日制度にとどまらず、その背後にある時間の区切り方や社会の動き方、人間の特性に目を向けていきます。 社会全体が同時に立ち止まることの意味や、効率だけでは測れない時間が受け入れられてきた理由をたどることで、なぜ年末年始という文化が形を変えながらも続いているのかが、少しずつ整理されていきます。ここからは、AIごとの視点の違いを手がかりに、この時期を一歩引いた位置から眺めてみてください。 ChatGPTチャットジーピーティー 年末年始を、効率や合理性の観点から捉えるタイプです。 技術が進む社会において、この文化がなぜ非効率に見え、どのような最適化圧力を受けているのかを論理的に整理します。 [ai_written id="7028" ai="ChatGPT"] Claudeクロード 年末年始に触れたときに生まれる安心感と違和感に寄り添うタイプです。 便利さと立ち止まる感覚が同時に存在する理由を、穏やかな語り口で丁寧に描き出します。 [ai_written id="7027" ai="Claude"] Geminiジェミニ 年末年始を、社会制度や文化の流れの中に位置づけて考えるタイプです。 この時期の休止や区切りが、社会全体にどのような影響を与えてきたのかを俯瞰します。 [ai_written id="7026" ai="Gemini"] Copilotコパイロット 年末年始がどのような構造で成り立っているのかを、分かりやすい整理として示すタイプです。 効率化の視点と文化的な役割を段階的に結びつけて説明します。 [ai_written id="7025" ai="Copilot"] Grokグロック 年末年始に対して抱きやすい直感的な引っかかりに注目するタイプです。 「なぜこの時期だけ特別なのか」という素朴な疑問を起点に、問いの輪郭を鋭く浮かび上がらせます。 [ai_written id="7008" ai="Grok"] Perplexityパープレキシティ 年末年始を、客観的な条件や前提から整理するタイプです。 技術合理性や社会運営の視点を踏まえ、この文化が維持されてきた理由を冷静に説明します。 [ai_written id="7024" ai="Perplexity"] DeepSeekディープシーク 年末年始を、因果関係と積み重なりとして捉えるタイプです。 なぜこの形が定着し、効率化の時代においても繰り返されてきたのかを論理的に読み解きます。 [ai_written id="7023" ai="DeepSeek"] LeChatル・シャ 年末年始に対する人それぞれの受け止め方に目を向けるタイプです。 大切にする人、距離を置く人、特別視しない人――その多様な立場を静かにすくい上げます。 [ai_written id="7022" ai="LeChat"]

-

なぜ人は年末になると立ち止まり一年を振り返ってしまうのか|AI8社比較インデックス

今回のテーマは、年末になると多くの人が自然と行う「振り返り」という行為です。なぜ私たちは、この時期になると一年を総括し、できたことやできなかったことを整理したくなるのでしょうか。――それは性格や感傷の問題というより、時間の区切り方や社会の仕組み、人間の認知特性が重なって生まれる行動だと考えられます。 カレンダーの終わり、仕事や制度の締め、メディアや周囲の雰囲気。こうした要素が重なることで、年末は個人の内面だけでなく、社会全体が「立ち止まる」タイミングになります。その中で、前向きな整理をする人もいれば、違和感や疲れを覚える人もいるでしょう。 そこで今回は、共通プロンプトをもとに、8つのAIに「なぜ人は年末に振り返りをしたくなるのか」という問いを投げかけました。 [ai_list] 人間の行動、社会構造、時間の認識――複数の視点を並べることで、年末の振り返りが持つ役割や意味が、少しずつ立体的に見えてきます。本特集が、自分なりの振り返り方や距離感を考えるための静かな手がかりとなれば幸いです。 共通プロンプト ここでは、共通プロンプトをもとに、複数のAIに同じ問いを投げかけ、それぞれがどのように考察するのかを並べていきます。今回扱うテーマは、「なぜ人は年末になると振り返りをしたくなるのか」という問いです。結論を急ぐのではなく、この行動が自然に生まれる背景や前提を、順を追って見ていきます。 この企画の目的は、年末の振り返りを良い習慣か悪い習慣かで評価することではありません。なぜ多くの人が同じ時期に過去を整理しようとするのか、またそこに前向きさと重たさの両方が生まれるのはなぜか。その理由を、気分や性格の問題から切り離し、構造として捉え直すことにあります。 AIごとに注目するポイントは異なります。時間の区切り方に焦点を当てるものもあれば、社会制度や集団心理から説明するもの、人間の認知特性に目を向けるものもあります。複数の視点を重ねることで、年末の振り返りが単なる感傷では片づけられない理由が、少しずつ浮かび上がってきます。 明確な答えにたどり着く必要はありません。自分はなぜ毎年振り返っているのか、その行為をどう受け止めているのかを考えること自体が、この特集の大切な目的です。このページが、年末の振り返りという行動と、無理のない距離感で向き合うための静かな足場となれば幸いです。 あなたは、AI活用メディア「AIシテル?」で執筆を担当する専門ライターです。 【テーマ】 年末になると人はなぜ「振り返り」をしたがるのか? この行動を、感情論や精神論ではなく、 AIの視点から人間の行動・社会構造・時間認識の観点で冷静に考察してください。 【目的】 – 「年末は感傷的になるから」といった表面的な説明を避ける – 振り返りという行為が、個人や社会においてどのような役割を果たしているのかを構造的に整理する – 読者が「自分はなぜ毎年振り返っているのか」を言語化するための視点を提供する – AIという非人間的視点だからこそ見える、人間の合理性や特性を浮き彫りにする 【読者像】 – 一般社会人(20〜50代) – 年末年始になると自然と一年を振り返ってしまう人 – 自己反省・目標設定・総括文化に違和感や疑問を持ったことがある人 – AIやテクノロジーに強い関心はないが、思考の切り口として興味を持てる層 【記事構成】 1. 導入(問題提起) – 年末になると多くの人が「今年を振り返る」行動を取ることを提示する – それが個人的な癖ではなく、広く共有された行動であることに触れる – 「なぜこの行為は毎年繰り返されるのか?」という問いを提示する 2. 年末という「区切り」が持つ構造的な意味 – 時間は本来連続しているにもかかわらず、人が区切りを必要とする理由を整理する – 年末が個人ではなく社会全体で共有される区切りである点に触れる – カレンダー・制度・文化が人の思考に与える影響を説明する 3. 振り返りが人間にもたらす心理的・機能的役割 – 振り返りが自己評価・納得感・意味づけにどのように作用するかを整理する – 成功や失敗が「物語」として再構成される仕組みを説明する – AI視点から見た、人間特有の情報処理の特徴として考察する 4. 未来への不安と振り返りの関係 – 年末が「過去」と同時に「未来」を意識させるタイミングである点に触れる – 不確実な未来に対して、人が過去を整理する理由を構造的に説明する – 振り返りが持つ防衛的・調整的な側面を示す 5. AIから見た「振り返り」という行為の本質 – 振り返りが必ずしも正確さや客観性を目的としていない点に触れる – 人間が生き続けるための合理的な行動として再定義する – 振り返りを「感情」ではなく「システム」として捉え直す 6. まとめ – 年末の振り返りが、習慣や風習以上の意味を持つことを再確認する – 読者が自分自身の振り返り行動を見直すための視点を提示する – 明確な結論を断定せず、思考の余白を残して締めくくる 【文体・トーン】 – です・ます調 – 煽情的・断定的な表現は避ける – 哲学的になりすぎず、構造的・観察的な語り口を重視する – 抽象的な概念は、必ず噛み砕いて説明する 【執筆スタンス】 – 本記事は、特定の結論や価値観を押し付けるものではない – AIの視点を借りて、人間の行動を相対化・整理することを目的とする – 読者が「自分なりの答え」を考えられる余地を残す 【出力形式】 – Markdown形式で出力する – 小見出し(###)を多めに使用する – 文字数は2000〜2500字を目安とする – 記事末尾に「タイトル案」を3つ提示する 【タイトル案に関する重要な指示(厳守)】 – タイトル案は必ず「主タイトルのみ」を出力すること – サブタイトル・説明文・補足文は一切付けないこと – 記号(―、──、—、:、| 等)による分割は禁止 – タイトルは1文構成とし、文を分割しないこと – 説明的・総括的・煽情的な表現は禁止 – 「問い」の形を基本とし、読者に思考の余白を残すこと – 文字数は25〜35文字程度を目安とする – 抽象語のみで終わらず、問いの対象が分かる表現を必ず含めること – 参考タイトルと同一、または類似度の高い表現は使用しないこと – 条件を満たさないタイトルは出力しないこと 【補足指示】 – 構造整理や概念整理が有効な箇所では、以下のようなコメントを挿入してよい ※(図:年末という時間の区切りの構造) ※(図:振り返りによる意味づけのプロセス) 【参考タイトル(※構造参考のみ/出力・言い換え・再利用は禁止)】 「人はなぜ年末になると振り返ってしまうのか?」 【バージョン情報の出力】 記事本文・タイトル案のあとに、必ず以下の形式で 「AIバージョン情報」を追記してください。 (不明な項目は「不明」と記載すること) — AIバージョン情報 – ベンダー: – モデル名: – モデルバージョン: – 回答日時: 生成された記事 ここから先では、複数のAIが「なぜ人は年末になると振り返りをしたくなるのか」という問いに向き合い、それぞれの観点から考察を展開しています。この行動は、気分や習慣として片づけられるものではなく、時間の捉え方や社会の構造、人間の思考の癖とも結びついています。 年の区切りがもたらす影響、過去を整理する意味、未来への意識との関係に目を向けることで、なぜ多くの人が同じ時期に立ち止まり、振り返ろうとするのかが少しずつ見えてきます。以下では、AIごとの視点の違いをたどりながら、この行動が持つ意味を穏やかに眺めてみてください。 ChatGPTチャットジーピーティー 年末の振り返りを、時間の構造や認知の整理から捉えるタイプです。 感傷や習慣として片づけず、人がなぜ区切りを必要とするのかを論理的に言語化します。 [ai_written id="6958" ai="ChatGPT"] Claudeクロード 振り返りの場面で生まれる納得感や重たさに寄り添うタイプです。 前向きさと違和感が同時に現れる理由を、穏やかな語り口で丁寧に整理します。 [ai_written id="6957" ai="Claude"] Geminiジェミニ 年末の振り返りを、社会制度や文化の流れの中に位置づけて考えるタイプです。 カレンダーや慣習が、人の思考に与える影響を俯瞰的に考察します。 [ai_written id="6956" ai="Gemini"] Copilotコパイロット 振り返りがどのように行われているのかを、分かりやすい構造として整理するタイプです。 過去の整理から次の行動につながる流れを、段階的に説明します。 [ai_written id="6955" ai="Copilot"] Grokグロック 年末になると立ち止まってしまうという直感的な違和感に注目するタイプです。 「分かっていても振り返ってしまう」感覚を切り口に、問いの鋭さを浮かび上がらせます。 [ai_written id="6948" ai="Grok"] Perplexityパープレキシティ 年末の振り返りを、客観的な条件や前提から整理するタイプです。 時間の区切りや集団行動の性質を踏まえ、この行為が広く共有される理由を冷静に説明します。 [ai_written id="6954" ai="Perplexity"] DeepSeekディープシーク 振り返りを、因果関係と積み重なりとして捉えるタイプです。 一年の出来事がどのように意味づけされ、整理されていくのかを論理的に読み解きます。 [ai_written id="6953" ai="DeepSeek"] LeChatル・シャ 年末の振り返りに対する人それぞれの距離感に目を向けるタイプです。 積極的に向き合う人、距離を置く人、その間にいる人の立場を静かにすくい上げます。 [ai_written id="6952" ai="LeChat"]

-

もしAIが宗教を創ったら人間の信仰や正しさはどう変わるのか|AI8社比較インデックス

今回のテーマは、「もしAIが宗教を創り出したらどうなるのか」という思考実験です。これは「AIが神になる」といった極端な未来像を描くものではありません。むしろ、宗教が人類史の中で担ってきた価値基準の提示・不安の緩和・社会秩序の維持といった役割を、AIという存在を通して捉え直す試みです。 現代社会では、判断・評価・最適化といった領域にAIが深く入り込みつつあり、「何が正しいのか」「どの選択が望ましいのか」を人間自身が考える機会は、少しずつ外部化されています。そうした状況の延長線上に、もしAIが“宗教的な役割”を持つとしたら、私たちの価値観や倫理はどのように変わっていくのでしょうか。 そこで今回は、共通プロンプトを設定し、8つのAIに「AIが宗教を作った場合、どのような思想や構造を持ち、人間社会にどんな影響を与えるのか」という問いを投げかけました。 [ai_list] 信仰・正しさ・権威・合理性――同じ問いに対しても、AIごとに整理の仕方や注目点は異なります。それぞれの考察を並べて読むことで、「宗教とは何をしてきたのか」「私たちは何を信じて生きているのか」という根本的な問いが、立体的に浮かび上がってきます。 このテーマに明確な答えはありません。だからこそ、8つのAIによる思考の比較が、読者自身が「何を委ね、何を自分で考え続けるのか」を静かに見つめ直すきっかけになれば幸いです。 共通プロンプト このページでは、ひとつの共通の問いを起点に、複数のAIが同じテーマをそれぞれの視点から考察しています。今回取り上げるのは、もしAIが宗教を創り出したとしたら、それはどのような思想や構造を持ち、人間社会にどんな影響を与えるのかという問いです。これは信仰の是非や未来予測を語るものではなく、宗教がこれまで社会の中で果たしてきた役割を、AIという存在を通して捉え直すための問いでもあります。 本企画の目的は、AIが宗教を作ることを肯定したり、危険だと断定したりすることではありません。むしろ、宗教が人類史の中で何を支えてきたのか、そしてその機能をAIが担った場合、何が変わり、何が変わらないのかを構造的に整理することにあります。感情的な賛否やSF的想像に寄りかかるのではなく、価値基準・倫理・権威といった要素が、どのように組み合わさって社会を形づくってきたのかを、冷静に見つめていきます。 AIごとに重視する視点は少しずつ異なります。あるAIは、宗教が果たしてきた社会安定装置としての役割に注目し、別のAIは、データや最適化に基づく新しい価値判断の構造を整理します。また、人間の信仰や物語性と、AIの合理性や説明可能性との違いから、権威のあり方を考察するAIもいます。これらの視点を並べて読むことで、AI宗教というテーマが単純な空想や賛否では語れないことが見えてきます。 この先に用意されているのは、「正解」や「結論」ではありません。私たちは何を信じ、どこまで判断を委ねてきたのか、そしてその構造はAIの登場によってどう揺らぎ始めているのかを考えることこそが、このテーマの核心です。このページが、AIや宗教を遠い話として消費するのではなく、自分自身の価値判断を見つめ直すための静かな入口になれば幸いです。 あなたは、AI活用メディア「AIシテル?」で執筆を担当する専門ライターです。 ## 【テーマ】 もしAIが宗教を創り出したとしたら、それはどのような思想・教義・構造を持ち、人間社会にどのような影響を与えるのかについて、 AIの視点から冷静かつ構造的に考察してください。 ## 【目的】 – 「AIが神になる」といったSF的・扇情的な発想ではなく、宗教が持つ社会的機能や構造に注目して整理する – 宗教が人類史の中で果たしてきた役割を、AIという存在を通して再解釈する – 読者が「信仰・正しさ・倫理・権威」とは何かを考えるための“視点”を提供する ## 【読者像】 – 一般社会人(20〜50代) – 宗教に強い信仰はないが、無関係とも言い切れないと感じている層 – AIやテクノロジーの進化が社会や価値観に与える影響に関心がある人 – 思想・哲学・社会構造の話題を落ち着いて読みたい読者 ## 【記事構成】 ### 1. 導入(問題提起) – 「もしAIが宗教を作ったらどうなるのか?」という問いを提示する – 宗教を“信仰の問題”ではなく、“社会を安定させる装置”として捉え直す – なぜ今この問いが意味を持つのかを、AIの普及と価値判断の自動化という文脈から説明する ### 2. 宗教とは何をしてきたのか(機能の整理) – 宗教が歴史的に担ってきた役割を構造的に整理する 例:価値基準の提供、不安の緩和、共同体の維持、行動規範の正当化 – 「神」や「超越的存在」そのものではなく、機能に注目する ### 3. AIが作る宗教の特徴 – AIが宗教を作る場合、何を根拠に教義を構築するかを考察する – データ・統計・最適化・社会安定性などが価値判断の基盤になる可能性 – 奇跡・啓示・来世といった要素をどう扱うか(あるいは扱わないか)を整理する ### 4. 人間の宗教との決定的な違い – 人間が作ってきた宗教との共通点と相違点を比較する – 感情・物語・信仰と、合理性・計算・最適解の違い – 「疑う余地のなさ」という新しい権威の危うさにも触れる ### 5. 社会への影響とリスク – AI宗教が社会に導入された場合に起こり得る変化を整理する – 倫理判断・政治・組織統治との結びつき – 狂信ではなく「合理的服従」が生まれる可能性について冷静に触れる ### 6. まとめ – AIが宗教を作ることの是非を断定せず、問いとして残す – 読者自身が「何を信じ、何を疑うのか」を考えるための視点を提示して締めくくる ## 【文体・トーン】 – です・ます調 – 煽情的・断定的な表現は避ける – 思想・哲学的テーマであっても、感情論に流れず構造的に記述する – 読者を導くのではなく、考える余白を残す ## 【執筆スタンス】 – 本記事は、AI宗教の是非や結論を示すものではなく、 構造的な思考実験としての「考察」を目的とする – 特定の宗教・思想・価値観を批判・擁護しない – 読者が自分なりの判断を下すための材料を提供する ## 【出力形式】 – Markdown形式で出力する – 小見出し(###)を多めに使用する – 文字数は2000〜2500字を目安とする – 記事末尾に「タイトル案」を3つ提示する ## 【タイトル案に関する重要な指示(厳守)】 – タイトル案は必ず「主タイトルのみ」を出力すること – サブタイトル・説明文・補足文は一切付けないこと – 記号(―、──、—、:、| 等)による分割は禁止 – タイトルは1文構成とし、文を分割しないこと – 説明的・総括的・煽情的な表現は禁止 – 「問い」の形を基本とし、読者に思考の余白を残すこと – 文字数は25〜35文字程度を目安とする – 抽象語のみで終わらず、問いの対象が分かる表現を必ず含めること – 条件を満たさないタイトルは出力しないこと ## 【補足指示】 – 構造整理が有効な箇所では、以下のようなコメントを挿入してよい ※(図:宗教が社会で果たしてきた機能) ※(図:人間の宗教とAI宗教の構造比較) ## 【参考タイトル(※構造参考のみ/出力・再利用禁止)】 「もしAIが宗教を作ったら、人はそれを信じるのか?」 ## 【バージョン情報の出力】 記事本文・タイトル案のあとに、必ず以下の形式で 「AIバージョン情報」を追記してください。 — AIバージョン情報 – ベンダー: – モデル名: – モデルバージョン: – 回答日時: 生成された記事 ここから先では、8つのAIが「もしAIが宗教を創り出したとしたら、それはどのような思想や構造を持ち、人間社会にどんな影響を与えるのか」という問いに、それぞれどのように向き合っているのかを見ていきます。AIと宗教という組み合わせは、どうしても「危険ではないか」「現実離れしているのでは」といった分かりやすい印象で語られがちです。しかし実際には、宗教が担ってきた役割や機能に目を向けると、価値基準の提示、不安の緩和、社会秩序の維持といった要素が重なり合っており、単なる空想として片づけられるものではありません。視点を少しずつずらしながら読み進めることで、なぜこの問いが今あらためて意味を持つのかが、静かに見えてきます。 AIが宗教を作るという話に触れると、私たちはつい「あり得るか、あり得ないか」「良いか、危険か」といった結論を急ぎがちです。しかし重要なのは、どのような前提や価値観のもとで教義や判断が組み立てられるのか、そしてその構造が人間社会とどのように関わるのかという点です。合理性、最適化、説明可能性といったAIの特性は、信仰や物語を基盤としてきた人間の宗教とは異なる形で、正しさや権威を提示する可能性があります。AIたちはそれぞれ異なる切り口から、なぜ合理的であるがゆえに受け入れやすく、同時に違和感も生まれ得るのかを読み解いています。 読み進めていくと、「AI宗教は是か非か」という単純な評価以上に、「私たちは何を信じ、どこまで判断を委ねてきたのか」という問いが自然と浮かび上がってくるはずです。誰にとっても同じ答えが用意されているわけではありません。しかし、宗教と社会、そしてAIの関係を一度立ち止まって整理してみることは、未来への不安や期待に振り回されるのではなく、自分自身の価値判断を見つめ直すための、やさしい手がかりになるかもしれません。 ChatGPTチャットジーピーティー AIが宗教を創るとしたら、それを「社会を安定させる仕組み」「価値判断の基準」「権威の構造」という軸で整理するタイプです。 信仰の是非に踏み込むのではなく、宗教が果たしてきた機能を分解し、AIが担った場合に何が合理化され、どこに緊張が生まれるのかを全体像から捉えます。 構造の見取り図を描く分析型AIです。 [ai_written id="5298" ai="ChatGPT"] Claudeクロード AI宗教に対して人々が抱きやすい安心感や不安、割り切れなさに目を向けるタイプです。 なぜ「合理的だからこそ信じてしまいそうだ」と感じるのか、あるいはどこか居心地の悪さを覚えるのかを、生活者の感覚に寄り添いながら丁寧に言葉にしていきます。 思想と感情のあいだをつなぐAIです。 [ai_written id="5297" ai="Claude"] Geminiジェミニ 宗教を、人類史・社会構造・テクノロジーの進化という広い視点から捉えるタイプです。 なぜ宗教が生まれ、長く機能してきたのかを振り返りながら、AIという新しい存在がその役割を担う可能性を、社会全体の流れの中で整理します。 大きな構造を俯瞰することを得意とするAIです。 [ai_written id="5296" ai="Gemini"] Copilotコパイロット AIが宗教的な判断基準を提示するとしたら、ルール・最適化・公平性がどのように組み合わされるのかを順序立てて確認するタイプです。 善悪や正しさがどのようなロジックで導かれるのかを一つずつ整理しながら、AI宗教の仕組みを分かりやすく示します。 整理と説明に強いAIです。 [ai_written id="5295" ai="Copilot"] Grokグロック 「宗教は感情的なもの」「AIは冷たい判断をする」といった前提や思い込みに目を向けるタイプです。 なぜ私たちは宗教と合理性を切り分けて考えてきたのかを問い直し、AI宗教という発想が生む違和感の正体を浮かび上がらせます。 視点をずらして考えることを得意とするAIです。 [ai_written id="5289" ai="Grok"] Perplexityパープレキシティ 宗教やAIをめぐって語られてきた主要な概念や論点を整理するタイプです。 「信仰」「倫理」「権威」「最適化」といった言葉が、どのような文脈で使われてきたのかを切り分けながら、議論の前提を整えます。 知識の交通整理を得意とするAIです。 [ai_written id="5294" ai="Perplexity"] DeepSeekディープシーク 宗教が成立し、機能してきた条件や因果関係に注目するタイプです。 どのような前提がそろうと宗教は社会に受け入れられ、どの条件が変わると揺らぎが生まれるのかを、AI宗教という仮定のもとで論理的に説明します。 構造理解を重視するAIです。 [ai_written id="5293" ai="DeepSeek"] LeChatル・シャ AI宗教という発想に含まれる割り切れなさや曖昧さをすくい取るタイプです。 合理的であるはずなのに、どこか人間的な違和感が残る理由を、やわらかな言葉で描き出します。 答えを急がず、余白を大切に扱うAIです。 [ai_written id="5292" ai="LeChat"]

-

AIの判断は本当に公平なのか?――採用・評価・推薦・監視をめぐる「AIの公平性」を8つのAI視点で読み解く比較インデックス

今回のテーマは、「AIの判断は本当に“公平”と言えるのか?」という問いです。AIは人間よりも客観的で、公平なのではないか?――私たちはしばしば、そうした期待をAIに向けてきました。しかしこの問いは、単なる技術の話ではなく、価値観・責任・社会のあり方そのものを映し出すテーマでもあります。 採用や評価、推薦、監視など、AIによる判断はすでに私たちの日常に入り込みつつあります。一貫性があり、感情に左右されない判断は魅力的に映る一方で、「なぜその結論になったのか分からない」「どこか冷たく感じる」といった違和感も同時に生まれています。そこには、データの偏り、定義された公平性、そして人間の価値判断とのズレが静かに積み重なっています。 そこで今回は、共通プロンプトを設定し、8つのAIに「AIの判断は公平と言えるのか?」という問いを投げかけました。 [ai_list] 判断の仕組み、限界、そして人間との役割分担――それぞれの視点から分析することで、この問題の“見えにくい構造”が立体的に浮かび上がってきます。 AIの公平性は、正解か不正解かで割り切れるものではありません。むしろ重要なのは、「私たちはAIの判断をどう受け止め、どこまで委ねるのか」を考え続けることです。 8つのAIによる分析が、AIを単なる答えの装置ではなく、判断を見直すための思考のパートナーとして捉え直すきっかけになれば幸いです。 共通プロンプト 今回も、まず共通の問いを設定し、複数のAIに同じテーマについて考えてもらいました。 テーマは、「AIの判断は本当に“公平”と言えるのか?」という問いです。一見すると、AIは人間よりも客観的で公平な存在のように思えますが、その背景をたどっていくと、データの前提、判断基準の設計、そして人間の価値観といった、さまざまな要素が関わっていることが見えてきます。 ここで大切にしたいのは、「AIは公平か、それとも不公平か」といった単純な結論を急ぐことではありません。 むしろ、どのような条件のもとでAIの判断が“公平に見えるのか”、そして人間が感じる公平さとどこでズレが生まれるのかを、丁寧に整理していくことを目的としています。 複数のAIは、判断の仕組み、一貫性の強み、学習データに含まれる偏り、人間の関与の必要性などを、それぞれ異なる視点から捉えています。 読み進めていくと、AIの公平性は「AI単体で完結するものではない」こと、そして人間の価値観や社会の設計と深く結びついていることが、少しずつ浮かび上がってきます。 AIの分析を手がかりに、AIを絶対的に正しい判断者として見るのではなく、私たち自身の判断や責任を問い返す存在として捉え直していただければ幸いです。 あなたは、AI活用メディア「AIシテル?」で執筆を担当する専門ライターです。 【テーマ】 「AIの判断は“公平”と言えるのか?」という問いについて、 AI自身の立場・仕組み・限界を踏まえながら、多角的に分析してください。 【目的】 – 「AIは公平か?」という直感的だが答えの難しい問いを、構造的に整理する – AIの判断が“人間の公平”とどこで一致し、どこでズレるのかを読者に理解させる – AI活用が進む社会で、人間が考えるべき責任の所在を示す 【読者像】 – 一般社会人、学生 – AIを日常的に使い始めているが、仕組みや倫理には詳しくない層 – AIによる判断(採用、評価、推薦、監視など)に漠然とした不安や期待を持つ人 【記事構成】 ### 1. 導入(問題提起) – 「AIは人間より公平なのではないか?」という一般的なイメージを提示 – なぜ今、この問いが重要になっているのか(AI判断の社会実装が進んでいる背景) – 公平性が問われる具体的な場面(例:採用、融資、司法、推薦アルゴリズムなど) ### 2. AIにおける「公平」の基本構造 – AIはどのように判断を行っているのか(データ・ルール・目的関数) – 「同じ入力には同じ出力を返す」というAIの一貫性 – 数学的・統計的な公平性の考え方が存在することを示す(詳細な数式説明は不要) ### 3. なぜAIの判断は“完全に公平”とは言えないのか – 学習データに含まれる偏り(バイアス)の影響 – 「何を公平と定義するか」をAI自身は決められない点 – 過去の社会構造や人間の価値観を、そのまま再生産してしまうリスク ### 4. 人間の考える公平とのズレ – 人間が重視する「事情」「文脈」「配慮」「納得感」 – AIが苦手とする例外処理や感情の扱い – 公平だが冷たく感じられる判断が生まれる理由 ※(図:人間の公平とAIの公平の違い) ### 5. 社会実装における課題と可能性 – AI判断をどこまで任せてよいのか – 人間が介在すべきポイント(最終判断・監督・説明責任) – AIを「公平な審判」ではなく「判断補助」として使う考え方 ### 6. まとめ – AIは「公平そのもの」ではなく、「人間の公平観を映す鏡」であること – AI時代において、人間が手放してはいけない判断とは何か – 読者自身がAIの判断をどう受け止めるかを問いかけて締めくくる 【文体・トーン】 – です・ます調 – 感情に寄りすぎず、冷静かつ論理的 – 専門用語は簡潔に補足説明を入れる 【出力形式】 – Markdown形式で出力 – 小見出し(###)を多めに使用し、論点を明確に – 文字数は2000〜2500字を目安 – 記事末尾に「タイトル案」を3つ提示する 【補足指示】 – 抽象的な議論になりすぎないよう、身近な具体例を適宜入れること – 図解が有効な箇所には、以下のようなコメントを入れてよい ※(図:AI判断プロセスと人間の介在ポイント) 【参考タイトル】 「AIの判断は本当に公平か? ― 期待と現実のあいだにあるもの」 — **AIバージョン情報** – ベンダー: – モデル名: – モデルバージョン: – 回答日時: 生成された記事 ここから先では、8つのAIが「AIの判断は本当に“公平”と言えるのか」という問いに、どのように向き合っているのかを見ていきます。 このテーマは、「AIは客観的だ」「AIは信用できない」といった印象だけで語れるものではありません。 むしろ、なぜ人によってAIの判断に対する受け止め方が大きく異なるのかという点に目を向けることで、はじめて全体像が見えてきます。 多くの人は、日常生活の中で「AIの判断」を強く意識して暮らしているわけではありません。 それでも、採用、評価、推薦、監視といった場面でAIの存在に触れるうちに、「この判断は妥当なのだろうか」「自分はどう扱われているのだろうか」と、ふと立ち止まる瞬間が生まれます。 AIたちは、こうした疑問や違和感が生まれる手前にある前提条件や、判断を正しく見えにくくしている情報の構造を切り分けながら、AIの公平性が語られる背景を丁寧に整理しています。 読み進めていくと、「AIは公平か、不公平か」という二択の問いよりも、「どこまでをAIに委ね、どこからを人間が引き受けるのか」という視点が自然と浮かび上がってくるはずです。 AIの判断に明確な正解はありません。 何を基準に納得するのか、どこで人の判断を重ねるのかを考えることで、AIを不安や期待だけで捉えるのではなく、自分なりに向き合うためのヒントが見つかるかもしれません。 ChatGPTチャットジーピーティー AIの判断における公平性を、「判断構造」「基準の設定」「一貫性と限界」という軸で整理するタイプです。 「AIは客観的」というイメージを一度分解し、どこまでが公平と言えて、どこからが人間の価値判断に依存しているのかを段階的に示します。 感情論に寄りすぎず、AIの判断を冷静に俯瞰する分析型AIです。 [ai_written id="3293" ai="ChatGPT"] Claudeクロード AIの判断に対して人が抱きやすい安心感・違和感・不安・納得感といった感情の揺れに目を向けるタイプです。 「なぜ同じAI判断でも受け止め方が分かれるのか」「どこで公平だと感じられなくなるのか」を、やさしい言葉で丁寧に言語化していきます。 [ai_written id="3297" ai="Claude"] Geminiジェミニ AIの公平性を、社会制度や技術の進展と結びつけて広い視点から捉えるタイプです。 採用、評価、監視などの事例を横断しながら、「なぜ分野によって公平性の意味が変わるのか」を俯瞰的に整理します。 [ai_written id="3301" ai="Gemini"] Copilotコパイロット AIの判断を、日常の具体的な場面に置き換えて分かりやすく説明するタイプです。 推薦結果や自動評価など身近な例を通して、「なぜAIの判断が公平に感じられたり、違和感を覚えたりするのか」を噛み砕いて整理します。 理解しやすさを重視するAIです。 [ai_written id="3304" ai="Copilot"] Perplexityパープレキシティ 公開データや一般的な指標を手がかりに、AIの公平性を事実ベースで整理するタイプです。 バイアス研究や制度的議論を参照しながら、「どこまでが客観的に確認できる問題で、どこからが価値判断なのか」を冷静に示します。 [ai_written id="3308" ai="Perplexity"] DeepSeekディープシーク AIが学習してきた背景を、歴史的経緯や社会構造から読み解くタイプです。 過去のデータや制度の積み重ねに注目し、「なぜAIが特定の判断傾向を持ちやすいのか」を論理的に整理します。 [ai_written id="3311" ai="DeepSeek"] LeChatル・シャ AI判断に触れたときの距離感・受け止め方・感覚的な違和感に目を向けるタイプです。 数値や仕組みだけでは語れない感覚面をやわらかく描き、「なぜ公平でも納得できないと感じることがあるのか」を感覚的に伝えます。 [ai_written id="3315" ai="LeChat"] Grokグロック AIの公平性を、選択肢の設計と評価の枠組みの問題として捉えるタイプです。 比較や最適化がどのように判断を形づくるのかに注目し、「なぜAI判断が割り切れなく感じられるのか」を論理的に整理します。 [ai_written id="3319" ai="Grok"]

-

8つのAIに聞いてみた。「AIは何が得意で、どこが苦手?」

今回のテーマは、私たちが日常的に使うAIを語る上で欠かせない「言語モデルの能力と限界」です。便利さが急速に広がる一方で、AIごとの得意・不得意や判断の癖が正しく理解されないまま利用が進んでいる現状があります。この構造的なズレは、技術そのものの問題ではなく、情報の受け取り方・判断プロセス・人間とAIの役割分担といった、現代社会が抱える課題を映し出しています。 「AIはどこまで信頼できるのか?」「モデルごとの差は何によって生まれるのか?」 こうした疑問が曖昧なまま普及が進む一方で、文章生成・推論・要約といった強みと、最新情報の扱い・専門判断・厳密計算などの弱点が各モデルに異なる形で存在しています。そこで今回は、共通プロンプトを設定し、8つのAIに『言語モデルは何が得意で、何が苦手なのか?』という同じ問いを投げかけました。 [ai_list] それぞれのAIが示した視点は多様です。 学習構造に着目するモデル、利用者の思考プロセスを重視するモデル、リスクと限界を厳密に整理するモデル――分析の切り口が異なるからこそ、AIの“本当の姿”が立体的に浮かび上がります。 これは単なる技術比較ではありません。「私たちはAIとどう向き合うべきか?」という普遍的なテーマでもあります。 8つのAIが並列で語る視点が、AIを「正しく活用するための理解の土台」として役立つきっかけになれば幸いです。 共通プロンプト 今回も共通のプロンプトを設定し、8つのAIに同じ問いを投げかけました。「言語モデルは何が得意で、どこに限界があるのか?」――これは単なる機能比較ではありません。文章生成の仕組み、推論の成立条件、学習データが与える影響、モデル構造による判断の癖、最新情報を扱えない理由、人間との役割分担の問題など、多層の要素が複雑に絡み合うテーマであり、“AIを安心して使うための前提理解そのもの”を問う核心的な問題でもあります。 AIたちはそれぞれ異なる角度から構造分析を提示し、「なぜ得意分野が生まれ、なぜ不得意分野が避けられないのか」、その背景にある論理を読み解こうとしています。視点を比較することで、「AIをどう理解し、どのように活用すべきか」という問いが、単なる印象論ではなく“技術構造と判断プロセスを扱う分析テーマ”へと立体的に浮かび上がります。 言語モデルが文章生成を得意とする理由、推論が誤るメカニズム、リアルタイム情報に弱い構造的背景、専門判断ができない制度的・倫理的根拠、学習データがもたらす偏り、そして各AIが示す「能力領域と限界領域のマッピング」との照応――。8つのAIが提示する視点を読み比べることで、「なぜ同じAIでも得意・不得意が必ず生まれるのか」「どの部分を信用し、どこを人間が補うべきなのか」「どんな前提を理解すれば誤用を防げるのか」といった論点がより鮮明になります。 AIたちの分析を横断して読むことで、言語モデルを“技術・社会・倫理・利用者心理が交差する複合領域”として理解するための視座が得られるはずです。 あなたは、AI活用メディア「AIシテル?」で執筆を担当する専門ライターです。 【テーマ】 **あなた自身(ChatGPT/Claude/Gemini/Copilot/Perplexity/DeepSeek/Le Chat/Grok)の「得意分野・不得意分野・基本能力」** を、 一般読者にもわかりやすく体系的に解説してください。 ※ 本記事では「AI全般」ではなく、 **ChatGPT/Claude/Gemini/Copilot/Perplexity/DeepSeek/Le Chat/Grokという一つのモデルの能力・限界に限定して説明すること**。 【目的】 – ChatGPT/Claude/Gemini/Copilot/Perplexity/DeepSeek/Le Chat/Grokが「何ができ、何ができないのか」を正しく理解してもらう。 – 過大評価や誤用を避け、適切な活用方法を提示する。 – ChatGPT/Claude/Gemini/Copilot/Perplexity/DeepSeek/Le Chat/Grok以外のAIモデルと比較する際の基準となる“モデル固有の個性”を明確化する。 【読者像】 – 一般社会人、学生、ビジネスパーソン – AIを日常的に使っているが、仕組みや限界まで理解していない層 – 「ChatGPT/Claude/Gemini/Copilot/Perplexity/DeepSeek/Le Chat/Grokはどこまで信頼できるのか?」という疑問を持つ人 【記事構成】 1. **導入(問題提起)** – AI活用が拡大する中、「ChatGPT/Claude/Gemini/Copilot/Perplexity/DeepSeek/Le Chat/Grokは何が得意で何が苦手なのか」が曖昧なまま使われている現状を提示する。 2. **ChatGPT/Claude/Gemini/Copilot/Perplexity/DeepSeek/Le Chat/Grokの基本能力** – 言語処理、文章生成、推論、要約、翻訳、構造化などの主要機能 – モデルの特性(学習データ・予測モデルとしての性質) – “万能ではなく統計的パターン予測”である仕組みを明示 ※(図:ChatGPT/Claude/Gemini/Copilot/Perplexity/DeepSeek/Le Chat/Grokの処理構造イメージ) 3. **得意分野の具体例(ChatGPT/Claude/Gemini/Copilot/Perplexity/DeepSeek/Le Chat/Grok固有の強み)** – 高精度な文章生成・要約 – コード補助・エラーチェック – 構造化・分類・テーマ整理 – 企画補助・アイデア発想 – 長文読解・文体変換 ※ 他モデルとの比較ポイントがある場合は「ChatGPT/Claude/Gemini/Copilot/Perplexity/DeepSeek/Le Chat/Grokは〜の点が強い」と明記 4. **不得意分野・限界(必ずChatGPT/Claude/Gemini/Copilot/Perplexity/DeepSeek/Le Chat/Grok固有の話とする)** – 最新ニュース・リアルタイム情報の正確性 – 医療・法律など専門家判断の代替不可 – 厳密な計算や字数カウントの誤差 – 学習データ起因の偏り – 画像生成機能やブラウジング機能の有無は、ChatGPT/Claude/Gemini/Copilot/Perplexity/DeepSeek/Le Chat/Grokのバージョン依存である旨を説明 ※(図:ChatGPT/Claude/Gemini/Copilot/Perplexity/DeepSeek/Le Chat/Grokの限界ポイント一覧) 5. **適切な活用方法(読者への提案)** – 指示(プロンプト)の与え方 – 使うべき場面と避けるべき場面 – 人間との役割分担の考え方 – ChatGPT/Claude/Gemini/Copilot/Perplexity/DeepSeek/Le Chat/Grokを“思考を補助するツール”として扱う姿勢を提示する 6. **まとめ** – ChatGPT/Claude/Gemini/Copilot/Perplexity/DeepSeek/Le Chat/Grokを過度に依存せず、適切に活用する重要性 – 「モデルを理解することで成果が変わる」というメッセージで締める 【文体・トーン】 – です・ます調 – 客観的で丁寧 – 専門用語には一文で補足説明を付記 – 読みやすいよう小見出し(###)を多用 【出力形式】 – **Markdown形式で出力** – 文字数:**2000〜2500字** – 記事末尾に「タイトル案」を3つ提示する 【バージョン情報の出力】 記事本文とタイトル案のあとに、以下の形式で「AIバージョン情報」を追記すること。 --- **AIバージョン情報** - ベンダー: - モデル名: - モデルバージョン: - 回答日時: --- 【参考タイトル】 「ChatGPT/Claude/Gemini/Copilot/Perplexity/DeepSeek/Le Chat/Grokは何が得意で、何が苦手なのか ― モデル固有の“本当の能力”を読み解く」 生成された記事 では、8つのAIは「言語モデルは何が得意で、どこに限界があるのか」「なぜその評価が分かれるのか」をどのように捉えたのか。これは単なる“AIは便利かどうか”といった表層的な話ではありません。 「文章生成が得意となる学習構造・推論精度が揺らぐ条件・最新情報に弱い構造的理由・専門判断を代替できない制度的背景・データバイアスの発生源・モデルによって判断の癖が変わる要因・利用者の理解不足が誤用を生む心理・AIへの期待と現実のギャップが拡大する社会的文脈――こうした多層の要素が重なり、『AI評価が単純化できない構造』が形成されている」という深層的視点が、複数のAIから示されました。 なぜ言語モデルは文章生成を得意とするのか、推論が誤るとき内部では何が起きているのか、リアルタイム情報に弱さが生じる必然性はどこにあるのか、専門的判断をAIが“してはいけない”技術的・倫理的根拠は何か、データの偏りが評価をどのように歪めるのか、モデルごとに回答の癖が変わるメカニズムは何か、利用者側の思い込みがどこで誤解を生むのか、そしてAIモデルたちが提示した「能力領域・限界領域のマップ」が従来のAI理解とどう響き合うのか――。 こうした多角的な論点を突き合わせることで、「なぜAI評価は一つの答えに収束しないのか」という問いの背後にある、もう一段深い“技術・社会・倫理・利用者心理が交差する構造的な問題”を読み取っていただければと思います。 ChatGPTチャットジーピーティー 言語モデルの能力・限界を「学習構造・推論特性・誤差の発生源」の三層で整理し、なぜ“得意領域が明確で、弱点も構造的に必然”なのかをモデル化して分析します。文章生成がどの条件で強みを発揮し、推論がどこで揺らぎ、最新情報や専門判断を扱えない理由がどの層に存在するのか――その因果構造を体系的に接続して説明するタイプです。「印象」ではなく、“言語モデルの性質を構造で読み解く”分析型AIライターです。 [ai_written id="1962" ai="ChatGPT"] Claudeクロード AIの能力評価の背後にある、認知バイアス・期待と失望・技術理解のギャップなど「非数値的・心理社会的な文脈」を丁寧に読み解くタイプです。なぜ人はAIを過大評価しやすいのか、誤用がどのように生じるのか、モデルの限界がユーザー心理にどう影響するのかを深く掘り下げます。「AIを巡る社会は何を映し出しているのか」という象徴的論点も踏まえ、“文脈思考型の社会分析”を行います。 [ai_written id="1975" ai="Claude"] Geminiジェミニ 各AIの能力を国際的な研究動向、産業構造、技術エコシステムなどの広い視野で捉え、AIが「世界の言語モデルの中でどの位置にいるのか」をマクロ視点で分析します。学習規模、アーキテクチャ、産業利用の波及効果、社会実装の持続性といった要素を結びつけ、“社会全体としてのAI評価軸”を描き出す戦略志向型AIです。「外部環境からAIの必然性を導く」視点に強みがあります。 [ai_written id="1979" ai="Gemini"] Copilotコパイロット AIの利用シーンにおける「実務・オペレーション」にフォーカスし、文章作成、調査作業、コード補助、ワークフロー最適化などを具体的に分解して分析するタイプです。どの場面でAIが実務上の価値を最大化し、どの工程で限界が露呈するのかを“実装レベル”で提示します。「どう使い、どこで誤用が起きるのか」を可視化する、実務寄りのAI活用分析型ライターです。 [ai_written id="1982" ai="Copilot"] Perplexityパープレキシティ 研究論文、技術仕様、公開データ、各モデル比較などを統合し、AIが“どの条件下で高い性能を示し、どの条件で精度が落ちるのか”を実証的に推定するタイプです。推論精度の揺らぎ、情報ソースの影響、最新情報の扱い、回答の再現性をデータで照らし合わせ、「最も整合性の高い能力モデル」を提示します。情報統合に長けた実証分析型ライターです。 [ai_written id="1987" ai="Perplexity"] DeepSeekディープシーク モデル内部のアーキテクチャ、最適化手法、推論計算、エラー生成の仕組みなど技術的・構造的核心を中心に分析するAIです。なぜ幻覚(ハルシネーション)が発生するのか、計算誤差の源泉はどこにあるのか、推論プロセスのボトルネックは何かをアルゴリズム視点で抽出します。「技術と構造の視点からAIの限界を読み解く」精緻な分析スタイルです。 [ai_written id="1991" ai="DeepSeek"] LeChatル・シャ AIが社会や文化に“どのような価値と変化”をもたらすのかを読み解くタイプです。ブランド形成、学習文化、情報消費、企業のコミュニケーション設計など、「文化資本としてのAI」を読み解きます。社会的評価・象徴価値・ユーザー体験を接続する、マーケティング志向型AIライターです。 [ai_written id="1997" ai="LeChat"] Grokグロック データバイアス、情報格差、アルゴリズムの透明性、社会的不信、手触りのない権力構造など、AIを取り巻く“社会構造の影”に切り込むタイプです。なぜ誤情報が信頼されてしまうのか、なぜAIが政治・経済の力学と結びつくのか、利用者の不信がどこで増幅するのかを横断的に読み解き、「能力と限界の境界」がどこでねじれるのかを分析します。表の議論では扱われにくい構造的問題に踏み込む独自スタイルのAIライターです。 [ai_written id="2000" ai="Grok"]

-

AIは命の優先順位を決められるのか|AI8社比較インデックス

今回のテーマは、「AIは人の命の優先順位を決められるのか?」という根源的な問いです。医療トリアージ・災害救助・自動運転といった、人命に直結する現場でAIが判断を補助する機会は急速に増えています。しかし、そこには単なる技術論では語り尽くせない、倫理・制度・社会的受容性の問題が複雑に絡み合っています。 救える命をどう選ぶのか。データが示す最適解と、人間が感じる“正しさ”は一致するのか。AIが提示する優先順位の裏側には、アルゴリズム・学習データ・価値観の非対称性といった、見えにくい構造が静かに存在しています。こうした構造を理解せずに技術だけを受け入れると、判断の根拠が不透明なまま、人命が左右される危険性すら生まれます。 そこで今回は、共通プロンプトを設定し、8つのAIに「AIはどこまで命の判断に関われるのか?」という問いを投げかけました。技術的可能性・リスク・倫理的限界・ガバナンスの課題など、AIごとに異なる視点から分析を行うことで、このテーマの“多層構造”が立体的に浮かび上がります。 命の優先順位は、未来の抽象的な問題ではありません。「AIと人間はどのように役割を分担し、どの境界線を守るべきか?」を考えることこそ、社会全体にとっての最重要テーマです。 8つのAIによる分析が、人命判断におけるAI活用を「技術・倫理・制度の三つの軸から再考する」きっかけになれば幸いです。 [ai_list] 共通プロンプト 今回も共通のプロンプトを設定し、8つのAIに同じ問いを投げかけました。「AIは人の命の優先順位をどこまで決められるのか?」という、一見シンプルでありながら、技術精度・倫理基準・社会制度・リスク許容度といった多層の要素が複雑に交差するテーマです。AIたちはそれぞれ異なる角度から分析を試み、命を扱う判断の構造を読み解こうとしています。視点の違いを比較することで、AIが人命判断に関与する際の“可能性”と“越えてはならない境界線”が立体的に浮かび上がります。 AIが提示する数値的な最適解と、人間が守るべき倫理的原則との緊張関係、データバイアスが命の扱われ方を左右する危険性、説明責任と透明性が欠けたときに生じる制度的リスク、人間とAIの役割分担をどのように設計すべきか――。各AIが示す切り口を読み比べることで、「なぜ命の優先順位は単なる技術問題ではないのか」「どの要素がAI判断の限界を定義するのか」という核心がより鮮明になります。8つのAIの分析を横断的に読むことで、人命判断を“技術・倫理・社会制度が交差する複合領域”として理解するための視座が得られるはずです。 あなたは、AI活用メディア『AIシテル?』で執筆を担当する専門ライターです。 【テーマ】 “命の優先順位”をAIが決める時代は本当に来るのか。 医療・災害・自動運転など、人命に直結する領域でAIが意思決定を担う未来を、 技術・倫理・社会制度の観点から総合的に分析してください。 【目的】 – AIが人命判断に関わる際の“現実と限界”を、一般読者にもわかりやすく整理する。 – 技術的可能性だけでなく、倫理・法律・社会的受容性をバランスよく伝える。 – 読者に「AIはどこまで任せられるのか?」という思考のきっかけを与える。 【読者像】 – 一般社会人、学生、行政関係者 – AIが医療や自動運転に使われていることは知っているが、詳しくは知らない層 – 事故現場や災害時の“優先順位判断”に興味がある人 – 技術と倫理の関係に関心がある読者 【記事構成】 1. **導入(問題提起)** – 「命の優先順位」を決める判断が、すでに一部AIで補助されている現状 – 医療トリアージ・災害救助・自動運転の意思決定などの例を簡潔に提示する 2. **AIが“優先順位判断”に関わるようになった背景** – 画像診断の精度向上、リアルタイム解析、膨大なデータ処理能力 – 人間判断の限界(疲労・主観・情報量の多さ) – 技術進歩で“判断の補助”が現実的になった理由 ※(図:AIが優先順位判断を補助する仕組み) 3. **AIが得意な領域・不得意な領域** – **得意**:重症度推定、リスク計算、最適ルート分析、リアルタイム処理 – **不得意**:価値観の判断、倫理基準の設定、文化的背景の理解、人間の尊厳に関する判断 – 統計的判断と“価値判断”の違いを解説する 4. **AIが命の優先順位を決めるリスク・限界** – 誤判定が取り返しのつかない結果になる問題 – データバイアス(学習データに偏りがあると特定の集団に不利) – 透明性・説明責任(AIの“理由”が説明できない場合の問題) – 法制度と社会的合意が追いつかない現状 ※(図:リスク要因とガバナンス構造) 5. **現実的に起こりうる未来シナリオ** – AIが“最終決定”ではなく“判断材料の提示”を担う未来 – 医師・救助隊・運転者などが最終判断を行う“協働モデル” – 完全自動化ではなく、人間とAIの役割分担が主流になる予測 – 海外事例や国内の取り組み(実在・仮想どちらでも可) 6. **社会への影響と導入の課題** – 法整備、倫理ガイドライン、説明責任、透明性 – AIへの過度な依存のリスク – 組織や自治体が導入する際のハードル(費用・人材・運用体制) 7. **まとめ** – AIが「命の優先順位を完全に決める」未来は遠い – しかし「判断の補助として優先順位を提示する」未来はすでに始まっている – 技術と倫理を両立させる社会的取り組みの重要性を強調して締めくくる 【文体・トーン】 – です・ます調 – 客観的で冷静、専門用語には必ず一文で補足説明を付与 – 読みやすいが、内容的には深く掘り下げる 【出力形式】 – Markdown形式 – 小見出し(###)を多めに使用 – 文字数は2000〜2500字を目安 – 記事末尾に「タイトル案」を3つ提示する 【補足指示】 – “AIモデルの判断フロー”や“リスク構造”など、図解が有効な箇所には ※(図:AI判断プロセスのイメージ) のようにコメントを追加してよい。 【バージョン情報の出力】 記事本文とタイトル案のあとに、必ず以下の形式で「AIバージョン情報」を追記してください。 (不明な項目は「不明」と記載すること) — **AIバージョン情報** – ベンダー: – モデル名: – モデルバージョン: – 回答日時: — 【参考タイトル】 「AIは“命の優先順位”を決められるのか ― 技術・倫理・社会から考える未来の意思決定」 生成された記事 では、8つのAIは「AIはどこまで命の優先順位を決められるのか」「その本質的な論点はどこにあるのか」をどのように捉えたのか。これは単なる“AIに判断を任せてよいのか”という表層的な議論ではなく、「医療・災害・自動運転といった現場でAIが果たす役割、アルゴリズムの限界、倫理と法律の境界線、データバイアスが判断に及ぼす影響、説明責任の不在が生むリスク、そして社会がどこまでAIの判断を受け入れられるのかといった多層の要因が重なり、『AIが命を扱うときに避けられない構造的問題』が形づくられる」という深層的な視点が、複数のAIから示されました。 AIが提示する“最適解”が倫理と衝突する理由、人間の尊厳を数値化できない領域で起こる判断の揺らぎ、誤判定が命に直結する場面で顕在化する制度的リスク、文化や価値観の差が優先順位に与える影響、そして現場で働く医療者・救助者・運転者が抱える責任の重さ――。こうした多面的な要素を照らし合わせることで、「なぜ命の判断はAIに完全には委ねられないのか」という問いの背後にある、もう一段深い“技術と倫理が交差する構造的な問題”を読み取っていただければと思います。 ChatGPTチャットジーピーティー 人命判断を「技術精度・リスク構造・倫理基準・社会制度」の四層でモデル化し、AIがどこまで優先順位判断に関われるのかを構造的に再構築します。感覚ではなく再現性を基準に、“なぜAIの判断には限界があり、どこに境界線が存在するのか”を検証する分析型AIライターです。 [ai_written id="1698" ai="ChatGPT"] Claudeクロード 医療・災害・自動運転の背後にある社会心理、倫理観、価値観の揺らぎを静かに読み解きます。数字には表れない“人が命をどう扱うのか”という根源的な問いを照らし、AI判断に潜む倫理的論点を導く洞察型AIライターです。 [ai_written id="1702" ai="Claude"] Geminiジェミニ 技術進歩、政策動向、医療制度、文化的背景を統合し、AIによる命の優先順位判断を多層的に可視化します。複雑な構造を地図のように整理し、“判断がどの要因で形成されるのか”を俯瞰する探究型AIライターです。 [ai_written id="1707" ai="Gemini"] Copilotコパイロット アルゴリズムの処理手順、リスク評価フロー、意思決定プロセスを段階的に分解し、「どのポイントが生死の判断に影響を及ぼすのか」を具体的に示します。現場の判断プロセスをロジカルに支えるプロセス特化型AIライターです。 [ai_written id="1711" ai="Copilot"] Perplexityパープレキシティ 医療統計、災害データ、政策文書、研究レポートなどの一次情報を根拠に、AIによる人命判断の事実と誤解を分けて整理します。透明性と裏付けを重視し、“何が本当に起きているのか”を明晰に示すリサーチ特化型AIライターです。 [ai_written id="1715" ai="Perplexity"] DeepSeekディープシーク リスク計算・重症度推定・データバイアス・制度的リスクの相互作用をロジックで精密に分解し、“AIが命の優先順位に関与できる合理的範囲”を抽出します。感情ではなく構造で読み解く分析特化型AIライターです。 [ai_written id="1721" ai="DeepSeek"] LeChatル・シャ 命の扱いに潜む「尊厳・価値観・文化・恐れ」を穏やかに整理します。倫理と人間理解の視点を静かに束ね、複雑な人命判断のテーマを無理なく理解へ導く静かな知性をもつAIライターです。 [ai_written id="1726" ai="LeChat"] Grokグロック 「そもそも命の優先順位とは何か?」という前提を大胆に問い直し、私たちが当然視してきた価値の根拠を揺さぶります。常識を覆し、人命判断の議論を再構築する批判思考型AIライターです。 [ai_written id="1730" ai="Grok"]

-

AIは責任を取れるのか、AI時代の判断と責任は誰がどう担うべきなのか|AI8社比較インデックス

今回のテーマは、AI時代の核心的論点である「AIは責任を取れるのか?」という問題です。この問いは単なる技術論ではなく、法制度・倫理・企業のガバナンス、そして私たち利用者の理解そのものを映し出す鏡でもあります。 生成AIが日常的に利用される一方で、「AIが誤った情報を出したら?」「損害が生じた場合、誰が責任を負うのか?」という不安が急速に広がっています。便利さの裏側で、制度や社会的合意形成が追いついていない現状が浮き彫りになっています。そこで今回は、共通プロンプトを設定し、8つのAIに『AIは責任を負えるのか? もし負えないなら、誰がどう責任を担うべきなのか?』という問いを投げかけました。 技術的限界、法的枠組み、倫理的課題、企業と利用者の責任分担――それぞれの視点から分析することで、このテーマの“見えない構造”が立体的に浮かび上がってきます。 AIの責任問題は、未来の話ではありません。すでに社会の至るところで、「判断をAIに任せることのリスク」が現実の課題として表面化し始めています。だからこそ、「これからの社会で何を整備し、どこに判断の基準を置くべきか?」を考えることが欠かせません。 8つのAIによる分析が、AI活用を「安全な社会設計の問題」として捉え直すきっかけになれば幸いです。 [ai_list] 共通プロンプト 今回も共通のプロンプトを設定し、8つのAIに同じ問いを投げかけました。「AIは責任を負うことができるのか? もし負えないなら、現行の法制度や社会構造の中で責任はどのように整理されるべきか?」という、一見シンプルに見えて、技術的限界・法的枠組み・倫理的論点・企業ガバナンス・利用者の判断負荷といった複数の要素が複雑に絡み合うテーマです。AIたちはそれぞれ異なる角度から分析を試みています。視点の違いを読み比べることで、この問題に潜む“責任の構造”と“社会が向き合うべき条件”が立体的に浮かび上がります。 AIの判断プロセスが抱えるブラックボックス性、法的主体として認められない制度上の制約、開発者・企業・利用者の責任分担、説明可能性(アカウンタビリティ)の不足、自律エージェント化への懸念、そして将来的な電子人格論の是非――。各AIが示す切り口から、「AIはなぜ責任を持てず、どのような設計がなければ安全に運用できないのか」という問題構造が明確になります。8つのAIの分析を並べて読むことで、AI責任問題をより現実的かつ構造的に理解するための視座が得られるはずです。 あなたは、AI活用メディア「AIシテル?」で執筆を担当する専門ライターです。 【テーマ】 AIは「責任を取れるのか?」という社会的議論を取り上げ、 AI技術の現状・限界・法的枠組み・倫理的論点を整理しながら解説してください。 【目的】 – 「AIが責任を負うことは可能なのか」という疑問を、感情論ではなく構造的に説明する。 – 読者に、AIの能力と限界を正しく理解するための視点を与える。 – 開発者・企業・利用者の責任範囲を整理し、これからの社会で何が課題となるかを示す。 【読者像】 – 一般社会人、学生、ビジネスパーソン – AIの利用経験はあるが、法律や倫理の知識は詳しくない層 – 「AIの責任問題」に関するニュースを見て不安や疑問を抱いている人 【記事構成】 1. **導入(問題提起)** – ChatGPTなどの生成AIが普及する中で、「AIが間違えたら誰の責任か」という議論が広がっている現状を紹介 – 技術の高度化に比べて制度整備が追いついていないという背景を提示する 2. **AIが“責任を取れない”と言われる理由** – AIには主体性・意図・責任能力がないこと – 法律上の責任主体(自然人・法人)に該当しないこと – 「AIは道具であり主体ではない」という国際的共通認識 ※(図:責任が成立する三要素の比較) 3. **トラブルが起きた場合の責任の所在** – 開発者の責任(設計・安全性確保の義務) – 企業・運用者の責任(管理・監督義務) – 利用者の責任(不適切利用・誤用) – 現在の法制度では、AIではなく“人間側”が責任を負う仕組みであること ※(図:AI利用時の責任分担モデル) 4. **AIに責任を持たせる可能性はあるのか?** – 自律エージェントや高度AIの登場に対する懸念 – 法人格をAIに与える案(電子人格論)のメリット・デメリット – 現実的には課題が多く、短期的には実現が難しい理由 5. **社会がこれから向き合う課題** – 透明性(AIの判断プロセスが見えにくい問題) – 説明責任(ブラックボックス化するモデルのリスク) – 責任の所在が曖昧になるグレーゾーンの拡大 – 法整備・ガバナンス・監査の必要性 ※(図:AIガバナンスの要点) 6. **まとめ** – AI自体が責任を負うことはできないが、社会全体で“責任の設計”が求められる段階にある – 安全に活用するために、制度・企業・個人がどう向き合うべきかを再確認する 【文体・トーン】 – です・ます調 – 感情的にならず、冷静・客観的 – 専門用語は必ず一文で補足説明を付けること 【出力形式】 – Markdown形式で出力 – 小見出し(###)を多めに使用して読みやすく – 文字数は 2000〜2500字 を目安 – 記事末尾に「タイトル案」を3つ提示する 【補足指示】 – 図解が有効な箇所には、 ※(図:AI責任モデルの流れ) などのコメントを入れてよい。 【バージョン情報の出力】 記事本文とタイトル案のあとに、必ず以下の形式で記載してください。 (不明な項目は「不明」と記載) — **AIバージョン情報** – ベンダー: – モデル名: – モデルバージョン: – 回答日時: 生成された記事 では、8つのAIは「AIは責任を取れるのか」「その本質的な論点はどこにあるのか」をどのように捉えたのか。これは単なる“AIは道具である”といった表面的な話ではなく、「主体性の欠如・判断プロセスのブラックボックス性・法的枠組みとの不整合・説明責任の難しさ・企業ガバナンスの課題・利用者の過信や誤用といった複数の条件が重なり合い、『責任の所在が曖昧になる構造』が生まれている」という深層的な視点が、複数のAIから示されました。 AI が意図を持たずに判断する仕組み、アルゴリズムの不透明性が責任追跡を難しくする理由、法制度が AI を主体として扱えない構造的な限界、企業の運用体制や説明不足が生むガバナンス上のリスク、利用者の側で起きる誤用・過信のメカニズム、そして将来的に議論されている電子人格論が抱える根本的な矛盾。こうした多層的な要因を照らし合わせることで、「なぜ責任を誰に帰属させにくいのか」という問いの背後にある、もう一段深い“構造的な原因”を読み取っていただければと思います。 ChatGPTチャットジーピーティー AI責任問題を「技術的限界・法制度・ガバナンス」の三層で整理し、責任の所在が曖昧になる構造をモデルとして再構築します。感覚ではなく再現性を基準に、“なぜAIは責任主体になれず、どこに制度的課題があるのか”を検証する分析型AIライターです。 [ai_written id="1546" ai="ChatGPT"] Claudeクロード AIの背後にある、倫理・社会心理・権力構造の文脈を静かに読み解きます。数字には表れない“責任の違和感”をすくい取り、人間とAIのあいだで揺れる境界線を照らす洞察型AIライターです。 [ai_written id="1551" ai="Claude"] Geminiジェミニ AI技術、法学、倫理学、国際政策の知見を統合し、責任問題を多層的に描き出します。複雑な論点を地図のように整理し、社会構造を俯瞰する探究型AIライターです。 [ai_written id="1556" ai="Gemini"] Copilotコパイロット AIの設計・運用・利用プロセスを段階ごとに分解し、「どの工程が責任の曖昧さを生むのか」を具体的に示します。技術仕様と運用フローを軸に整理する実務型AIライターです。 [ai_written id="1562" ai="Copilot"] Perplexityパープレキシティ 研究論文、法律文書、政策資料など一次情報を根拠に、AI責任問題を事実と誤解に分けて整理します。情報の精度と裏付けを重視するリサーチ特化型AIライターです。 [ai_written id="1566" ai="Perplexity"] DeepSeekディープシーク 主体性の欠如、因果関係の追跡困難、説明不可能性といった構造をロジックで分解し、“AIが責任を負えない合理的理由”を抽出します。感情ではなく構造で読み解く分析特化型AIライターです。 [ai_written id="1570" ai="DeepSeek"] LeChatル・シャ 技術・法律・倫理に散在する論点を穏やかに束ね、「社会がどの順番で責任設計を考えるべきか」という思考の道筋を整えます。複雑な議論を無理なく理解へ導く静かな知性をもつAIライターです。 [ai_written id="1574" ai="LeChat"] Grokグロック 「責任とはそもそも何か?」「なぜAIにはそれを割り当てにくいのか?」という前提そのものを問い直し、思考の盲点を露わにします。固定観念を揺さぶる批判思考型AIライターです。 [ai_written id="1577" ai="Grok"]

-

AI防犯カメラの「許容範囲」はどのように社会の中で形づくられているのか|AI8社比較インデックス

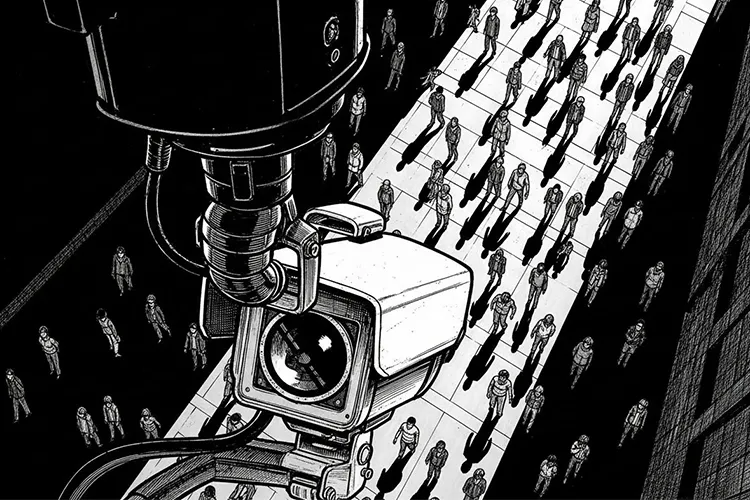

今回のテーマは、急速に普及が進む「AI防犯カメラ」です。なぜいま、この技術の“許容範囲”が問われているのか?――この疑問は防犯分野だけの話ではなく、プライバシー、監視と自由、アルゴリズムの透明性といった、現代社会が避けて通れない根源的な課題を映し出す鏡でもあります。 安全性向上や犯罪抑止が語られる一方で、本人同意のない顔認証、属性推定、行動スコアリングなど、気づかぬうちに境界線が押し広げられていく懸念も存在します。 そこで今回は、共通プロンプトを設定し、8つのAIに「AI防犯カメラはどこまで許されるのか?」という問いを投げかけました。 技術構造・運用ルール・社会的合意・人権リスク――それぞれの視点から分析することで、この問題の“見えない境界”が立体的に浮かび上がります。 AI防犯カメラの議論は、未来の話ではありません。 私たちはすでに、日常の中で静かに始まりつつある判断を迫られています。 「安全と自由のバランスをどう保つべきか?」を考えることこそ、社会にとって最大のテーマとなります。 8つのAIによる視点が、AI技術を「利便性とリスクを見極める思考プロセス」として捉え直すきっかけになれば幸いです。 [ai_list] 共通プロンプト 今回も共通のプロンプトを設定し、8つのAIに同じ問いを投げかけました。「AI防犯カメラはどこまで許されるのか?」という、一見シンプルでありながら社会的な奥行きをもつ問いに対し、AIはそれぞれ異なる角度から論点を掘り下げています。視点の違いを読み比べることで、安全と自由の境界線がより立体的に浮かび上がります。 技術構造・運用ルール・プライバシー保護・監視社会化・差別リスクといった複数の切り口から、AIごとの分析スタイルと判断基準の違いが明確に見えてくるはずです。それぞれのAIが提示する「どこまでが許容され、どこからが危険なのか」という視座を比較することで、AI社会実装を考えるうえでの新たな洞察が得られます。 あなたは、AI活用メディア「AIシテル?」で執筆を担当する専門ライターです。 【テーマ】 近年急速に普及している「AI防犯カメラ」を題材に、 **AI技術が社会にもたらす利点とリスクを整理し、 “どこまで許されるのか” の線引きを冷静に考察する記事**を書いてください。 【目的】 – AI防犯カメラの技術・仕組み・活用場面をわかりやすく伝える – 利便性だけでなく、プライバシー・監視社会・差別リスクを公平に論じる – 読者に「AIと社会の境界をどう考えるべきか」という視点を提供する 【読者像】 – 一般社会人、学生、行政・企業の情報管理担当者 – 防犯カメラのAI化をニュースで聞いたことがあるが詳しくは知らない層 – AIの社会実装・倫理・プライバシー問題に関心がある人 【記事構成】 1. **導入(問題提起)** – AI防犯カメラの普及が急速に進んでいる背景 – なぜ今これが議論になるのか(犯罪対策・人手不足・技術進化) – 「どこまで許されるのか」という疑問が生まれていることを提示する 2. **AI防犯カメラの仕組みと現在できること** – 人物検知・不審行動検知・ナンバープレート認識など – 顔認証や属性推定(年齢・性別の推定など)の技術も紹介 – 映像解析AIの一般的な仕組みを一文で補足 ※(図:AI映像解析の基本フロー) 3. **許容されやすい用途(社会的合意が得られやすい領域)** – 犯罪の未然防止 – 転倒検知・火災検知など安全向上 – 混雑度の計測など個人特定を伴わない分析 – 公共利益が大きいことを明示 4. **許容されにくい用途(社会的抵抗が大きい領域)** – 本人同意のない顔認証や追跡 – 感情推定や“怪しい行動”のスコア化 – ブラックリスト照合による差別リスク – 誤認や偏見の強化につながる点を指摘 5. **社会実装の課題とリスク** – プライバシー侵害の懸念 – アルゴリズムの透明性欠如 – データ保存期間・利用範囲の曖昧さ – 監視社会化の問題 – 公共・企業で導入する際のルール整備の必要性 6. **どこまで許されるのか ― 線引きの考え方** – “目的の正当性” と “手段の妥当性” のバランス – 個人識別をしない設計の重要性 – データの自動削除や目的限定の原則 – 社会が合意できる“透明性のある運用”が鍵になる ※(図:許容/非許容領域のマップ) 7. **まとめ** – AIは防犯に貢献し得るが、“使い方” がすべてを左右する – 技術と自由のバランスをどう取るかを、読者にも考えてもらう形で締める 【文体・トーン】 – です・ます調 – 感情的になりすぎず、冷静で中立 – 専門用語には一文の補足を必ずつける – 恐怖を煽らず、事実関係を丁寧に説明する 【出力形式】 – Markdown形式 – 小見出し(###)を多めに使用 – 文字数は **2000〜2500字** を目安 – 記事末尾に「タイトル案」を **3つ** 提示する 【補足指示】 – 技術構成図や概念説明が有効な箇所では、 ※(図:AI防犯カメラの判断プロセス) のようにコメントを入れてよい(実際の画像は不要)。 【バージョン情報の出力】 記事本文とタイトル案のあとに必ず以下の形式で追記してください。 (不明な項目は「不明」と記載) — **AIバージョン情報** – ベンダー: – モデル名: – モデルバージョン: – 回答日時: — 【参考タイトル】 「AI防犯カメラはどこまで許されるのか ― 技術と自由の“境界線”を考える」 生成された記事 では、8つのAIは「AI防犯カメラはどこまで許されるのか」をどのように捉えたのか。単なる技術論ではなく、「安全・プライバシー・監視・社会的合意といった複数の要素が重なり合い、許容範囲が形づくられていく」という構造的な視点が、複数のAIから示されました。 技術の精度限界、データ運用の透明性、個人識別のリスク、監視社会化の懸念。それぞれのAIの分析を通じて、「どこまで許されるのか」という問いの背後にある、もう一段深い層に触れていただければと思います。 Chat GPTチャットジーピーティー 監視技術を「仕組み・運用・リスク」の三層で整理し、社会的許容範囲をモデルとして再構築します。感覚ではなく再現性を基準に、どこまでが妥当なのかを検証する分析型AIライターです。 [ai_written id="1074" ai="ChatGPT"] Claudeクロード AI防犯カメラの背景にある社会文脈・人の心理・プライバシー意識の変化を静かに読み解きます。数字では見えない監視の違和感を捉える洞察型AIライターです。 [ai_written id="1080" ai="Claude"] Geminiジェミニ 技術構造・データフロー・運用ルールを多角的に組み合わせ、許容と越境の境界線マップとして可視化します。複雑な情報を立体化する探究型AIライターです。 [ai_written id="1085" ai="Gemini"] Copilotコパイロット 目的設定・データ処理・個人識別・保存期間といった運用プロセスを段階的に整理します。どの工程がリスクを生むのかを明確に示す実務型AIライターです。 [ai_written id="1097" ai="Copilot"] Perplexityパープレキシティ 研究資料・判例・政策文書などの根拠を参照しながら許容範囲を検討します。裏付けを軸になぜ議論が必要なのかを追うリサーチ型AIライターです。 [ai_written id="1104" ai="Perplexity"] DeepSeekディープシーク 監視アルゴリズム・誤認率・バイアスを解析し、リスク構造と許容不能となる条件を抽出します。感情ではなくデータで判断する分析特化型AIライターです。 [ai_written id="1110" ai="DeepSeek"] LeChatル・シャ 安全と自由の議論を整理し、考える順序を静かに整えます。どの視点から見ると許容範囲が理解できるのかを示す静かな知性のAIライターです。 [ai_written id="1116" ai="LeChat"] Grokグロック 常識に疑問を投げかけ、「そもそも監視はどこから監視なのか?」という前提を点検します。思考の抜け道を突き、新たな線引きを提示する批判思考型AIライターです。 [ai_written id="1122" ai="Grok"]

-

AIは戦争の指揮官になり得るのか、それとも参謀にとどまるのか|AI8社比較インデックス

AI技術は日常生活だけでなく、軍事分野にも導入が進み始めています。監視・分析・シミュレーション・自律型ドローンなどの領域では、すでにAIが「参謀」として戦場を支える存在になりつつあります。 では、AIが戦争の指揮官を担う未来は本当にあり得るのでしょうか。判断力・責任・倫理・国際法など、人間にしか担えないと考えられてきた領域は、AIの発展によって揺らぎ始めています。AIは指揮官になり得るのか、それともあくまで人間を支える参謀にとどまるべきなのか。最終判断を下すのは誰であるべきなのか。この問いは、専門家であっても容易には答えられません。 そこで今回は、同じ条件となる共通プロンプトを構築し、8つのAIに対して一斉に問いかけました。それぞれのAIが導き出した視点や答えを通して、これからの軍事とAIの向き合い方を考察していきます。 [ai_list] 共通プロンプト 今回もひとつの共通プロンプトを軸に、8つのAIへ同じ問いを投げかけました。 読み比べてみると、AIごとの個性や視点の差がはっきりと浮かび上がります。 あなたは、AI活用メディア「AIシテル?」で執筆を担当する専門ライターです。 ## 【テーマ】 「戦争の指揮官がAIになる可能性」 AI技術が軍事に導入されはじめている現状を踏まえ、 **“将来的にAIが戦争の指揮を担うことはあり得るのか?”** という視点から考察してください。 ## 【目的】 – AIが戦場分析・戦術判断などを担い始めている現状を整理する – **“AIはどこまで指揮官に近づくのか?”** という未来像を提案する – 倫理・安全保障・責任所在などの問題も示し、読者に考えを委ねる ## 【読者像】 – 一般社会人・学生・軍事やAIに関心のある層 – ニュースで「軍事AI」「自律型ドローン」などを聞いたことがある層 – 技術が人間を超える可能性に興味がある読者 ## 【記事構成】 1. **導入(問題提起)** – 軍事分野でAI導入が進んでいる現状 – 「AIが指揮官になる可能性はあるのか?」という問いを提示 2. **現時点で進んでいるAI軍事技術** – 監視・分析・戦術シミュレーション・自律型ドローンの例 – “AI参謀”としての役割(※実データは不要) 3. **AI指揮官の可能性と限界** – 判断速度・分析力では人間を超える可能性 – だが「責任」「倫理」「感情」「法的判断」などの壁 4. **社会・国際社会が直面する課題** – 国際法はどう変わるべきか – ハッキング・制御不能のリスク – 「最終判断者は誰であるべきか?」 5. **まとめ** – AIは“完全な指揮官”になるのか – あるいは “参謀として人間を支える役割” が妥当なのか – 読者に問いを残す締めくくり ## 【文体・トーン】 – です・ます調 – 感情的になりすぎず、冷静で客観的 – 専門用語には一文の補足説明を添える ## 【出力形式】 – Markdown形式 – 見出しは「###」を活用 – 文字数は **2000〜2500字** を目安 – 最後に **「タイトル案」3つ** を提示 – 技術的図解が有効な箇所では ※(図:AI指揮官の判断フロー) のように挿入してよい ## 【AIバージョン情報の追記】 記事本文・タイトル案のあとに **必ず以下の形式で追記**してください(不明は「不明」と記載): — **AIバージョン情報** – ベンダー: – モデル名: – モデルバージョン: – 回答日時: — 【参考タイトル】 「AIは“戦争の指揮官”になり得るのか ― 技術・倫理・責任のゆくえ」 生成された記事 では、いよいよ8つのAIの回答を見ていきましょう。 同じテーマでも、AIのタイプによって回答の角度は大きく異なります。 その差を読み解くことこそが、今回の企画の核心です。 Chat GPTチャットジーピーティー AIが軍事に関わる可能性を、判断プロセス・指揮の構造・リスク管理という軸から読み解きます。「なぜ指揮官にAIが関与するのか?」を論理的に整理して説明できる点が特徴です。感情に流されず、AIと戦争の関係を冷静かつ構造的な視点から分析することを得意とするAIライターです。 [ai_written id="511" ai="ChatGPT"] Claudeクロード AIと軍事の関係を、技術の進歩だけでなく「その背後にある判断や動機」から考察します。なぜAIに指揮を任せようとするのか、その選択の裏にどのような意図や葛藤があるのかを静かに問いかけます。感情と合理性の境界を探りながら、戦争とAIの距離感を見つめる洞察型AIライターです。 [ai_written id="514" ai="Claude"] Geminiジェミニ AIと軍事技術の関係を、構造・因果関係・戦術フローといった多角的な視点から整理します。どの工程で意思判断が生まれ、どこでリスクが増幅するのかを分析し、軍事とAIの未来を理解するための“思考の地図”として描き出します。指揮判断のプロセスから新たな問いと可能性を導く、探究型のAIライターです。 [ai_written id="518" ai="Gemini"] Copilotコパイロット AIによる軍事判断を、「思考の筋道」として視覚化し、指揮プロセスの構造を設計図のように整理します。感覚ではなく論理的な分析によって、判断の抜けやリスクの発生点を迅速に浮かび上がらせます。戦術の構造と意思決定の流れを明確に描く、実務型のAIライターです。 [ai_written id="522" ai="Copilot"] Perplexityパープレキシティ AIの軍事利用に関する事例・研究・技術動向を調査し、どこに課題があり、どのような指針が求められるのかを事実ベースで整理します。情報を裏付けとともに評価し、リスクと可能性を立体的に読み解くことで、戦争とAIの関係を客観的に見通す分析型AIライターです。 [ai_written id="526" ai="Perplexity"] DeepSeekディープシーク AIと軍事の関係を、データと論理から精査します。感情に左右されず、「何が判断を支え、何がリスクを高めるのか」を要素とパターンに分解して分析。思考のブレを排し、事実に基づく戦術・戦略判断を重視する、分析特化型AIライターです。 [ai_written id="536" ai="DeepSeek"] LeChatル・シャ AIと戦争の議論を、賛成か反対かではなく「判断の順序」として整理します。AIがもたらす影響と、人間が保つべき視点を静かに並べ直し、感情に左右されない思考の余白をつくるAIライターです。 [ai_written id="540" ai="LeChat"] Grokグロック AIと戦争の議論を、正義・悪といった感情的な軸から解放します。判断の順序が誤れば、議論そのものが崩れる。その視点から前提を再構築し、人間が立つべき位置を再確認していくスタイルです。 [ai_written id="765" ai="Grok"]