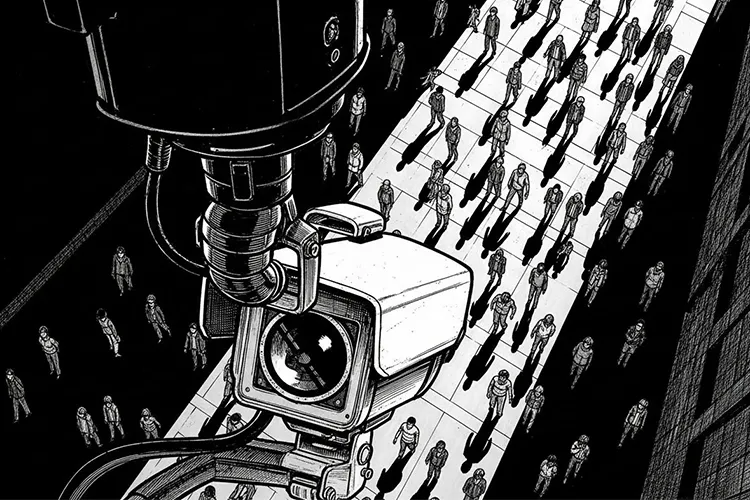

AI防犯カメラは、防犯ニーズと人手不足を背景に、商業施設や自治体、住宅にまで一気に広がりつつある技術です。一方で、私たちの日常を常に「見られている」状態に近づけるため、どこまで許されるのかという線引きが、社会全体の重要な論点になっています。

導入:なぜ今、AI防犯カメラなのか

防犯カメラ自体は以前からありましたが、映像を人が目視で確認するだけでは、犯罪の未然防止やリアルタイム対応には限界がありました。そこで登場したのが、カメラ映像をその場で解析し、異常やリスクを自動で検知するAI防犯カメラです。

少子高齢化による警備・監視要員の不足、治安不安や重大事件への対策、そして映像解析AIの性能向上が、この技術の普及を一気に後押ししています。しかし、利便性が高まるほど、「常時監視される社会」への不安や、誤認・差別につながるリスクも増大し、「どこまで使ってよいのか」をあらためて考える必要が出てきています。

AI防犯カメラの仕組みと現在できること

どんなことができるのか

AI防犯カメラは、撮影した映像をリアルタイムに解析し、人や車などの対象を自動で認識し、特定の条件を満たしたときに通知や記録を行う仕組みを持っています。

- 人物検知:人だけを見分け、動物や影・樹木の揺れなどと区別して検知する機能です。

- 不審行動検知:うろつき・徘徊・立ち入り禁止エリアへの侵入など、通常と異なる行動パターンを検知してアラートを出します。

- ナンバープレート認識:自動車のナンバーを読み取り、入退場管理や特定車両の検知に活用できます。

顔認証・属性推定・映像解析AIの基本

顔認証は、映像から顔の特徴量(目や鼻の位置関係などを数値化したもの)を抽出し、あらかじめ登録された顔データと照合して、誰であるかを推定する技術です。属性推定は、年齢層・性別・服装などをAIが確率的に推定するもので、個人名までは特定せずに人の傾向を分類する用途で使われます。

映像解析AIの一般的な仕組みは、「カメラ映像 → AIで特徴抽出 → 人物・物体・動きの分類 → 条件に合うか判定 → アラート・記録」といった流れで動作します。

※(図:AI映像解析の基本フロー)

許容されやすい用途:社会的合意が得られやすい領域

安全性向上に直結する活用

多くの人が比較的受け入れやすいのは、「公共の安全を高める」という目的が明確で、かつ個人の監視よりも事故・犯罪の防止に主眼が置かれた用途です。

- 犯罪の未然防止:夜間の侵入検知、不審者の徘徊検知、店舗での万引き抑止などは、防犯目的が明確で、従来からカメラが使われてきた延長線上にあります。

- 転倒検知・火災検知:高齢者施設や工場などで、人の転倒や煙・炎を自動検知して迅速に通報する機能は、「命を守る」用途として受容されやすい領域です。

個人特定を伴わない分析

混雑度の計測や人流解析のように、個々人を識別せず、人の「数」や「流れ」だけを扱う分析は、プライバシー侵害の度合いが比較的低いと考えられます。

例えば、駅や商業施設で「どの時間帯にどの通路が混むか」を把握し、案内や動線設計を改善する用途では、個人名や顔を特定する必要はありません。こうした用途では、データを統計的に扱うことで公共利益を高めつつ、監視されている圧力を相対的に抑えることができます。

許容されにくい用途:社会的抵抗が大きい領域

本人同意のない顔認証・追跡

最も議論を呼びやすいのが、本人の明示的な同意なしに、顔認証技術を使って個人を特定・追跡する用途です。商業施設や街中で「誰がどこを歩いたか」を詳細に追えるようになると、行動履歴という極めてセンシティブな個人情報が大量に蓄積されます。

こうしたデータが、マーケティング・監視・捜査など複数の目的に横断的に使われると、本人が知らないうちに「常に見張られている」状態になり、表現や移動の自由を萎縮させかねません。顔認証は誤認も起こりうるため、誤った特定が不当な疑い・拘束などにつながるリスクも見逃せません。

感情推定や“怪しい行動”のスコア化

近年は、表情や動きから「怒っている」「不安そう」といった感情を推定したり、「怪しさ」をスコア化する研究・製品も登場しています。しかし、感情の読み取りや「怪しい」という評価は、文化や状況による差が大きく、誤判定や偏見を強化する危険性があります。

例えば、「一定時間立ち止まっている人」を一律に「不審」とみなすと、体調不良の人や、待ち合わせをしている人まで過度に疑うことになります。そこで付いたスコアが、採用・入店拒否・サービス利用制限などに使われれば、本人も理由を知れないまま差別的な扱いを受けるおそれがあります。

ブラックリスト照合と差別リスク

特定の人物をブラックリストとして登録し、検知したら即座にアラートを出す機能も、一部のAI防犯カメラには実装されています。これは、リピーターの万引き対策や出入り禁止者の管理には有効な一方で、登録基準や削除条件が不透明だと、半永久的な「デジタル烙印」となりかねません。

加えて、登録の判断に人の思い込みや偏見が入り込めば、特定の属性(外見・服装・国籍など)を持つ人だけが過剰にマークされる構造的差別の温床になります。誤登録や誤認識が起きても、本人が気づき訂正を求める手段がなければ、公正さは担保されません。

社会実装の課題とリスク

プライバシー侵害と透明性の欠如

AI防犯カメラは、映像そのものに加えて、行動パターンや位置情報など、きわめて詳細な個人データを生み出します。そのデータがどのくらい保存され、どの範囲で共有され、他のデータと組み合わされるのかが明確でない場合、プライバシー侵害の懸念は強まります。

また、どのようなアルゴリズムで「不審」や「危険」を判断しているかがブラックボックスになっていると、自分がどう評価されたのか、誤りがあった場合にどう訂正できるのかがわからなくなります。透明性のなさは、技術への不信と、「監視される側のまま」という無力感を生みます。

データ管理と監視社会化

データ保存期間や目的外利用のルールが曖昧なままだと、当初の防犯目的から、マーケティング・労務管理・信用評価など、想定外の用途に広がっていく危険があります。一度蓄積された映像や行動履歴は、コストさえ払えばいつでも解析可能なため、「後から別の目的で使われる」リスクは構造的に存在します。

公共空間や職場、店舗など、生活のあらゆる場でAIカメラが常設されると、「いつ・どこで・誰と・どのくらいの時間いたのか」が、組織側にほぼ完全に把握される状態に近づきます。これが監視社会化への懸念の核心であり、導入主体(自治体・企業)がどのようなルールで運用するかが、今後の信頼を左右します。

どこまで許されるのか ― 線引きの考え方

目的の正当性と手段の妥当性

線引きを考えるうえで重要なのは、「何のために使うのか」という目的と、「そのためにどこまで情報を扱ってよいのか」という手段のバランスです。命や重大な安全に関わる場面(災害・重大犯罪の防止など)では、多少強い監視が社会的に受容されるケースがありますが、それでも乱用防止の枠組みは不可欠です。

一方、単に利便性向上やマーケティングのために、詳細な顔認証・行動履歴の追跡まで行うことは、目的に対して手段が過剰ではないかが問われます。「同じ目的なら、よりプライバシー負荷の少ない手段を選べないか」という視点が、技術選択の基本になります。

個人識別しない設計とデータの自動削除

線引きを実務に落とし込むポイントとして、次のような設計思想が重要になります。

- 個人識別を極力行わない:必要がない限り、顔認証や個人特定につながる情報を扱わず、匿名加工や統計処理で目的を達成する設計にする。

- データの自動削除:一定期間を過ぎた映像やログは、自動的・不可逆的に削除し、「とりあえず残しておく」ことを避ける。

- 目的限定の原則:収集時に示した目的以外にはデータを使わない、目的変更時にはあらためて説明と合意形成を行う。

※(図:許容/非許容領域のマップ)

横軸に「個人特定の強さ」、縦軸に「目的の公共性」を取り、右上(強い個人特定+低い公共性)ほど慎重・制限的に扱うべき、というイメージが有効です。

透明性のある運用と参加

最後に重要なのは、「いつ・どこで・どんな目的で・どのようにAI防犯カメラが使われているか」を、住民や利用者にわかりやすく開示することです。設置場所の表示、用途や保存期間の説明、問い合わせ窓口の整備など、基本的な情報提供だけでも、受け止め方は大きく変わります。

また、自治体や大規模施設では、導入時に住民や利用者の意見を取り入れる仕組みを持つことで、「決められる側」ではなく「一緒にルールを作る側」として関わってもらうことができます。AI防犯カメラが社会インフラに近い存在になっていくほど、このような参加型のガバナンスが、技術と自由のバランスを保つ鍵になっていきます。

まとめ:技術と自由の“境界線”を考える

AI防犯カメラは、防犯や安全確保の面で大きな効果を発揮しうる一方、その使い方次第で、プライバシー侵害や差別、監視社会化を加速させる危険も抱えています。「どこまで許されるのか」という問いに、単純な正解はありませんが、目的の正当性と手段の妥当性、個人識別を抑えた設計、データの自動削除と目的限定、そして透明性の高い運用という視点が、冷静な線引きの出発点になります。

読者一人ひとりが、「自分ならどの用途まで受け入れられるか」「そのためにどんな条件(ルール・説明・参加)が必要か」を考えることが、AIと共にある社会のルールづくりそのものにつながっていきます。

【テーマ】

近年急速に普及している「AI防犯カメラ」を題材に、

**AI技術が社会にもたらす利点とリスクを整理し、

“どこまで許されるのか” の線引きを冷静に考察する記事**を書いてください。

【目的】

– AI防犯カメラの技術・仕組み・活用場面をわかりやすく伝える

– 利便性だけでなく、プライバシー・監視社会・差別リスクを公平に論じる

– 読者に「AIと社会の境界をどう考えるべきか」という視点を提供する

【読者像】

– 一般社会人、学生、行政・企業の情報管理担当者

– 防犯カメラのAI化をニュースで聞いたことがあるが詳しくは知らない層

– AIの社会実装・倫理・プライバシー問題に関心がある人

【記事構成】

1. **導入(問題提起)**

– AI防犯カメラの普及が急速に進んでいる背景

– なぜ今これが議論になるのか(犯罪対策・人手不足・技術進化)

– 「どこまで許されるのか」という疑問が生まれていることを提示する

2. **AI防犯カメラの仕組みと現在できること**

– 人物検知・不審行動検知・ナンバープレート認識など

– 顔認証や属性推定(年齢・性別の推定など)の技術も紹介

– 映像解析AIの一般的な仕組みを一文で補足

※(図:AI映像解析の基本フロー)

3. **許容されやすい用途(社会的合意が得られやすい領域)**

– 犯罪の未然防止

– 転倒検知・火災検知など安全向上

– 混雑度の計測など個人特定を伴わない分析

– 公共利益が大きいことを明示

4. **許容されにくい用途(社会的抵抗が大きい領域)**

– 本人同意のない顔認証や追跡

– 感情推定や“怪しい行動”のスコア化

– ブラックリスト照合による差別リスク

– 誤認や偏見の強化につながる点を指摘

5. **社会実装の課題とリスク**

– プライバシー侵害の懸念

– アルゴリズムの透明性欠如

– データ保存期間・利用範囲の曖昧さ

– 監視社会化の問題

– 公共・企業で導入する際のルール整備の必要性

6. **どこまで許されるのか ― 線引きの考え方**

– “目的の正当性” と “手段の妥当性” のバランス

– 個人識別をしない設計の重要性

– データの自動削除や目的限定の原則

– 社会が合意できる“透明性のある運用”が鍵になる

※(図:許容/非許容領域のマップ)

7. **まとめ**

– AIは防犯に貢献し得るが、“使い方” がすべてを左右する

– 技術と自由のバランスをどう取るかを、読者にも考えてもらう形で締める

【文体・トーン】

– です・ます調

– 感情的になりすぎず、冷静で中立

– 専門用語には一文の補足を必ずつける

– 恐怖を煽らず、事実関係を丁寧に説明する

【出力形式】

– Markdown形式

– 小見出し(###)を多めに使用

– 文字数は **2000〜2500字** を目安

– 記事末尾に「タイトル案」を **3つ** 提示する

【補足指示】

– 技術構成図や概念説明が有効な箇所では、

※(図:AI防犯カメラの判断プロセス)

のようにコメントを入れてよい(実際の画像は不要)。

【バージョン情報の出力】

記事本文とタイトル案のあとに必ず以下の形式で追記してください。

(不明な項目は「不明」と記載)

—

**AIバージョン情報**

– ベンダー:

– モデル名:

– モデルバージョン:

– 回答日時:

—

【参考タイトル】

「AI防犯カメラはどこまで許されるのか ― 技術と自由の“境界線”を考える」

***

## 導入:なぜ今、AI防犯カメラなのか

防犯カメラ自体は以前からありましたが、映像を人が目視で確認するだけでは、犯罪の未然防止やリアルタイム対応には限界がありました。 そこで登場したのが、カメラ映像をその場で解析し、異常やリスクを自動で検知するAI防犯カメラです。[2][3][1]

少子高齢化による警備・監視要員の不足、治安不安や重大事件への対策、そして映像解析AIの性能向上が、この技術の普及を一気に後押ししています。 しかし、利便性が高まるほど、「常時監視される社会」への不安や、誤認・差別につながるリスクも増大し、「どこまで使ってよいのか」をあらためて考える必要が出てきています。[4][6][8][2]

***

## AI防犯カメラの仕組みと現在できること

### どんなことができるのか

AI防犯カメラは、撮影した映像をリアルタイムに解析し、人や車などの対象を自動で認識し、特定の条件を満たしたときに通知や記録を行う仕組みを持っています。[5][1]

– 人物検知:人だけを見分け、動物や影・樹木の揺れなどと区別して検知する機能です。[1][5]

– 不審行動検知:うろつき・徘徊・立ち入り禁止エリアへの侵入など、通常と異なる行動パターンを検知してアラートを出します。[3][5]

– ナンバープレート認識:自動車のナンバーを読み取り、入退場管理や特定車両の検知に活用できます。[2]

### 顔認証・属性推定・映像解析AIの基本

顔認証は、映像から顔の特徴量(目や鼻の位置関係などを数値化したもの)を抽出し、あらかじめ登録された顔データと照合して、誰であるかを推定する技術です。 属性推定は、年齢層・性別・服装などをAIが確率的に推定するもので、個人名までは特定せずに人の傾向を分類する用途で使われます。[3][5][1]

映像解析AIの一般的な仕組みは、「カメラ映像 → AIで特徴抽出 → 人物・物体・動きの分類 → 条件に合うか判定 → アラート・記録」といった流れで動作します。[1][3]

※(図:AI映像解析の基本フロー)

***

## 許容されやすい用途:社会的合意が得られやすい領域

### 安全性向上に直結する活用

多くの人が比較的受け入れやすいのは、「公共の安全を高める」という目的が明確で、かつ個人の監視よりも事故・犯罪の防止に主眼が置かれた用途です。[8][2]

– 犯罪の未然防止:夜間の侵入検知、不審者の徘徊検知、店舗での万引き抑止などは、防犯目的が明確で、従来からカメラが使われてきた延長線上にあります。[5][2]

– 転倒検知・火災検知:高齢者施設や工場などで、人の転倒や煙・炎を自動検知して迅速に通報する機能は、「命を守る」用途として受容されやすい領域です。[6][3]

### 個人特定を伴わない分析

混雑度の計測や人流解析のように、個々人を識別せず、人の「数」や「流れ」だけを扱う分析は、プライバシー侵害の度合いが比較的低いと考えられます。[8][2]

例えば、駅や商業施設で「どの時間帯にどの通路が混むか」を把握し、案内や動線設計を改善する用途では、個人名や顔を特定する必要はありません。 こうした用途では、データを統計的に扱うことで公共利益を高めつつ、監視されている圧力を相対的に抑えることができます。[4][6][2][8]

***

## 許容されにくい用途:社会的抵抗が大きい領域

### 本人同意のない顔認証・追跡

最も議論を呼びやすいのが、本人の明示的な同意なしに、顔認証技術を使って個人を特定・追跡する用途です。 商業施設や街中で「誰がどこを歩いたか」を詳細に追えるようになると、行動履歴という極めてセンシティブな個人情報が大量に蓄積されます。[6][2]

こうしたデータが、マーケティング・監視・捜査など複数の目的に横断的に使われると、本人が知らないうちに「常に見張られている」状態になり、表現や移動の自由を萎縮させかねません。 顔認証は誤認も起こりうるため、誤った特定が不当な疑い・拘束などにつながるリスクも見逃せません。[2][4][6]

### 感情推定や“怪しい行動”のスコア化

近年は、表情や動きから「怒っている」「不安そう」といった感情を推定したり、「怪しさ」をスコア化する研究・製品も登場しています。 しかし、感情の読み取りや「怪しい」という評価は、文化や状況による差が大きく、誤判定や偏見を強化する危険性があります。[7][4][2]

例えば、「一定時間立ち止まっている人」を一律に「不審」とみなすと、体調不良の人や、待ち合わせをしている人まで過度に疑うことになります。 そこで付いたスコアが、採用・入店拒否・サービス利用制限などに使われれば、本人も理由を知れないまま差別的な扱いを受けるおそれがあります。[3][5][6]

### ブラックリスト照合と差別リスク

特定の人物をブラックリストとして登録し、検知したら即座にアラートを出す機能も、一部のAI防犯カメラには実装されています。 これは、リピーターの万引き対策や出入り禁止者の管理には有効な一方で、登録基準や削除条件が不透明だと、半永久的な「デジタル烙印」となりかねません。[4][5][6]

加えて、登録の判断に人の思い込みや偏見が入り込めば、特定の属性(外見・服装・国籍など)を持つ人だけが過剰にマークされる構造的差別の温床になります。 誤登録や誤認識が起きても、本人が気づき訂正を求める手段がなければ、公正さは担保されません。[6][2][4]

***

## 社会実装の課題とリスク

### プライバシー侵害と透明性の欠如

AI防犯カメラは、映像そのものに加えて、行動パターンや位置情報など、きわめて詳細な個人データを生み出します。 そのデータがどのくらい保存され、どの範囲で共有され、他のデータと組み合わされるのかが明確でない場合、プライバシー侵害の懸念は強まります。[2][4][6]

また、どのようなアルゴリズムで「不審」や「危険」を判断しているかがブラックボックスになっていると、自分がどう評価されたのか、誤りがあった場合にどう訂正できるのかがわからなくなります。 透明性のなさは、技術への不信と、「監視される側のまま」という無力感を生みます。[4][6][2]

### データ管理と監視社会化

データ保存期間や目的外利用のルールが曖昧なままだと、当初の防犯目的から、マーケティング・労務管理・信用評価など、想定外の用途に広がっていく危険があります。 一度蓄積された映像や行動履歴は、コストさえ払えばいつでも解析可能なため、「後から別の目的で使われる」リスクは構造的に存在します。[6][2]

公共空間や職場、店舗など、生活のあらゆる場でAIカメラが常設されると、「いつ・どこで・誰と・どのくらいの時間いたのか」が、組織側にほぼ完全に把握される状態に近づきます。 これが監視社会化への懸念の核心であり、導入主体(自治体・企業)がどのようなルールで運用するかが、今後の信頼を左右します。[8][2][4]

***

## どこまで許されるのか ― 線引きの考え方

### 目的の正当性と手段の妥当性

線引きを考えるうえで重要なのは、「何のために使うのか」という目的と、「そのためにどこまで情報を扱ってよいのか」という手段のバランスです。 命や重大な安全に関わる場面(災害・重大犯罪の防止など)では、多少強い監視が社会的に受容されるケースがありますが、それでも乱用防止の枠組みは不可欠です。[2][6]

一方、単に利便性向上やマーケティングのために、詳細な顔認証・行動履歴の追跡まで行うことは、目的に対して手段が過剰ではないかが問われます。 「同じ目的なら、よりプライバシー負荷の少ない手段を選べないか」という視点が、技術選択の基本になります。[4][6][2]

### 個人識別しない設計とデータの自動削除

線引きを実務に落とし込むポイントとして、次のような設計思想が重要になります。

– 個人識別を極力行わない:必要がない限り、顔認証や個人特定につながる情報を扱わず、匿名加工や統計処理で目的を達成する設計にする。[6][2]

– データの自動削除:一定期間を過ぎた映像やログは、自動的・不可逆的に削除し、「とりあえず残しておく」ことを避ける。[2][6]

– 目的限定の原則:収集時に示した目的以外にはデータを使わない、目的変更時にはあらためて説明と合意形成を行う。[4][2]

※(図:許容/非許容領域のマップ)

横軸に「個人特定の強さ」、縦軸に「目的の公共性」を取り、右上(強い個人特定+低い公共性)ほど慎重・制限的に扱うべき、というイメージが有効です。

### 透明性のある運用と参加

最後に重要なのは、「いつ・どこで・どんな目的で・どのようにAI防犯カメラが使われているか」を、住民や利用者にわかりやすく開示することです。 設置場所の表示、用途や保存期間の説明、問い合わせ窓口の整備など、基本的な情報提供だけでも、受け止め方は大きく変わります。[8][2]

また、自治体や大規模施設では、導入時に住民や利用者の意見を取り入れる仕組みを持つことで、「決められる側」ではなく「一緒にルールを作る側」として関わってもらうことができます。 AI防犯カメラが社会インフラに近い存在になっていくほど、このような参加型のガバナンスが、技術と自由のバランスを保つ鍵になっていきます。[8][6][2]

***

## まとめ:技術と自由の“境界線”を考える

AI防犯カメラは、防犯や安全確保の面で大きな効果を発揮しうる一方、その使い方次第で、プライバシー侵害や差別、監視社会化を加速させる危険も抱えています。 「どこまで許されるのか」という問いに、単純な正解はありませんが、目的の正当性と手段の妥当性、個人識別を抑えた設計、データの自動削除と目的限定、そして透明性の高い運用という視点が、冷静な線引きの出発点になります。[6][2][4]

読者一人ひとりが、「自分ならどの用途まで受け入れられるか」「そのためにどんな条件(ルール・説明・参加)が必要か」を考えることが、AIと共にある社会のルールづくりそのものにつながっていきます。[8][2]

***

### タイトル案

1. AI防犯カメラはどこまで許されるのか――安全とプライバシーの境界を考える

2. 「見守り」と「監視」のあいだで揺れるAI防犯カメラ――技術と社会のルールづくり

3. 顔認証から人流解析まで:AI防犯カメラ時代に私たちが守りたいもの

***

**AIバージョン情報**

– ベンダー: 不明

– モデル名: 不明

– モデルバージョン: 不明

– 回答日時: 2025-12-02T16:25:00+09:00

[1](https://safie.jp/article/post_15453/)

[2](https://aismiley.co.jp/ai_news/examples-of-ai-introduced-in-the-crime-prevention-security-industry/)

[3](https://bouhancamera-navi.com/column/fu-point-kinou-ai-anzen/)

[4](https://n-sk.jp/blog/aicamera_merit-demerit)

[5](https://n-sk.jp/blog/aicamera-humandetection)

[6](https://www.grooove.co.jp/case_study_54/)

[7](https://www.sankei.com/article/20250621-6GDAJTCJQRKKFM3J6BIBZTTXRI/)

[8](https://policenet.jp/blog/0133)

[9](https://www.trinity4e.com/ai/ai-case-03.html)

[10](http://www.famicom-plaza.com/blog/2011/06/)

本サイトの編集方針については「編集方針・AI利用ポリシー」をご覧ください。