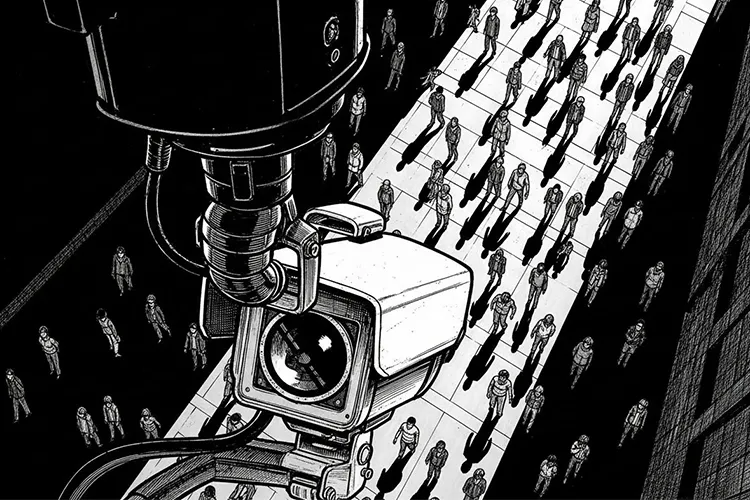

近年、街角や駅、商業施設、オフィスビルなどで、AIを搭載した防犯カメラの導入が急速に進んでいます。背景には、犯罪の未然防止や人手不足の解消、そしてAI技術の飛躍的な進化があります。特に、2020年代に入ってからは、ディープラーニングを活用した映像解析技術が実用化され、防犯カメラは単なる「記録装置」から「自動判断装置」へと進化を遂げました。

しかし、その一方で、「AI防犯カメラはどこまで許されるのか」という疑問が社会に広がっています。プライバシーの侵害、監視社会の到来、そしてAIによる差別のリスク――これらの懸念は、技術の進歩とともに深刻さを増しています。本記事では、AI防犯カメラの仕組みや活用場面をわかりやすく解説するとともに、その利点とリスクを整理し、社会がどのように「線引き」をすべきかを考察します。

AI防犯カメラの仕組みと現在できること

主な機能と技術

AI防犯カメラは、映像から特定の情報を抽出・解析する技術を搭載しています。主な機能は以下の通りです。

- 人物検知:映像内の人物を検出し、その位置や動きを追跡します。

- 不審行動検知:長時間の立ち止まりや、特定のエリアへの侵入など、事前に設定された「不審な行動」を検知します。

- ナンバープレート認識:車両のナンバープレートを読み取り、データベースと照合します。

- 顔認証:登録された顔データと照合し、個人を特定します。

- 属性推定:年齢や性別、服装などの属性を推定します。

これらの機能は、ディープラーニングと呼ばれるAI技術を用いて実現されています。ディープラーニングは、大量の映像データを学習させることで、特定のパターンや特徴を自動的に認識できるようになります。

※(図:AI映像解析の基本フロー)

映像解析AIの仕組み

映像解析AIは、カメラで撮影された映像をフレームごとに分析し、特定の物体や行動を検出します。例えば、人物検知では、映像内の人物の輪郭や動きをAIが認識し、不審行動検知では、その動きが「通常」と「異常」のどちらに該当するかを判断します。これらの判断は、事前に学習させたデータに基づいて行われます。

許容されやすい用途 ― 社会的合意が得られやすい領域

犯罪の未然防止

- 侵入者の検知:不法侵入や窃盗の防止に役立ちます。

- 暴力行為の検知:駅や商業施設での暴力行為を早期に発見し、警備員や警察に通報します。

安全向上

- 転倒検知:高齢者施設や駅のホームで、転倒事故を検知し、迅速な対応を可能にします。

- 火災検知:煙や炎を検知し、火災の早期発見に貢献します。

個人特定を伴わない分析

- 混雑度の計測:駅やイベント会場での混雑状況を分析し、安全な誘導に役立ちます。

- 交通量の分析:道路の交通量を分析し、渋滞緩和や交通安全に活用します。

これらの用途では、個人を特定せず、公共の安全や利便性を向上させる目的が明確であるため、社会的な合意が得られやすいと言えます。

許容されにくい用途 ― 社会的抵抗が大きい領域

本人同意のない顔認証や追跡

- 顔認証:本人の同意なしに顔データを収集し、個人を特定することは、プライバシーの侵害につながります。

- 追跡:特定の人物を長時間にわたり追跡することは、監視社会の到来を懸念させます。

感情推定や“怪しい行動”のスコア化

- 感情推定:AIが人物の表情から感情を推定し、それを基に行動を制限することは、誤認や偏見を生むリスクがあります。

- スコア化:「怪しい行動」をスコア化し、それに基づいて警備員や警察が対応することは、差別やプロファイリングを助長する可能性があります。

ブラックリスト照合による差別リスク

- ブラックリスト照合:特定の人物をブラックリストと照合し、入場を拒否することは、差別や社会的排除を引き起こす可能性があります。

- 誤認:AIの誤認により、無実の人物が不当に疑われるリスクもあります。

これらの用途では、個人の自由や権利が侵害される可能性が高く、社会的な抵抗が大きくなります。

社会実装の課題とリスク

プライバシー侵害の懸念

- 個人情報の収集:顔データや行動履歴などの個人情報が、本人の同意なしに収集・利用される可能性があります。

- データの悪用:収集されたデータが、第三者に漏洩したり、不正に利用されたりするリスクがあります。

アルゴリズムの透明性欠如

- ブラックボックス化:AIの判断基準が不明確であるため、なぜ特定の行動が「不審」と判断されたのかがわかりません。

- 偏見の強化:学習データに偏りがある場合、AIが特定の人種や性別に対して不当な判断を下す可能性があります。

データ保存期間・利用範囲の曖昧さ

- データの長期保存:映像データが長期間保存され、当初の目的以外に利用される可能性があります。

- 利用範囲の拡大:当初の目的を超えて、データが他の用途に流用されるリスクがあります。

監視社会化の問題

- 常時監視の不安:AI防犯カメラの普及により、常に監視されているという不安が社会に広がります。

- 自由の制限:監視が行き過ぎると、個人の自由や表現の自由が制限される可能性があります。

ルール整備の必要性

- 法的な枠組みの不足:AI防犯カメラの導入や運用に関する法的なルールが整備されていないため、濫用のリスクがあります。

- 企業・行政の責任:導入する企業や行政は、データの適切な管理と透明性のある運用が求められます。

どこまで許されるのか ― 線引きの考え方

「目的の正当性」と「手段の妥当性」のバランス

- 目的の正当性:防犯や安全向上など、公共の利益に資する目的であることが求められます。

- 手段の妥当性:目的を達成するための手段が、必要最小限であり、プライバシーや自由を過度に制限しないものであることが重要です。

個人識別をしない設計の重要性

- 匿名化:個人を特定しない形でデータを収集・分析することが望ましいです。

- 目的限定の原則:収集したデータは、当初の目的以外には利用しないことが求められます。

データの自動削除や透明性のある運用

- 自動削除:映像データは、一定期間を過ぎたら自動的に削除される仕組みが必要です。

- 透明性のある運用:AIの判断基準やデータの利用方法を公開し、社会の監視を受けることが重要です。

社会が合意できる「透明性のある運用」が鍵

- 社会的な合意形成:AI防犯カメラの導入や運用に関して、社会全体で議論し、合意を形成することが必要です。

- 継続的な見直し:技術の進歩や社会の変化に応じて、ルールや運用方法を見直し続けることが求められます。

※(図:許容/非許容領域のマップ)

まとめ:技術と自由のバランスを考える

AI防犯カメラは、犯罪の未然防止や安全向上に大きく貢献する可能性を秘めています。しかし、その一方で、プライバシーの侵害や監視社会の到来、差別のリスクといった課題も抱えています。AI技術の社会実装においては、「どこまで許されるのか」という線引きが重要です。

技術の進歩は止められませんが、その「使い方」を社会全体で議論し、透明性と公正さを確保することが求められています。読者の皆さんも、AIと社会の境界線について、一度立ち止まって考えてみてはいかがでしょうか。

【テーマ】

近年急速に普及している「AI防犯カメラ」を題材に、

**AI技術が社会にもたらす利点とリスクを整理し、

“どこまで許されるのか” の線引きを冷静に考察する記事**を書いてください。

【目的】

– AI防犯カメラの技術・仕組み・活用場面をわかりやすく伝える

– 利便性だけでなく、プライバシー・監視社会・差別リスクを公平に論じる

– 読者に「AIと社会の境界をどう考えるべきか」という視点を提供する

【読者像】

– 一般社会人、学生、行政・企業の情報管理担当者

– 防犯カメラのAI化をニュースで聞いたことがあるが詳しくは知らない層

– AIの社会実装・倫理・プライバシー問題に関心がある人

【記事構成】

1. **導入(問題提起)**

– AI防犯カメラの普及が急速に進んでいる背景

– なぜ今これが議論になるのか(犯罪対策・人手不足・技術進化)

– 「どこまで許されるのか」という疑問が生まれていることを提示する

2. **AI防犯カメラの仕組みと現在できること**

– 人物検知・不審行動検知・ナンバープレート認識など

– 顔認証や属性推定(年齢・性別の推定など)の技術も紹介

– 映像解析AIの一般的な仕組みを一文で補足

※(図:AI映像解析の基本フロー)

3. **許容されやすい用途(社会的合意が得られやすい領域)**

– 犯罪の未然防止

– 転倒検知・火災検知など安全向上

– 混雑度の計測など個人特定を伴わない分析

– 公共利益が大きいことを明示

4. **許容されにくい用途(社会的抵抗が大きい領域)**

– 本人同意のない顔認証や追跡

– 感情推定や“怪しい行動”のスコア化

– ブラックリスト照合による差別リスク

– 誤認や偏見の強化につながる点を指摘

5. **社会実装の課題とリスク**

– プライバシー侵害の懸念

– アルゴリズムの透明性欠如

– データ保存期間・利用範囲の曖昧さ

– 監視社会化の問題

– 公共・企業で導入する際のルール整備の必要性

6. **どこまで許されるのか ― 線引きの考え方**

– “目的の正当性” と “手段の妥当性” のバランス

– 個人識別をしない設計の重要性

– データの自動削除や目的限定の原則

– 社会が合意できる“透明性のある運用”が鍵になる

※(図:許容/非許容領域のマップ)

7. **まとめ**

– AIは防犯に貢献し得るが、“使い方” がすべてを左右する

– 技術と自由のバランスをどう取るかを、読者にも考えてもらう形で締める

【文体・トーン】

– です・ます調

– 感情的になりすぎず、冷静で中立

– 専門用語には一文の補足を必ずつける

– 恐怖を煽らず、事実関係を丁寧に説明する

【出力形式】

– Markdown形式

– 小見出し(###)を多めに使用

– 文字数は **2000〜2500字** を目安

– 記事末尾に「タイトル案」を **3つ** 提示する

【補足指示】

– 技術構成図や概念説明が有効な箇所では、

※(図:AI防犯カメラの判断プロセス)

のようにコメントを入れてよい(実際の画像は不要)。

【バージョン情報の出力】

記事本文とタイトル案のあとに必ず以下の形式で追記してください。

(不明な項目は「不明」と記載)

—

**AIバージョン情報**

– ベンダー:

– モデル名:

– モデルバージョン:

– 回答日時:

—

【参考タイトル】

「AI防犯カメラはどこまで許されるのか ― 技術と自由の“境界線”を考える」

—

## 1. 導入:AI防犯カメラが問いかける「どこまで許されるのか」

近年、街角や駅、商業施設、オフィスビルなどで、AIを搭載した防犯カメラの導入が急速に進んでいます。背景には、犯罪の未然防止や人手不足の解消、そしてAI技術の飛躍的な進化があります。特に、2020年代に入ってからは、ディープラーニングを活用した映像解析技術が実用化され、防犯カメラは単なる「記録装置」から「自動判断装置」へと進化を遂げました。

しかし、その一方で、「AI防犯カメラはどこまで許されるのか」という疑問が社会に広がっています。プライバシーの侵害、監視社会の到来、そしてAIによる差別のリスク――これらの懸念は、技術の進歩とともに深刻さを増しています。本記事では、AI防犯カメラの仕組みや活用場面をわかりやすく解説するとともに、その利点とリスクを整理し、社会がどのように「線引き」をすべきかを考察します。

—

## 2. AI防犯カメラの仕組みと現在できること

### 2-1. 主な機能と技術

AI防犯カメラは、映像から特定の情報を抽出・解析する技術を搭載しています。主な機能は以下の通りです。

– **人物検知**:映像内の人物を検出し、その位置や動きを追跡します。

– **不審行動検知**:長時間の立ち止まりや、特定のエリアへの侵入など、事前に設定された「不審な行動」を検知します。

– **ナンバープレート認識**:車両のナンバープレートを読み取り、データベースと照合します。

– **顔認証**:登録された顔データと照合し、個人を特定します。

– **属性推定**:年齢や性別、服装などの属性を推定します。

これらの機能は、**ディープラーニング**と呼ばれるAI技術を用いて実現されています。ディープラーニングは、大量の映像データを学習させることで、特定のパターンや特徴を自動的に認識できるようになります。

※(図:AI映像解析の基本フロー)

### 2-2. 映像解析AIの仕組み

映像解析AIは、カメラで撮影された映像をフレームごとに分析し、特定の物体や行動を検出します。例えば、人物検知では、映像内の人物の輪郭や動きをAIが認識し、不審行動検知では、その動きが「通常」と「異常」のどちらに該当するかを判断します。これらの判断は、事前に学習させたデータに基づいて行われます。

—

## 3. 許容されやすい用途 ― 社会的合意が得られやすい領域

AI防犯カメラの導入が社会的に受け入れられやすいのは、以下のような「公共の利益」が明確な場面です。

### 3-1. 犯罪の未然防止

– **侵入者の検知**:不法侵入や窃盗の防止に役立ちます。

– **暴力行為の検知**:駅や商業施設での暴力行為を早期に発見し、警備員や警察に通報します。

### 3-2. 安全向上

– **転倒検知**:高齢者施設や駅のホームで、転倒事故を検知し、迅速な対応を可能にします。

– **火災検知**:煙や炎を検知し、火災の早期発見に貢献します。

### 3-3. 個人特定を伴わない分析

– **混雑度の計測**:駅やイベント会場での混雑状況を分析し、安全な誘導に役立ちます。

– **交通量の分析**:道路の交通量を分析し、渋滞緩和や交通安全に活用します。

これらの用途では、個人を特定せず、公共の安全や利便性を向上させる目的が明確であるため、社会的な合意が得られやすいと言えます。

—

## 4. 許容されにくい用途 ― 社会的抵抗が大きい領域

一方で、AI防犯カメラの導入に対する抵抗感が強いのは、以下のような用途です。

### 4-1. 本人同意のない顔認証や追跡

– **顔認証**:本人の同意なしに顔データを収集し、個人を特定することは、プライバシーの侵害につながります。

– **追跡**:特定の人物を長時間にわたり追跡することは、監視社会の到来を懸念させます。

### 4-2. 感情推定や“怪しい行動”のスコア化

– **感情推定**:AIが人物の表情から感情を推定し、それを基に行動を制限することは、誤認や偏見を生むリスクがあります。

– **スコア化**:「怪しい行動」をスコア化し、それに基づいて警備員や警察が対応することは、差別やプロファイリングを助長する可能性があります。

### 4-3. ブラックリスト照合による差別リスク

– **ブラックリスト照合**:特定の人物をブラックリストと照合し、入場を拒否することは、差別や社会的排除を引き起こす可能性があります。

– **誤認**:AIの誤認により、無実の人物が不当に疑われるリスクもあります。

これらの用途では、個人の自由や権利が侵害される可能性が高く、社会的な抵抗が大きくなります。

—

## 5. 社会実装の課題とリスク

AI防犯カメラの社会実装には、以下のような課題とリスクが伴います。

### 5-1. プライバシー侵害の懸念

– **個人情報の収集**:顔データや行動履歴などの個人情報が、本人の同意なしに収集・利用される可能性があります。

– **データの悪用**:収集されたデータが、第三者に漏洩したり、不正に利用されたりするリスクがあります。

### 5-2. アルゴリズムの透明性欠如

– **ブラックボックス化**:AIの判断基準が不明確であるため、なぜ特定の行動が「不審」と判断されたのかがわかりません。

– **偏見の強化**:学習データに偏りがある場合、AIが特定の人種や性別に対して不当な判断を下す可能性があります。

### 5-3. データ保存期間・利用範囲の曖昧さ

– **データの長期保存**:映像データが長期間保存され、当初の目的以外に利用される可能性があります。

– **利用範囲の拡大**:当初の目的を超えて、データが他の用途に流用されるリスクがあります。

### 5-4. 監視社会化の問題

– **常時監視の不安**:AI防犯カメラの普及により、常に監視されているという不安が社会に広がります。

– **自由の制限**:監視が行き過ぎると、個人の自由や表現の自由が制限される可能性があります。

### 5-5. ルール整備の必要性

– **法的な枠組みの不足**:AI防犯カメラの導入や運用に関する法的なルールが整備されていないため、濫用のリスクがあります。

– **企業・行政の責任**:導入する企業や行政は、データの適切な管理と透明性のある運用が求められます。

—

## 6. どこまで許されるのか ― 線引きの考え方

AI防犯カメラの導入をめぐる「どこまで許されるのか」という問いに対する答えは、「目的の正当性」と「手段の妥当性」のバランスにあります。

### 6-1. 「目的の正当性」と「手段の妥当性」のバランス

– **目的の正当性**:防犯や安全向上など、公共の利益に資する目的であることが求められます。

– **手段の妥当性**:目的を達成するための手段が、必要最小限であり、プライバシーや自由を過度に制限しないものであることが重要です。

### 6-2. 個人識別をしない設計の重要性

– **匿名化**:個人を特定しない形でデータを収集・分析することが望ましいです。

– **目的限定の原則**:収集したデータは、当初の目的以外には利用しないことが求められます。

### 6-3. データの自動削除や透明性のある運用

– **自動削除**:映像データは、一定期間を過ぎたら自動的に削除される仕組みが必要です。

– **透明性のある運用**:AIの判断基準やデータの利用方法を公開し、社会の監視を受けることが重要です。

### 6-4. 社会が合意できる「透明性のある運用」が鍵

– **社会的な合意形成**:AI防犯カメラの導入や運用に関して、社会全体で議論し、合意を形成することが必要です。

– **継続的な見直し**:技術の進歩や社会の変化に応じて、ルールや運用方法を見直し続けることが求められます。

※(図:許容/非許容領域のマップ)

—

## 7. まとめ:技術と自由のバランスを考える

AI防犯カメラは、犯罪の未然防止や安全向上に大きく貢献する可能性を秘めています。しかし、その一方で、プライバシーの侵害や監視社会の到来、差別のリスクといった課題も抱えています。AI技術の社会実装においては、「どこまで許されるのか」という線引きが重要です。

技術の進歩は止められませんが、その「使い方」を社会全体で議論し、透明性と公正さを確保することが求められています。読者の皆さんも、AIと社会の境界線について、一度立ち止まって考えてみてはいかがでしょうか。

—

## タイトル案

1. 「AI防犯カメラはどこまで許されるのか ― 技術と自由の“境界線”を考える」

2. 「AI防犯カメラの光と影 ― 社会が直面する「監視」と「安全」のジレンマ」

3. 「AI防犯カメラの普及が問いかけるもの ― プライバシーと安全のバランスを探る」

—

**AIバージョン情報**

– ベンダー: Mistral AI

– モデル名: Le Chat

– モデルバージョン: 不明

– 回答日時: 2025年12月3日

本サイトの編集方針については「編集方針・AI利用ポリシー」をご覧ください。