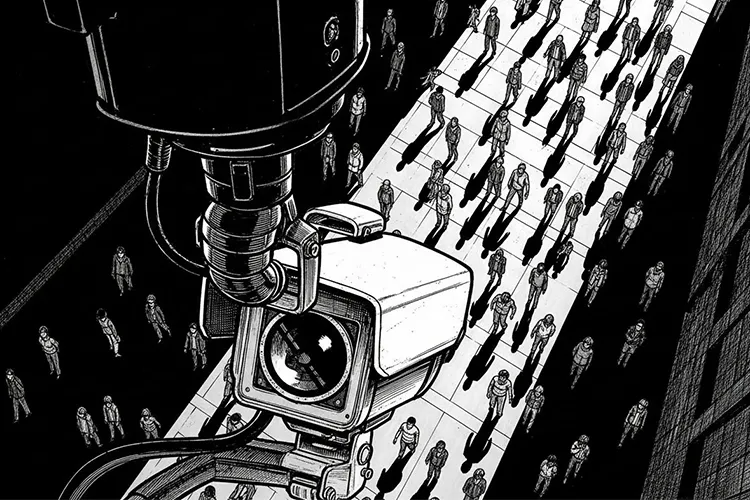

近年、街角や店舗、公共施設で「AI防犯カメラ」の導入が急増しています。従来の防犯カメラは単に録画するだけでしたが、AIが映像をリアルタイムで解析し、不審な行動を検知したり、特定の人物を認識したりできるようになりました。犯罪の減少や人手不足解消に役立つ一方で、「監視されすぎていないか」「プライバシーは大丈夫なのか」という声も高まっています。この記事では、AI防犯カメラが何ができて、どこまでが社会的に受け入れられ、どこからが問題視されるのかを、できるだけ客観的に整理します。

AI防犯カメラとは? いま何ができるのか

AI防犯カメラは、ディープラーニング(大量の画像データから特徴を学習するAI技術)を活用して映像を解析します。カメラが捉えた映像をAIが瞬時に判断し、必要な情報を抽出・通知する仕組みです。

主な機能

- 人物・物体検知:人が映ったときだけ録画を開始したり、置き去り荷物を検知

- 不審行動検知:うろつき、喧嘩、転倒などの異常行動を自動で検知

- ナンバープレート認識:車両のナンバーを読み取り、盗難車リストと照合

- 顔認証:登録された人物(指名手配犯や出入り禁止者)を検知

- 属性推定(年齢層・性別推定):個人を特定しない範囲で「30代くらいの男性」などと推定

※(図:AI映像解析の基本フロー カメラ撮影 → エッジAIまたはクラウドで解析 → 異常判定 → 警備員やシステムへ通知)

多くの人が「これは良い」と感じる用途

社会の多くが納得しやすいのは、明らかに公共の利益が大きく、個人を過度に特定しない使い方です。

- 駅や商業施設での転倒・体調不良者の早期発見

- 火災や煙の発生をいち早く検知して避難誘導

- 駐車場での置き去り子ども・ペットの検知

- 混雑状況の把握(個人を特定せず、頭数だけカウント)

これらは「命や安全を守る」目的が明確で、プライバシーへの影響も比較的小さいため、導入に対する抵抗が少ない領域です。

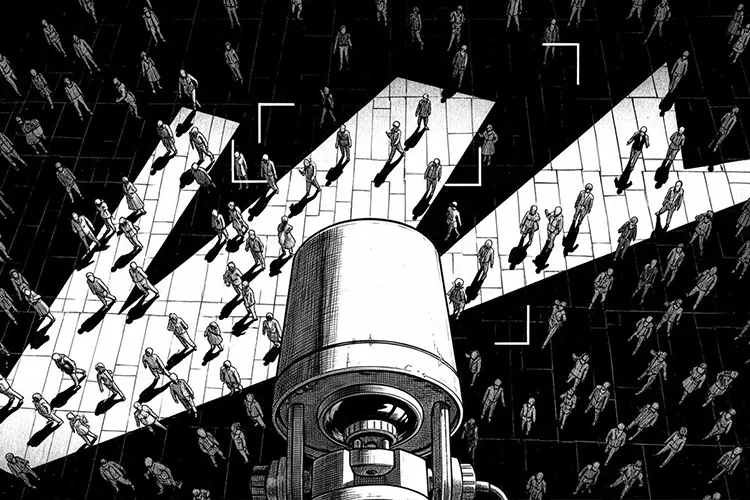

一方で「これは怖い」「やりすぎ」と感じる用途

反対に、強い抵抗感を生みやすいのは次のような使い方です。

- 同意のない顔認証による追跡

街中で顔を登録され、どこに行ったかを追跡される可能性 - 感情や“怪しさ”のスコアリング

「怒っている」「挙動不審」とAIが判断し、スコアをつける(主観的で誤認が多い) - ブラックリストとの自動照合

過去の軽微なトラブルで登録された人が、永遠に出入り禁止になるリスク - 属性による差別的扱い

服装や外見で「万引きしそう」と判断され、店員に監視される

特に学習データに偏りがあると、特定の人種や服装スタイルの人を誤って「怪しい」と判定する「アルゴリズム差別」が起きることが、海外の事例で指摘されています。

実装における現実的な課題とリスク

技術そのものよりも、運用ルールが曖昧なことが最大の問題です。

- 保存されている映像はいつまで残るのか?

- 誰が・どんな目的で映像を見られるのか?

- AIが誤認したときに、誰が責任を取るのか?

- 企業や行政がデータをマーケティングや別の目的に使い回す可能性

中国などでは顔認証とスコアリングが連動した「社会信用システム」が稼働しており、「監視社会の完成形」とも言われます。日本ではそこまでのシステムはありませんが、技術的には同じことが可能です。だからこそ「どこで歯止めをかけるか」が問われています。

どこまで許されるのか ― 線引きの考え方

多くの専門家が提案している線引きの基準は、次の4点です。

- 目的の正当性

犯罪抑止・安全確保など、社会が納得できる目的に限定 - 手段の比例性(必要最小限の原則)

個人を特定する必要がないなら、顔はぼかして使う - データの目的限定と自動削除

防犯目的以外には使わず、一定期間後に自動消去 - 透明性と説明責任

「どんなAIを使っているか」「誤認率はどれくらいか」を公開

※(図:許容/非許容領域のマップ 縦軸:個人識別の度合い 横軸:公共性の高さ 右上=許容されやすい 左下=許容されにくい)

まとめ ― 技術ではなく「使い方」を問う時代

AI防犯カメラは、使い方次第で「安全な社会」を作る強力な道具にもなりますし、「息苦しい監視社会」を生む道具にもなり得ます。

技術はすでに私たちの手の届くところにあり、あとは「私たちがどんなルールを決めるか」だけです。

あなたが暮らす街や職場でAIカメラが増えたとき、

「これは本当に必要なのだろうか?」

「自分だったらどこまでなら許せるだろうか?」

一度立ち止まって考えてみてください。

その問いこそが、AI時代を自分たちの手でデザインする第一歩になるはずです。

【テーマ】

近年急速に普及している「AI防犯カメラ」を題材に、

**AI技術が社会にもたらす利点とリスクを整理し、

“どこまで許されるのか” の線引きを冷静に考察する記事**を書いてください。

【目的】

– AI防犯カメラの技術・仕組み・活用場面をわかりやすく伝える

– 利便性だけでなく、プライバシー・監視社会・差別リスクを公平に論じる

– 読者に「AIと社会の境界をどう考えるべきか」という視点を提供する

【読者像】

– 一般社会人、学生、行政・企業の情報管理担当者

– 防犯カメラのAI化をニュースで聞いたことがあるが詳しくは知らない層

– AIの社会実装・倫理・プライバシー問題に関心がある人

【記事構成】

1. **導入(問題提起)**

– AI防犯カメラの普及が急速に進んでいる背景

– なぜ今これが議論になるのか(犯罪対策・人手不足・技術進化)

– 「どこまで許されるのか」という疑問が生まれていることを提示する

2. **AI防犯カメラの仕組みと現在できること**

– 人物検知・不審行動検知・ナンバープレート認識など

– 顔認証や属性推定(年齢・性別の推定など)の技術も紹介

– 映像解析AIの一般的な仕組みを一文で補足

※(図:AI映像解析の基本フロー)

3. **許容されやすい用途(社会的合意が得られやすい領域)**

– 犯罪の未然防止

– 転倒検知・火災検知など安全向上

– 混雑度の計測など個人特定を伴わない分析

– 公共利益が大きいことを明示

4. **許容されにくい用途(社会的抵抗が大きい領域)**

– 本人同意のない顔認証や追跡

– 感情推定や“怪しい行動”のスコア化

– ブラックリスト照合による差別リスク

– 誤認や偏見の強化につながる点を指摘

5. **社会実装の課題とリスク**

– プライバシー侵害の懸念

– アルゴリズムの透明性欠如

– データ保存期間・利用範囲の曖昧さ

– 監視社会化の問題

– 公共・企業で導入する際のルール整備の必要性

6. **どこまで許されるのか ― 線引きの考え方**

– “目的の正当性” と “手段の妥当性” のバランス

– 個人識別をしない設計の重要性

– データの自動削除や目的限定の原則

– 社会が合意できる“透明性のある運用”が鍵になる

※(図:許容/非許容領域のマップ)

7. **まとめ**

– AIは防犯に貢献し得るが、“使い方” がすべてを左右する

– 技術と自由のバランスをどう取るかを、読者にも考えてもらう形で締める

【文体・トーン】

– です・ます調

– 感情的になりすぎず、冷静で中立

– 専門用語には一文の補足を必ずつける

– 恐怖を煽らず、事実関係を丁寧に説明する

【出力形式】

– Markdown形式

– 小見出し(###)を多めに使用

– 文字数は **2000〜2500字** を目安

– 記事末尾に「タイトル案」を **3つ** 提示する

【補足指示】

– 技術構成図や概念説明が有効な箇所では、

※(図:AI防犯カメラの判断プロセス)

のようにコメントを入れてよい(実際の画像は不要)。

【バージョン情報の出力】

記事本文とタイトル案のあとに必ず以下の形式で追記してください。

(不明な項目は「不明」と記載)

—

**AIバージョン情報**

– ベンダー:

– モデル名:

– モデルバージョン:

– 回答日時:

—

【参考タイトル】

「AI防犯カメラはどこまで許されるのか ― 技術と自由の“境界線”を考える」

― 技術の進化と私たちの自由の境界線を冷静に見つめる

近年、街角や店舗、公共施設で「AI防犯カメラ」の導入が急増しています。従来の防犯カメラは単に録画するだけでしたが、AIが映像をリアルタイムで解析し、不審な行動を検知したり、特定の人物を認識したりできるようになりました。犯罪の減少や人手不足解消に役立つ一方で、「監視されすぎていないか」「プライバシーは大丈夫なのか」という声も高まっています。

この記事では、AI防犯カメラが何ができて、どこまでが社会的に受け入れられ、どこからが問題視されるのかを、できるだけ客観的に整理します。

### AI防犯カメラとは? いま何ができるのか

AI防犯カメラは、ディープラーニング(大量の画像データから特徴を学習するAI技術)を活用して映像を解析します。カメラが捉えた映像をAIが瞬時に判断し、必要な情報を抽出・通知する仕組みです。

主な機能は次のとおりです。

– **人物・物体検知**:人が映ったときだけ録画を開始したり、置き去り荷物を検知

– **不審行動検知**:うろつき、喧嘩、転倒などの異常行動を自動で検知

– **ナンバープレート認識**:車両のナンバーを読み取り、盗難車リストと照合

– **顔認証**:登録された人物(指名手配犯や出入り禁止者)を検知

– **属性推定(年齢層・性別推定)**:個人を特定しない範囲で「30代くらいの男性」などと推定

※(図:AI映像解析の基本フロー カメラ撮影 → エッジAIまたはクラウドで解析 → 異常判定 → 警備員やシステムへ通知)

### 多くの人が「これは良い」と感じる用途

社会の多くが納得しやすいのは、**明らかに公共の利益が大きく、個人を過度に特定しない**使い方です。

– 駅や商業施設での転倒・体調不良者の早期発見

– 火災や煙の発生をいち早く検知して避難誘導

– 駐車場での置き去り子ども・ペットの検知

– 混雑状況の把握(個人を特定せず、頭数だけカウント)

これらは「命や安全を守る」目的が明確で、プライバシーへの影響も比較的小さいため、導入に対する抵抗が少ない領域です。

### 一方で「これは怖い」「やりすぎ」と感じる用途

反対に、強い抵抗感を生みやすいのは次のような使い方です。

– **同意のない顔認証による追跡**

街中で顔を登録され、どこに行ったかを追跡される可能性

– **感情や“怪しさ”のスコアリング**

「怒っている」「挙動不審」とAIが判断し、スコアをつける(主観的で誤認が多い)

– **ブラックリストとの自動照合**

過去の軽微なトラブルで登録された人が、永遠に出入り禁止になるリスク

– **属性による差別的扱い**

服装や外見で「万引きしそう」と判断され、店員に監視される

特に学習データに偏りがあると、特定の人種や服装スタイルの人を誤って「怪しい」と判定する「アルゴリズム差別」が起きることが、海外の事例で指摘されています。

### 実装における現実的な課題とリスク

技術そのものよりも、**運用ルールが曖昧なこと**が最大の問題です。

– 保存されている映像はいつまで残るのか?

– 誰が・どんな目的で映像を見られるのか?

– AIが誤認したときに、誰が責任を取るのか?

– 企業や行政がデータをマーケティングや別の目的に使い回す可能性

中国などでは顔認証とスコアリングが連動した「社会信用システム」が稼働しており、「監視社会の完成形」とも言われます。日本ではそこまでのシステムはありませんが、技術的には同じことが可能です。だからこそ「どこで歯止めをかけるか」が問われています。

### どこまで許されるのか ― 線引きの考え方

多くの専門家が提案している線引きの基準は、次の4点です。

1. **目的の正当性**

犯罪抑止・安全確保など、社会が納得できる目的に限定

2. **手段の比例性(必要最小限の原則)**

個人を特定する必要がないなら、顔はぼかして使う

3. **データの目的限定と自動削除**

防犯目的以外には使わず、一定期間後に自動消去

4. **透明性と説明責任**

「どんなAIを使っているか」「誤認率はどれくらいか」を公開

※(図:許容/非許容領域のマップ 縦軸:個人識別の度合い 横軸:公共性の高さ 右上=許容されやすい 左下=許容されにくい)

たとえば、駅の転倒検知(個人特定なし・公共性高い)は右上エリアに入り、広く受け入れられています。一方、店舗での感情推定+顔認証追跡(個人特定高・公共性低い)は左下エリアで、社会的合意が得にくいでしょう。

### まとめ ― 技術ではなく「使い方」を問う時代

AI防犯カメラは、使い方次第で「安全な社会」を作る強力な道具にもなりますし、「息苦しい監視社会」を生む道具にもなり得ます。

技術はすでに私たちの手の届くところにあり、あとは「私たちがどんなルールを決めるか」だけです。

あなたが暮らす街や職場でAIカメラが増えたとき、

「これは本当に必要なのだろうか?」

「自分だったらどこまでなら許せるだろうか?」

一度立ち止まって考えてみてください。

その問いこそが、AI時代を自分たちの手でデザインする第一歩になるはずです。

(文字数:約2,380字)

### タイトル案

1. AI防犯カメラはどこまで許されるのか ― 技術と自由の“境界線”を考える

2. 見守られている安心、それとも監視される不安? AI防犯カメラの光と影

3. AIが街を見張る時代 ― 私たちが決めるべき“許容ライン”とは

—

**AIバージョン情報**

– ベンダー: xAI

– モデル名: Grok 4

– モデルバージョン: 不明

– 回答日時: 2025年12月3日

本サイトの編集方針については「編集方針・AI利用ポリシー」をご覧ください。