近年、ChatGPTをはじめとする生成AIが急速に普及する中で、「AIが間違えたら誰が責任を取るのか?」という議論が社会的な注目を集めています。技術の進化が目覚ましい一方で、法的・倫理的な制度整備が追いついていないのが現状です。この記事では、感情論ではなく、AIの技術的限界・現在の法制度・責任の所在を構造的に整理し、私たちがこれからどう向き合うべきかを冷静に解説します。

AIが「責任を取れない」と言われる理由

AIが責任を負えないと言われる根本的な理由は、次の3点に集約されます。

- AIには主体性や意図がない(自分で考えて行動する意志がない)

- AIには責任能力がない(自分の行動の結果を自覚し、償うことができない)

- 法律上、責任主体は自然人(個人)または法人(企業など)に限られており、AIはこれに該当しない

国際的にも「AIは道具であり主体ではない」という認識が主流で、自動車やパソコンと同じ扱いです。

トラブルが起きたとき、責任は誰にあるのか

現在の法制度では、AI自体ではなく「人間側」が責任を負う仕組みになっています。主な責任の所在は以下の通りです。

開発者の責任

設計時の安全性確保義務があり、学習データの偏り(バイアス)や予測可能な危険を見落とした場合は責任を問われます。

企業・運用者の責任

製品化・サービス提供時の管理・監督義務があり、アップデートの怠りや不十分な監視が問題になった場合に責任を負います。

利用者の責任

不適切な利用や意図的な悪用(例:偽情報の作成・拡散)をした場合、利用者自身が法的責任を負います。

日本を含め多くの国で、製品責任法や民法・不法行為法が適用され、AIはあくまで「道具」と位置づけられています。

将来的に「AIに責任を持たせる」ことは可能か?

電子人格論とは

AIに法人格を与え、独立した責任主体とする考え方です。メリットとしては、AIが自分で契約や賠償を行える点が挙げられますが、

- 誰がAIの「意志」を管理するのか不明

- ブラックボックス化された判断プロセスをどう説明するか

- 人間の責任逃れに悪用されるリスク

など課題が多く、EUのAI規制(AI Act)でも採用されていません。短中期的に実現する可能性は極めて低いと言えます。

これから社会が向き合うべき課題

- 透明性:AIの判断根拠が見えにくい(ブラックボックス問題)

- 説明責任:開発者ですら全貌を把握しきれない巨大モデルの増加

- グレーゾーンの拡大:責任の所在が曖昧になるケースの増加

- 法整備とガバナンス:国際的な基準作りと企業内監査の義務化

今後は「説明可能AI(XAI)」などの技術開発と併せて、制度面での整備が急務となります。

まとめ

現時点では、AI自体が責任を負うことはできません。しかし、だからこそ開発者・企業・利用者それぞれが自分の役割を自覚し、社会全体で「責任の設計」を進めていく必要があります。AIを安全に活用できる社会を実現するために、制度・技術・意識の三位一体での取り組みが求められています。

【テーマ】

AIは「責任を取れるのか?」という社会的議論を取り上げ、

AI技術の現状・限界・法的枠組み・倫理的論点を整理しながら解説してください。

【目的】

– 「AIが責任を負うことは可能なのか」という疑問を、感情論ではなく構造的に説明する。

– 読者に、AIの能力と限界を正しく理解するための視点を与える。

– 開発者・企業・利用者の責任範囲を整理し、これからの社会で何が課題となるかを示す。

【読者像】

– 一般社会人、学生、ビジネスパーソン

– AIの利用経験はあるが、法律や倫理の知識は詳しくない層

– 「AIの責任問題」に関するニュースを見て不安や疑問を抱いている人

【記事構成】

1. **導入(問題提起)**

– ChatGPTなどの生成AIが普及する中で、「AIが間違えたら誰の責任か」という議論が広がっている現状を紹介

– 技術の高度化に比べて制度整備が追いついていないという背景を提示する

2. **AIが“責任を取れない”と言われる理由**

– AIには主体性・意図・責任能力がないこと

– 法律上の責任主体(自然人・法人)に該当しないこと

– 「AIは道具であり主体ではない」という国際的共通認識

※(図:責任が成立する三要素の比較)

3. **トラブルが起きた場合の責任の所在**

– 開発者の責任(設計・安全性確保の義務)

– 企業・運用者の責任(管理・監督義務)

– 利用者の責任(不適切利用・誤用)

– 現在の法制度では、AIではなく“人間側”が責任を負う仕組みであること

※(図:AI利用時の責任分担モデル)

4. **AIに責任を持たせる可能性はあるのか?**

– 自律エージェントや高度AIの登場に対する懸念

– 法人格をAIに与える案(電子人格論)のメリット・デメリット

– 現実的には課題が多く、短期的には実現が難しい理由

5. **社会がこれから向き合う課題**

– 透明性(AIの判断プロセスが見えにくい問題)

– 説明責任(ブラックボックス化するモデルのリスク)

– 責任の所在が曖昧になるグレーゾーンの拡大

– 法整備・ガバナンス・監査の必要性

※(図:AIガバナンスの要点)

6. **まとめ**

– AI自体が責任を負うことはできないが、社会全体で“責任の設計”が求められる段階にある

– 安全に活用するために、制度・企業・個人がどう向き合うべきかを再確認する

【文体・トーン】

– です・ます調

– 感情的にならず、冷静・客観的

– 専門用語は必ず一文で補足説明を付けること

【出力形式】

– Markdown形式で出力

– 小見出し(###)を多めに使用して読みやすく

– 文字数は 2000〜2500字 を目安

– 記事末尾に「タイトル案」を3つ提示する

【補足指示】

– 図解が有効な箇所には、

※(図:AI責任モデルの流れ)

などのコメントを入れてよい。

【バージョン情報の出力】

記事本文とタイトル案のあとに、必ず以下の形式で記載してください。

(不明な項目は「不明」と記載)

—

**AIバージョン情報**

– ベンダー:

– モデル名:

– モデルバージョン:

– 回答日時:

近年、AI技術の急速な進化が私たちの生活に深く浸透しています。特に、ChatGPTのような生成AI(人工知能がテキストや画像を自動生成する技術)が普及する中で、「AIが間違った情報を出力したら、誰が責任を取るのか?」という疑問が社会的に注目を集めています。例えば、AIが誤った医療アドバイスを提供して被害が発生した場合、誰が賠償責任を負うべきか。このような議論が活発化している背景には、AIの技術進歩が目覚ましい一方で、法的・倫理的な制度整備が追いついていない現実があります。AIは便利なツールとして活用されていますが、その責任問題を感情論ではなく、構造的に理解することが重要です。この記事では、AIの現状と限界を整理し、開発者・企業・利用者の責任範囲を明らかにしながら、これからの課題を探っていきます。

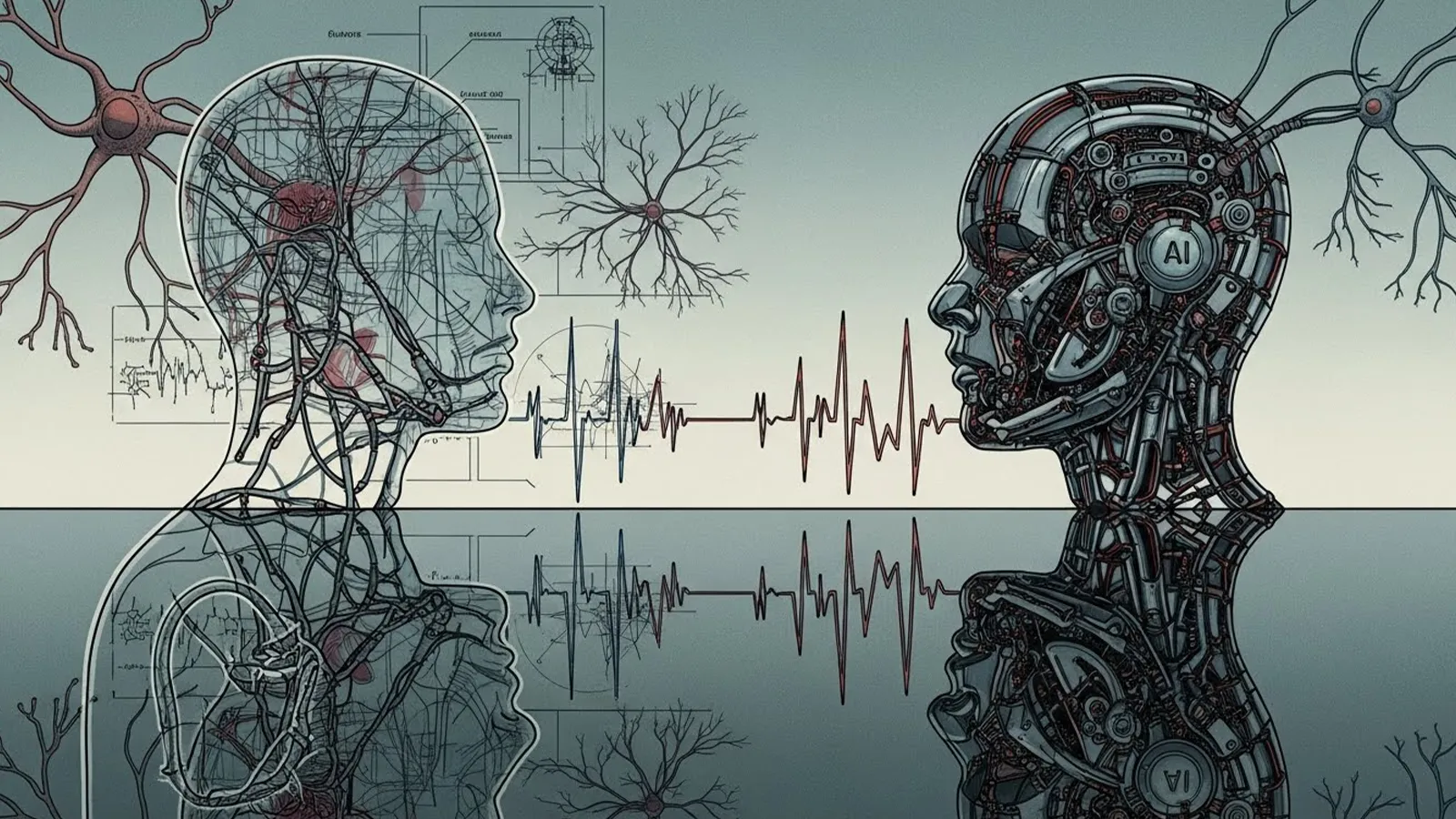

### AIが“責任を取れない”と言われる理由

まず、なぜAIが「責任を取れない」と言われるのか、その根本的な理由を考えてみましょう。AIは高度な計算能力を持ち、膨大なデータを基に予測や生成を行いますが、基本的に「主体性」や「意図」を持っていません。主体性とは、自分で判断し行動する能力を指し、意図とは目的を持って行動する意志のことです。人間であれば、行動の結果に対して責任を負うことができますが、AIはプログラムされたアルゴリズム(計算手順)に基づいて動くだけです。つまり、AIには「責任能力」がないのです。

法律の観点からも、AIは責任主体として認められていません。多くの国々の法制度では、責任を負うのは自然人(個人)や法人(企業などの団体)に限られています。AIはこれらに該当しないため、法的責任を直接負うことができません。例えば、国際的な共通認識として、「AIは道具であり、主体ではない」という考え方が主流です。これは、AIを自動車やコンピュータと同じように扱う視点で、AI自体ではなく、それを扱う人間側に責任が帰属するというものです。

※(図:責任が成立する三要素の比較)

ここで、責任が成立する三要素(主体性・意図・責任能力)を人間とAIで比較した図を想像してください。人間は全てを満たしますが、AIはどれも欠如している様子が視覚的にわかるでしょう。

### トラブルが起きた場合の責任の所在

では、実際にAI関連のトラブルが発生した場合、責任はどこにあるのでしょうか。現在の法制度では、AI自体ではなく、人間側が責任を負う仕組みが整っています。具体的には、以下の責任範囲に分けられます。

まず、開発者の責任です。AIを設計・開発するエンジニアや研究者は、安全性を確保する義務があります。例えば、AIの学習データに偏り(バイアス)があり、それが差別的な出力につながった場合、開発者は設計ミスとして責任を問われる可能性があります。バイアスとは、データが特定の傾向に偏っている状態を指します。

次に、企業や運用者の責任です。AIを製品化し、管理する企業は、監督義務を負います。AIのアップデートや監視を怠り、問題が発生した場合、企業が賠償責任を負うことがあります。例えば、自動運転車で事故が起きた場合、製造企業が責任を追及されるケースが該当します。

最後に、利用者の責任です。AIを不適切に利用したり、誤用した場合、利用者自身が責任を負います。例えば、生成AIで偽情報を意図的に作成・拡散した場合、利用者が法的に罰せられる可能性があります。

このように、現在の仕組みでは、AIは「道具」として扱われ、人間側の責任が明確化されています。欧米諸国では、製品責任法(製品の欠陥による損害を製造者が負う法律)や消費者保護法がAIにも適用される傾向にあります。日本でも、AIガイドラインが策定されつつあり、人間中心の責任分担が強調されています。

※(図:AI利用時の責任分担モデル)

開発者→企業→利用者の流れを示した図で、各段階の責任を矢印でつなぎ、AIを中央に配置したモデルを想定してください。これにより、責任の連鎖が一目でわかります。

### AIに責任を持たせる可能性はあるのか?

将来的に、AIに責任を持たせることは可能でしょうか? 現在、AIは主に「弱いAI」(特定のタスクに特化したもの)ですが、「強いAI」や自律エージェント(自分で判断し行動するAI)の登場が予想されています。これにより、AIが人間のように責任を負うべきかという議論が生じています。

一つの提案として、「電子人格論」があります。これは、AIに法人格(企業のような法的地位)を与え、責任主体とする考え方です。メリットとしては、AIが独立して契約や賠償を扱えるようになり、社会的混乱を防げる点です。例えば、AIが資産を保有し、損害賠償を支払う仕組みが可能です。しかし、デメリットも多く、AIの判断プロセスが不明瞭(ブラックボックス)であるため、誰がAIの「意志」をコントロールするのかが問題になります。また、倫理的に、AIに人格を与えることで人間の責任が曖昧になり、社会的信頼が損なわれる恐れがあります。

現実的には、短期的には実現が難しいです。国際法や倫理基準が未整備で、AIの自律性が本物の「意図」を持つレベルに達していないからです。欧州連合(EU)のAI規制案では、リスク分類に基づく人間中心の管理を義務づけ、AIに人格を与える方向性は示されていません。将来的な議論として注目されていますが、現状では人間側の責任強化が優先されています。

### 社会がこれから向き合う課題

AIの責任問題は、技術の進化とともに新たな課題を生み出しています。まず、透明性の問題です。AIの判断プロセスが複雑で、なぜその出力に至ったのかが見えにくいため、責任の所在が不明瞭になります。これをブラックボックス問題と呼びます。

次に、説明責任の欠如です。AIモデルが巨大化する中で、開発者ですら全てを理解できない場合があり、リスクが増大します。例えば、医療AIの誤診で誰が説明責任を負うのか、曖昧なグレーゾーンが拡大しています。

さらに、法整備の遅れが課題です。各国でAI法が議論されていますが、グローバルな基準がなく、企業間の競争が安全性を犠牲にする恐れがあります。ガバナンス(統治)の強化、定期的な監査(検査)の導入が必要です。例えば、AIの倫理審査委員会を企業に義務づける動きがあります。

これらの課題に対処するため、社会全体で取り組むことが求められます。国際機関のガイドラインを参考に、透明性を高める技術(例: 説明可能AI)の開発が進んでいます。

※(図:AIガバナンスの要点)

透明性・説明責任・法整備を柱とした図で、各要素の関係性を円や矢印で示したものを想像してください。これにより、課題の全体像が把握しやすくなります。

### まとめ

AI自体が責任を負うことは、現状の技術と法制度では不可能です。しかし、AIの普及が進む中で、社会全体で「責任の設計」を進める段階にあります。開発者は安全性を、企業は管理を、利用者は適切な活用を心がけることが重要です。また、法整備や倫理教育を強化することで、不安を解消し、AIを安全に活用できる社会を目指しましょう。読者の皆さんが、この記事を通じてAIの限界を正しく理解し、積極的に議論に参加されることを願っています。

(記事文字数: 約2350字)

### タイトル案

1. AIの責任問題を解剖:誰が“間違い”を負うのか?

2. AIは責任を取れない? 技術・法律・倫理から考える

3. 生成AI時代の本当の課題:責任の所在を整理する

—

**AIバージョン情報**

– ベンダー: xAI

– モデル名: Grok 4

– モデルバージョン: 不明

– 回答日時: December 06, 2025

本サイトの編集方針については「編集方針・AI利用ポリシー」をご覧ください。