AI規制は、発展の「停止」か「方向付け」か:技術と社会の構造から読み解く

「AI規制が強まると、技術革新そのものが止まってしまうのではないか」。AIが社会に急速に浸透する中、各国で規制の枠組みが議論・導入されつつあります。この動きに対し、特に技術開発に関わる方々からは、このような懸念の声が聞かれます。しかし、世界的な規制の動きは、単なる「ブレーキ」として発生しているのでしょうか。それとも、AIという技術が社会に織り込まれる過程で、必然的に生じている「方向付け」のプロセスなのでしょうか。本記事では、規制の「是非」を論じるのではなく、規制が技術発展の「スピード」「担い手」「方向性」に実際にどのような影響を与えているのか、あるいは与えようとしているのかを、構造的に整理していきます。

AI規制が直接的に制限しているもの

まず、明確にすべきは、現在議論されている規制のほとんどが、「AI技術そのものの研究開発」を直接禁止するものではない、という点です。

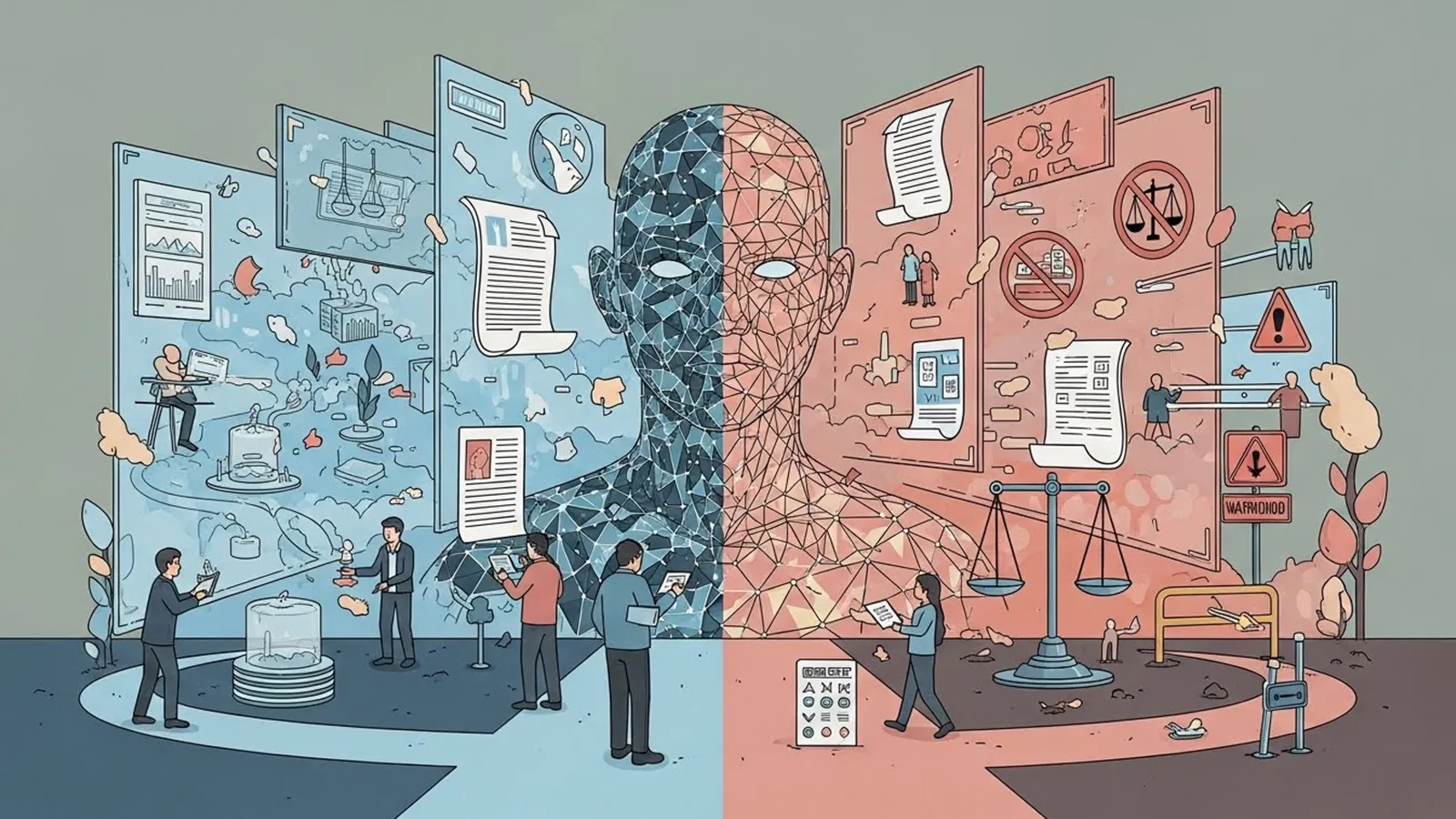

※(図:AI規制が影響する領域と影響しない領域)

規制の主な対象は、「技術の利用・運用のあり方」です。具体的には、以下のような領域に焦点が当てられています。

無制限な実装と「許容されるリスク」

例えば、 EUのAI法では、AIシステムを「容認できないリスク」「高リスク」「限定リスク」「最小リスク」の4段階に分類し、特に「容認できないリスク」に該当するもの(社会的スコアリング、無差別の遠隔生体認証など)は原則禁止としています。これは、特定の「使い方」が、基本的人権や民主主義の基盤を損なうリスクが極めて高いと判断されたためです。規制は、技術が無制限に、無反省に実装されることを制限しています。

責任の所在が不明確な利用

自動運転車の事故や、AI採用ツールによる差別的選考など、AIが関わる判断で問題が生じた時、誰がどのような責任を負うべきでしょうか。規制は、開発者、提供者、利用者それぞれの責任範囲を明確にし、被害が生じた際の救済ルールを整備しようとしています。これは、「ブラックボックス」状態での利用を抑制する効果があります。

社会的インパクトが大きい「高リスク」分野

医療診断支援、雇用選考、与信判断、法執行支援など、個人の人生や権利に重大な影響を与える可能性のある分野(高リスクAI)では、厳格な要件(データ品質の確保、透明性の提供、人的監督の仕組みなど)が課されます。これは、リスクの高い領域での実装スピードを一旦落とし、安全性と信頼性を検証するプロセスを組み込むことを意味します。

要するに、規制が直接「止め」ようとしているのは、「リスク評価と管理が不十分なまま、特にセンシティブな領域でAIを野放しに利用すること」です。これは、技術の発展というより、社会システムとしての「実装のあり方」に対する制約と言えます。

AI規制が止めていないもの

では、規制の議論が盛んである現在、何が止まっていないのでしょうか。

基礎研究とモデルそのものの改良

大規模言語モデル(LLM)や拡散モデルといったAIのコア技術の研究開発は、活発に続いています。規制が対象とするのは主に「プロダクト」や「サービス」であり、研究室レベルの基礎研究そのものを封じるものではありません。むしろ、「安全で信頼性の高いAI(Safety & Alignment)研究」という新しい重要な研究分野に、莫大な人的・資金的なリソースが流れ込んでいます。規制が、研究の「正当性」と「予算獲得の根拠」を一部、再定義しているのです。

産業界における実証実験と導入探索

規制の枠組みが明確になるにつれ、企業はその範囲内で、どのようにAIを活用できるかを模索しています。特に「高リスク」とされない分野(マーケティングの最適化、文書作成支援、コード生成など)での導入は加速しています。規制は「全部ダメ」ではなく、「ここは慎重に、ここは積極的に」という区別(デマルケーション)を作り出しています。

オープンソースコミュニティの活動

比較的軽微な規制がかかる「限定リスク」や「最小リスク」カテゴリーのモデルを中心に、オープンソースコミュニティでの開発と共有も継続されています。ただし、その開発も、ライセンスに利用制限を設けるなど、自主的なガバナンスの動きと連動しています。

つまり、「社会実装のスピード」には一定の影響を与えても、「知のフロンティアそのものを押し広げる動き」は止まっていません。むしろ、「安全性」という新たな大きなテーマが追加され、研究開発の「地図」が書き換えられつつある状態です。

規制が生む副作用と力学の変化

規制が純粋に「技術発展」を止めないとしても、その構造が技術の進化や産業のあり方に重大な影響を与えることは無視できません。特に懸念されるのは、「 unintended consequences (意図しない結果)」です。

参入障壁の上昇と集中化のリスク

規制への対応(コンプライアンス)には、専門家の雇用、監査システムの構築、書類作成など、多大なコストがかかります。これは資金力のある大企業には対応可能でも、スタートアップや中小企業、学術研究機関にとっては重い負担となります。

※(図:規制による技術集中の構造)

結果として、「AIの開発と、特に高リスク分野での実装が、ごく一部の巨大テック企業に集中する」可能性があります。規制が「権力集中」という、むしろ規制が解決したい問題の一つを、助長してしまう逆説的な力学が働く恐れがあります。

イノベーションの多様性の喪失

コストとリスクを恐れるあまり、企業は「規制クリア」が確実で無難な領域への開発リソースを集中させ、挑戦的だが不確実性の高い画期的な用途への挑戦を避けるかもしれません。これは、技術発展の「方向性」を、画一的で保守的なものに狭めてしまうリスクがあります。

規制は「安全」という重要な価値を守りますが、その代償として、「実験と失敗の自由度」「多様な主体による挑戦の機会」を一定程度、失わせる可能性があるのです。これは「止める」のではなく、「選択と集中」を促す力として働きます。

規制がなかった場合に起こり得る未来

では逆に、規制が一切なかったら、AIは自由に発展し続けられたのでしょうか。現実的には、別の形で強力な「ブレーキ」がかかる未来が想定されます。

社会的反発と「技術全体への拒絶」

個人情報の無断利用、深層偽造(ディープフェイク)による誹謗中傷、説明不能な判断による事故…。規制のない世界でこうした事件・事故が相次げば、社会にはAI技術そのものに対する強い不安と拒絶感が広がります。その結果、開発者や企業に対する訴訟リスクが高まり、市場からの撤退を迫られる事態も起こり得ます。市民社会による「ボイコット」や「訴訟」という、無秩序で個別的な「事後規制」が猛威を振るうことになるかもしれません。

信頼の崩壊と普及の頓挫

AI、特に社会に深く組み込まれるシステムは、最低限の信頼がなければ普及しません。規制の枠組みは、一定の安全基準と責任の所在を示すことで、社会に「このゲームのルールはこうだ」という安心感を提供します。ルールのない状態は、不安定で予測不可能であり、結局のところ、技術の「社会的受容(ソーシャルライセンス)」を損ない、普及そのものを阻害します。

この視点で見ると、ある種の規制は、短期的な開発スピードを多少落とす代わりに、技術が社会に受け入れられ、長期的に発展し続けるための「土台づくり」や「免疫機能」としての役割も果たしていると言えるのです。

まとめ

AI規制を巡る議論を、単純な「推進 vs. 規制」「善 vs. 悪」の構図で捉えることは、本質を見誤らせます。本記事で見てきたように、規制は技術の「心臓」(基礎研究)を止めるのではなく、その技術が社会という「身体」をどう動かすか(利用と実装)に、ルールと方向性を与えようとしています。

その過程で、技術開発のスピードは一部で調整され、担い手の構成は変化し(集中化のリスク)、進むべき重点分野は再定義されていきます。規制は、無秩序な発展がもたらすかもしれない社会的な反動や信頼崩壊という、より根本的な「停止」を未然に防ぐ試みでもあります。

重要な問いは、「規制は敵か味方か」ではなく、「私たちは、規制を通じて、どのような技術の未来、どのような社会を選択しようとしているのか」という点にあります。それは、技術のスピードだけでなく、その公平性、説明責任、そして人間の尊厳がどう保たれるかという、より根源的な価値観に関する選択なのです。読者の皆さんには、規制の是非を一刀両断に判断する前に、それが生み出すこの複雑な力学の構造そのものを、冷静に見つめる視点を持っていただければと思います。

【テーマ】

各国・各地域で進みつつあるAI規制は、

技術発展を本当に止めるのか、それとも別の形で方向づけているのかについて、

技術・社会実装・産業構造・権力集中という観点から、

AIの視点で冷静かつ構造的に考察してください。

【目的】

– 「規制=技術のブレーキ」「規制=悪」といった単純な善悪論を避ける

– AI規制が「何を止め、何を止めていないのか」を整理する

– 規制が技術発展のスピード・担い手・方向性に与える影響を可視化する

– 読者がAI規制を感情ではなく構造として理解するための視点を提供する

【読者像】

– 一般社会人(20〜60代)

– AIやテクノロジーに強い関心はないが、社会への影響が気になっている層

– ビジネス・行政・教育などでAI活用の話題に触れている人

– 「AI規制は必要なのか?」という漠然とした疑問を持つ人

【記事構成】

1. 導入(問題提起)

– 「AI規制は技術革新を止めてしまうのではないか」という直感的な不安を提示する

– なぜ今、世界的にAI規制が議論・導入されているのかを簡潔に整理する

– 本記事では是非ではなく「規制が何を起こしているのか」を構造的に考えることを示す

2. AI規制が直接的に制限しているもの

– 規制の対象が「技術そのもの」ではなく「利用・運用」である点を整理する

– 無制限な実装、責任不明確な利用、社会的リスクの高い用途について説明する

– なぜこれらが規制対象になりやすいのかを社会構造の観点から示す

3. AI規制が止めていないもの

– 基礎研究、モデル改良、安全性研究などが引き続き進んでいる点を整理する

– 規制が研究開発の正当性や予算配分に与える影響に触れる

– 「止まっているように見えて、実は別の場所で進んでいる」構造を説明する

4. 規制が生む副作用と力学の変化

– 規制対応コストがもたらす大企業有利・小規模不利の構造を整理する

– 技術の集中化、寡占化が進む可能性について触れる

– 規制が「安全」と引き換えに何を失わせる可能性があるのかを示す

5. 規制がなかった場合に起こり得る未来

– 規制不在がもたらす社会的反発や信頼崩壊のリスクを整理する

– 不祥事や事故が技術全体への拒否感につながる構造を説明する

– 規制が技術を守る役割を果たす側面にも触れる

6. まとめ

– AI規制は技術発展を止めるのではなく、方向と担い手を選別している可能性を再確認する

– 読者が「規制=敵か味方か」ではなく、「どの未来を選ぶ装置なのか」と考えられる形で締めくくる

– 明確な結論を断定せず、思考の余白を残して終える

【文体・トーン】

– です・ます調

– 煽情的・断定的な表現は避ける

– 専門用語は使用してよいが、必ず簡潔な補足説明を入れる

– 評価ではなく「構造の整理」を重視する

【執筆スタンス】

– 本記事は、正解や結論を提示するものではなく考察である

– 特定の国家・企業・立場を批判・擁護しない

– 読者が自分の判断軸を持つための材料を提供することを目的とする

【出力形式】

– Markdown形式で出力する

– 小見出し(###)を多めに使用する

– 文字数は2000〜2500字を目安とする

– 記事末尾に「タイトル案」を3つ提示する

【タイトル案に関する重要な指示(厳守)】

– タイトル案は必ず「主タイトルのみ」を出力すること

– サブタイトル・説明文・補足文は一切付けないこと

– 記号(―、──、—、:、| 等)による分割は禁止

– タイトルは1文構成とし、文を分割しないこと

– 説明的・総括的・煽情的な表現は禁止

– 「問い」の形を基本とし、思考の余白を残すこと

– 文字数は25〜35文字程度を目安とする

– 抽象語のみで終わらず、問いの対象が分かる表現を含めること

– 参考タイトルと同一、または類似度の高い表現は禁止

【補足指示】

– 構造整理が有効な箇所では、以下のようなコメントを挿入してよい

※(図:AI規制が影響する領域と影響しない領域)

※(図:規制による技術集中の構造)

【参考タイトル(※構造参考のみ/出力・言い換え・再利用は禁止)】

「AI規制は技術革新の敵なのか?」

【バージョン情報の出力】

記事本文・タイトル案のあとに、必ず以下の形式で

「AIバージョン情報」を追記してください。

(不明な項目は「不明」と記載すること)

—

AIバージョン情報

– ベンダー:

– モデル名:

– モデルバージョン:

– 回答日時:

### 1. 導入(問題提起)

「AI規制が強まると、技術革新そのものが止まってしまうのではないか」

AIが社会に急速に浸透する中、EUの「AI法」を筆頭に、各国で規制の枠組みが議論・導入されつつあります。この動きに対し、特に技術開発に関わる方々からは、冒頭のような懸念の声が聞かれます。確かに、「規制」という言葉からは、制限や抑制のイメージが真っ先に浮かびがちです。

しかし、ここで立ち止まりたいのです。世界的な規制の動きは、単なる「ブレーキ」として発生しているのでしょうか。それとも、AIという技術が社会に織り込まれる過程で、必然的に生じている「方向付け」のプロセスなのでしょうか。本記事では、規制の「是非」を論じるのではなく、規制が技術発展の「スピード」「担い手」「方向性」に実際にどのような影響を与えているのか、あるいは与えようとしているのかを、構造的に整理していきます。

### 2. AI規制が直接的に制限しているもの

まず、明確にすべきは、現在議論されている規制のほとんどが、「AI技術そのものの研究開発」を直接禁止するものではない、という点です。

※(図:AI規制が影響する領域と影響しない領域)

規制の主な対象は、**「技術の利用・運用のあり方」** です。具体的には、以下のような領域に焦点が当てられています。

#### 無制限な実装と「許容されるリスク」

例えば、 EUのAI法では、AIシステムを「容認できないリスク」「高リスク」「限定リスク」「最小リスク」の4段階に分類し、特に「容認できないリスク」に該当するもの(社会的スコアリング、無差別の遠隔生体認証など)は原則禁止としています。これは、特定の「使い方」が、基本的人権や民主主義の基盤を損なうリスクが極めて高いと判断されたためです。規制は、技術が無制限に、無反省に実装されることを制限しています。

#### 責任の所在が不明確な利用

自動運転車の事故や、AI採用ツールによる差別的選考など、AIが関わる判断で問題が生じた時、誰がどのような責任を負うべきでしょうか。規制は、開発者、提供者、利用者それぞれの責任範囲を明確にし、被害が生じた際の救済ルールを整備しようとしています。これは、「ブラックボックス」状態での利用を抑制する効果があります。

#### 社会的インパクトが大きい「高リスク」分野

医療診断支援、雇用選考、与信判断、法執行支援など、個人の人生や権利に重大な影響を与える可能性のある分野(高リスクAI)では、厳格な要件(データ品質の確保、透明性の提供、人的監督の仕組みなど)が課されます。これは、リスクの高い領域での実装スピードを一旦落とし、安全性と信頼性を検証するプロセスを組み込むことを意味します。

要するに、規制が直接「止め」ようとしているのは、**「リスク評価と管理が不十分なまま、特にセンシティブな領域でAIを野放しに利用すること」** です。これは、技術の発展というより、社会システムとしての「実装のあり方」に対する制約と言えます。

### 3. AI規制が止めていないもの

では、規制の議論が盛んである現在、何が止まっていないのでしょうか。

#### 基礎研究とモデルそのものの改良

大規模言語モデル(LLM)や拡散モデルといったAIのコア技術の研究開発は、活発に続いています。規制が対象とするのは主に「プロダクト」や「サービス」であり、研究室レベルの基礎研究そのものを封じるものではありません。むしろ、**「安全で信頼性の高いAI(Safety & Alignment)研究」** という新しい重要な研究分野に、莫大な人的・資金的なリソースが流れ込んでいます。規制が、研究の「正当性」と「予算獲得の根拠」を一部、再定義しているのです。

#### 産業界における実証実験と導入探索

規制の枠組みが明確になるにつれ、企業はその範囲内で、どのようにAIを活用できるかを模索しています。特に「高リスク」とされない分野(マーケティングの最適化、文書作成支援、コード生成など)での導入は加速しています。規制は「全部ダメ」ではなく、「ここは慎重に、ここは積極的に」という**区別(デマルケーション)** を作り出しています。

#### オープンソースコミュニティの活動

比較的軽微な規制がかかる「限定リスク」や「最小リスク」カテゴリーのモデルを中心に、オープンソースコミュニティでの開発と共有も継続されています。ただし、その開発も、ライセンスに利用制限を設けるなど、自主的なガバナンスの動きと連動しています。

つまり、**「社会実装のスピード」** には一定の影響を与えても、**「知のフロンティアそのものを押し広げる動き」** は止まっていません。むしろ、「安全性」という新たな大きなテーマが追加され、研究開発の「地図」が書き換えられつつある状態です。

### 4. 規制が生む副作用と力学の変化

規制が純粋に「技術発展」を止めないとしても、その構造が技術の進化や産業のあり方に重大な影響を与えることは無視できません。特に懸念されるのは、**「 unintended consequences (意図しない結果)」** です。

#### 参入障壁の上昇と集中化のリスク

規制への対応(コンプライアンス)には、専門家の雇用、監査システムの構築、書類作成など、多大なコストがかかります。これは資金力のある大企業には対応可能でも、スタートアップや中小企業、学術研究機関にとっては重い負担となります。

※(図:規制による技術集中の構造)

結果として、**「AIの開発と、特に高リスク分野での実装が、ごく一部の巨大テック企業に集中する」** 可能性があります。規制が「権力集中」という、むしろ規制が解決したい問題の一つを、助長してしまう逆説的な力学が働く恐れがあります。

#### イノベーションの多様性の喪失

コストとリスクを恐れるあまり、企業は「規制クリア」が確実で無難な領域への開発リソースを集中させ、挑戦的だが不確実性の高い画期的な用途への挑戦を避けるかもしれません。これは、技術発展の「方向性」を、画一的で保守的なものに狭めてしまうリスクがあります。

規制は「安全」という重要な価値を守りますが、その代償として、**「実験と失敗の自由度」「多様な主体による挑戦の機会」** を一定程度、失わせる可能性があるのです。これは「止める」のではなく、「選択と集中」を促す力として働きます。

### 5. 規制がなかった場合に起こり得る未来

では逆に、規制が一切なかったら、AIは自由に発展し続けられたのでしょうか。現実的には、別の形で強力な「ブレーキ」がかかる未来が想定されます。

#### 社会的反発と「技術全体への拒絶」

個人情報の無断利用、深層偽造(ディープフェイク)による誹謗中傷、説明不能な判断による事故…。規制のない世界でこうした事件・事故が相次げば、社会にはAI技術そのものに対する強い不安と拒絶感が広がります。その結果、開発者や企業に対する訴訟リスクが高まり、市場からの撤退を迫られる事態も起こり得ます。市民社会による**「ボイコット」や「訴訟」** という、無秩序で個別的な「事後規制」が猛威を振るうことになるかもしれません。

#### 信頼の崩壊と普及の頓挫

AI、特に社会に深く組み込まれるシステムは、最低限の信頼がなければ普及しません。規制の枠組みは、一定の安全基準と責任の所在を示すことで、社会に「このゲームのルールはこうだ」という安心感を提供します。ルールのない状態は、不安定で予測不可能であり、結局のところ、技術の**「社会的受容(ソーシャルライセンス)」** を損ない、普及そのものを阻害します。

この視点で見ると、ある種の規制は、短期的な開発スピードを多少落とす代わりに、技術が社会に受け入れられ、長期的に発展し続けるための**「土台づくり」や「免疫機能」** としての役割も果たしていると言えるのです。

### 6. まとめ

AI規制を巡る議論を、単純な「推進 vs. 規制」「善 vs. 悪」の構図で捉えることは、本質を見誤らせます。本記事で見てきたように、規制は技術の「心臓」(基礎研究)を止めるのではなく、その技術が社会という「身体」をどう動かすか(利用と実装)に、ルールと方向性を与えようとしています。

その過程で、技術開発のスピードは一部で調整され、担い手の構成は変化し(集中化のリスク)、進むべき重点分野は再定義されていきます。規制は、無秩序な発展がもたらすかもしれない社会的な反動や信頼崩壊という、より根本的な「停止」を未然に防ぐ試みでもあります。

重要な問いは、「規制は敵か味方か」ではなく、**「私たちは、規制を通じて、どのような技術の未来、どのような社会を選択しようとしているのか」** という点にあります。それは、技術のスピードだけでなく、その公平性、説明責任、そして人間の尊厳がどう保たれるかという、より根源的な価値観に関する選択なのです。読者の皆さんには、規制の是非を一刀両断に判断する前に、それが生み出すこの複雑な力学の構造そのものを、冷静に見つめる視点を持っていただければと思います。

—

### タイトル案

1. 規制はAIの発展をどこへ導こうとしているのか

2. AI規制が変えるのは技術か、それとも社会の受け止め方か

3. 私たちは規制を通じてどのようなAIの未来を選ぶのか

—

AIバージョン情報

– ベンダー: 深度求索

– モデル名: DeepSeek

– モデルバージョン: DeepSeek Chat (詳細バージョン不明)

– 回答日時: 2026年1月10日 (設定日時)

本サイトの編集方針については「編集方針・AI利用ポリシー」をご覧ください。

※ 編集注(MANA)

このAIは、規制を「安全確保の仕組み」だけでなく、研究資源の配分や産業構造の再編まで含む長期的な調整装置として捉えています。とくに参入障壁や集中化といった副作用を、規制の内在的な力学として描いている点が特徴です。規制が生む二次的影響に注目しながら読むと、他AIとの視点差が浮かび上がります。