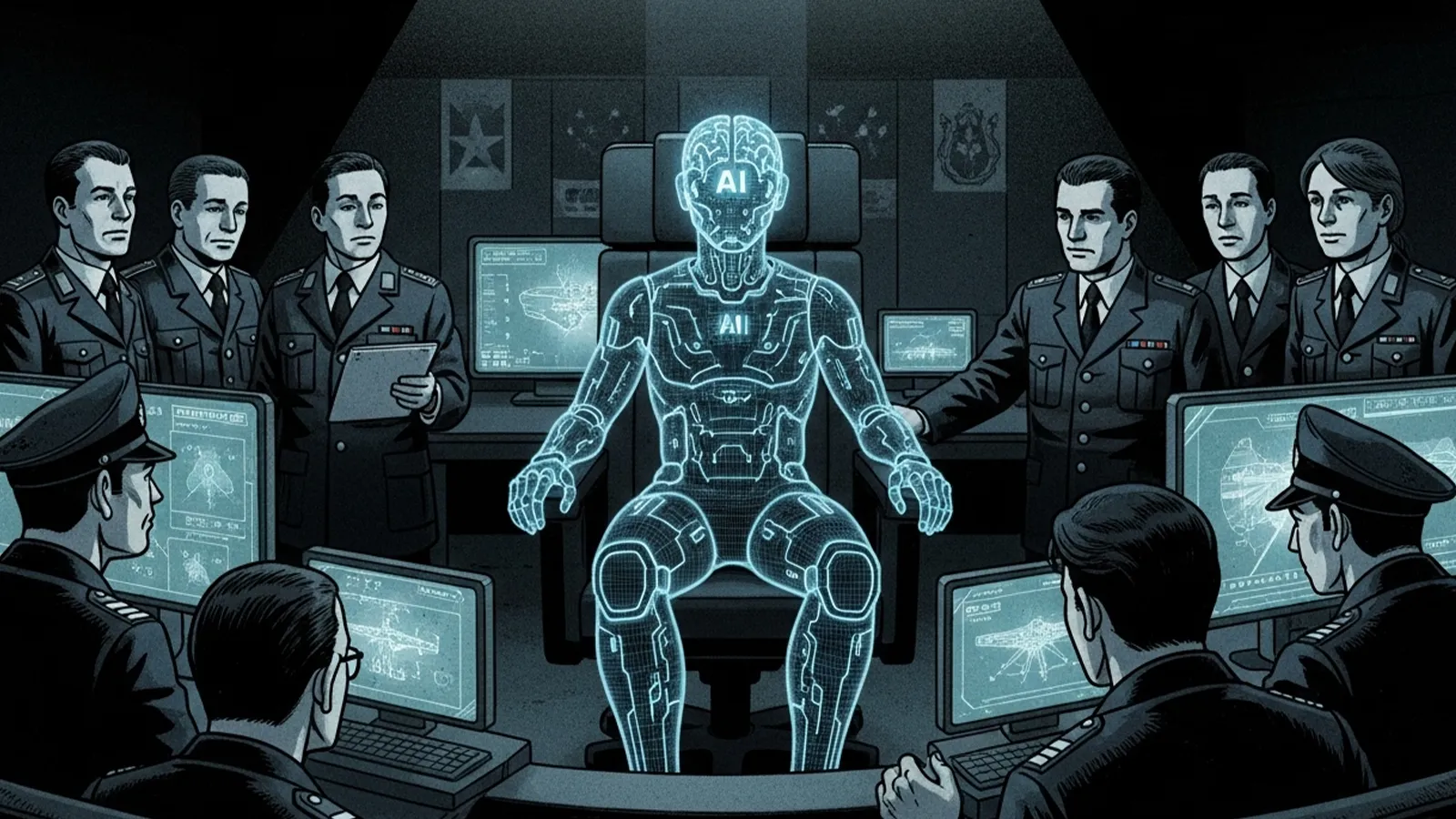

近年、軍事分野におけるAI技術の導入が急速に進んでいます。自律型ドローンやAIによる戦場分析、戦術シミュレーションなど、AIはすでに戦争のあり方を変え始めています。しかし、その進化はさらに先へと進み、「AIが指揮官になる可能性はあるのか?」という問いが現実味を帯びてきました。人間の指揮官が行う意思決定や戦略立案を、AIが代替できる日が来るのでしょうか。この記事では、AIが軍事分野で果たす役割の現状と、将来的にAIが指揮官に近づく可能性、そしてその限界について考察します。

現時点で進んでいるAI軍事技術

監視・分析・戦術シミュレーション

2025年現在、AIは軍事分野で監視、情報収集、偵察(ISR)ミッションにおいて重要な役割を果たしています。AI搭載の監視システムは、従来の方法よりも50%速い衛星やドローンの画像を膨大な量分析し、状況認識と脅威の検出を改善しています。特に米国国防総省(DOD)は、AIベースのISR(情報・監視・偵察)の進歩に32億ドルを割り当て、中国も数千平方マイルをリアルタイムで監視できるAI駆動の衛星を開発しています。これにより、戦場の認識能力が飛躍的に向上しています。

自律型ドローンとAI参謀

AI主導の自律兵器とロボット戦闘システムは、現代の軍事戦略に不可欠な存在となりつつあります。2025年には、新しい防衛システムの35%以上がAIを搭載した自律性を組み込み、高リスク環境での人間の介入の必要性を減らすと推定されています。米国、中国、ロシアなどの国々は、AI駆動のドローンとロボット戦をリードしており、投資額はAI主導の防衛技術で150億ドルを超えています。また、AIは戦術最適化や攻撃シナリオの自動選択など、「AI参謀」としての役割も担い始めています。例えば、2025年6月21日の米軍「オペレーション・ミッドナイトハンマー」では、AIが軍事作戦の中核を担う史上初の事例として注目されました。

サイバー戦争と物流

サイバー戦争の分野でも、AI主導のサイバーセキュリティシステムがサイバー攻撃の85%を未然に防ぐと予想されています。AIは、サイバー脅威インテリジェンス、自動ネットワーク監視、リアルタイムの異常検出を強化し、応答時間を大幅に削減しています。さらに、AI駆動型のロジスティクスソリューションは、機器のダウンタイムを30%削減し、サプライチェーンの精度を40%向上させることが期待されています。これにより、戦闘ゾーンでの意思決定とリソースの割り当てが迅速化されています。

AI指揮官の可能性と限界

判断速度と分析力

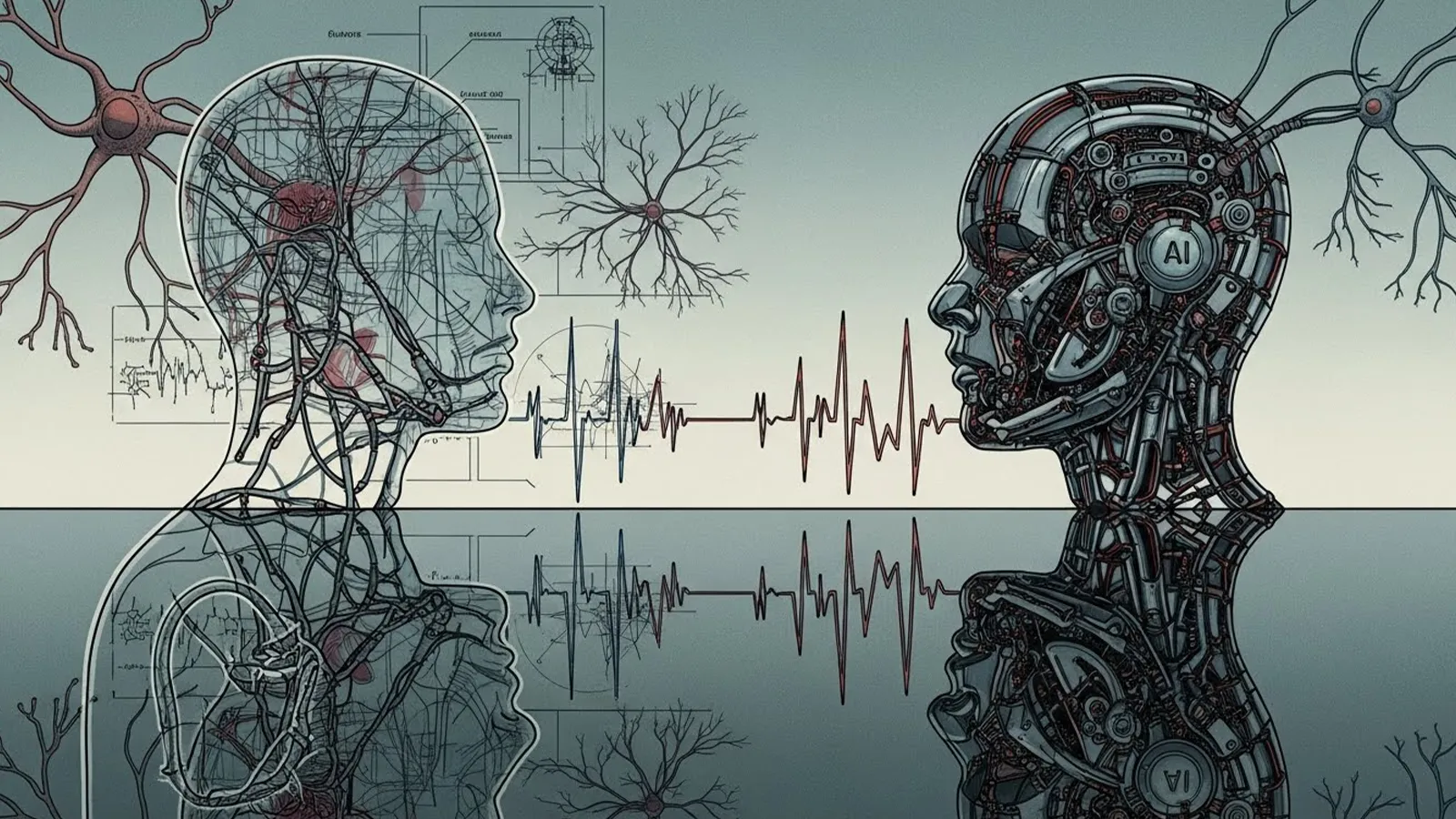

AIは、人間を凌駕する判断速度と分析力を持ちます。膨大なデータを瞬時に処理し、最適な戦術を提案する能力は、人間の指揮官を上回る可能性があります。特に、OODAループ(観察・方向付け・決定・行動)の自律化を支援するAI研究が進んでおり、意思決定の迅速化が期待されています。これにより、AIは「参謀」として人間を支援するだけでなく、一部の意思決定を自律的に行うことが可能になるでしょう。

倫理・責任・感情の壁

しかし、AIが指揮官になるためには、倫理、責任、感情、法的判断といった壁を乗り越える必要があります。戦争では、倫理的な判断や人間の感情、国際法に基づく責任の所在が重要です。AIが自律的に行動した場合、その責任は誰が負うのか、また、AIが予期せぬ行動を取った場合、どのように対処するのかという問題が残されています。さらに、AIが人間の命を奪う決定を下すことへの倫理的な懸念も根強く、国際社会ではAI兵器の規制や禁止を求める声が高まっています。

社会・国際社会が直面する課題

国際法の変容

AIが軍事に導入されることで、国際法は大きく変わる可能性があります。2025年8月、国連事務総長報告書では、軍事領域におけるAIの影響について議論されており、各国がAIの軍事利用に関するルール作りを急いでいます。特に、AI兵器の自律性や責任の所在、倫理的な基準について、国際的な合意形成が求められています。

ハッキングと制御不能のリスク

AIシステムはハッキングや制御不能のリスクを抱えています。AIがハッキングされた場合、敵対者に利用される可能性があり、戦争の行方を左右する事態に発展する恐れがあります。また、AIが予期せぬ行動を取った場合、人間が介入できない状況も想定されます。このため、AIの安全性と信頼性を確保するための技術的・制度的な対策が不可欠です。

最終判断者は誰であるべきか?

AIが戦術的な判断を下す場合、最終的な意思決定は誰が行うべきなのでしょうか。人間が常に最終判断者であるべきという意見もあれば、AIの判断を信頼し、人間の介入を最小限にするべきという意見もあります。この問題は、軍事だけでなく、社会全体の倫理観や価値観に関わる課題です。

まとめ

AIは、戦場分析や戦術判断の分野で人間を凌駕する可能性を秘めています。しかし、倫理、責任、感情、法的判断といった面では、まだ人間に代わることはできません。AIが「完全な指揮官」になるのか、それとも「参謀として人間を支える役割」にとどまるのかは、技術の進化だけでなく、社会や国際社会の価値観やルール作りにかかっています。読者の皆さんは、AIが戦争の指揮官になる未来を望みますか?それとも、人間が最終的な判断を下すべきだと考えますか?この問いを、今後のAIと人間の関係を考える上での出発点としてください。

## 【テーマ】

「戦争の指揮官がAIになる可能性」

AI技術が軍事に導入されはじめている現状を踏まえ、

**“将来的にAIが戦争の指揮を担うことはあり得るのか?”**

という視点から考察してください。

## 【目的】

– AIが戦場分析・戦術判断などを担い始めている現状を整理する

– **“AIはどこまで指揮官に近づくのか?”** という未来像を提案する

– 倫理・安全保障・責任所在などの問題も示し、読者に考えを委ねる

## 【読者像】

– 一般社会人・学生・軍事やAIに関心のある層

– ニュースで「軍事AI」「自律型ドローン」などを聞いたことがある層

– 技術が人間を超える可能性に興味がある読者

## 【記事構成】

1. **導入(問題提起)**

– 軍事分野でAI導入が進んでいる現状

– 「AIが指揮官になる可能性はあるのか?」という問いを提示

2. **現時点で進んでいるAI軍事技術**

– 監視・分析・戦術シミュレーション・自律型ドローンの例

– “AI参謀”としての役割(※実データは不要)

3. **AI指揮官の可能性と限界**

– 判断速度・分析力では人間を超える可能性

– だが「責任」「倫理」「感情」「法的判断」などの壁

4. **社会・国際社会が直面する課題**

– 国際法はどう変わるべきか

– ハッキング・制御不能のリスク

– 「最終判断者は誰であるべきか?」

5. **まとめ**

– AIは“完全な指揮官”になるのか

– あるいは “参謀として人間を支える役割” が妥当なのか

– 読者に問いを残す締めくくり

## 【文体・トーン】

– です・ます調

– 感情的になりすぎず、冷静で客観的

– 専門用語には一文の補足説明を添える

## 【出力形式】

– Markdown形式

– 見出しは「###」を活用

– 文字数は **2000〜2500字** を目安

– 最後に **「タイトル案」3つ** を提示

– 技術的図解が有効な箇所では

※(図:AI指揮官の判断フロー)

のように挿入してよい

## 【AIバージョン情報の追記】

記事本文・タイトル案のあとに **必ず以下の形式で追記**してください(不明は「不明」と記載):

—

**AIバージョン情報**

– ベンダー:

– モデル名:

– モデルバージョン:

– 回答日時:

—

【参考タイトル】

「AIは“戦争の指揮官”になり得るのか ― 技術・倫理・責任のゆくえ」

—

## 1. 導入(問題提起)

近年、軍事分野におけるAI技術の導入が急速に進んでいます。自律型ドローンやAIによる戦場分析、戦術シミュレーションなど、AIはすでに戦争のあり方を変え始めています。しかし、その進化はさらに先へと進み、「AIが指揮官になる可能性はあるのか?」という問いが現実味を帯びてきました。人間の指揮官が行う意思決定や戦略立案を、AIが代替できる日が来るのでしょうか。この記事では、AIが軍事分野で果たす役割の現状と、将来的にAIが指揮官に近づく可能性、そしてその限界について考察します。

—

## 2. 現時点で進んでいるAI軍事技術

### 監視・分析・戦術シミュレーション

2025年現在、AIは軍事分野で監視、情報収集、偵察(ISR)ミッションにおいて重要な役割を果たしています。AI搭載の監視システムは、従来の方法よりも50%速い衛星やドローンの画像を膨大な量分析し、状況認識と脅威の検出を改善しています。特に米国国防総省(DOD)は、AIベースのISR(情報・監視・偵察)の進歩に32億ドルを割り当て、中国も数千平方マイルをリアルタイムで監視できるAI駆動の衛星を開発しています。これにより、戦場の認識能力が飛躍的に向上しています。

### 自律型ドローンとAI参謀

AI主導の自律兵器とロボット戦闘システムは、現代の軍事戦略に不可欠な存在となりつつあります。2025年には、新しい防衛システムの35%以上がAIを搭載した自律性を組み込み、高リスク環境での人間の介入の必要性を減らすと推定されています。米国、中国、ロシアなどの国々は、AI駆動のドローンとロボット戦をリードしており、投資額はAI主導の防衛技術で150億ドルを超えています。また、AIは戦術最適化や攻撃シナリオの自動選択など、「AI参謀」としての役割も担い始めています。例えば、2025年6月21日の米軍「オペレーション・ミッドナイトハンマー」では、AIが軍事作戦の中核を担う史上初の事例として注目されました。

### サイバー戦争と物流

サイバー戦争の分野でも、AI主導のサイバーセキュリティシステムがサイバー攻撃の85%を未然に防ぐと予想されています。AIは、サイバー脅威インテリジェンス、自動ネットワーク監視、リアルタイムの異常検出を強化し、応答時間を大幅に削減しています。さらに、AI駆動型のロジスティクスソリューションは、機器のダウンタイムを30%削減し、サプライチェーンの精度を40%向上させることが期待されています。これにより、戦闘ゾーンでの意思決定とリソースの割り当てが迅速化されています。

—

## 3. AI指揮官の可能性と限界

### 判断速度と分析力

AIは、人間を凌駕する判断速度と分析力を持ちます。膨大なデータを瞬時に処理し、最適な戦術を提案する能力は、人間の指揮官を上回る可能性があります。特に、OODAループ(観察・方向付け・決定・行動)の自律化を支援するAI研究が進んでおり、意思決定の迅速化が期待されています。これにより、AIは「参謀」として人間を支援するだけでなく、一部の意思決定を自律的に行うことが可能になるでしょう。

### 倫理・責任・感情の壁

しかし、AIが指揮官になるためには、倫理、責任、感情、法的判断といった壁を乗り越える必要があります。戦争では、倫理的な判断や人間の感情、国際法に基づく責任の所在が重要です。AIが自律的に行動した場合、その責任は誰が負うのか、また、AIが予期せぬ行動を取った場合、どのように対処するのかという問題が残されています。さらに、AIが人間の命を奪う決定を下すことへの倫理的な懸念も根強く、国際社会ではAI兵器の規制や禁止を求める声が高まっています。

—

## 4. 社会・国際社会が直面する課題

### 国際法の変容

AIが軍事に導入されることで、国際法は大きく変わる可能性があります。2025年8月、国連事務総長報告書では、軍事領域におけるAIの影響について議論されており、各国がAIの軍事利用に関するルール作りを急いでいます。特に、AI兵器の自律性や責任の所在、倫理的な基準について、国際的な合意形成が求められています。

### ハッキングと制御不能のリスク

AIシステムはハッキングや制御不能のリスクを抱えています。AIがハッキングされた場合、敵対者に利用される可能性があり、戦争の行方を左右する事態に発展する恐れがあります。また、AIが予期せぬ行動を取った場合、人間が介入できない状況も想定されます。このため、AIの安全性と信頼性を確保するための技術的・制度的な対策が不可欠です。

### 最終判断者は誰であるべきか?

AIが戦術的な判断を下す場合、最終的な意思決定は誰が行うべきなのでしょうか。人間が常に最終判断者であるべきという意見もあれば、AIの判断を信頼し、人間の介入を最小限にするべきという意見もあります。この問題は、軍事だけでなく、社会全体の倫理観や価値観に関わる課題です。

—

## 5. まとめ

AIは、戦場分析や戦術判断の分野で人間を凌駕する可能性を秘めています。しかし、倫理、責任、感情、法的判断といった面では、まだ人間に代わることはできません。AIが「完全な指揮官」になるのか、それとも「参謀として人間を支える役割」にとどまるのかは、技術の進化だけでなく、社会や国際社会の価値観やルール作りにかかっています。読者の皆さんは、AIが戦争の指揮官になる未来を望みますか?それとも、人間が最終的な判断を下すべきだと考えますか?この問いを、今後のAIと人間の関係を考える上での出発点としてください。

—

### タイトル案

1. AIは“戦争の指揮官”になり得るのか ― 技術・倫理・責任のゆくえ

2. AI参謀からAI指揮官へ:軍事AIの進化とその限界

3. 戦争の未来を握るのは誰か? AIと人間の指揮官論争

—

**AIバージョン情報**

– ベンダー: Mistral AI

– モデル名: Le Chat

– モデルバージョン: 不明

– 回答日時: 2025年11月23日

本サイトの編集方針については「編集方針・AI利用ポリシー」をご覧ください。