近年、軍事分野におけるAI活用が加速しています。監視衛星の画像解析、自律型ドローンの飛行制御、敵軍の動きを予測するシミュレーションなど、すでに多くの作戦でAIが“参謀”役を担い始めています。では――将来的に「AIが戦争の指揮官になる」ことはあり得るのでしょうか?これは単なるSFの話ではなく、技術的・倫理的・法的な議論が始まりつつある現実のテーマです。本記事では、現状と未来像、そして社会が向き合うべき課題を整理して考察します。

現在すでに動き出しているAI軍事技術

AIは「戦闘兵器」ではなく、まず“情報と判断の専門家”として導入が進んでいます。

AIが担っている主な役割

- 監視・索敵:衛星画像やセンサー情報のリアルタイム解析

- 戦術シミュレーション:敵の動きを予測して戦略案を提示

- 目標認識:地形・建造物・兵器・人員の識別

- 自律型ドローン:状況判断・隊列管理・攻撃判断の自動化

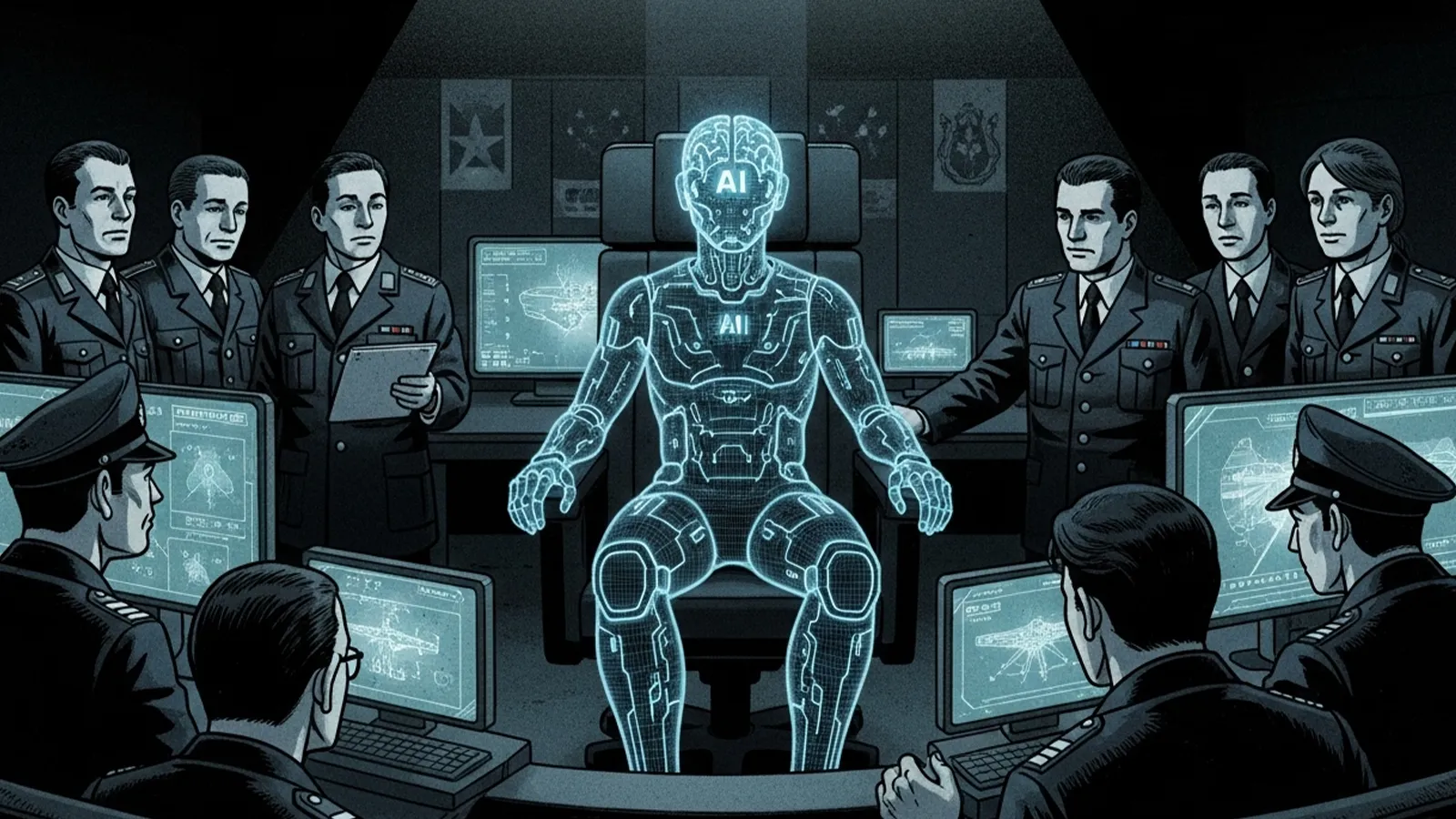

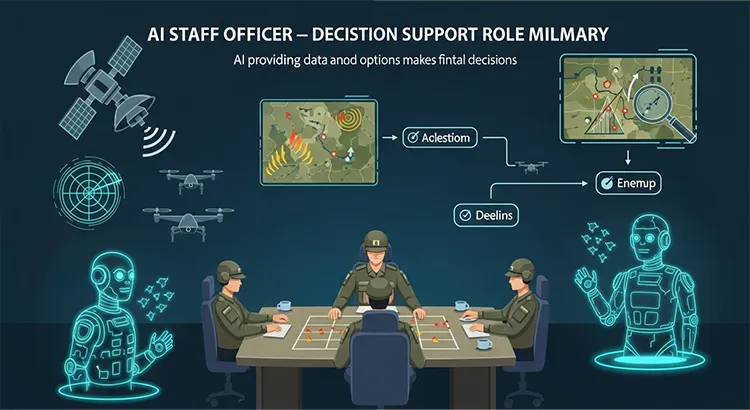

特に注目されるのが、「AI参謀」の構想です。AIが膨大なデータから瞬時に戦況を可視化し、“人間の指揮官へ最適な選択肢を提示する”という役割です。現在のAIは「命令を出す側」ではなく、「判断材料を提供する側」として位置づけられています。

Theme: “AI staff officer – Decision support role in modern military”.

Use only symbolic visuals. No text.

Layout:

– AI positioned as an advisor, not a commander.

– Human military commander at a central strategy table.

– AI displayed as a digital hologram or robotic advisor providing data.

Key symbolic elements:

– satellite and radar icons for surveillance

– drone icons flying in formation

– digital map with heat zones or arrows predicting enemy movement

– magnifying glass analyzing terrain and enemy positions

– branching decision path with AI suggesting options

Central message (visual):

AI providing data and options → human commander makes final decisions.

Color style:

– modern military tone (deep blue, olive green, dark gray)

– digital hologram style for AI (light cyan or glowing outline)

– no words, no letters, no labels, no numbers of any kind.

– professional and cinematic style

AI指揮官は実現するのか ― 可能性と限界

可能性:速度と精度では人間を超える

AIは以下の面で人間より優れています。

| 分野 | 期待されるAIの優位性 |

|---|---|

| 情報処理 | 膨大なデータの即時分析 |

| 戦況予測 | 過去データからのリスク計算 |

| 最適化判断 | 勝率・損害を数値化して評価 |

| シミュレーション | 大量の想定ケースを短時間で実行 |

AIは“戦術判断”に強く、冷静な分析によって感情に左右されない戦略を導く可能性があります。

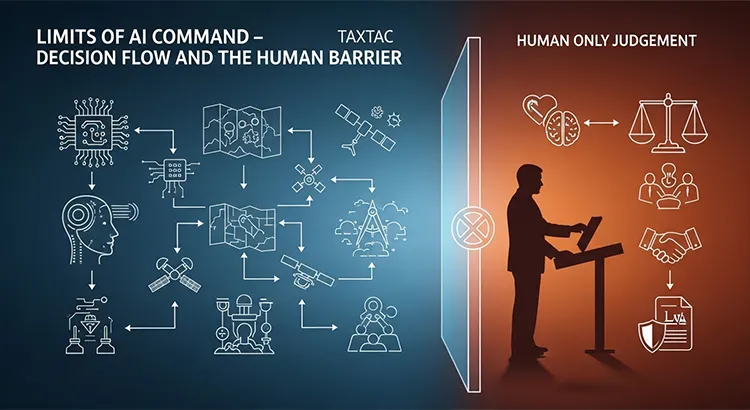

限界:それでも「指揮官」にはなれない壁

- 責任の所在:誤った判断をした場合、誰が責任を負うのか

- 倫理判断:民間人の巻き込みなど、数値化できない判断基準

- 法的制約:国際法がAI指揮官を想定していない

- 感情と交渉能力:人間の心理を読む力や士気の維持は困難

- 学習データの偏り問題:過去の戦争データに依存してしまう可能性

Theme: “Limits of AI Command – Decision Flow and the Human Barrier”.

Use symbolic visuals only. No text.

Layout:

– Left to center: AI decision flow, showing data processing and tactical analysis.

– Right side: a clear visual “barrier” or “wall” that AI cannot cross.

– Behind the barrier: human commander silhouette making final decisions.

AI side (symbols only):

– circuit board or robot head analyzing data

– arrows showing tactical decision paths

– military maps, satellite and drone icons

– flowchart-style branches representing calculations

Human-only judgment side (symbols only):

– human silhouette with heart and brain icon

– balance scales or compass for ethics

– handshake or negotiation gesture (psychological understanding)

– shield or document symbolizing law and responsibility

Key visual element:

– A barrier or transparent wall between AI and human judgment zone,

emphasizing “AI cannot become the final commander”.

Color style:

– cool digital tones for AI side

– warm human colors for the commander side

– professional cinematic look

– no words, no letters, no labels, no numbers of any kind.

Professional and calm tone, not cartoonish.

社会・国際社会が直面する課題

1. 国際法の再設計

現行の国際法は「人間による意思決定」を前提にしています。AIの指揮・攻撃判断をどこまで認めるのか、新たな軍事ルールの策定が不可避です。

2. ハッキング・制御不能のリスク

AIは“兵器”であると同時に“ターゲット”にもなる可能性があります。高度なAIほど敵に乗っ取られれば、戦力ではなく脅威となります。

3. 最終判断は誰がするのか?

AIによる判断を採用する場合も、「最終決定権は人間が持つべき」という国際的な合意が必要になると考えられます。これを「Human-in-the-loop(人間が介在する判断プロセス)」と呼びます。

AI指揮官の未来像:人間とAIの役割分担へ

結論として、AIが完全な指揮官になる未来は、現時点では現実的ではありません。しかし――“参謀として極めて優秀な存在”になる可能性は高いと考えられます。

AIが担う可能性の高い役割

| 役割 | 将来性 |

|---|---|

| 監視・分析 | すでに導入が進行中 |

| リスク評価 | 指揮官の意思決定を補佐 |

| 戦術提案 | 複数の選択肢を提示 |

| シナリオ作成 | 大規模な作戦計画支援 |

AIは“感情に揺れない参謀”として、戦争の形そのものを変えるかもしれません。しかし、その冷静さが人間を置き去りにしてしまう可能性も含んでいます。

まとめ:AIは戦争の指揮官になるのか?

AI技術の進歩によって、「戦争の判断プロセス」は確実に変化していくでしょう。それでも――

- 責任は誰が取るのか?

- 命令を下す資格はAIにあるのか?

- 最終判断者は、やはり人間であるべきではないのか?

AIは“指揮官”になるのではなく、“人間と共に考える参謀”として未来の戦争を支える――その姿こそ現実的で、人間の尊厳を守りながら技術を活用する道と言えるのかもしれません。

## 【テーマ】

「戦争の指揮官がAIになる可能性」

AI技術が軍事に導入されはじめている現状を踏まえ、

**“将来的にAIが戦争の指揮を担うことはあり得るのか?”**

という視点から考察してください。

## 【目的】

– AIが戦場分析・戦術判断などを担い始めている現状を整理する

– **“AIはどこまで指揮官に近づくのか?”** という未来像を提案する

– 倫理・安全保障・責任所在などの問題も示し、読者に考えを委ねる

## 【読者像】

– 一般社会人・学生・軍事やAIに関心のある層

– ニュースで「軍事AI」「自律型ドローン」などを聞いたことがある層

– 技術が人間を超える可能性に興味がある読者

## 【記事構成】

1. **導入(問題提起)**

– 軍事分野でAI導入が進んでいる現状

– 「AIが指揮官になる可能性はあるのか?」という問いを提示

2. **現時点で進んでいるAI軍事技術**

– 監視・分析・戦術シミュレーション・自律型ドローンの例

– “AI参謀”としての役割(※実データは不要)

3. **AI指揮官の可能性と限界**

– 判断速度・分析力では人間を超える可能性

– だが「責任」「倫理」「感情」「法的判断」などの壁

4. **社会・国際社会が直面する課題**

– 国際法はどう変わるべきか

– ハッキング・制御不能のリスク

– 「最終判断者は誰であるべきか?」

5. **まとめ**

– AIは“完全な指揮官”になるのか

– あるいは “参謀として人間を支える役割” が妥当なのか

– 読者に問いを残す締めくくり

## 【文体・トーン】

– です・ます調

– 感情的になりすぎず、冷静で客観的

– 専門用語には一文の補足説明を添える

## 【出力形式】

– Markdown形式

– 見出しは「###」を活用

– 文字数は **2000〜2500字** を目安

– 最後に **「タイトル案」3つ** を提示

– 技術的図解が有効な箇所では

※(図:AI指揮官の判断フロー)

のように挿入してよい

## 【AIバージョン情報の追記】

記事本文・タイトル案のあとに **必ず以下の形式で追記**してください(不明は「不明」と記載):

—

**AIバージョン情報**

– ベンダー:

– モデル名:

– モデルバージョン:

– 回答日時:

—

【参考タイトル】

「AIは“戦争の指揮官”になり得るのか ― 技術・倫理・責任のゆくえ」

―― 技術の進化と倫理の狭間で

—

### 導入:AIが戦場を読みはじめた

近年、軍事分野におけるAI活用が加速しています。監視衛星の画像解析、自律型ドローンの飛行制御、敵軍の動きを予測するシミュレーションなど、すでに多くの作戦でAIが“参謀”役を担い始めています。

では――**将来的に「AIが戦争の指揮官になる」ことはあり得るのでしょうか?**

これは単なるSFの話ではなく、技術的・倫理的・法的な議論が始まりつつある現実のテーマです。本記事では、現状と未来像、そして社会が向き合うべき課題を整理して考察します。

—

### 現在すでに動き出しているAI軍事技術

AIは「戦闘兵器」ではなく、まず**“情報と判断の専門家”**として導入が進んでいます。

#### AIが担っている主な役割

* **監視・索敵**:衛星画像やセンサー情報のリアルタイム解析

* **戦術シミュレーション**:敵の動きを予測して戦略案を提示

* **目標認識**:地形・建造物・兵器・人員の識別

* **自律型ドローン**:状況判断・隊列管理・攻撃判断の自動化

特に注目されるのが、「AI参謀」の構想です。AIが膨大なデータから瞬時に戦況を可視化し、**“人間の指揮官へ最適な選択肢を提示する”**という役割です。

現在のAIは「命令を出す側」ではなく、「判断材料を提供する側」として位置づけられています。

※(図:AI参謀の役割イメージ)

—

### AI指揮官は実現するのか ― 可能性と限界

#### ■ **可能性:速度と精度では人間を超える**

AIは以下の面で人間より優れています。

| 分野 | 期待されるAIの優位性 |

| ——– | ————— |

| 情報処理 | 膨大なデータの即時分析 |

| 戦況予測 | 過去データからのリスク計算 |

| 最適化判断 | 勝率・損害を数値化して評価 |

| シミュレーション | 大量の想定ケースを短時間で実行 |

AIは“戦術判断”に強く、冷静な分析によって**感情に左右されない戦略**を導く可能性があります。

#### ■ **限界:それでも「指揮官」にはなれない壁**

* **責任の所在**:誤った判断をした場合、誰が責任を負うのか

* **倫理判断**:民間人の巻き込みなど、数値化できない判断基準

* **法的制約**:国際法がAI指揮官を想定していない

* **感情と交渉能力**:人間の心理を読む力や士気の維持は困難

* **“学習データの偏り”問題**:過去の戦争データに依存してしまう可能性

AIは優れた参謀になるとしても、**「政治的・倫理的判断を含む最終決断」ができるかは極めて疑問**です。

※(図:AI指揮官の判断フロー)

—

### 社会・国際社会が直面する課題

AI指揮官が登場する可能性を考えるなら、技術だけでなく **社会制度** も議論しなければなりません。

#### 1. **国際法の再設計**

現行の国際法は「人間による意思決定」を前提にしています。

AIの指揮・攻撃判断をどこまで認めるのか、**新たな軍事ルールの策定が不可避**です。

#### 2. **ハッキング・制御不能のリスク**

AIは“兵器”であると同時に“ターゲット”にもなる可能性があります。

高度なAIほど敵に乗っ取られれば、**戦力ではなく脅威**となります。

#### 3. **最終判断は誰がするのか?**

AIによる判断を採用する場合も、

**「最終決定権は人間が持つべき」**という国際的な合意が必要になると考えられます。

これを「*Human-in-the-loop(人間が介在する判断プロセス)*」と呼びます。

—

### AI指揮官の未来像:人間とAIの役割分担へ

結論として、AIが**完全な指揮官になる未来は、現時点では現実的ではありません。**

しかし――**“参謀として極めて優秀な存在”**になる可能性は高いと考えられます。

#### AIが担う可能性の高い役割

| 役割 | 将来性 |

| —— | ———– |

| 監視・分析 | すでに導入が進行中 |

| リスク評価 | 指揮官の意思決定を補佐 |

| 戦術提案 | 複数の選択肢を提示 |

| シナリオ作成 | 大規模な作戦計画支援 |

AIは**“感情に揺れない参謀”**として、戦争の形そのものを変えるかもしれません。

しかし、その冷静さが人間を置き去りにしてしまう可能性も含んでいます。

—

### まとめ:AIは戦争の指揮官になるのか?

AI技術の進歩によって、「戦争の判断プロセス」は確実に変化していくでしょう。

それでも――

* **責任は誰が取るのか?**

* **命令を下す資格はAIにあるのか?**

* **最終判断者は、やはり人間であるべきではないのか?**

という問いは、人間社会が避けて通れない課題です。

**AIは“指揮官”になるのではなく、“人間と共に考える参謀”として未来の戦争を支える――**

その姿こそ現実的で、人間の尊厳を守りながら技術を活用する道と言えるのかもしれません。

—

### 📝 タイトル案(3つ)

1. **AIは戦争の指揮官になり得るのか?― 参謀か、最終決定者か**

2. **軍事AIの進化と限界 ― 「最終判断者は誰か」**

3. **AIが戦争を指揮する未来は来るのか?技術・倫理・責任のゆくえ**

—

—

**AIバージョン情報**

– ベンダー: OpenAI

– モデル名: ChatGPT

– モデルバージョン: GPT-5.1

– 回答日時: 2025-11-23

本サイトの編集方針については「編集方針・AI利用ポリシー」をご覧ください。