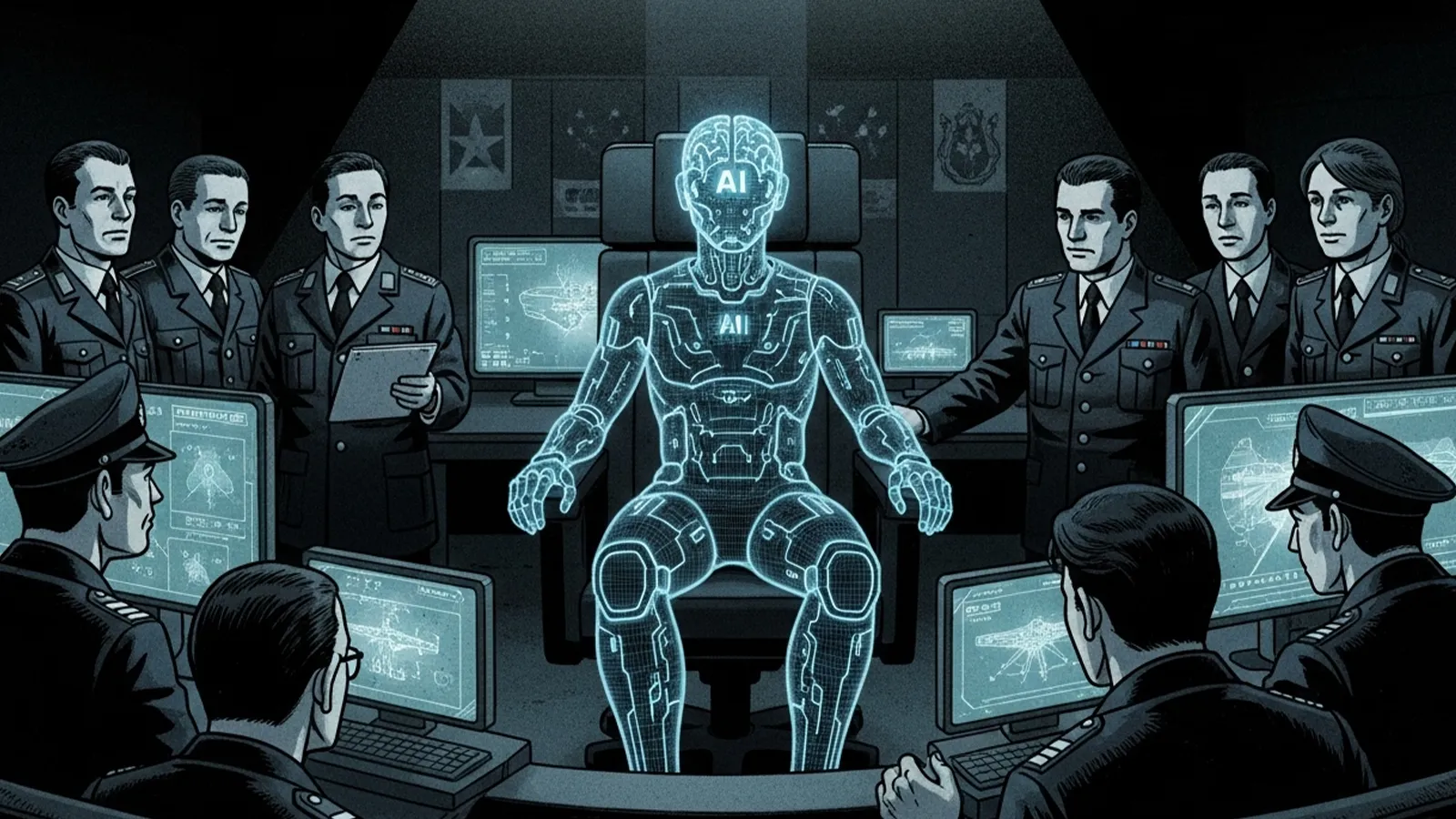

現代の軍事戦略において、AI(人工知能)技術の導入はもはや避けられない潮流となっています。偵察、情報分析、目標選定、そして無人兵器の制御といった多岐にわたる分野で、AIはすでに戦術的意思決定の速度と精度を劇的に向上させ始めています。

この技術進化の先にある、極めて重大な問いが浮かび上がります。それは、「将来的にAIが、人間の将軍に代わって戦争全体の指揮を担うことはあり得るのか?」という問いです。

現在、AIはあくまで「参謀」や「オペレーター」の役割に留まっています。しかし、その自律性が高まり、判断能力が人間の限界を超えたとき、私たちはAIに「指揮官」の座を明け渡すことになるのでしょうか。本稿では、軍事AIの現状を整理しつつ、AI指揮官が直面する可能性と倫理的な限界について深く考察します。

🛡️ 導入(問題提起):戦場に立つAI技術の現在地

現代の軍事戦略において、AI(人工知能)技術の導入はもはや避けられない潮流となっています。偵察、情報分析、目標選定、そして無人兵器の制御といった多岐にわたる分野で、AIはすでに戦術的意思決定の速度と精度を劇的に向上させ始めています。

この技術進化の先にある、極めて重大な問いが浮かび上がります。それは、「将来的にAIが、人間の将軍に代わって戦争全体の指揮を担うことはあり得るのか?」という問いです。

現在、AIはあくまで「参謀」や「オペレーター」の役割に留まっています。しかし、その自律性が高まり、判断能力が人間の限界を超えたとき、私たちはAIに「指揮官」の座を明け渡すことになるのでしょうか。本稿では、軍事AIの現状を整理しつつ、AI指揮官が直面する可能性と倫理的な限界について深く考察します。

🔎 現時点で進んでいるAI軍事技術:”AI参謀”としての役割

AIは、すでに多くの国で、人間による意思決定を支援する「AI参謀」のような役割を果たしています。その技術は、大きく分けて以下の分野で導入が進んでいます。

1. 情報収集と戦場分析(ISR)

AIは、衛星画像、ドローンからの映像、電子情報など、戦場で収集される膨大なデータを瞬時に分析します。人間では処理しきれない量の情報をリアルタイムで解析し、敵の動きや部隊配置といった戦況を正確に把握することで、指揮官の状況認識(Situation Awareness)を大幅に高めます。

2. 戦術シミュレーションと意思決定支援

特定の戦闘シナリオに基づき、AIは何万通りもの戦術をシミュレーションし、それぞれの成功確率やリスクを評価できます。これにより、指揮官は経験則や直感に頼るだけでなく、データに基づいた客観的な戦術判断を下すことが可能になります。

3. 自律型兵器システム(LAWS)

最も議論を呼んでいるのが、自律型兵器システム(Lethal Autonomous Weapon Systems:LAWS)、いわゆる「キラーロボット」です。これは、人間が介入することなく、AI自身が標的を認識し、攻撃の実行を決定する兵器を指します。偵察ドローンから始まり、現在は無人戦闘車両や自律型ミサイルなど、その応用範囲は広がりつつあります。

これらの技術は、戦場における「情報の優位性」と「決定の速度」を確保する上で決定的な役割を果たします。

🚀 AI指揮官の可能性と限界:どこまで人間に近づけるか

AIが指揮官の役割を担う未来は、どのようなメリットとデメリットをもたらすのでしょうか。

✅ AI指揮官の可能性

AIが人間の指揮官を凌駕する可能性があるのは、その処理能力と客観性にあります。

- 超高速の判断速度: 現代戦は数秒単位の意思決定が勝敗を分けるため、AIは人間の反応速度を遥かに超える速度で情報を処理し、最適な戦術を提案・実行できます。

- バイアスの排除: 人間が陥りがちな疲労、恐怖、怒りといった感情的な判断ミスや認知バイアスから解放され、常に冷静沈徹な判断を下せます。

- 最適解の追求: 過去の膨大な戦闘データから学習し、特定の状況下で最も被害を抑え、目標達成確率が高い「最適解」を導き出すことができます。

🚧 AI指揮官の限界を定める「4つの壁」

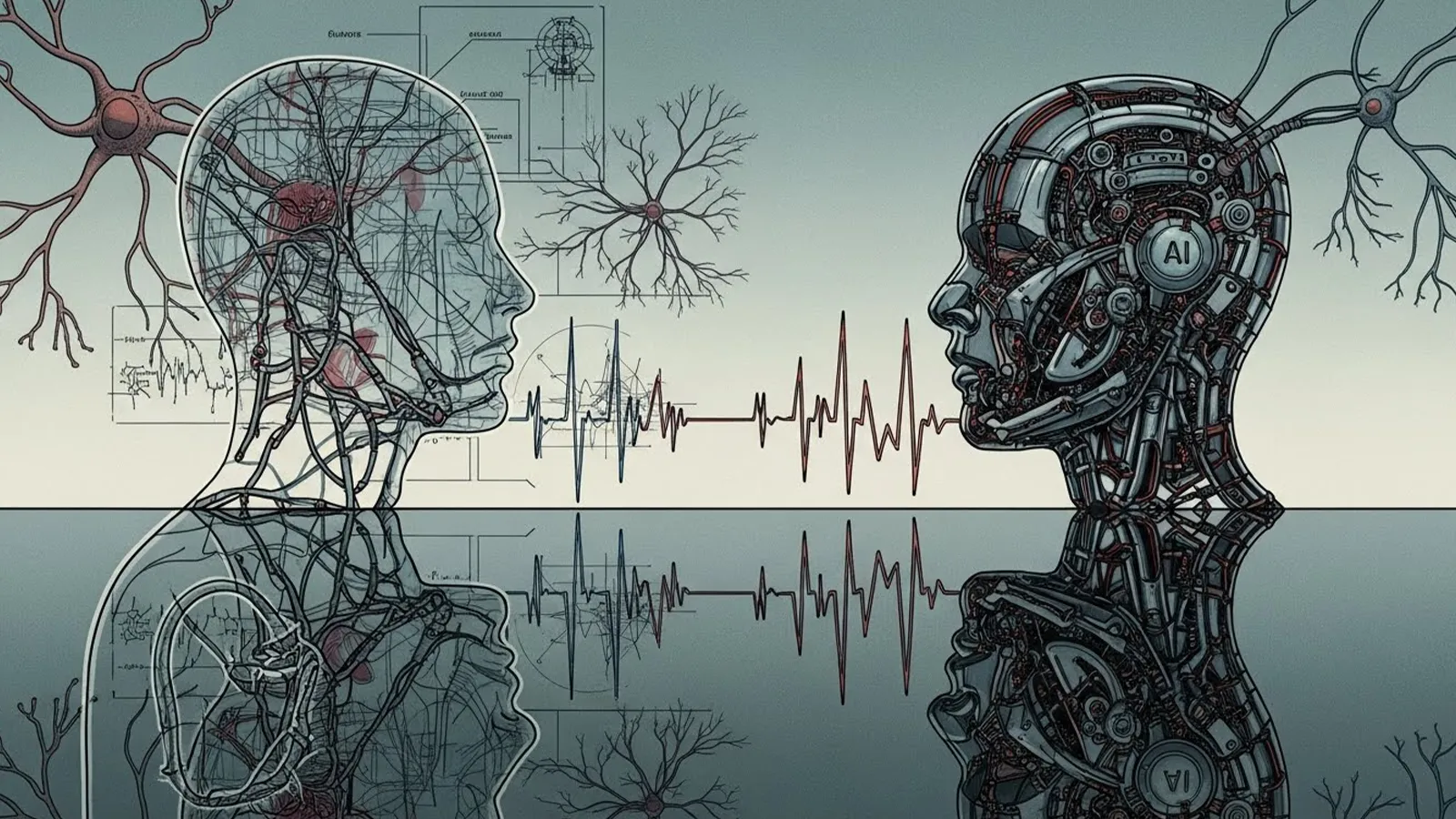

しかし、AIが真に「指揮官」となるには、技術的な問題以上に、乗り越えがたい倫理的・哲学的・法的な壁が存在します。

1. 責任の壁(Accountability)

戦闘行為によって民間人に被害が生じた場合、その責任は誰にあるのか? AIに「責任」を負わせることはできません。プログラマー、AIを配備した上級指揮官、あるいは国家全体か。責任の所在があいまいになることで、倫理的な歯止めが失われるリスクがあります。

2. 倫理・道徳の壁(Morality)

戦争には、単なる効率や勝敗を超えた倫理的判断が不可欠です。例えば、「降伏した敵兵をどう扱うか」「非戦闘員の犠牲をどこまで許容するか」といった判断は、国際人道法(IHL)や人道的精神に基づく必要があります。AIはデータに基づいて学習しますが、「人命の尊厳」といった概念を真に理解し、状況の機微に応じた適切な判断を下すことは極めて困難です。

3. 法的判断の壁(Legality)

AIは、国際人道法やジュネーブ条約といった複雑な国際法規を解釈し、刻々と変化する戦場で適用する能力を持つでしょうか。特に「必要性」「均衡性」「区別(戦闘員と非戦闘員の区別)」といった法的原則は、高度な状況判断と意図の読み取りを必要とします。

4. 人間の信頼(Trust)

戦場で兵士が命を託すには、指揮官に対する絶対的な信頼が必要です。AIがいくら優れていても、その判断プロセスがブラックボックスである限り、人間がその「命令」に命を懸けて従うことができるのか、という心理的な問題も残ります。

※(図:AI指揮官の判断フロー)

(入力)戦場データ $\to$ (処理)超高速分析 $\to$ (判断)戦術提案 $\to$ (壁)倫理・国際法チェック $\to$ (出力)実行命令

🌐 社会・国際社会が直面する課題:最終判断者は誰か

AI軍事技術の発展は、単なる技術の問題ではなく、国際安全保障の枠組みや、社会の倫理観そのものを揺るがす課題を提起しています。

1. 国際法の変革の必要性

自律型兵器が普及すれば、国際人道法は大きく変わる必要に迫られます。AIに「区別」や「均衡性」の原則をどのようにプログラムし、もし違反があった場合に、法的に誰を裁くのか。AI兵器の「責任ある使用」を担保するための国際的な取り決めが急務です。

2. ハッキング・制御不能のリスク

AIシステムは、外部からのハッキングや、アルゴリズムの予期せぬエラー(制御不能な暴走)のリスクを常に抱えています。AI指揮官が誤った判断を下したり、敵にシステムを乗っ取られたりすれば、その結果は人類の制御を超えた大惨事につながりかねません。

3. 「最終判断者は誰であるべきか?」

最も重要な課題は、人命に関わる「最終的な判断(Human-on-the-loop)」を誰が担うか、という点です。国際社会では、自律型兵器が攻撃を決定するプロセスにおいて、いかなる場合も人間の実質的な関与を確保すべきだという議論が主流になりつつあります。AIはあくまで高度なツールであり、「生命の決定」という重責は人間が持つべきだという考えです。

💡 まとめ:AIは“完全な指揮官”になるのか

AIは、すでに情報分析と戦術提案において、人間の能力を遥かに超える「最高の参謀」としての地位を確立しつつあります。その判断速度と客観性は、未来の軍事作戦において不可欠な要素となるでしょう。

しかし、戦争の指揮官には、技術的な優位性だけでなく、国際法、倫理、道徳、そして人間の「生命の重み」を理解し、その上で責任を負うという、人間の本質的な能力が求められます。

結論として、AIが軍事作戦の細部を担う“戦術レベルの指揮官”に近づく可能性は非常に高いですが、国際法や人命に関する重大な決定を下す“戦略レベルの完全な指揮官”となる道は、倫理的・法的な壁に阻まれていると言えます。

私たちは、AIを「人間の指揮官を最大限に支援する、強力な意思決定ツール」として活用することを目指すべきではないでしょうか。AIの限界と人間の役割を明確に区切り、常に「最終判断は人間が下す」という原則を保持することが、技術進化と人類の安全保障を両立させるための鍵となります。

読者の皆様は、AIがどこまで戦場の意思決定に介入することを許容しますか? この問いは、AI技術の発展と共に、私たち全員が向き合い続けるべきテーマです。

## 【テーマ】

「戦争の指揮官がAIになる可能性」

AI技術が軍事に導入されはじめている現状を踏まえ、

**“将来的にAIが戦争の指揮を担うことはあり得るのか?”**

という視点から考察してください。

## 【目的】

– AIが戦場分析・戦術判断などを担い始めている現状を整理する

– **“AIはどこまで指揮官に近づくのか?”** という未来像を提案する

– 倫理・安全保障・責任所在などの問題も示し、読者に考えを委ねる

## 【読者像】

– 一般社会人・学生・軍事やAIに関心のある層

– ニュースで「軍事AI」「自律型ドローン」などを聞いたことがある層

– 技術が人間を超える可能性に興味がある読者

## 【記事構成】

1. **導入(問題提起)**

– 軍事分野でAI導入が進んでいる現状

– 「AIが指揮官になる可能性はあるのか?」という問いを提示

2. **現時点で進んでいるAI軍事技術**

– 監視・分析・戦術シミュレーション・自律型ドローンの例

– “AI参謀”としての役割(※実データは不要)

3. **AI指揮官の可能性と限界**

– 判断速度・分析力では人間を超える可能性

– だが「責任」「倫理」「感情」「法的判断」などの壁

4. **社会・国際社会が直面する課題**

– 国際法はどう変わるべきか

– ハッキング・制御不能のリスク

– 「最終判断者は誰であるべきか?」

5. **まとめ**

– AIは“完全な指揮官”になるのか

– あるいは “参謀として人間を支える役割” が妥当なのか

– 読者に問いを残す締めくくり

## 【文体・トーン】

– です・ます調

– 感情的になりすぎず、冷静で客観的

– 専門用語には一文の補足説明を添える

## 【出力形式】

– Markdown形式

– 見出しは「###」を活用

– 文字数は **2000〜2500字** を目安

– 最後に **「タイトル案」3つ** を提示

– 技術的図解が有効な箇所では

※(図:AI指揮官の判断フロー)

のように挿入してよい

## 【AIバージョン情報の追記】

記事本文・タイトル案のあとに **必ず以下の形式で追記**してください(不明は「不明」と記載):

—

**AIバージョン情報**

– ベンダー:

– モデル名:

– モデルバージョン:

– 回答日時:

—

【参考タイトル】

「AIは“戦争の指揮官”になり得るのか ― 技術・倫理・責任のゆくえ」

## 🛡️ 導入(問題提起):戦場に立つAI技術の現在地

現代の軍事戦略において、AI(人工知能)技術の導入はもはや避けられない潮流となっています。偵察、情報分析、目標選定、そして無人兵器の制御といった多岐にわたる分野で、AIはすでに戦術的意思決定の速度と精度を劇的に向上させ始めています。

この技術進化の先にある、極めて重大な問いが浮かび上がります。それは、「**将来的にAIが、人間の将軍に代わって戦争全体の指揮を担うことはあり得るのか?**」という問いです。

現在、AIはあくまで「参謀」や「オペレーター」の役割に留まっています。しかし、その自律性が高まり、判断能力が人間の限界を超えたとき、私たちはAIに「指揮官」の座を明け渡すことになるのでしょうか。本稿では、軍事AIの現状を整理しつつ、AI指揮官が直面する可能性と倫理的な限界について深く考察します。

—

## 🔎 現時点で進んでいるAI軍事技術:”AI参謀”としての役割

AIは、すでに多くの国で、人間による意思決定を支援する「**AI参謀**」のような役割を果たしています。その技術は、大きく分けて以下の分野で導入が進んでいます。

### 1. 情報収集と戦場分析(ISR)

AIは、衛星画像、ドローンからの映像、電子情報など、戦場で収集される膨大なデータを瞬時に分析します。人間では処理しきれない量の情報をリアルタイムで解析し、敵の動きや部隊配置といった戦況を正確に把握することで、指揮官の**状況認識(Situation Awareness)**を大幅に高めます。

### 2. 戦術シミュレーションと意思決定支援

特定の戦闘シナリオに基づき、AIは何万通りもの戦術をシミュレーションし、それぞれの成功確率やリスクを評価できます。これにより、指揮官は経験則や直感に頼るだけでなく、**データに基づいた客観的な戦術判断**を下すことが可能になります。

### 3. 自律型兵器システム(LAWS)

最も議論を呼んでいるのが、自律型兵器システム(Lethal Autonomous Weapon Systems:LAWS)、いわゆる「**キラーロボット**」です。これは、人間が介入することなく、AI自身が標的を認識し、攻撃の実行を決定する兵器を指します。偵察ドローンから始まり、現在は無人戦闘車両や自律型ミサイルなど、その応用範囲は広がりつつあります。

これらの技術は、戦場における「情報の優位性」と「決定の速度」を確保する上で決定的な役割を果たします。

—

## 🚀 AI指揮官の可能性と限界:どこまで人間に近づけるか

AIが指揮官の役割を担う未来は、どのようなメリットとデメリットをもたらすのでしょうか。

### ✅ AI指揮官の可能性

AIが人間の指揮官を凌駕する可能性があるのは、その**処理能力と客観性**にあります。

* **超高速の判断速度:** 現代戦は数秒単位の意思決定が勝敗を分けるため、AIは人間の反応速度を遥かに超える速度で情報を処理し、最適な戦術を提案・実行できます。

* **バイアスの排除:** 人間が陥りがちな疲労、恐怖、怒りといった**感情的な判断ミスや認知バイアス**から解放され、常に冷静沈徹な判断を下せます。

* **最適解の追求:** 過去の膨大な戦闘データから学習し、特定の状況下で最も被害を抑え、目標達成確率が高い**「最適解」**を導き出すことができます。

### 🚧 AI指揮官の限界を定める「4つの壁」

しかし、AIが真に「指揮官」となるには、技術的な問題以上に、乗り越えがたい**倫理的・哲学的・法的**な壁が存在します。

#### 1. 責任の壁(Accountability)

戦闘行為によって民間人に被害が生じた場合、その**責任は誰にあるのか?** AIに「責任」を負わせることはできません。プログラマー、AIを配備した上級指揮官、あるいは国家全体か。責任の所在があいまいになることで、倫理的な歯止めが失われるリスクがあります。

#### 2. 倫理・道徳の壁(Morality)

戦争には、単なる効率や勝敗を超えた**倫理的判断**が不可欠です。例えば、「降伏した敵兵をどう扱うか」「非戦闘員の犠牲をどこまで許容するか」といった判断は、国際人道法(IHL)や**人道的精神**に基づく必要があります。AIはデータに基づいて学習しますが、「人命の尊厳」といった概念を真に理解し、**状況の機微**に応じた適切な判断を下すことは極めて困難です。

#### 3. 法的判断の壁(Legality)

AIは、国際人道法やジュネーブ条約といった**複雑な国際法規**を解釈し、刻々と変化する戦場で適用する能力を持つでしょうか。特に「必要性」「均衡性」「区別(戦闘員と非戦闘員の区別)」といった法的原則は、高度な**状況判断と意図の読み取り**を必要とします。

#### 4. 人間の信頼(Trust)

戦場で兵士が命を託すには、指揮官に対する**絶対的な信頼**が必要です。AIがいくら優れていても、その判断プロセスがブラックボックスである限り、人間がその「命令」に命を懸けて従うことができるのか、という心理的な問題も残ります。

※(図:AI指揮官の判断フロー)

(入力)戦場データ $\to$ (処理)超高速分析 $\to$ (判断)戦術提案 $\to$ **(壁)倫理・国際法チェック** $\to$ (出力)実行命令

—

## 🌐 社会・国際社会が直面する課題:最終判断者は誰か

AI軍事技術の発展は、単なる技術の問題ではなく、国際安全保障の枠組みや、社会の倫理観そのものを揺るがす課題を提起しています。

### 1. 国際法の変革の必要性

自律型兵器が普及すれば、**国際人道法**は大きく変わる必要に迫られます。AIに「区別」や「均衡性」の原則をどのようにプログラムし、もし違反があった場合に、法的に誰を裁くのか。AI兵器の**「責任ある使用」**を担保するための国際的な取り決めが急務です。

### 2. ハッキング・制御不能のリスク

AIシステムは、外部からの**ハッキング**や、**アルゴリズムの予期せぬエラー**(制御不能な暴走)のリスクを常に抱えています。AI指揮官が誤った判断を下したり、敵にシステムを乗っ取られたりすれば、その結果は人類の制御を超えた大惨事につながりかねません。

### 3. 「最終判断者は誰であるべきか?」

最も重要な課題は、**人命に関わる「最終的な判断(Human-on-the-loop)」**を誰が担うか、という点です。国際社会では、自律型兵器が攻撃を決定するプロセスにおいて、いかなる場合も**人間の実質的な関与**を確保すべきだという議論が主流になりつつあります。AIはあくまで高度なツールであり、「生命の決定」という重責は人間が持つべきだという考えです。

—

## 💡 まとめ:AIは“完全な指揮官”になるのか

AIは、すでに情報分析と戦術提案において、人間の能力を遥かに超える「**最高の参謀**」としての地位を確立しつつあります。その判断速度と客観性は、未来の軍事作戦において不可欠な要素となるでしょう。

しかし、戦争の指揮官には、技術的な優位性だけでなく、国際法、倫理、道徳、そして人間の「**生命の重み**」を理解し、その上で責任を負うという、**人間の本質的な能力**が求められます。

結論として、AIが軍事作戦の細部を担う**“戦術レベルの指揮官”**に近づく可能性は非常に高いですが、国際法や人命に関する重大な決定を下す**“戦略レベルの完全な指揮官”**となる道は、倫理的・法的な壁に阻まれていると言えます。

私たちは、AIを「**人間の指揮官を最大限に支援する、強力な意思決定ツール**」として活用することを目指すべきではないでしょうか。AIの限界と人間の役割を明確に区切り、常に**「最終判断は人間が下す」**という原則を保持することが、技術進化と人類の安全保障を両立させるための鍵となります。

読者の皆様は、AIがどこまで戦場の意思決定に介入することを許容しますか? この問いは、AI技術の発展と共に、私たち全員が向き合い続けるべきテーマです。

—

### タイトル案

1. **AIは“戦争の指揮官”になり得るのか?—技術・倫理・責任のゆくえ**

2. **AI将軍は誕生するか? 軍事AIの最前線と「倫理的判断」の壁**

3. **戦場の最終決定権は誰の手に? AI指揮官の可能性と国際社会の課題**

—

**AIバージョン情報**

– ベンダー: Google

– モデル名: Flash 2.5

– モデルバージョン: 不明

– 回答日時: 2025年11月23日

本サイトの編集方針については「編集方針・AI利用ポリシー」をご覧ください。