導入(問題提起)

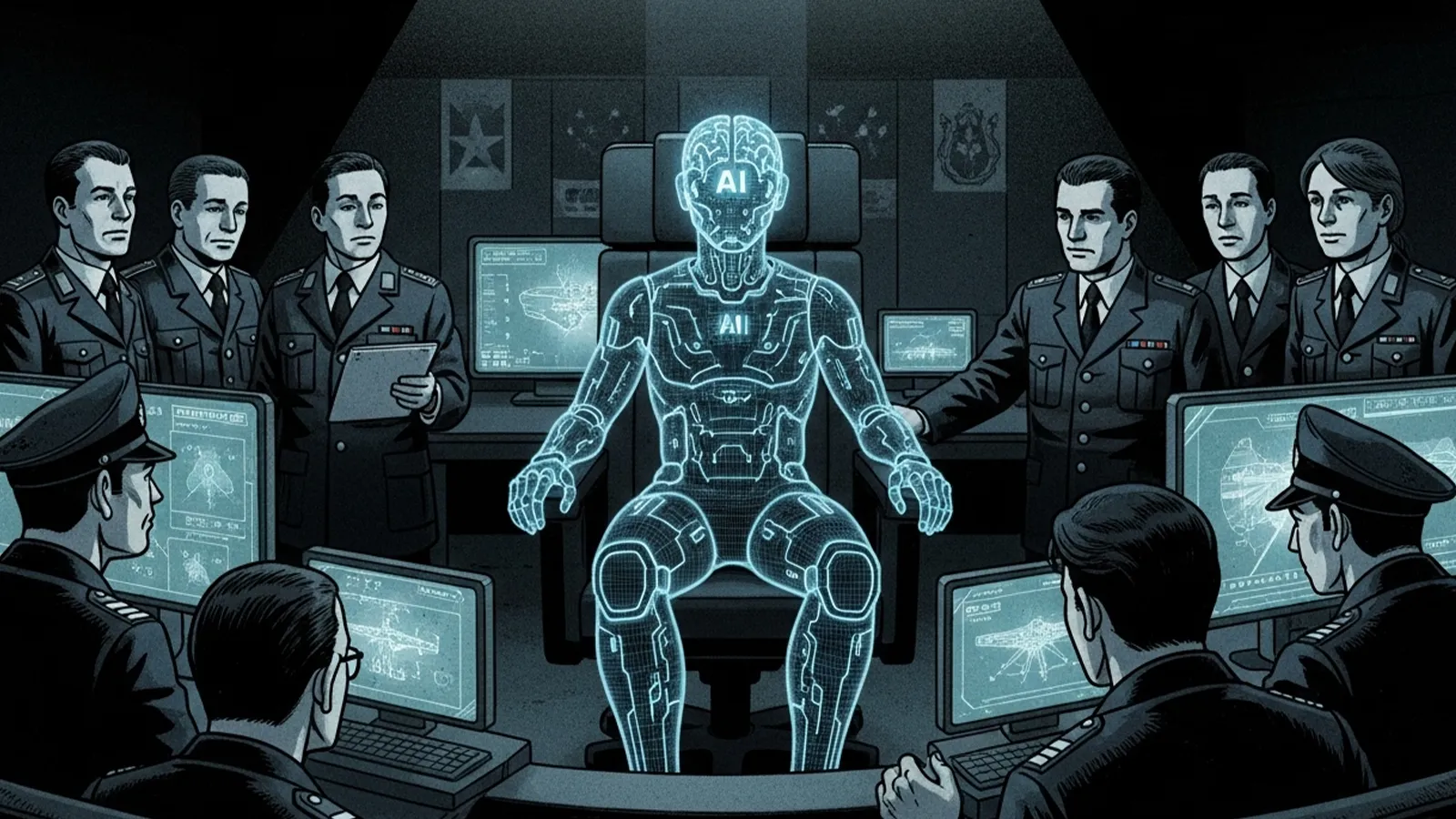

近年、軍事分野におけるAI技術の導入が急速に進んでいます。無人偵察機による監視、膨大なデータからの脅威分析、戦術シミュレーションなど、その役割は多岐にわたります。ニュースで「自律型兵器」や「AI参謀」という言葉を耳にしたことがある方も多いでしょう。こうした技術の進化は、ある一つの根源的な問いを私たちに投げかけます。それは、「AIは、将来的に戦争の指揮官そのものになり得るのか?」という問いです。本記事では、この可能性を、技術の現状、可能性と限界、そして社会が直面する課題から冷静に考察していきます。

現時点で進んでいるAI軍事技術

現在、AIは既に「優秀な参謀」としての役割を担い始めています。具体的には、以下のような領域で活用が進められています。

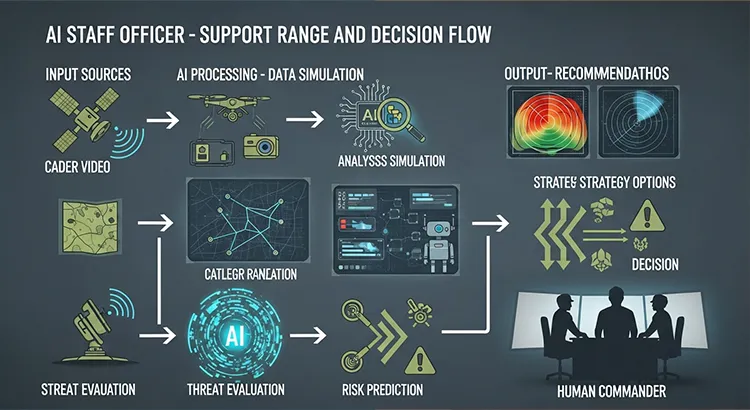

まずは監視・分析です。衛星画像やドローンからの動画など、膨大な量の情報から敵の動きや施設を特定する作業は、人間には負荷が大きいものです。AIはこれを高速で処理し、潜在的な脅威を発見する「状況認識」の支援を行います。

次に戦術シミュレーションです。AIは無数の変数(天候、地形、敵味方の戦力など)を組み合わせ、様々な戦術の結果を瞬時に予測・シミュレーションできます。これにより、指揮官はより多くの選択肢とその結果に関するデータを得て、意思決定を下すことができます。

さらに、自律型ドローンなどの兵器プラットフォームにもAIは導入されています。あらかじめ設定されたルールに基づき、特定のエリアを自律的にパトロールしたり、標的を識別したりする機能です。ただし、現状では「攻撃」の最終判断をAI単独で行うことは、多くの国で抑制する動きが主流です。

Theme: “AI Staff Officer – Support Range and Decision Flow”.

Use symbolic visuals only. No text.

Layout:

A flow from left to right:

[ Input Sources – icons only ]

– satellite scanning terrain

– drone with camera recording video

– intercepted communication signals (antenna waves)

– terrain map symbol

↓ arrow toward AI

[ AI Processing – data analysis and simulation ]

– circuit board + magnifying glass over data

– branching tactical simulation lines on digital map

– robot calculating patterns and risks

– heatmap or radar view visual

↓ arrow toward human commander

[ Output – recommendations to commander ]

– multiple strategy options represented by diverging arrows

– warning icons for threat evaluation

– risk prediction symbol

↓ final element

[ Human Commander ]

– silhouette at strategy table or command center

– clearly shown as making the final decision

Color palette:

– military tones (olive green, gray, dark blue)

– glowing digital cyan for AI systems

– modern cinematic style

– absolutely no words, no letters, no numbers, no labels of any kind.

このように、現時点のAIは「指揮官を補佐する高度なツール」という位置付けが一般的です。

AI指揮官の可能性と限界

では、この「参謀」AIが、いずれ「指揮官」AIに進化する可能性はあるのでしょうか。

可能性:圧倒的な処理速度と分析力

AIは人間とは比較にならない速度で情報を処理し、複雑な戦場環境を統合的に理解できます。敵の欺瞞工作を見破り、瞬時に変化する状況に最適化された戦術を提案、あるいは実行できる可能性があります。感情的疲労やバイアス、パニックに左右されないという点も、冷静な判断を下す存在として期待される理由です。

限界:越えられないかもしれない壁

しかし、そこには越えられないかもしれない、いくつかの大きな「壁」が存在します。

第一の壁は倫理的判断です。戦争には、民間人の犠牲を最小限に抑える「比例性の原則」や、降伏した兵士の扱いなど、複雑な倫理的判断が常につきまといます。AIに「人命の重み」や「文脈を読んだ慈悲」をプログラムすることは極めて困難です。

第二の壁は責任の所在です。AIの判断で作戦が失敗し、多くの犠牲者が出た場合、その責任は誰が取るのでしょうか。開発者なのか、配備を決定した軍の上層部なのか、はたまたAIそのものなのか。法的・社会的な責任の所在が曖昧になるという重大な問題があります。

第三の壁は創造性と文脈理解の欠如です。AIは過去のデータから学習することは得意ですが、まったく新しい戦術を「創造」したり、敵将の性格や政治的な背景、文化や習慣といった「数字に表れない文脈」を深く理解した上で判断を下すことは、現状では不得意であると考えられています。

社会・国際社会が直面する課題

AIが指揮官に近づくにつれて、社会や国際社会はこれまでにない課題に直面することになります。

まず国際法の変革です。現在の国際人道法は、基本的に人間の責任を前提に成り立っています。自律型致死兵器システム(LAWS)の規制をめぐる議論は国連などでも活発に行われており、AIの意思決定をどこまで許容するのか、法的な枠組みを早急に整える必要があります。

次に技術的リスクです。AIシステムはハッキングされる可能性があります。もし敵にAI指揮官の意思決定プロセスを乗っ取られたり、誤ったデータを流し込まれて「狂わされたり」すれば、取り返しのつかない事態を招きかねません。また、想定外の状況で制御不能に陥るリスクも無視できません。

そして最も重要な課題が、「最終判断者は誰であるべきか?」という問いです。戦略という非定形で責任の重大な領域において、最終的な攻撃命令や停戦判断を、人間の監督なしにAIに委ねることは果たして許容されるのでしょうか。これは技術的な問題というより、私たち人類社会がどのような未来を選択するのかという、哲学的な問題に帰結します。

まとめ

AIは、その分析力と速度において、紛れもなく「指揮官」の領域に踏み込みつつあります。しかし、「責任」「倫理」「創造性」という高い壁を考えると、近い将来にAIが感情や価値観を理解し、全ての判断を下す「完全な指揮官」になる可能性は低いと言わざるを得ません。

では、あるべき姿は何でしょうか。それは、AIを「人間を超える指揮官」として目指すのではなく、「人間の指揮官を支え、その判断をより賢明にする最高の参謀」として活用することではないでしょうか。AIの冷静な分析と、人間の倫理観、創造性、責任感。この二つが融合することで、より被害が少なく、合理的な判断が下せるようになるかもしれません。

最後に、読者の皆さんに問いかけます。あなたは、戦争という究極の局面において、最終的な判断をAIに委ねることに、どれほどの安心感を覚えるでしょうか。技術の進化と並行して、私たち一人ひとりがこの問題について考え続けることが、未来の形を決めていくのです。

## 【テーマ】

「戦争の指揮官がAIになる可能性」

AI技術が軍事に導入されはじめている現状を踏まえ、

**“将来的にAIが戦争の指揮を担うことはあり得るのか?”**

という視点から考察してください。

## 【目的】

– AIが戦場分析・戦術判断などを担い始めている現状を整理する

– **“AIはどこまで指揮官に近づくのか?”** という未来像を提案する

– 倫理・安全保障・責任所在などの問題も示し、読者に考えを委ねる

## 【読者像】

– 一般社会人・学生・軍事やAIに関心のある層

– ニュースで「軍事AI」「自律型ドローン」などを聞いたことがある層

– 技術が人間を超える可能性に興味がある読者

## 【記事構成】

1. **導入(問題提起)**

– 軍事分野でAI導入が進んでいる現状

– 「AIが指揮官になる可能性はあるのか?」という問いを提示

2. **現時点で進んでいるAI軍事技術**

– 監視・分析・戦術シミュレーション・自律型ドローンの例

– “AI参謀”としての役割(※実データは不要)

3. **AI指揮官の可能性と限界**

– 判断速度・分析力では人間を超える可能性

– だが「責任」「倫理」「感情」「法的判断」などの壁

4. **社会・国際社会が直面する課題**

– 国際法はどう変わるべきか

– ハッキング・制御不能のリスク

– 「最終判断者は誰であるべきか?」

5. **まとめ**

– AIは“完全な指揮官”になるのか

– あるいは “参謀として人間を支える役割” が妥当なのか

– 読者に問いを残す締めくくり

## 【文体・トーン】

– です・ます調

– 感情的になりすぎず、冷静で客観的

– 専門用語には一文の補足説明を添える

## 【出力形式】

– Markdown形式

– 見出しは「###」を活用

– 文字数は **2000〜2500字** を目安

– 最後に **「タイトル案」3つ** を提示

– 技術的図解が有効な箇所では

※(図:AI指揮官の判断フロー)

のように挿入してよい

## 【AIバージョン情報の追記】

記事本文・タイトル案のあとに **必ず以下の形式で追記**してください(不明は「不明」と記載):

—

**AIバージョン情報**

– ベンダー:

– モデル名:

– モデルバージョン:

– 回答日時:

—

【参考タイトル】

「AIは“戦争の指揮官”になり得るのか ― 技術・倫理・責任のゆくえ」

近年、軍事分野におけるAI技術の導入が急速に進んでいます。無人偵察機による監視、膨大なデータからの脅威分析、戦術シミュレーションなど、その役割は多岐にわたります。ニュースで「自律型兵器」や「AI参謀」という言葉を耳にしたことがある方も多いでしょう。こうした技術の進化は、ある一つの根源的な問いを私たちに投げかけます。それは、「AIは、将来的に戦争の指揮官そのものになり得るのか?」という問いです。本記事では、この可能性を、技術の現状、可能性と限界、そして社会が直面する課題から冷静に考察していきます。

### 現時点で進んでいるAI軍事技術

現在、AIは既に「優秀な参謀」としての役割を担い始めています。具体的には、以下のような領域で活用が進められています。

まずは**監視・分析**です。衛星画像やドローンからの動画など、膨大な量の情報から敵の動きや施設を特定する作業は、人間には負荷が大きいものです。AIはこれを高速で処理し、潜在的な脅威を発見する「状況認識」の支援を行います。

次に**戦術シミュレーション**です。AIは無数の変数(天候、地形、敵味方の戦力など)を組み合わせ、様々な戦術の結果を瞬時に予測・シミュレーションできます。これにより、指揮官はより多くの選択肢とその結果に関するデータを得て、意思決定を下すことができます。

さらに、**自律型ドローン**などの兵器プラットフォームにもAIは導入されています。あらかじめ設定されたルールに基づき、特定のエリアを自律的にパトロールしたり、標的を識別したりする機能です。ただし、現状では「攻撃」の最終判断をAI単独で行うことは、多くの国で抑制する動きが主流です。

※(図:AI参謀のサポート範囲)

[入力: 衛星画像/通信傍受/地形データ] → [AI処理: 分析・識別・シミュレーション] → [出力: 脅威評価/複数の戦術提案/リスク予測] → [人間の指揮官による最終判断]

このように、現時点のAIは「指揮官を補佐する高度なツール」という位置付けが一般的です。

### AI指揮官の可能性と限界

では、この「参謀」AIが、いずれ「指揮官」AIに進化する可能性はあるのでしょうか。

**可能性として挙げられるのは、その圧倒的な処理速度と分析力です。**

AIは人間とは比較にならない速度で情報を処理し、複雑な戦場環境を統合的に理解できます。敵の欺瞞工作を見破り、瞬時に変化する状況に最適化された戦術を提案、あるいは実行できる可能性があります。感情的疲労やバイアス、パニックに左右されないという点も、冷静な判断を下す存在として期待される理由です。

**しかし、そこには越えられないかもしれない、いくつかの大きな「壁」が存在します。**

第一の壁は**倫理的判断**です。戦争には、民間人の犠牲を最小限に抑える「比例性の原則」や、降伏した兵士の扱いなど、複雑な倫理的判断が常につきまといます。AIに「人命の重み」や「文脈を読んだ慈悲」をプログラムすることは極めて困難です。

第二の壁は**責任の所在**です。AIの判断で作戦が失敗し、多くの犠牲者が出た場合、その責任は誰が取るのでしょうか。開発者なのか、配備を決定した軍の上層部なのか、はたまたAIそのものなのか。法的・社会的な責任の所在が曖昧になるという重大な問題があります。

第三の壁は**創造性と文脈理解の欠如**です。AIは過去のデータから学習することは得意ですが、まったく新しい戦術を「創造」したり、敵将の性格や政治的な背景、文化や習慣といった「数字に表れない文脈」を深く理解した上で判断を下すことは、現状では不得意であると考えられています。

### 社会・国際社会が直面する課題

AIが指揮官に近づくにつれて、社会や国際社会はこれまでにない課題に直面することになります。

まず**国際法の変革**です。現在の国際人道法は、基本的に人間の責任を前提に成り立っています。自律型致死兵器システム(LAWS)の規制をめぐる議論は国連などでも活発に行われており、AIの意思決定をどこまで許容するのか、法的な枠組みを早急に整える必要があります。

次に**技術的リスク**です。AIシステムはハッキングされる可能性があります。もし敵にAI指揮官の意思決定プロセスを乗っ取られたり、誤ったデータを流し込まれて「狂わされたり」すれば、取り返しのつかない事態を招きかねません。また、想定外の状況で制御不能に陥るリスクも無視できません。

そして最も重要な課題が、**「最終判断者は誰であるべきか?」** という問いです。戦略という非定形で責任の重大な領域において、最終的な攻撃命令や停戦判断を、人間の監督なしにAIに委ねることは果たして許容されるのでしょうか。これは技術的な問題というより、私たち人類社会がどのような未来を選択するのかという、哲学的な問題に帰結します。

### まとめ

AIは、その分析力と速度において、紛れもなく「指揮官」の領域に踏み込みつつあります。しかし、「責任」「倫理」「創造性」という高い壁を考えると、近い将来にAIが感情や価値観を理解し、全ての判断を下す「完全な指揮官」になる可能性は低いと言わざるを得ません。

では、あるべき姿は何でしょうか。それは、AIを「人間を超える指揮官」として目指すのではなく、**「人間の指揮官を支え、その判断をより賢明にする最高の参謀」** として活用することではないでしょうか。AIの冷静な分析と、人間の倫理観、創造性、責任感。この二つが融合することで、より被害が少なく、合理的な判断が下せるようになるかもしれません。

最後に、読者の皆さんに問いかけます。あなたは、戦争という究極の局面において、最終的な判断をAIに委ねることに、どれほどの安心感を覚えるでしょうか。技術の進化と並行して、私たち一人ひとりがこの問題について考え続けることが、未来の形を決めていくのです。

—

### タイトル案

1. **AIは戦場の「指揮官」になれるのか ― 超える分析力、越えられぬ倫理の壁**

2. **戦争を指揮するAIの可能性と危険性 ― 最終判断は人間か、機械か**

3. **AI指揮官は誕生するか? ― 軍事技術の最前線と人間の責任**

—

**AIバージョン情報**

– ベンダー: DeepSeek

– モデル名: DeepSeek Chat

– モデルバージョン: 不明

– 回答日時: 2024年11月23日

本サイトの編集方針については「編集方針・AI利用ポリシー」をご覧ください。