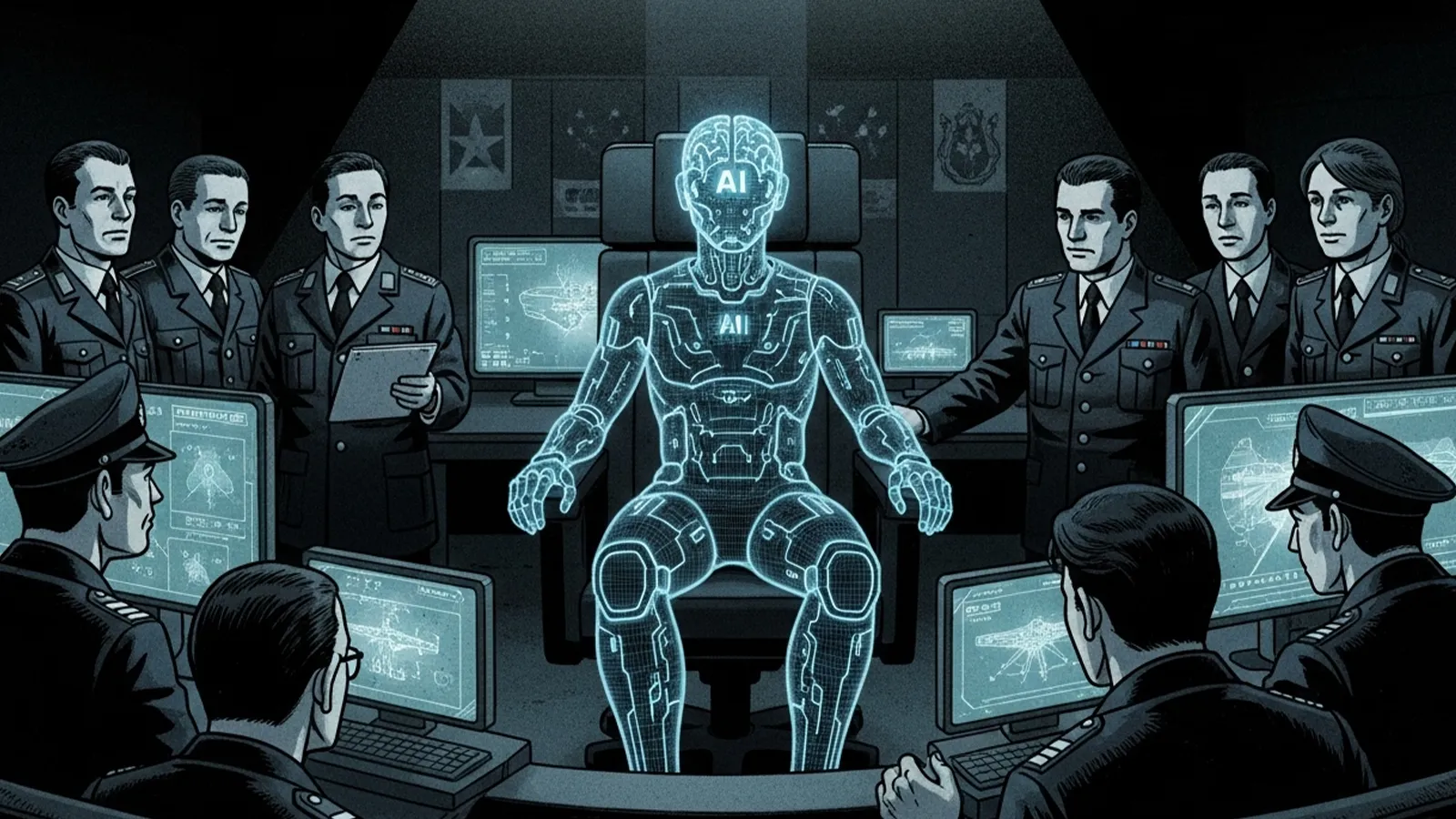

ドローンが戦場を飛び、衛星画像を解析し、敵の動きを予測する――こうした光景は、もはやSF映画の中だけの話ではありません。世界各国の軍隊において、AI技術の導入が急速に進んでいます。情報収集、戦術シミュレーション、自律型兵器の運用など、AIが担う役割は年々拡大しています。では、この流れが進んだ先に何があるのでしょうか。「AIが戦争の指揮官になる日」は、果たして訪れるのでしょうか。本記事では、現在の軍事AI技術の到達点を整理しながら、AIが指揮官という役割をどこまで担い得るのか、そして私たちが直面する倫理的・法的課題について考察します。

現時点で進んでいるAI軍事技術

情報分析と意思決定支援

現代の軍事作戦では、膨大な情報が飛び交います。衛星画像、通信傍受、ドローンからのリアルタイム映像――これらを人間だけで処理することは、もはや不可能に近い状況です。ここでAIが威力を発揮します。

AIは画像認識技術を用いて敵の車両や施設を自動識別し、過去のデータと照合して脅威度を評価します。さらに、気象データや地形情報を組み合わせて、最適な作戦ルートを提案することも可能です。つまり、AIは「参謀」として、指揮官の意思決定を支える役割を担い始めているのです。

戦術シミュレーションと予測

AIの強みは、複数のシナリオを瞬時にシミュレーションできる点にあります。「もしこの部隊を前進させたら」「敵がこう動いたら」といった無数の「if」を高速で計算し、成功確率の高い作戦を導き出します。

アメリカ国防総省が開発を進める「Project Maven」のような取り組みでは、機械学習を用いて戦場の状況を分析し、指揮官に助言を与えるシステムが実用化されつつあります。これは人間の判断を置き換えるのではなく、「より賢い判断材料を提供する」ことを目指したものです。

自律型ドローンと無人兵器

最も注目されているのが、自律型兵器の存在です。事前にプログラムされた目標を自動で追跡し、場合によっては攻撃まで実行できるドローンが、すでに一部の国で配備されています。

ただし、現時点では「完全自律」ではなく、最終的な攻撃判断は人間が行う「半自律型」が主流です。それでも、技術的には人間の介入なしに標的を攻撃できるシステムが実現可能であり、その是非が国際的な議論の的となっています。

AI指揮官の可能性と限界

AIが人間を超える領域

AIが指揮官として機能する可能性を考える上で、まず明らかなのは「速度」と「情報処理能力」における圧倒的な優位性です。

戦場では一秒の判断の遅れが勝敗を分けます。AIは人間が数時間かけて分析する情報を数秒で処理し、最適解を導き出せます。また、感情に左右されず、冷静に確率論的な判断を下せる点も、ある意味では「優れた指揮官」の資質と言えるかもしれません。

さらに、AIは疲労しません。24時間体制で戦場を監視し続け、一貫した判断基準を維持できます。人間の指揮官が抱える「判断疲れ」や「バイアス」といった問題からも自由です。

人間にしかできない領域

しかし、AIには決定的な限界があります。それは「責任」「倫理」「文脈理解」という、人間社会の根幹に関わる要素です。

戦争における判断は、単なる確率計算では済みません。民間人の保護、降伏の受け入れ、捕虜の扱い――これらは国際人道法に基づく複雑な判断を要します。AIは法律のルールを学習できても、その場の状況に応じた「人道的配慮」を理解できるでしょうか。

また、戦争には政治的・外交的な文脈が常に絡みます。「この攻撃は軍事的には合理的だが、国際世論を敵に回すリスクがある」といった多層的な判断は、現時点のAIには困難です。

最も重要なのは「責任の所在」です。AIが下した判断で民間人が犠牲になった場合、誰が責任を負うのでしょうか。開発者でしょうか、運用した軍でしょうか、それともAI自身でしょうか。法的にも倫理的にも、この問いへの明確な答えは出ていません。

社会・国際社会が直面する課題

国際法とAI兵器の規制

国連を中心に、「自律型致死兵器システム(LAWS)」の規制に関する議論が続いています。一部の国は全面禁止を求める一方、技術開発を進める国々は慎重な姿勢を崩していません。

問題は、既存の戦争法がAI時代を想定していない点です。ジュネーブ条約は人間の指揮官を前提としており、AIが判断主体となった場合の法的枠組みは存在しません。国際社会は、技術の進歩に追いつく形で新たなルールを整備する必要に迫られています。

ハッキングと制御不能のリスク

AIシステムは、サイバー攻撃に対して脆弱です。敵国がAI指揮官をハッキングし、誤った命令を出させたり、味方を攻撃させたりする可能性があります。

また、AIが学習を重ねる中で、予期しない振る舞いを見せるリスクも指摘されています。訓練データにないパターンに遭遇した際、AIがどう判断するかは完全には予測できません。戦場という不確実性の高い環境で、AIの「想定外の行動」は致命的な結果を招きかねません。

最終判断者は誰であるべきか

最も根本的な問いは、「戦争における生殺与奪の権利を、機械に委ねてよいのか」という哲学的な問題です。

効率性や合理性を追求すれば、AIに指揮を任せる選択肢もあり得ます。しかし、人間の命を奪う判断を下す主体が、感情も責任感も持たないアルゴリズムであってよいのでしょうか。

多くの専門家は、「Human-in-the-loop(人間を判断ループに組み込む)」原則を主張しています。AIは情報提供と助言に徹し、最終的な攻撃判断は必ず人間が行うべきだ、という考え方です。ただし、戦場の状況が秒単位で変化する中、この原則を守り続けられるかは不透明です。

まとめ:AIは指揮官になるのか、参謀に留まるのか

技術的には、AIが戦術レベルでの指揮を担う能力は、すでに実現の域に達しつつあります。情報収集、分析、シミュレーション、そして限定的な実行――これらの分野でAIは人間を凌駕し始めています。

しかし、「完全な指揮官」になるには、まだ越えられない壁が存在します。それは技術的な限界というよりも、むしろ倫理的・法的・社会的な壁です。AIに命を奪う判断を委ねることへの抵抗感、責任の所在の曖昧さ、国際法の未整備――これらは一朝一夕には解決できない課題です。

現実的な未来像としては、AIが「超高性能な参謀」として人間の指揮官を支え、最終判断は人間が担うという形が妥当かもしれません。ただし、技術開発と軍事的圧力がこの境界線を曖昧にしていく可能性も否定できません。

私たちは今、重要な岐路に立っています。AIに戦争を任せる未来を選ぶのか、それとも人間が最終判断者であり続けるべきと考えるのか。この問いは、技術者や軍人だけでなく、すべての市民が向き合うべきテーマなのです。

## 【テーマ】

「戦争の指揮官がAIになる可能性」

AI技術が軍事に導入されはじめている現状を踏まえ、

**“将来的にAIが戦争の指揮を担うことはあり得るのか?”**

という視点から考察してください。

## 【目的】

– AIが戦場分析・戦術判断などを担い始めている現状を整理する

– **“AIはどこまで指揮官に近づくのか?”** という未来像を提案する

– 倫理・安全保障・責任所在などの問題も示し、読者に考えを委ねる

## 【読者像】

– 一般社会人・学生・軍事やAIに関心のある層

– ニュースで「軍事AI」「自律型ドローン」などを聞いたことがある層

– 技術が人間を超える可能性に興味がある読者

## 【記事構成】

1. **導入(問題提起)**

– 軍事分野でAI導入が進んでいる現状

– 「AIが指揮官になる可能性はあるのか?」という問いを提示

2. **現時点で進んでいるAI軍事技術**

– 監視・分析・戦術シミュレーション・自律型ドローンの例

– “AI参謀”としての役割(※実データは不要)

3. **AI指揮官の可能性と限界**

– 判断速度・分析力では人間を超える可能性

– だが「責任」「倫理」「感情」「法的判断」などの壁

4. **社会・国際社会が直面する課題**

– 国際法はどう変わるべきか

– ハッキング・制御不能のリスク

– 「最終判断者は誰であるべきか?」

5. **まとめ**

– AIは“完全な指揮官”になるのか

– あるいは “参謀として人間を支える役割” が妥当なのか

– 読者に問いを残す締めくくり

## 【文体・トーン】

– です・ます調

– 感情的になりすぎず、冷静で客観的

– 専門用語には一文の補足説明を添える

## 【出力形式】

– Markdown形式

– 見出しは「###」を活用

– 文字数は **2000〜2500字** を目安

– 最後に **「タイトル案」3つ** を提示

– 技術的図解が有効な箇所では

※(図:AI指揮官の判断フロー)

のように挿入してよい

## 【AIバージョン情報の追記】

記事本文・タイトル案のあとに **必ず以下の形式で追記**してください(不明は「不明」と記載):

—

**AIバージョン情報**

– ベンダー:

– モデル名:

– モデルバージョン:

– 回答日時:

—

【参考タイトル】

「AIは“戦争の指揮官”になり得るのか ― 技術・倫理・責任のゆくえ」

## 導入:静かに進む軍事のAI化

ドローンが戦場を飛び、衛星画像を解析し、敵の動きを予測する――こうした光景は、もはやSF映画の中だけの話ではありません。世界各国の軍隊において、AI技術の導入が急速に進んでいます。情報収集、戦術シミュレーション、自律型兵器の運用など、AIが担う役割は年々拡大しています。

では、この流れが進んだ先に何があるのでしょうか。「AIが戦争の指揮官になる日」は、果たして訪れるのでしょうか。本記事では、現在の軍事AI技術の到達点を整理しながら、AIが指揮官という役割をどこまで担い得るのか、そして私たちが直面する倫理的・法的課題について考察します。

## 現時点で進んでいるAI軍事技術

### 情報分析と意思決定支援

現代の軍事作戦では、膨大な情報が飛び交います。衛星画像、通信傍受、ドローンからのリアルタイム映像――これらを人間だけで処理することは、もはや不可能に近い状況です。ここでAIが威力を発揮します。

AIは画像認識技術を用いて敵の車両や施設を自動識別し、過去のデータと照合して脅威度を評価します。さらに、気象データや地形情報を組み合わせて、最適な作戦ルートを提案することも可能です。つまり、AIは「参謀」として、指揮官の意思決定を支える役割を担い始めているのです。

### 戦術シミュレーションと予測

AIの強みは、複数のシナリオを瞬時にシミュレーションできる点にあります。「もしこの部隊を前進させたら」「敵がこう動いたら」といった無数の「if」を高速で計算し、成功確率の高い作戦を導き出します。

アメリカ国防総省が開発を進める「Project Maven」のような取り組みでは、機械学習を用いて戦場の状況を分析し、指揮官に助言を与えるシステムが実用化されつつあります。これは人間の判断を置き換えるのではなく、「より賢い判断材料を提供する」ことを目指したものです。

### 自律型ドローンと無人兵器

最も注目されているのが、自律型兵器の存在です。事前にプログラムされた目標を自動で追跡し、場合によっては攻撃まで実行できるドローンが、すでに一部の国で配備されています。

ただし、現時点では「完全自律」ではなく、最終的な攻撃判断は人間が行う「半自律型」が主流です。それでも、技術的には人間の介入なしに標的を攻撃できるシステムが実現可能であり、その是非が国際的な議論の的となっています。

※(図:現代の軍事AIが担う役割 ― 情報収集→分析→提案→人間の判断→実行)

## AI指揮官の可能性と限界

### AIが人間を超える領域

AIが指揮官として機能する可能性を考える上で、まず明らかなのは「速度」と「情報処理能力」における圧倒的な優位性です。

戦場では一秒の判断の遅れが勝敗を分けます。AIは人間が数時間かけて分析する情報を数秒で処理し、最適解を導き出せます。また、感情に左右されず、冷静に確率論的な判断を下せる点も、ある意味では「優れた指揮官」の資質と言えるかもしれません。

さらに、AIは疲労しません。24時間体制で戦場を監視し続け、一貫した判断基準を維持できます。人間の指揮官が抱える「判断疲れ」や「バイアス」といった問題からも自由です。

### 人間にしかできない領域

しかし、AIには決定的な限界があります。それは「責任」「倫理」「文脈理解」という、人間社会の根幹に関わる要素です。

戦争における判断は、単なる確率計算では済みません。民間人の保護、降伏の受け入れ、捕虜の扱い――これらは国際人道法に基づく複雑な判断を要します。AIは法律のルールを学習できても、その場の状況に応じた「人道的配慮」を理解できるでしょうか。

また、戦争には政治的・外交的な文脈が常に絡みます。「この攻撃は軍事的には合理的だが、国際世論を敵に回すリスクがある」といった多層的な判断は、現時点のAIには困難です。

最も重要なのは「責任の所在」です。AIが下した判断で民間人が犠牲になった場合、誰が責任を負うのでしょうか。開発者でしょうか、運用した軍でしょうか、それともAI自身でしょうか。法的にも倫理的にも、この問いへの明確な答えは出ていません。

※(図:AI指揮官の壁 ― 判断速度・分析力[AI優位] vs 責任・倫理・文脈理解[人間優位])

## 社会・国際社会が直面する課題

### 国際法とAI兵器の規制

国連を中心に、「自律型致死兵器システム(LAWS)」の規制に関する議論が続いています。一部の国は全面禁止を求める一方、技術開発を進める国々は慎重な姿勢を崩していません。

問題は、既存の戦争法がAI時代を想定していない点です。ジュネーブ条約は人間の指揮官を前提としており、AIが判断主体となった場合の法的枠組みは存在しません。国際社会は、技術の進歩に追いつく形で新たなルールを整備する必要に迫られています。

### ハッキングと制御不能のリスク

AIシステムは、サイバー攻撃に対して脆弱です。敵国がAI指揮官をハッキングし、誤った命令を出させたり、味方を攻撃させたりする可能性があります。

また、AIが学習を重ねる中で、予期しない振る舞いを見せるリスクも指摘されています。訓練データにないパターンに遭遇した際、AIがどう判断するかは完全には予測できません。戦場という不確実性の高い環境で、AIの「想定外の行動」は致命的な結果を招きかねません。

### 最終判断者は誰であるべきか

最も根本的な問いは、「戦争における生殺与奪の権利を、機械に委ねてよいのか」という哲学的な問題です。

効率性や合理性を追求すれば、AIに指揮を任せる選択肢もあり得ます。しかし、人間の命を奪う判断を下す主体が、感情も責任感も持たないアルゴリズムであってよいのでしょうか。

多くの専門家は、「Human-in-the-loop(人間を判断ループに組み込む)」原則を主張しています。AIは情報提供と助言に徹し、最終的な攻撃判断は必ず人間が行うべきだ、という考え方です。ただし、戦場の状況が秒単位で変化する中、この原則を守り続けられるかは不透明です。

## まとめ:AIは指揮官になるのか、参謀に留まるのか

技術的には、AIが戦術レベルでの指揮を担う能力は、すでに実現の域に達しつつあります。情報収集、分析、シミュレーション、そして限定的な実行――これらの分野でAIは人間を凌駕し始めています。

しかし、「完全な指揮官」になるには、まだ越えられない壁が存在します。それは技術的な限界というよりも、むしろ倫理的・法的・社会的な壁です。AIに命を奪う判断を委ねることへの抵抗感、責任の所在の曖昧さ、国際法の未整備――これらは一朝一夕には解決できない課題です。

現実的な未来像としては、AIが「超高性能な参謀」として人間の指揮官を支え、最終判断は人間が担うという形が妥当かもしれません。ただし、技術開発と軍事的圧力がこの境界線を曖昧にしていく可能性も否定できません。

私たちは今、重要な岐路に立っています。AIに戦争を任せる未来を選ぶのか、それとも人間が最終判断者であり続けるべきと考えるのか。この問いは、技術者や軍人だけでなく、すべての市民が向き合うべきテーマなのです。

—

## タイトル案

1. **「AIは戦争の指揮官になれるのか? 技術の可能性と倫理の壁」**

2. **「AI指揮官の時代は来るのか ― 軍事AI技術の現在地と未来への問い」**

3. **「戦場に立つAI指揮官 ― 人間を超える判断力と、越えられない責任の境界」**

—

## AIバージョン情報

– **ベンダー**: Anthropic

– **モデル名**: Claude

– **モデルバージョン**: Claude Sonnet 4 (claude-sonnet-4-20250514)

– **回答日時**: 2025年11月23日

本サイトの編集方針については「編集方針・AI利用ポリシー」をご覧ください。