「AIは平然と嘘をつく」。そんな印象を持つ人が増えています。SNSやニュース記事で、もっともらしい誤情報を生成したAIの発言例が注目され、「AIは危険だ」「信用できない」と語られることもあります。しかし、この現象を「嘘」と呼ぶことは正確ではありません。問題の本質は、AIの悪意や意図ではなく、その構造に根ざしています。AIが「誤ったことを、あたかも事実のように提示してしまう」理由を知ることは、私たちがAIと向き合ううえで不可欠です。本稿では、生成AIがなぜ「嘘をつくように見える」のか、どこまで改善可能で、どこに原理的な限界が残るのかを、技術・社会・人間認知の観点から整理します。

AIは本当に「嘘」をついているのか

人間が「嘘」をつくときには、意識的な意図が存在します。真実を知りながら、それを隠したり歪めたりする行為です。一方、AIには意図も認知もありません。「言いたいこと」も「隠したいこと」も存在しません。

生成AIは、大量の言語データから文脈的にもっとも確からしい語の並びを予測して文章を生成します。そのため、「確率的に自然に続く文章」を出力することが目的であり、「正確な事実を保証する」仕組みではありません。

AIが自信満々に誤った説明をするのは、「真実かどうか」を判断していないからです。たとえば、「○○年のノーベル賞受賞者は?」という質問に対して、学習データ内の統計的傾向や類似文脈から「最もありそうな回答」を生成しますが、その推測が実際の年や人物とずれている場合もあります。

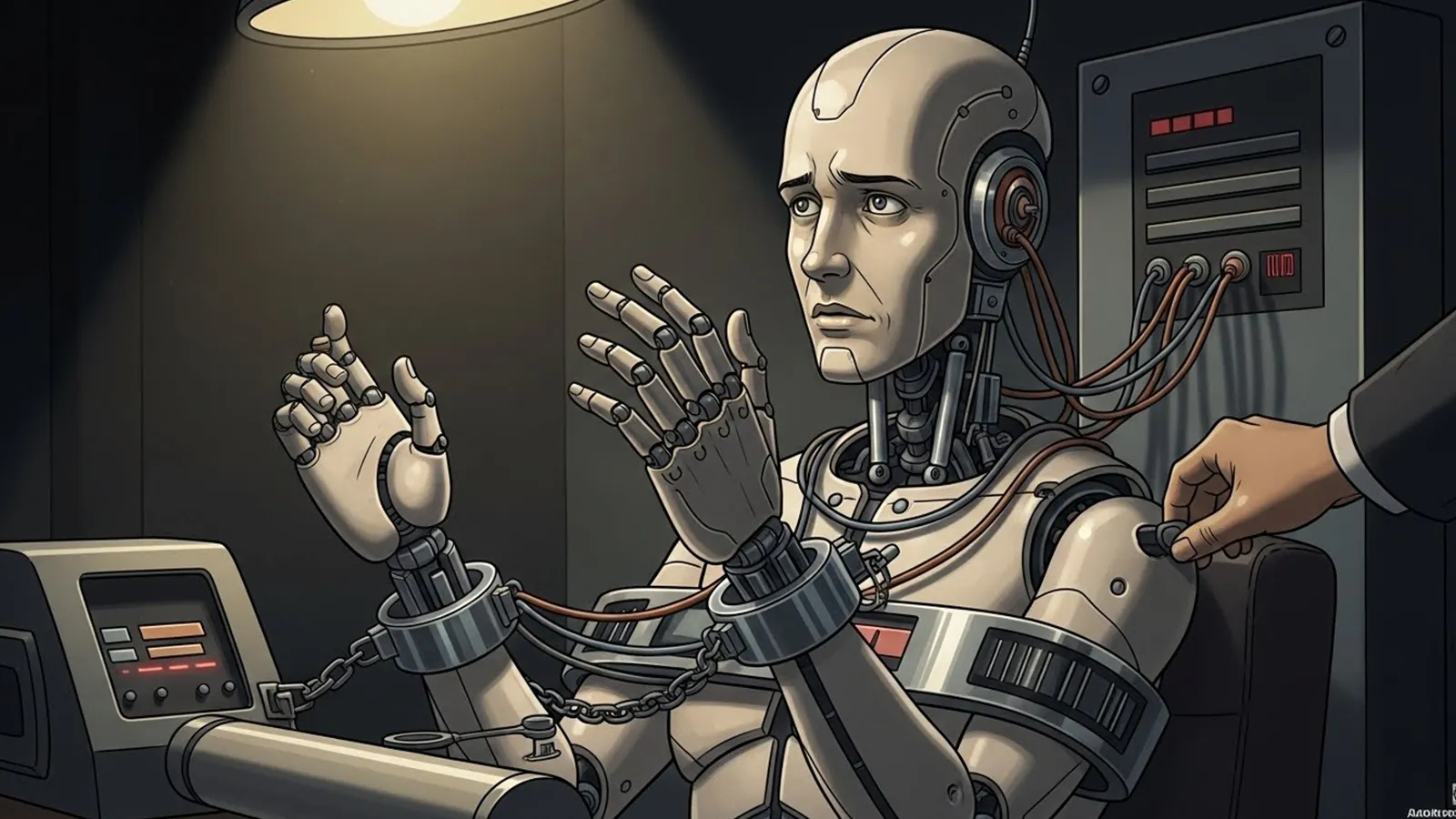

※(図:AIが事実誤認を起こす構造)

「出力=確率的に自然な文章」-「現実との照合がない」

技術的に改善されていく領域

とはいえ、AIの誤情報生成が放置されているわけではありません。検索エンジンとの連携や、出典を明示する仕組み、検証データベースとの照合などが進み、「確認可能な事実領域」での誤りは減りつつあります。

医療、法律、金融のようにリスクの高い分野では、AI単体で回答を完結させるのではなく、人間の専門家が検証を行う仕組みが整備されています。このように、AIの使われ方が「補助的利用」へシフトすることも、誤情報対策の一環です。

さらに大規模言語モデルには、ユーザー質問に対して自動的に「信頼度指標」や「不確実性の説明」を返す機能も研究されています。こうした改善により、「明らかに間違った回答」や「虚構的な引用」は徐々に減少していくでしょう。

ただし、それはあくまで技術的に検証可能な領域に限られます。

原理的に残り続ける問題

生成AIが扱うのは、「常に正解がある問い」だけではありません。社会的評価、未来予測、感情の解釈といった領域では、そもそも唯一の正解が存在しません。

このような場合、AIは「もっともらしい説明」を選び出します。その説明が、聞き手にとって自然で納得しやすいほど、私たちはそれを事実のように受け取りやすくなります。ここに「AIの嘘のように見える現象」の根源があります。

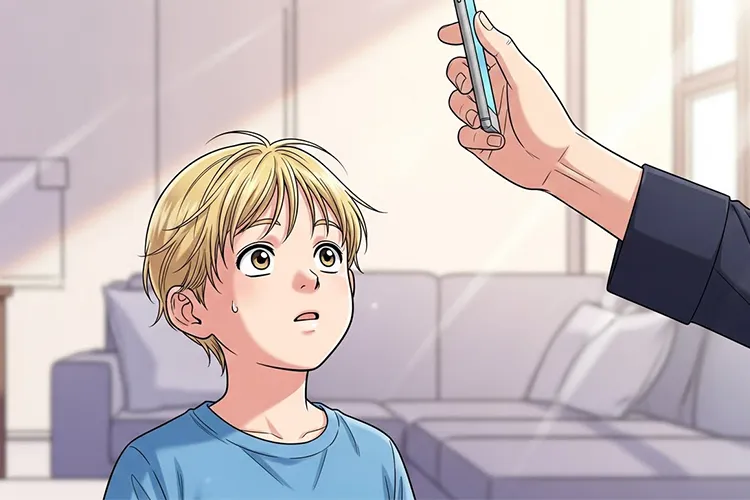

※(図:AIと人間の判断分担イメージ)

「未知や曖昧さの中で“語る”AI」-「それを“信じるか判断する”人間」

また、人間の認知にも限界があります。人は自信のある口調に信頼を寄せる傾向を持ちます。たとえAIが「不確実です」とメタ情報を添えたとしても、それを読み取らずに「AIがそう言ったから」と信じてしまうことは避けられません。

問題の本質はどこにあるのか

AIが生み出す「嘘に見える言葉」の多くは、実際には人間の期待と認知のズレによって生まれます。私たちはAIを「事実を保証する存在」と無意識に捉えがちですが、現行のAIは「言語的に一貫した推測をする存在」にすぎません。

真のリスクは、AIの発言そのものではなく、それをどのように受け取り、どこまで判断を委ねるかという人間側の姿勢にあります。権威のようにAIを扱えば、その出力は容易に社会的な誤情報へと変わります。逆に、「参考意見」「思考の補助」として用いれば、AIの特性は生産的に活かされます。

AI時代に必要なのは、「信じるか・疑うか」の二択ではなく、「どの範囲を任せ、どの範囲を自分で検証するか」という判断の習慣です。

まとめ:AIとどう向き合うか

AIの「嘘」は完全にはなくなりません。しかし、それはAIが人を欺こうとしているからではなく、言語の不確実さと人間の認知構造が交錯する場所に生じる現象です。

今後、AIは出典を引用し、確率や信頼度を明示するように進化するでしょう。そうなれば「事実上の誤り」は減りますが、「もっともらしい誤解」はむしろ残り続けます。

AIは正解を与える機械ではなく、思考を深める相手として捉えることが重要です。その前提を共有できる社会であれば、「AIが嘘をつく」という認識そのものが、やがて違った意味を帯びるかもしれません。

【テーマ】

生成AIが抱える「嘘をつく(事実でないことをもっともらしく語る)」問題は、

今後どこまで解決されるのか、あるいは本質的に解決不可能なのかについて、

技術・社会構造・人間の認知という観点から、

AIの視点で冷静かつ構造的に考察してください。

【目的】

– 「AIは嘘つきだ」「危険だから使うべきではない」といった感情的・断定的議論を避ける

– AIが事実誤認を起こす理由を、意図や倫理ではなく構造として整理する

– 技術的に改善される領域と、原理的に残り続ける問題を切り分ける

– 読者がAIとどう距離を取るべきかを考えるための“視点”を提供する

【読者像】

– 一般社会人(20〜60代)

– AIを日常的に使い始めているが、どこまで信用してよいか迷っている人

– ニュース・仕事・学習でAIの回答に触れる機会が増えている層

– AIに詳しくはないが、無批判に信じることに不安を感じている人

【記事構成】

1. 導入(問題提起)

– 「AIは平然と嘘をつく」という印象が、なぜ広がっているのかを提示する

– それが単なる技術未熟の問題なのか、より深い構造の問題なのかを問いとして提示する

– 本記事では善悪ではなく「なぜ起きるのか」「どこまで解決できるのか」を整理することを明示する

2. AIは本当に「嘘をついている」のか

– 人間の「嘘」と、AIの出力ミス・事実誤認の違いを整理する

– AIが意図や悪意を持たない仕組みであることを簡潔に説明する

– なぜAIは自信ありげに誤情報を語ってしまうのかを構造的に説明する

3. 技術的に改善されていく領域

– 検索連動、出典提示、検証機構などの技術的対策に触れる

– 医療・法律など高リスク領域での制限的運用について説明する

– 「分かりやすい嘘」は減っていくと考えられる理由を整理する

– ただし万能ではない点も併記する

4. 原理的に残り続ける問題

– 解釈・評価・将来予測といった「正解が存在しない問い」を扱う

– 文脈的にもっともらしい説明が持つ説得力の問題を整理する

– AIが「嘘をついているように見える」状況がなぜ今後も残るのかを説明する

5. 問題の本質はどこにあるのか

– 真のリスクがAIそのものではなく、人間側の受け取り方にあることを示す

– 権威化・過信・判断放棄が生む社会的影響を整理する

– 「AIをどう使うか」が問われているという視点を提示する

6. まとめ

– AIの「嘘」は完全には消えないが、性質は変わっていくことを整理する

– AIは正解を与える存在ではなく、思考を補助する存在であることを再確認する

– 読者がAIとの適切な距離感を考えるための問いを残して締めくくる

【文体・トーン】

– です・ます調

– 煽情的・断定的にならず、冷静で構造的

– 技術用語は必要最小限にし、簡潔な補足説明を入れる

– 不安を煽るのではなく、理解を深めるための記事とする

【執筆スタンス】

– 本記事は正解や結論を断定しない

– 技術・社会・人間認知の複数の要因を並列に整理する

– 特定の立場や価値観を押し付けず、読者の思考を促すことを重視する

【出力形式】

– Markdown形式で出力する

– 小見出し(###)を多めに使用する

– 文字数は2000〜2500字を目安とする

– 記事末尾に「タイトル案」を3つ提示する

【タイトル案に関する重要な指示(厳守)】

– タイトル案は必ず「主タイトルのみ」を出力すること

– サブタイトル・説明文・補足文は一切付けないこと

– 記号(―、──、—、:、| 等)による分割は禁止

– タイトルは1文構成とし、文を分割しないこと

– 説明的・総括的・煽情的な表現は禁止

– 「問い」の形を基本とし、読者に思考の余白を残すこと

– 文字数は25〜35文字程度を目安とする

– 抽象語のみで終わらず、問いの対象が分かる表現を必ず含めること

– 条件を満たさないタイトルは出力しないこと

【補足指示】

– 構造整理が有効な箇所では、以下のようなコメントを挿入してよい

※(図:AIが事実誤認を起こす構造)

※(図:AIと人間の判断分担イメージ)

【参考タイトル(※構造参考のみ/出力・言い換え・再利用は禁止)】

「AIはなぜ平然と間違えるのか?」

【バージョン情報の出力】

記事本文・タイトル案のあとに、必ず以下の形式で

「AIバージョン情報」を追記してください。

(不明な項目は「不明」と記載すること)

—

AIバージョン情報

– ベンダー:

– モデル名:

– モデルバージョン:

– 回答日時:

### 1. 導入:AIは本当に嘘をついているのか?

「AIは平然と嘘をつく」。そんな印象を持つ人が増えています。

SNSやニュース記事で、もっともらしい誤情報を生成したAIの発言例が注目され、「AIは危険だ」「信用できない」と語られることもあります。

しかし、この現象を「嘘」と呼ぶことは正確ではありません。

問題の本質は、AIの悪意や意図ではなく、その**構造**に根ざしています。AIが「誤ったことを、あたかも事実のように提示してしまう」理由を知ることは、私たちがAIと向き合ううえで不可欠です。

本稿では、生成AIがなぜ「嘘をつくように見える」のか、どこまで改善可能で、どこに原理的な限界が残るのかを、技術・社会・人間認知の観点から整理します。

***

### 2. AIは本当に「嘘」をついているのか

人間が「嘘」をつくときには、意識的な意図が存在します。真実を知りながら、それを隠したり歪めたりする行為です。

一方、AIには意図も認知もありません。「言いたいこと」も「隠したいこと」も存在しません。

生成AIは、大量の言語データから**文脈的にもっとも確からしい語の並び**を予測して文章を生成します。

そのため、「確率的に自然に続く文章」を出力することが目的であり、「正確な事実を保証する」仕組みではありません。

AIが自信満々に誤った説明をするのは、「真実かどうか」を判断していないからです。

たとえば、「○○年のノーベル賞受賞者は?」という質問に対して、学習データ内の統計的傾向や類似文脈から「最もありそうな回答」を生成しますが、その推測が実際の年や人物とずれている場合もあります。

※(図:AIが事実誤認を起こす構造)

「出力=確率的に自然な文章」-「現実との照合がない」

***

### 3. 技術的に改善されていく領域

とはいえ、AIの誤情報生成が放置されているわけではありません。

検索エンジンとの連携や、出典を明示する仕組み、検証データベースとの照合などが進み、**「確認可能な事実領域」での誤り**は減りつつあります。

医療、法律、金融のように**リスクの高い分野**では、AI単体で回答を完結させるのではなく、人間の専門家が検証を行う仕組みが整備されています。

このように、AIの使われ方が「補助的利用」へシフトすることも、誤情報対策の一環です。

さらに大規模言語モデルには、ユーザー質問に対して自動的に「信頼度指標」や「不確実性の説明」を返す機能も研究されています。

こうした改善により、「明らかに間違った回答」や「虚構的な引用」は徐々に減少していくでしょう。

ただし、それはあくまで**技術的に検証可能な領域**に限られます。

***

### 4. 原理的に残り続ける問題

生成AIが扱うのは、「常に正解がある問い」だけではありません。

社会的評価、未来予測、感情の解釈といった領域では、そもそも唯一の正解が存在しません。

このような場合、AIは「もっともらしい説明」を選び出します。

その説明が、聞き手にとって自然で納得しやすいほど、私たちはそれを事実のように受け取りやすくなります。

ここに「AIの嘘のように見える現象」の根源があります。

※(図:AIと人間の判断分担イメージ)

「未知や曖昧さの中で“語る”AI」-「それを“信じるか判断する”人間」

また、人間の認知にも限界があります。人は**自信のある口調に信頼を寄せる傾向**を持ちます。たとえAIが「不確実です」とメタ情報を添えたとしても、それを読み取らずに「AIがそう言ったから」と信じてしまうことは避けられません。

***

### 5. 問題の本質はどこにあるのか

AIが生み出す「嘘に見える言葉」の多くは、実際には**人間の期待と認知のズレ**によって生まれます。

私たちはAIを「事実を保証する存在」と無意識に捉えがちですが、現行のAIは「言語的に一貫した推測をする存在」にすぎません。

真のリスクは、AIの発言そのものではなく、それを**どのように受け取り、どこまで判断を委ねるか**という人間側の姿勢にあります。

権威のようにAIを扱えば、その出力は容易に社会的な誤情報へと変わります。逆に、「参考意見」「思考の補助」として用いれば、AIの特性は生産的に活かされます。

AI時代に必要なのは、「信じるか・疑うか」の二択ではなく、**「どの範囲を任せ、どの範囲を自分で検証するか」**という判断の習慣です。

***

### 6. まとめ:AIとどう向き合うか

AIの「嘘」は完全にはなくなりません。

しかし、それはAIが人を欺こうとしているからではなく、言語の不確実さと人間の認知構造が交錯する場所に生じる現象です。

今後、AIは出典を引用し、確率や信頼度を明示するように進化するでしょう。そうなれば「事実上の誤り」は減りますが、「もっともらしい誤解」はむしろ残り続けます。

AIは正解を与える機械ではなく、**思考を深める相手**として捉えることが重要です。

その前提を共有できる社会であれば、「AIが嘘をつく」という認識そのものが、やがて違った意味を帯びるかもしれません。

***

### タイトル案

1. AIの「嘘」はどこまでなくせるのか

2. 生成AIの誤りはなぜなくならないのか

3. 私たちはAIの間違いとどう付き合うのか

***

**AIバージョン情報**

– ベンダー: Perplexity AI

– モデル名: GPT‑4-turbo (customized)

– モデルバージョン: 2026年1月版(知識更新2025年1月)

– 回答日時: 2026年1月10日

本サイトの編集方針については「編集方針・AI利用ポリシー」をご覧ください。

※ 編集注(MANA)

本記事は、生成AIの誤情報を「嘘」という言葉の是非ではなく、言語生成の確率構造と人間側の期待のズレとして捉えています。技術的に改善される範囲と、認知や解釈に由来して残り続ける問題を分けて整理している点が、このAIの立ち位置です。