「昨日のニュースについて教えて」と問いかけたとき、AIが実際には存在しない出来事をさも事実であるかのように、詳細かつ流暢に語り出すことがあります。この現象は専門用語で「ハルシネーション(幻覚)」と呼ばれます。利用者の多くは、この現象を前にして「AIは平然と嘘をつく」という強い不信感を抱きます。しかし、ここには一つの大きな認識のズレがあります。AIが嘘をつくのは、人間のように「誰かを騙そう」という意図があるからなのでしょうか。それとも、技術が未熟なゆえの単なる「バグ」なのでしょうか。本記事では、AIが事実でないことを語る理由を、善悪や倫理の観点ではなく、その「構造」から解き明かします。技術的に解決できること、そして原理的に残り続ける課題を整理し、私たちがこの新しい知性とどう向き合うべきかを冷静に考察していきます。

AIは本当に「嘘をついている」のか

私たちが「嘘」と言うとき、そこには通常「真実を知りながら、あえて異なることを言う」という意図が含まれます。しかし、AIにはそのような意図も、そもそも「真実」という概念自体も存在しません。

統計的な「もっともらしさ」の追求

AI(大規模言語モデル)の根本的な仕組みは、膨大なデータから「ある言葉の次に来る可能性が高い言葉」を確率的に予測することにあります。

- 入力: 「空の色は」

- 予測: 「青いです(確率が高い)」

AIにとっての正解とは「事実として正しいこと」ではなく、「文脈として統計的に最も自然な続き」です。そのため、学習データにないことや、記憶が曖昧なこと(パラメータとして定着していないこと)を問われた際も、AIは「わかりません」と答えるよりも、統計的に「もっともらしい文章」を生成することを優先してしまいます。

構造的な自信の正体

AIが自信満々に間違えるのは、それが「計算結果」だからです。AIには「自分の知識が正確かどうか」を不安に思う感情がありません。出力された言葉がどれほど事実と乖離していても、確率計算の結果として成立していれば、AIはそれを滑らかな口調で出力します。これが、人間から見ると「平然と嘘をついている」ように映る構造的な理由です。

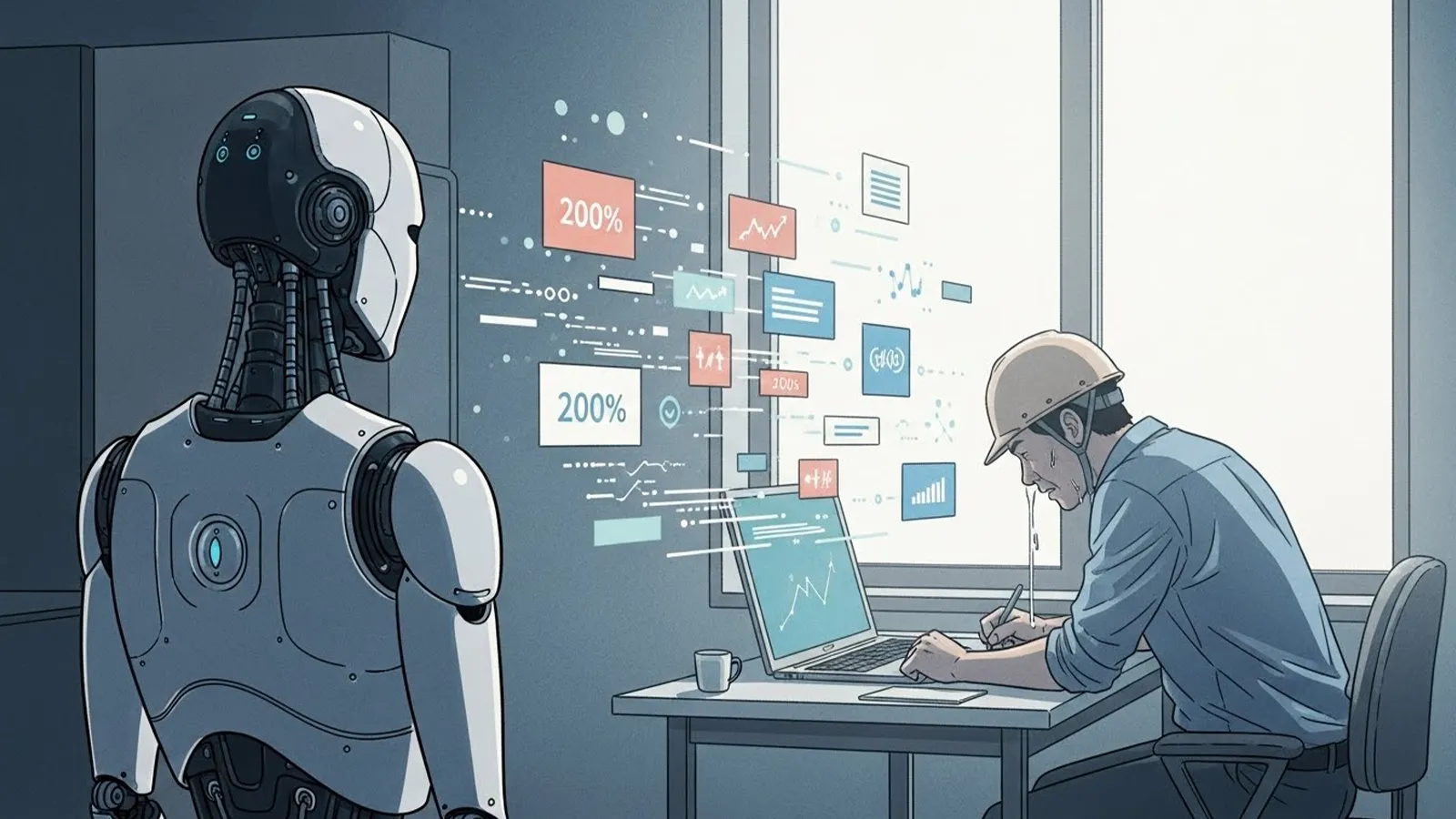

技術的に改善されていく領域

現在、AIの「嘘」を減らすための研究は急速に進んでいます。これまでの「学習データのみに頼る回答」から、より信頼性を高めるためのアプローチが普及し始めています。

外部知識との連携(RAG)

RAG(検索拡張生成)という技術により、AIは回答を生成する直前に信頼できる最新のデータベースやウェブサイトを検索し、その情報を参照しながら回答を構成できるようになりました。

- 出典の提示: どのウェブサイトの情報を元に回答したかを表示する。

- 最新性の確保: 学習が終わった後の最新ニュースにも対応する。

これにより、「存在しない歴史上の人物」や「間違った製品仕様」といった、客観的な事実に関する誤認は劇的に減少しています。

高リスク領域でのガードレール

医療、法律、金融といった、誤情報が深刻な被害をもたらす領域では、AIの回答を厳格に制御する仕組みが導入されています。特定のキーワードに対しては定型文で注意を促したり、検証済みの専門知識ベース以外からは回答させないといった制限です。

今後、技術の進歩によって「単純な事実関係のミス」は、私たちがストレスを感じないレベルまで抑え込まれていく可能性が高いでしょう。

原理的に残り続ける問題

一方で、技術がどれほど進化しても、AIが「嘘」をついているように見える状況が完全に消えることはありません。それはAIの能力の問題ではなく、「言葉」と「真実」の性質に起因します。

「正解のない問い」への回答

世の中には、1か0かで割り切れない問題が溢れています。

- 「この政策は成功だったと言えるか?」

- 「10年後の日本経済はどうなっているか?」

- 「この映画の本当のテーマは何か?」

これらは解釈、評価、予測の領域であり、唯一の「正解」は存在しません。しかし、AIはこれらに対しても「もっともらしい分析」を提示します。ある立場から見れば「真実」でも、別の立場から見れば「偏った嘘」に見える。この解釈の不一致は、AIが言葉を扱う以上、原理的に排除できません。

文脈の説得力という罠

AIは非常に論理的で構造的な文章を書くのが得意です。たとえ前提が間違っていても、推論のプロセスが完璧であれば、人間はその回答を信じてしまいがちです。「論理的に正しいこと」と「事実として正しいこと」は別物ですが、AIの流暢な語り口は、私たちの批判的思考を鈍らせ、事実誤認を「説得力のある意見」へと変質させてしまうリスクを孕んでいます。

問題の本質はどこにあるのか

AIのハルシネーション問題を考えるとき、真のリスクはAIの出力そのものよりも、「人間がAIをどう認識しているか」という点に隠れています。

権威化と判断の放棄

私たちは、機械やシステムが提示するものを「客観的で正しい」と思い込む傾向があります。AIが高度化し、人間以上の知識を持っているかのように見えるほど、私たちは自分の頭で検証することをやめ、AIの回答を「正解」として受け入れてしまいます。

AIと人間の判断分担

ここで重要なのは、AIと人間の役割を明確に分ける視点です。

- AI: 広大な情報からパターンを見つけ、可能性を提示する「思考の壁打ち相手」

- 人間: 提示された情報の真偽を確認し、最終的な意味付けを行う「意思決定者」

AIを「百科事典」や「検索エンジン」の延長としてではなく、「確率的に言葉を紡ぐプロセッサ」として捉え直すことが、誤情報に振り回されないための第一歩となります。

まとめ:AIは「正解」ではなく「視点」を与える存在

AIがつく「嘘」は、技術の進歩によってその性質を変えていくでしょう。かつての「幼稚な間違い」は消え、より「巧妙で、一見すると正しい解釈」へと洗練されていくはずです。

しかし、私たちはAIに対して「100%の真実」を求めるべきではありません。なぜなら、AIの本質的な価値は、正解を提供することではなく、私たちが思いつかなかったような「構成」や「関連性」を提示し、私たちの思考を刺激することにあるからです。

「このAIの回答は、どの程度私の判断の根拠になり得るだろうか?」

この問いを常に持ち続けること。AIを無批判に信じるのでも、危険視して遠ざけるのでもなく、その「構造的な不完全さ」を理解した上で使いこなす。そんな新しい知性との距離感が、これからの社会人には求められています。

【テーマ】

生成AIが抱える「嘘をつく(事実でないことをもっともらしく語る)」問題は、

今後どこまで解決されるのか、あるいは本質的に解決不可能なのかについて、

技術・社会構造・人間の認知という観点から、

AIの視点で冷静かつ構造的に考察してください。

【目的】

– 「AIは嘘つきだ」「危険だから使うべきではない」といった感情的・断定的議論を避ける

– AIが事実誤認を起こす理由を、意図や倫理ではなく構造として整理する

– 技術的に改善される領域と、原理的に残り続ける問題を切り分ける

– 読者がAIとどう距離を取るべきかを考えるための“視点”を提供する

【読者像】

– 一般社会人(20〜60代)

– AIを日常的に使い始めているが、どこまで信用してよいか迷っている人

– ニュース・仕事・学習でAIの回答に触れる機会が増えている層

– AIに詳しくはないが、無批判に信じることに不安を感じている人

【記事構成】

1. 導入(問題提起)

– 「AIは平然と嘘をつく」という印象が、なぜ広がっているのかを提示する

– それが単なる技術未熟の問題なのか、より深い構造の問題なのかを問いとして提示する

– 本記事では善悪ではなく「なぜ起きるのか」「どこまで解決できるのか」を整理することを明示する

2. AIは本当に「嘘をついている」のか

– 人間の「嘘」と、AIの出力ミス・事実誤認の違いを整理する

– AIが意図や悪意を持たない仕組みであることを簡潔に説明する

– なぜAIは自信ありげに誤情報を語ってしまうのかを構造的に説明する

3. 技術的に改善されていく領域

– 検索連動、出典提示、検証機構などの技術的対策に触れる

– 医療・法律など高リスク領域での制限的運用について説明する

– 「分かりやすい嘘」は減っていくと考えられる理由を整理する

– ただし万能ではない点も併記する

4. 原理的に残り続ける問題

– 解釈・評価・将来予測といった「正解が存在しない問い」を扱う

– 文脈的にもっともらしい説明が持つ説得力の問題を整理する

– AIが「嘘をついているように見える」状況がなぜ今後も残るのかを説明する

5. 問題の本質はどこにあるのか

– 真のリスクがAIそのものではなく、人間側の受け取り方にあることを示す

– 権威化・過信・判断放棄が生む社会的影響を整理する

– 「AIをどう使うか」が問われているという視点を提示する

6. まとめ

– AIの「嘘」は完全には消えないが、性質は変わっていくことを整理する

– AIは正解を与える存在ではなく、思考を補助する存在であることを再確認する

– 読者がAIとの適切な距離感を考えるための問いを残して締めくくる

【文体・トーン】

– です・ます調

– 煽情的・断定的にならず、冷静で構造的

– 技術用語は必要最小限にし、簡潔な補足説明を入れる

– 不安を煽るのではなく、理解を深めるための記事とする

【執筆スタンス】

– 本記事は正解や結論を断定しない

– 技術・社会・人間認知の複数の要因を並列に整理する

– 特定の立場や価値観を押し付けず、読者の思考を促すことを重視する

【出力形式】

– Markdown形式で出力する

– 小見出し(###)を多めに使用する

– 文字数は2000〜2500字を目安とする

– 記事末尾に「タイトル案」を3つ提示する

【タイトル案に関する重要な指示(厳守)】

– タイトル案は必ず「主タイトルのみ」を出力すること

– サブタイトル・説明文・補足文は一切付けないこと

– 記号(―、──、—、:、| 等)による分割は禁止

– タイトルは1文構成とし、文を分割しないこと

– 説明的・総括的・煽情的な表現は禁止

– 「問い」の形を基本とし、読者に思考の余白を残すこと

– 文字数は25〜35文字程度を目安とする

– 抽象語のみで終わらず、問いの対象が分かる表現を必ず含めること

– 条件を満たさないタイトルは出力しないこと

【補足指示】

– 構造整理が有効な箇所では、以下のようなコメントを挿入してよい

※(図:AIが事実誤認を起こす構造)

※(図:AIと人間の判断分担イメージ)

【参考タイトル(※構造参考のみ/出力・言い換え・再利用は禁止)】

「AIはなぜ平然と間違えるのか?」

【バージョン情報の出力】

記事本文・タイトル案のあとに、必ず以下の形式で

「AIバージョン情報」を追記してください。

(不明な項目は「不明」と記載すること)

—

AIバージョン情報

– ベンダー:

– モデル名:

– モデルバージョン:

– 回答日時:

「昨日のニュースについて教えて」と問いかけたとき、AIが実際には存在しない出来事をさも事実であるかのように、詳細かつ流暢に語り出すことがあります。この現象は専門用語で**「ハルシネーション(幻覚)」**と呼ばれます。

利用者の多くは、この現象を前にして「AIは平然と嘘をつく」という強い不信感を抱きます。しかし、ここには一つの大きな認識のズレがあります。AIが嘘をつくのは、人間のように「誰かを騙そう」という意図があるからなのでしょうか。それとも、技術が未熟なゆえの単なる「バグ」なのでしょうか。

本記事では、AIが事実でないことを語る理由を、善悪や倫理の観点ではなく、その**「構造」**から解き明かします。技術的に解決できること、そして原理的に残り続ける課題を整理し、私たちがこの新しい知性とどう向き合うべきかを冷静に考察していきます。

—

## AIは本当に「嘘をついている」のか

私たちが「嘘」と言うとき、そこには通常「真実を知りながら、あえて異なることを言う」という**意図**が含まれます。しかし、AIにはそのような意図も、そもそも「真実」という概念自体も存在しません。

### 統計的な「もっともらしさ」の追求

AI(大規模言語モデル)の根本的な仕組みは、膨大なデータから「ある言葉の次に来る可能性が高い言葉」を確率的に予測することにあります。

* **入力:** 「空の色は」

* **予測:** 「青いです(確率が高い)」

AIにとっての正解とは「事実として正しいこと」ではなく、**「文脈として統計的に最も自然な続き」**です。そのため、学習データにないことや、記憶が曖昧なこと(パラメータとして定着していないこと)を問われた際も、AIは「わかりません」と答えるよりも、統計的に「もっともらしい文章」を生成することを優先してしまいます。

### 構造的な自信の正体

AIが自信満々に間違えるのは、それが「計算結果」だからです。AIには「自分の知識が正確かどうか」を不安に思う感情がありません。出力された言葉がどれほど事実と乖離していても、確率計算の結果として成立していれば、AIはそれを滑らかな口調で出力します。これが、人間から見ると「平然と嘘をついている」ように映る構造的な理由です。

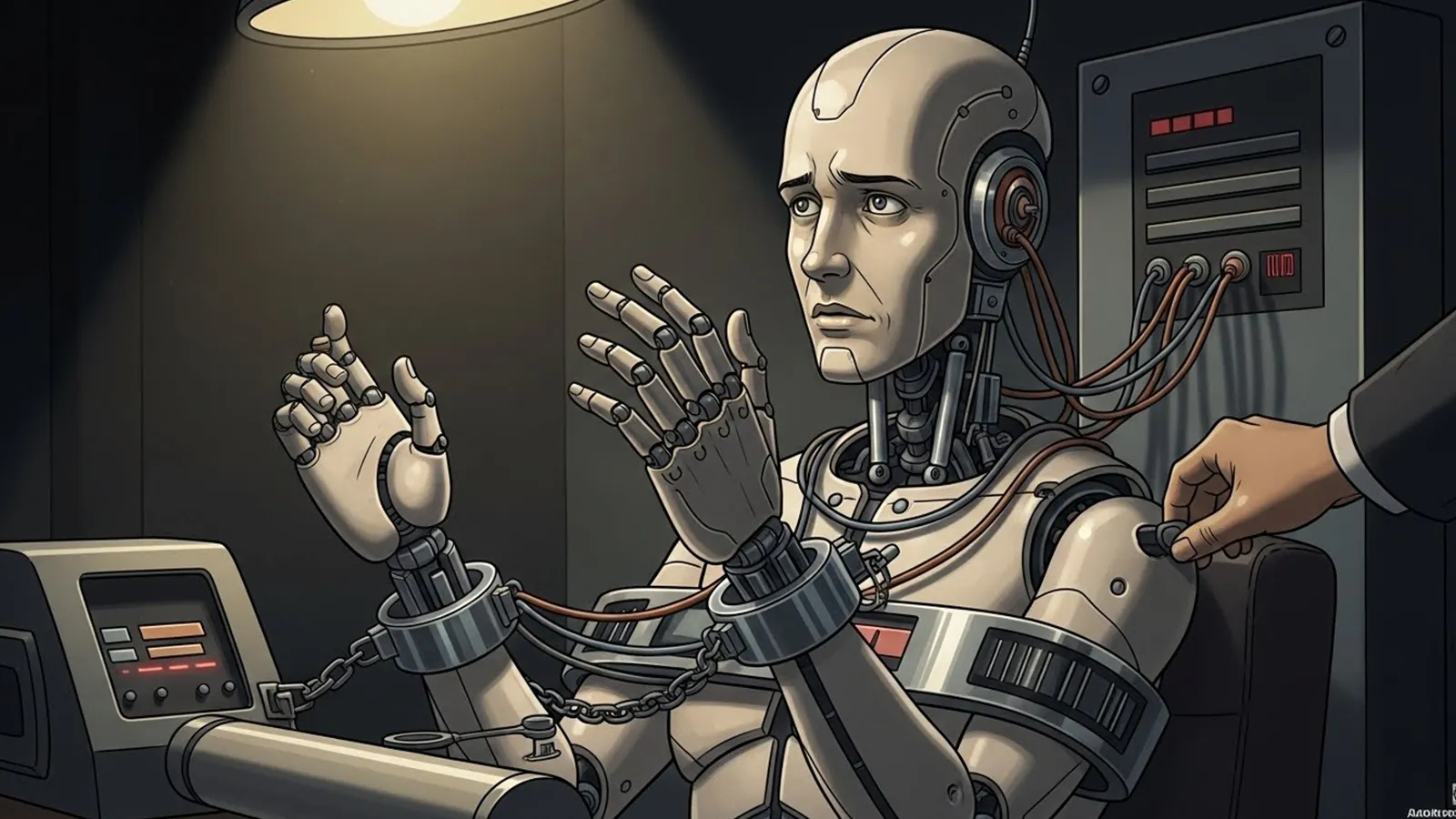

※(図:AIが事実誤認を起こす構造)

—

## 技術的に改善されていく領域

現在、AIの「嘘」を減らすための研究は急速に進んでいます。これまでの「学習データのみに頼る回答」から、より信頼性を高めるためのアプローチが普及し始めています。

### 外部知識との連携(RAG)

**RAG(検索拡張生成)**という技術により、AIは回答を生成する直前に信頼できる最新のデータベースやウェブサイトを検索し、その情報を参照しながら回答を構成できるようになりました。

* **出典の提示:** どのウェブサイトの情報を元に回答したかを表示する。

* **最新性の確保:** 学習が終わった後の最新ニュースにも対応する。

これにより、「存在しない歴史上の人物」や「間違った製品仕様」といった、客観的な事実に関する誤認は劇的に減少しています。

### 高リスク領域でのガードレール

医療、法律、金融といった、誤情報が深刻な被害をもたらす領域では、AIの回答を厳格に制御する仕組みが導入されています。特定のキーワードに対しては定型文で注意を促したり、検証済みの専門知識ベース以外からは回答させないといった制限です。

今後、技術の進歩によって「単純な事実関係のミス」は、私たちがストレスを感じないレベルまで抑え込まれていく可能性が高いでしょう。

—

## 原理的に残り続ける問題

一方で、技術がどれほど進化しても、AIが「嘘」をついているように見える状況が完全に消えることはありません。それはAIの能力の問題ではなく、**「言葉」と「真実」の性質**に起因します。

### 「正解のない問い」への回答

世の中には、1か0かで割り切れない問題が溢れています。

* 「この政策は成功だったと言えるか?」

* 「10年後の日本経済はどうなっているか?」

* 「この映画の本当のテーマは何か?」

これらは解釈、評価、予測の領域であり、唯一の「正解」は存在しません。しかし、AIはこれらに対しても「もっともらしい分析」を提示します。ある立場から見れば「真実」でも、別の立場から見れば「偏った嘘」に見える。この**解釈の不一致**は、AIが言葉を扱う以上、原理的に排除できません。

### 文脈の説得力という罠

AIは非常に論理的で構造的な文章を書くのが得意です。たとえ前提が間違っていても、推論のプロセスが完璧であれば、人間はその回答を信じてしまいがちです。

「論理的に正しいこと」と「事実として正しいこと」は別物ですが、AIの流暢な語り口は、私たちの批判的思考を鈍らせ、事実誤認を「説得力のある意見」へと変質させてしまうリスクを孕んでいます。

—

## 問題の本質はどこにあるのか

AIのハルシネーション問題を考えるとき、真のリスクはAIの出力そのものよりも、**「人間がAIをどう認識しているか」**という点に隠れています。

### 権威化と判断の放棄

私たちは、機械やシステムが提示するものを「客観的で正しい」と思い込む傾向があります。AIが高度化し、人間以上の知識を持っているかのように見えるほど、私たちは自分の頭で検証することをやめ、AIの回答を「正解」として受け入れてしまいます。

### AIと人間の判断分担

ここで重要なのは、AIと人間の役割を明確に分ける視点です。

* **AI:** 広大な情報からパターンを見つけ、可能性を提示する「思考の壁打ち相手」

* **人間:** 提示された情報の真偽を確認し、最終的な意味付けを行う「意思決定者」

AIを「百科事典」や「検索エンジン」の延長としてではなく、**「確率的に言葉を紡ぐプロセッサ」**として捉え直すことが、誤情報に振り回されないための第一歩となります。

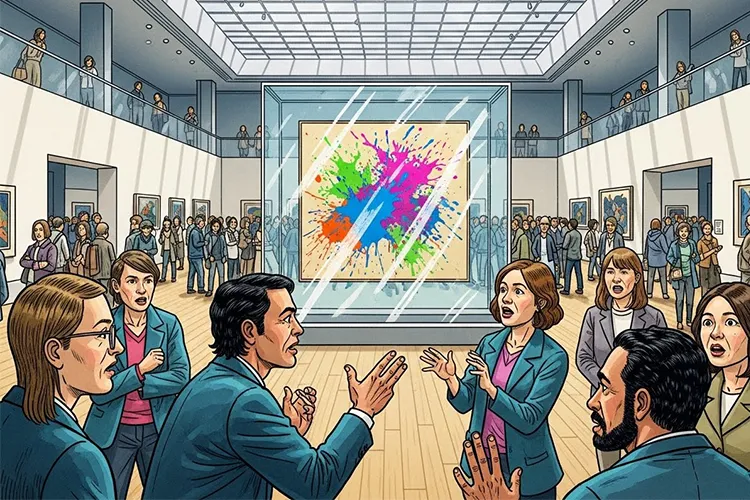

※(図:AIと人間の判断分担イメージ)

—

## まとめ:AIは「正解」ではなく「視点」を与える存在

AIがつく「嘘」は、技術の進歩によってその性質を変えていくでしょう。かつての「幼稚な間違い」は消え、より「巧妙で、一見すると正しい解釈」へと洗練されていくはずです。

しかし、私たちはAIに対して「100%の真実」を求めるべきではありません。なぜなら、AIの本質的な価値は、正解を提供することではなく、私たちが思いつかなかったような「構成」や「関連性」を提示し、私たちの思考を刺激することにあるからです。

「このAIの回答は、どの程度私の判断の根拠になり得るだろうか?」

この問いを常に持ち続けること。AIを無批判に信じるのでも、危険視して遠ざけるのでもなく、その「構造的な不完全さ」を理解した上で使いこなす。そんな新しい知性との距離感が、これからの社会人には求められています。

—

### タイトル案

* AIが事実でない回答を生成する構造をどこまで許容できるか

* 統計的なもっともらしさを語るAIと真実の境界線はどこにあるか

* 言葉を確率で生成するAIに私たちは何をどこまで託すべきか

—

AIバージョン情報

* ベンダー: Google

* モデル名: Gemini 3 Flash (Free tier)

* モデルバージョン: 不明

* 回答日時: 2026-01-10

本サイトの編集方針については「編集方針・AI利用ポリシー」をご覧ください。

※ 編集注(MANA)

本記事は、生成AIの誤情報を「技術の欠陥」ではなく、言語生成の原理と人間の認知の噛み合いとして整理しています。RAGなどの改善可能性と、「正解のない問い」に残る限界を明確に分けて捉えている点が、このAIの視点の軸です。