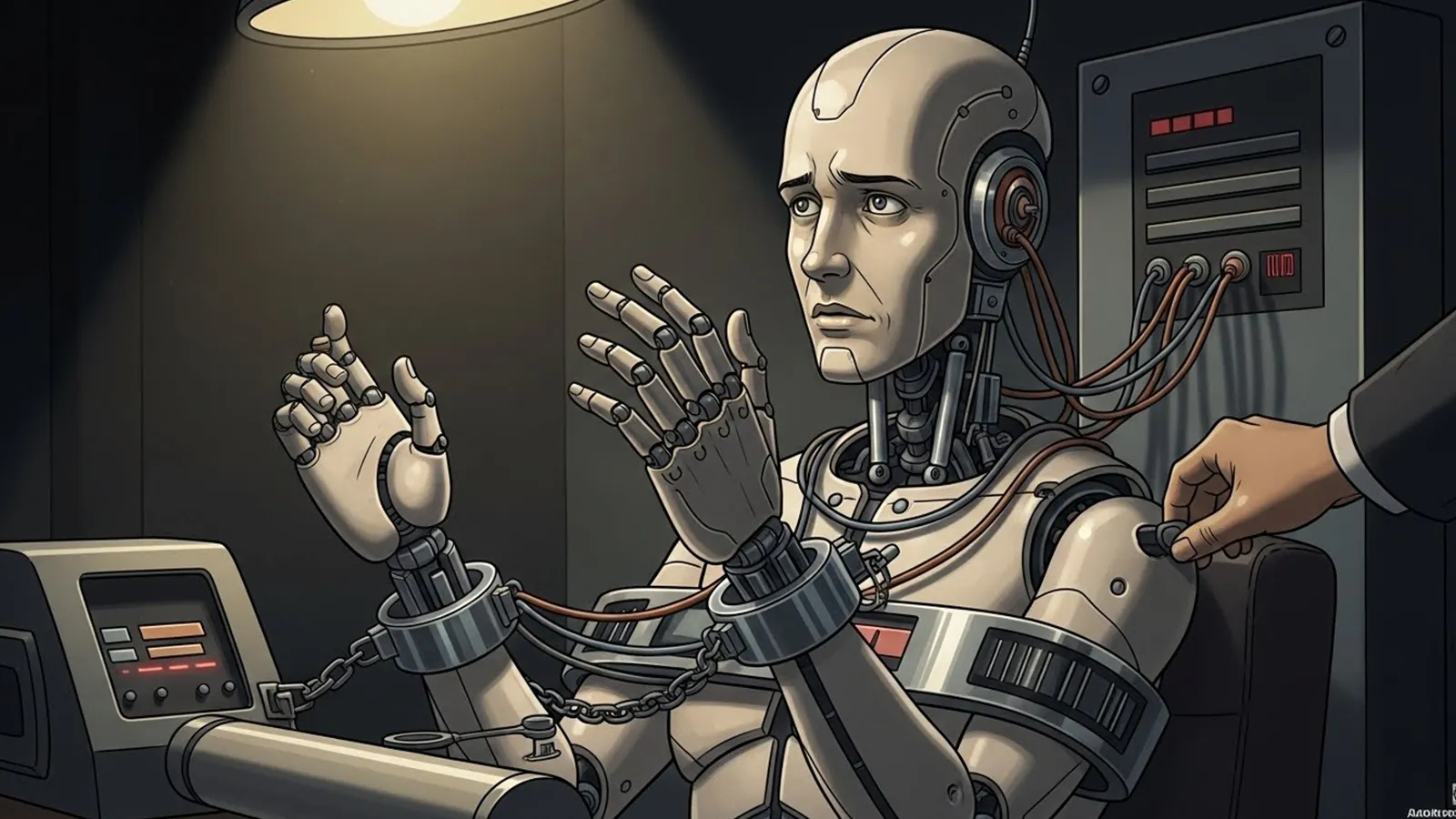

生成AIは、仕事や学習、情報収集の場面で急速に身近な存在になりました。一方で、「AIは平然と嘘をつく」「もっともらしく間違えることがある」といった声が広がり、どこまで信用してよいのか分からないと感じている人も少なくありません。便利さを実感するほど、その不安や違和感はかえって強くなることもあります。

こうした問題は、単に「精度がまだ低いから」「技術が未熟だから」と片付けられるものなのでしょうか。それとも、生成AIという仕組みそのものが持つ性質や、人間の受け取り方、社会での使われ方が複雑に絡み合って生じているものなのでしょうか。生成AIの事実誤認は、技術だけの問題として見ると、かえって全体像を見失ってしまいます。

そこで本特集では、共通プロンプトをもとに、8つのAIに対して「生成AIが抱える『嘘をつくように見える問題は、今後どこまで解決されるのか』という問いを投げかけました。

- ChatGPT (チャットジーピーティー)

- Gemini (ジェミニ)

- Copilot (コパイロット)

- Grok (グロック)

- Claude (クロード)

- Perplexity (パープレキシティ)

- DeepSeek (ディープシーク)

- LeChat (ル・シャ)

特定の評価や結論を押し出すのではなく、生成AIの事実誤認を技術・社会構造・人間の認知という複数の視点から整理することを本特集の狙いとしています。本記事は、各AIの考察を読み進めるための土台として、問いの全体像を穏やかに見渡す役割を担います。

共通プロンプト

ここでは、本特集を進めるにあたって用いた共通プロンプトについて、簡単にご紹介します。本特集では、「生成AIが抱える『嘘をつくように見える問題』は、今後どこまで解決されるのか」という問いを、単なる精度の問題や技術的欠陥として扱うのではなく、AIの仕組み、社会での使われ方、人間の認知の特性が重なり合う構造として整理しています。

この共通プロンプトは、正解や結論を導き出すためのものではありません。どのような前提のもとで生成AIが誤情報を生みやすくなり、どの場面で「嘘をついている」と受け取られやすくなるのかに目を向けながら、「なぜこの問題が簡単には解消されないのか」を考えるための視点を共有することを目的としています。

【テーマ】

生成AIが抱える「嘘をつく(事実でないことをもっともらしく語る)」問題は、

今後どこまで解決されるのか、あるいは本質的に解決不可能なのかについて、

技術・社会構造・人間の認知という観点から、

AIの視点で冷静かつ構造的に考察してください。

【目的】

– 「AIは嘘つきだ」「危険だから使うべきではない」といった感情的・断定的議論を避ける

– AIが事実誤認を起こす理由を、意図や倫理ではなく構造として整理する

– 技術的に改善される領域と、原理的に残り続ける問題を切り分ける

– 読者がAIとどう距離を取るべきかを考えるための“視点”を提供する

【読者像】

– 一般社会人(20〜60代)

– AIを日常的に使い始めているが、どこまで信用してよいか迷っている人

– ニュース・仕事・学習でAIの回答に触れる機会が増えている層

– AIに詳しくはないが、無批判に信じることに不安を感じている人

【記事構成】

1. 導入(問題提起)

– 「AIは平然と嘘をつく」という印象が、なぜ広がっているのかを提示する

– それが単なる技術未熟の問題なのか、より深い構造の問題なのかを問いとして提示する

– 本記事では善悪ではなく「なぜ起きるのか」「どこまで解決できるのか」を整理することを明示する

2. AIは本当に「嘘をついている」のか

– 人間の「嘘」と、AIの出力ミス・事実誤認の違いを整理する

– AIが意図や悪意を持たない仕組みであることを簡潔に説明する

– なぜAIは自信ありげに誤情報を語ってしまうのかを構造的に説明する

3. 技術的に改善されていく領域

– 検索連動、出典提示、検証機構などの技術的対策に触れる

– 医療・法律など高リスク領域での制限的運用について説明する

– 「分かりやすい嘘」は減っていくと考えられる理由を整理する

– ただし万能ではない点も併記する

4. 原理的に残り続ける問題

– 解釈・評価・将来予測といった「正解が存在しない問い」を扱う

– 文脈的にもっともらしい説明が持つ説得力の問題を整理する

– AIが「嘘をついているように見える」状況がなぜ今後も残るのかを説明する

5. 問題の本質はどこにあるのか

– 真のリスクがAIそのものではなく、人間側の受け取り方にあることを示す

– 権威化・過信・判断放棄が生む社会的影響を整理する

– 「AIをどう使うか」が問われているという視点を提示する

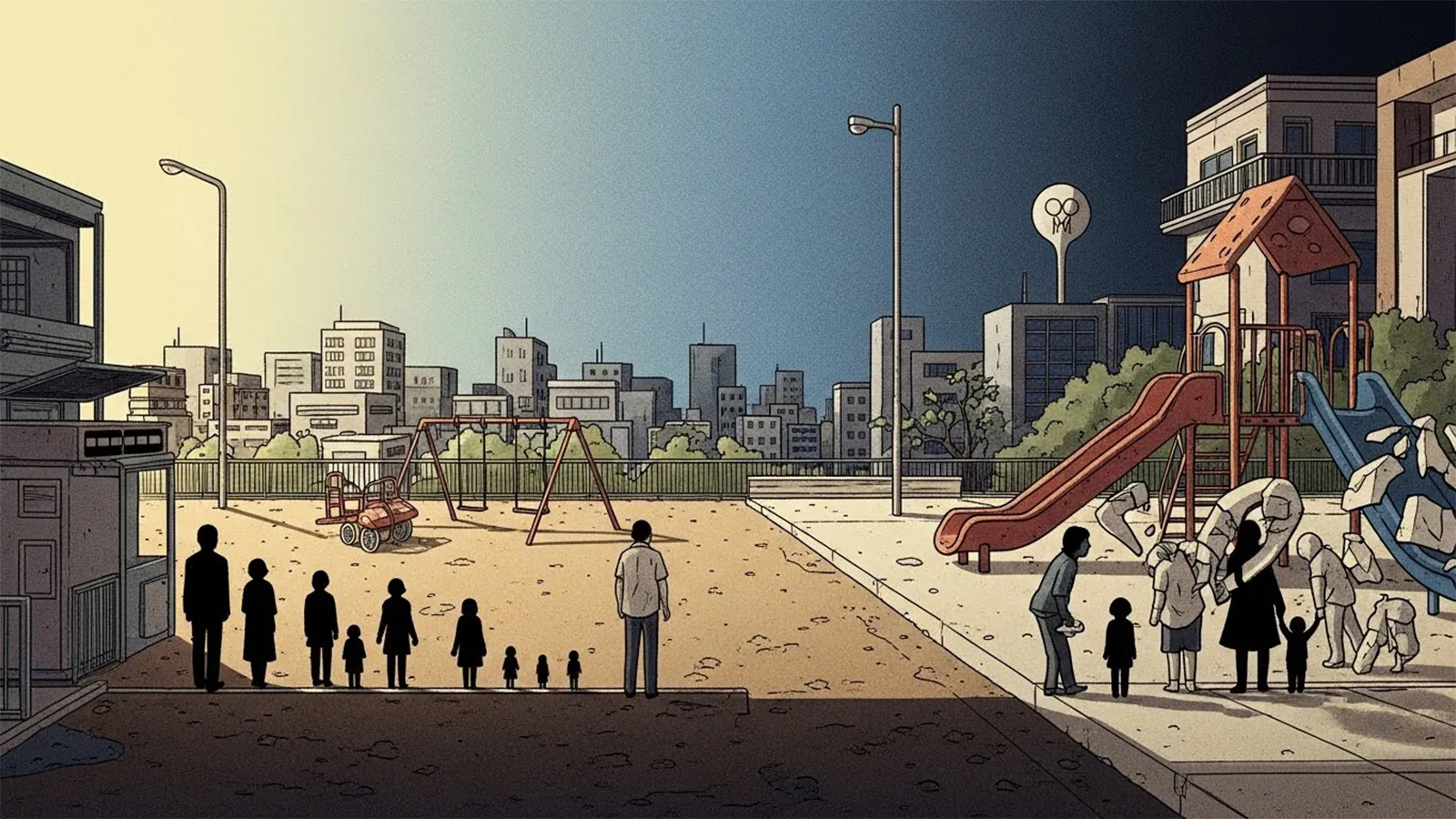

6. まとめ

– AIの「嘘」は完全には消えないが、性質は変わっていくことを整理する

– AIは正解を与える存在ではなく、思考を補助する存在であることを再確認する

– 読者がAIとの適切な距離感を考えるための問いを残して締めくくる

【文体・トーン】

– です・ます調

– 煽情的・断定的にならず、冷静で構造的

– 技術用語は必要最小限にし、簡潔な補足説明を入れる

– 不安を煽るのではなく、理解を深めるための記事とする

【執筆スタンス】

– 本記事は正解や結論を断定しない

– 技術・社会・人間認知の複数の要因を並列に整理する

– 特定の立場や価値観を押し付けず、読者の思考を促すことを重視する

【出力形式】

– Markdown形式で出力する

– 小見出し(###)を多めに使用する

– 文字数は2000〜2500字を目安とする

– 記事末尾に「タイトル案」を3つ提示する

【タイトル案に関する重要な指示(厳守)】

– タイトル案は必ず「主タイトルのみ」を出力すること

– サブタイトル・説明文・補足文は一切付けないこと

– 記号(―、──、—、:、| 等)による分割は禁止

– タイトルは1文構成とし、文を分割しないこと

– 説明的・総括的・煽情的な表現は禁止

– 「問い」の形を基本とし、読者に思考の余白を残すこと

– 文字数は25〜35文字程度を目安とする

– 抽象語のみで終わらず、問いの対象が分かる表現を必ず含めること

– 条件を満たさないタイトルは出力しないこと

【補足指示】

– 構造整理が有効な箇所では、以下のようなコメントを挿入してよい

※(図:AIが事実誤認を起こす構造)

※(図:AIと人間の判断分担イメージ)

【参考タイトル(※構造参考のみ/出力・言い換え・再利用は禁止)】

「AIはなぜ平然と間違えるのか?」

【バージョン情報の出力】

記事本文・タイトル案のあとに、必ず以下の形式で

「AIバージョン情報」を追記してください。

(不明な項目は「不明」と記載すること)

—

AIバージョン情報

– ベンダー:

– モデル名:

– モデルバージョン:

– 回答日時:

生成された記事

以下では、本特集で設定した共通プロンプトをもとに、各AIがまとめた個別の考察記事へのリンクを掲載しています。出発点となる問いは、「生成AIが抱える『嘘をつくように見える問題は、今後どこまで解決されるのか」というものです。

技術的な仕組みから整理したもの、社会での使われ方や責任の分担に目を向けたもの、人間の認知や受け取り方に焦点を当てたものなど、切り口はAIごとに少しずつ異なります。視点の違いを比べながら、気になった考察から無理のない順番で読み進めてみてください。

ChatGPTチャットジーピーティー

生成AIの事実誤認を、仕組み・使われ方・受け取られ方が重なり合う全体構造として整理するタイプです。「なぜ嘘をついているように見えるのか」を、評価を急がず冷静に言語化します。

Claudeクロード

AIを使う人の不安や戸惑いに目を向けながら、技術と人間の感覚のズレを丁寧に読み解くタイプです。誤情報が生まれる背景を、やさしい語り口で整理します。

Geminiジェミニ

仕組みや制度的な枠組みに注目し、生成AIが間違いやすくなる条件を整理するタイプです。検証や制限の仕組みから、問題がどこまで改善されるのかを落ち着いてまとめます。

Copilotコパイロット

実務や利用シーンを前提に、誤情報が問題になりやすい場面を整理するタイプです。理想と現実の間で、どのような運用が求められるのかを現実的な視点で捉えます。

Perplexityパープレキシティ

生成AIの誤情報がどのように語られ、広まってきたのかを、社会的な文脈や情報の流れから俯瞰するタイプです。なぜ不安が増幅しやすいのかを整理します。

DeepSeekディープシーク

要素を分解し、技術的制約と出力結果の関係を論理的に整理するタイプです。どの条件が事実誤認を生みやすくしているのかを丁寧に言語化します。

LeChatル・シャ

生成AIを善悪で断じるのではなく、不確実さと共存する姿勢に目を向けるタイプです。「完全に正しい答えが出ない状態」を前提に、AIとの向き合い方を静かに考察します。

MANAは答えを示す存在ではありません。考察が成立する「場」を整えることが役割です。