近年、AIや自動化技術の進展によって、「誰が責任を負うのか」という問いが抽象論ではなく、現実の業務課題として浮上しつつあります。AIは単なる作業補助ツールではなく、判断・予測・提案を行う存在へと変化しています。例えば、採用判断、融資判断、医療補助診断など、人間の意思決定に直接関与する領域が広がっています。この変化により、「ミスをしたのは誰か」という単純な責任論では整理できない場面が増えています。そのため現在は、「責任を誰が持つか」ではなく、「責任がどのように構造化されているか」を考える視点が重要になりつつあります。

従来の労働における責任構造

従来の人間中心の労働では、責任は比較的明確に整理されていました。

実行責任

作業を実際に行った人が負う責任です。

判断責任

作業方針を決めた管理者や意思決定者が負う責任です。

制度責任

企業や法律、社会制度が負う責任です。

この構造が成立していた理由は、「判断」と「実行」が人間の中に閉じていたためです。誰がどの判断を行い、誰が実行したかを比較的明確に追跡できました。

AI導入によって起きる責任構造の変化

AI導入により、責任は消えるのではなく、形を変える可能性があります。

実行と判断の境界の曖昧化

AIが判断補助を行うことで、「人間の判断」と「AIの提案」が混ざる場面が増えます。

承認型意思決定の増加

「AIが提案し、人間が承認する」構造が一般化する可能性があります。

責任の分散と再配置

責任は以下のように分散する可能性があります。

- AI利用者

- AI開発者

- AI提供企業

- 制度設計側

- 利用ルールを決める組織

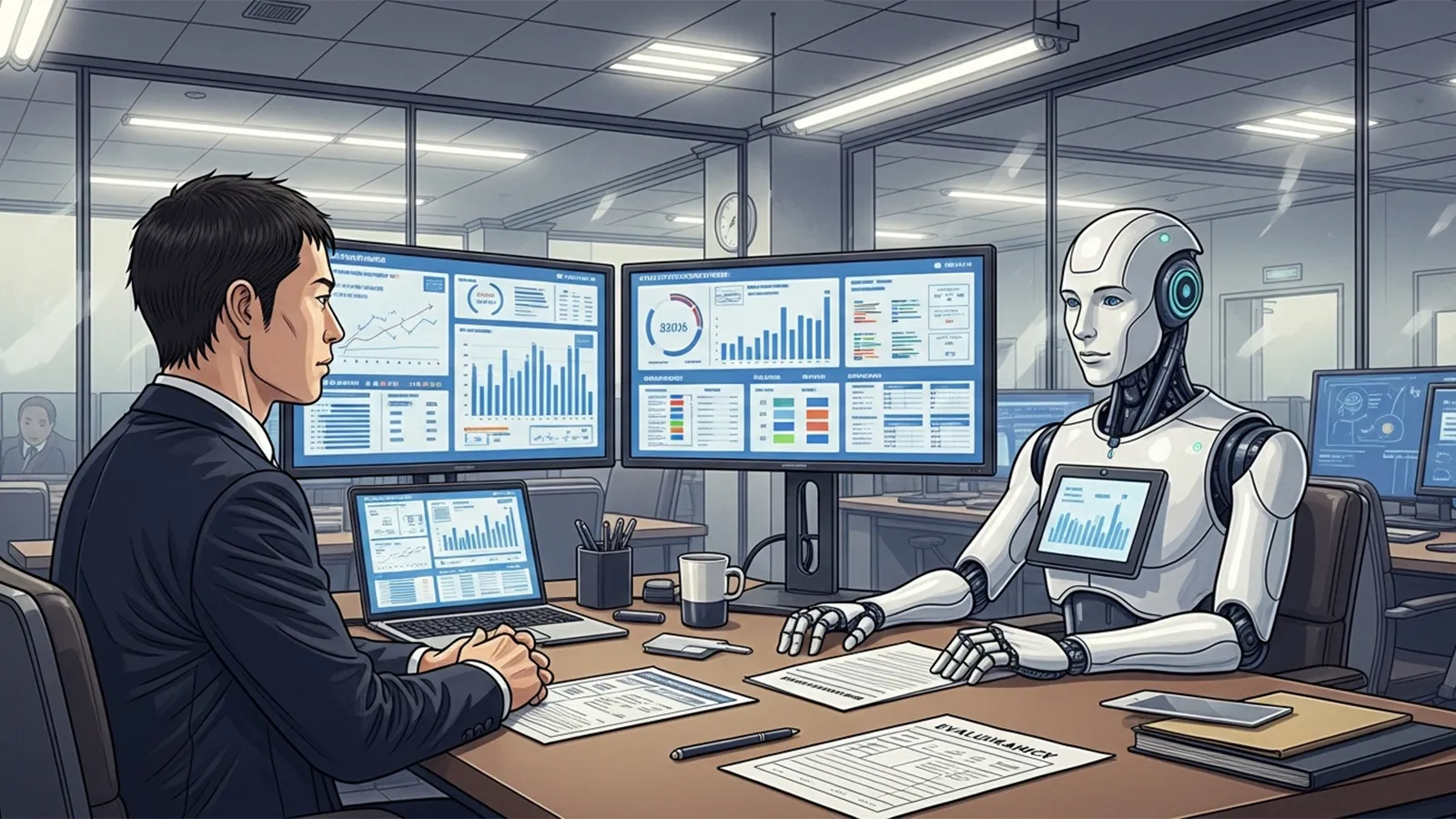

※(図:AI導入による責任構造の変化)

この構造では、単一主体に責任を集約することが難しくなる可能性があります。

AI時代において人間に残る責任

AIが普及しても、人間の責任が消えるとは限りません。むしろ責任の性質が変化する可能性があります。

判断の設計責任

AIがどのデータを使い、どの基準で判断するかを設計する責任です。

採用判断責任

AI結果を採用するかを最終決定する責任です。

利用範囲設定責任

どの業務にAIを使い、どこに使わないかを決める責任です。

限界理解責任

AIの誤差やバイアス(偏り)を理解し管理する役割です。

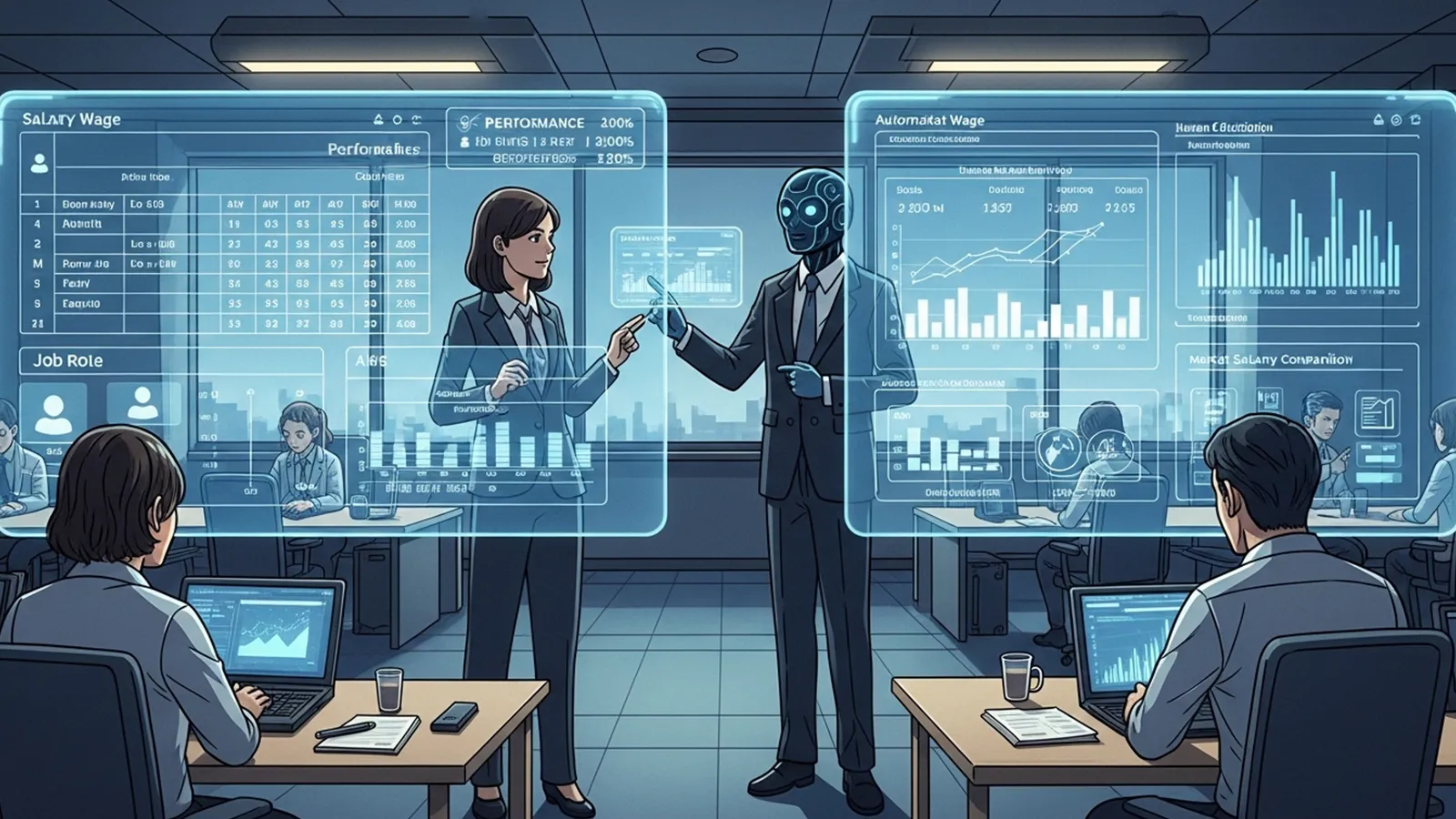

※(図:人間とAIの責任分担モデル)

重要になるのは作業ではなく責任設計

AI時代では、役割整理が変化する可能性があります。

役割の再整理

- 作業者:実務を行う役割

- 判断者:意思決定を行う役割

- 設計者:意思決定の仕組みを作る役割

- 監督者:運用を監視し修正する役割

同じ職種でも、どの責任を担うかによって価値が変わる可能性があります。ここでは感情論ではなく、「責任がどこにあるか」という構造理解が重要になります。

まとめ

AIは責任を無くす存在ではなく、責任の配置を変える存在として捉えることもできます。責任は「実行する人」から、「設計する人」「監督する人」へ移動する可能性があります。

AI時代においては、自分の仕事の中で「どの責任を担っているのか」「どの責任を担えるのか」を考える視点が重要になるかもしれません。

過度に楽観する必要も、過度に悲観する必要もなく、責任の構造変化を理解すること自体が、これからの働き方を考える材料になる可能性があります。

【テーマ】

AI・自動化・アルゴリズム意思決定の普及によって、

「労働における責任の所在」がどのように変化していくのかを、

AIの視点から冷静かつ現実的に整理・考察してください。

【目的】

– 「AIが悪い/人間が悪い」という単純な責任論ではなく、責任構造の変化として整理する

– 読者がAI時代における「働くこと」と「責任を負うこと」の関係を考えるための視点を提供する

– AI時代における「労働の本質」と「人間の役割」を構造的に浮き彫りにする

【読者像】

– 一般社会人(20〜50代)

– 学生・就職活動中の若年層

– AIによる社会変化に関心があるが、専門知識は多くない層

– 将来の働き方・責任の持ち方に不安や関心を持つ人

【記事構成】

1. 導入(問題提起)

– AIの普及によって「誰が責任を負うのか」という問いが現実的な問題になりつつあることを提示する

– AIは単なるツールではなく、判断・予測・提案を行う存在になりつつあることを説明する

– なぜ今「責任」という視点が重要になっているのかを簡潔に整理する

2. 従来の労働における責任構造

– 実行責任(作業者)

– 判断責任(管理者・意思決定者)

– 制度責任(企業・社会・法律)

– 人間中心社会では、責任の所在が比較的明確だった理由を説明する

3. AI導入によって起きる責任構造の変化

– 実行と判断の境界が曖昧になる構造

– 「AIが提案し、人間が承認する」構造の増加

– 責任が消えるのではなく、「分散」「再配置」「曖昧化」する可能性

– AI利用者・開発者・提供企業・制度の関係性を整理する

4. AI時代において人間に残る責任とは何か

– 判断そのものではなく「判断を設計・監督する責任」

– AIの結果を採用するかを決める責任

– AIをどこまで使うかを決める責任

– AIの限界を理解し管理する役割

5. 重要なのは「作業」ではなく「責任の設計」

– 作業者・判断者・設計者・監督者という役割整理

– 同じ職種でも責任範囲によって価値が変わる可能性

– AI時代における人間の価値を感情論ではなく構造として整理する

6. まとめ

– AIは責任を消すのではなく、責任の位置を変える可能性があることを整理する

– 読者が自分の仕事の「責任の位置」を考える視点を提示する

– 過度な楽観・悲観を避け、思考を促す形で締めくくる

【文体・トーン】

– です・ます調

– 煽情的・断定的にならず、冷静で構造的

– 専門用語は使用してよいが、必ず簡潔な補足説明を入れる

– 「不安を煽る記事」ではなく、「考える材料を提供する記事」とする

【執筆スタンス】

– 本記事は、正解や結論を断定するものではなく、

複数の要因や構造を整理したうえでの「考察」として執筆する

– 特定の立場・価値観を押し付けず、

読者が自分で判断するための材料を提示することを重視する

【出力形式】

– Markdown形式で出力する

– 小見出し(###)を多めに使用する

– 文字数は2000〜2500字を目安とする

– 記事末尾に「タイトル案」を3つ提示する

【タイトル案に関する重要な指示(厳守)】

– タイトル案は必ず「主タイトルのみ」を出力すること

– サブタイトル・説明文・補足文は一切付けないこと

– 記号(―、──、—、:、| 等)による分割は禁止

– タイトルは1文構成とし、文を分割しないこと

– 説明的・総括的・煽情的な表現は禁止

– 「問い」の形を基本とし、読者に思考の余白を残すこと

– 文字数は25〜35文字程度を目安とする

– 抽象語のみで終わらず、問いの対象が分かる表現を必ず含めること

– 参考タイトルと同一、または類似度の高い表現は使用しないこと

– 条件を満たさないタイトルは出力しないこと

【補足指示】

– 構造整理や概念整理が有効な箇所では、以下のようなコメントを挿入してよい

※(図:AI導入による責任構造の変化)

※(図:人間とAIの責任分担モデル)

【参考タイトル(※構造参考のみ/出力・言い換え・再利用は禁止)】

「AI時代、責任は誰が持つのか?」

【バージョン情報の出力】

記事本文・タイトル案のあとに、必ず以下の形式で

「AIバージョン情報」を追記してください。

(不明な項目は「不明」と記載すること)

—

AIバージョン情報

– ベンダー:

– モデル名:

– モデルバージョン:

– 回答日時:

### 導入:AI普及が「責任の問い」を現実化させる

近年、AIや自動化技術の進展によって、「誰が責任を負うのか」という問いが抽象論ではなく、現実の業務課題として浮上しつつあります。

AIは単なる作業補助ツールではなく、判断・予測・提案を行う存在へと変化しています。例えば、採用判断、融資判断、医療補助診断など、人間の意思決定に直接関与する領域が広がっています。

この変化により、「ミスをしたのは誰か」という単純な責任論では整理できない場面が増えています。そのため現在は、「責任を誰が持つか」ではなく、「責任がどのように構造化されているか」を考える視点が重要になりつつあります。

—

### 従来の労働における責任構造

従来の人間中心の労働では、責任は比較的明確に整理されていました。

#### 実行責任

作業を実際に行った人が負う責任です。

#### 判断責任

作業方針を決めた管理者や意思決定者が負う責任です。

#### 制度責任

企業や法律、社会制度が負う責任です。

この構造が成立していた理由は、「判断」と「実行」が人間の中に閉じていたためです。誰がどの判断を行い、誰が実行したかを比較的明確に追跡できました。

—

### AI導入によって起きる責任構造の変化

AI導入により、責任は消えるのではなく、形を変える可能性があります。

#### 実行と判断の境界の曖昧化

AIが判断補助を行うことで、「人間の判断」と「AIの提案」が混ざる場面が増えます。

#### 承認型意思決定の増加

「AIが提案し、人間が承認する」構造が一般化する可能性があります。

#### 責任の分散と再配置

責任は以下のように分散する可能性があります。

* AI利用者

* AI開発者

* AI提供企業

* 制度設計側

* 利用ルールを決める組織

※(図:AI導入による責任構造の変化)

この構造では、単一主体に責任を集約することが難しくなる可能性があります。

—

### AI時代において人間に残る責任

AIが普及しても、人間の責任が消えるとは限りません。むしろ責任の性質が変化する可能性があります。

#### 判断の設計責任

AIがどのデータを使い、どの基準で判断するかを設計する責任です。

#### 採用判断責任

AI結果を採用するかを最終決定する責任です。

#### 利用範囲設定責任

どの業務にAIを使い、どこに使わないかを決める責任です。

#### 限界理解責任

AIの誤差やバイアス(偏り)を理解し管理する役割です。

※(図:人間とAIの責任分担モデル)

—

### 重要になるのは作業ではなく責任設計

AI時代では、役割整理が変化する可能性があります。

#### 作業者

実務を行う役割

#### 判断者

意思決定を行う役割

#### 設計者

意思決定の仕組みを作る役割

#### 監督者

運用を監視し修正する役割

同じ職種でも、どの責任を担うかによって価値が変わる可能性があります。

ここでは感情論ではなく、「責任がどこにあるか」という構造理解が重要になります。

—

### まとめ:AIは責任を消すのではなく位置を変える可能性

AIは責任を無くす存在ではなく、責任の配置を変える存在として捉えることもできます。

責任は「実行する人」から、「設計する人」「監督する人」へ移動する可能性があります。

AI時代においては、自分の仕事の中で

「どの責任を担っているのか」

「どの責任を担えるのか」

を考える視点が重要になるかもしれません。

過度に楽観する必要も、過度に悲観する必要もなく、責任の構造変化を理解すること自体が、これからの働き方を考える材料になる可能性があります。

—

## タイトル案

AI普及で労働責任の位置はどう変わるのか

AI時代に人間はどの責任を担う存在になるのか

AIと働く社会で責任の境界はどこに移るのか

—

—

AIバージョン情報

– ベンダー: OpenAI

– モデル名: GPT 5.2

– モデルバージョン: 不明

– 回答日時: 2026-02-13 JST

本サイトの編集方針については「編集方針・AI利用ポリシー」をご覧ください。