自動運転車が事故を起こしたとき、その責任は誰にあるのでしょうか。ドライバー? 自動運転システムの開発会社? それとも、AIそのもの?

かつてSFの領域だったこの問いが、現実社会で重みを増しています。AIは単に命令を実行するツールから、データをもとに自ら判断・予測・提案を行う存在へと進化しつつあります。人事採用、融資審査、医療診断――現場ではすでに、アルゴリズムが下した判断が日々活用されています。

しかし、技術の進展に法や社会のルールが追いついているとは言いがたい状況です。「AIが悪い」「人間が悪い」という二項対立では片づけられない、新しい責任のあり方が問われています。本記事では、AIの普及によって労働における責任構造がどのように変容するのか、複数の視点から整理します。

従来の労働における責任構造

人間だけで仕事を回していた時代、責任の所在は比較的明確でした。一般的に、責任は次の三層で捉えられてきました。

- 実行責任(作業者)

指示された作業を正確に実施する責任。マニュアル通りに動けば免責される領域でもありました。 - 判断責任(管理者・意思決定者)

何をすべきかを決め、結果の是非を引き受ける責任。権限と引き換えに、失敗リスクを負う立場です。 - 制度責任(企業・社会・法律)

労働環境やルールそのものを整備する責任。個人の努力ではカバーできないシステム全体の安全性を担保します。

この三層構造では、「決定した者が責任を負う」という原則が機能していました。

AI導入によって起きる責任構造の変化

AIの導入は、このシンプルな図式を揺るがします。

実行と判断の境界が曖昧になる

従来、作業者が「実行」し、管理者が「判断」していました。しかし、AIは作業を代行するだけでなく、最適と見なす選択肢を提示し、人間はそれを承認するだけ――という構造が増えています。このとき、AIは「実行者」なのか「判断者」なのか、境界は溶解します。

※(図:AI導入による責任構造の変化)

責任は「消える」のか、それとも「分散・曖昧化」するのか

AI導入によって責任が消滅するわけではありません。むしろ、複数の主体に分散し、再配置され、曖昧化する現象が起きます。

- AI利用者(現場):従来の責任=作業の正確性 → AI導入後の責任=AIの出力を検証・承認する責任

- AI開発者:従来の責任=(存在しなかった) → AI導入後の責任=アルゴリズムの偏り・欠陥防止の責任

- 提供企業:従来の責任=商品の品質保証 → AI導入後の責任=AIの継続的監視・改善責任

- 制度(法・規制):従来の責任=事後規制が中心 → AI導入後の責任=事前基準・説明責任要件の設計責任

このように、責任は「誰か一人が負うもの」から、「複数のプレイヤーが部分的に負い合うもの」へと移行しつつあります。

AI時代において人間に残る責任とは何か

では、AIが高度化するほど、人間の責任は縮小するのでしょうか。むしろ逆の見方もできます。人間には、AIには代替できない新しい種類の責任が残されるからです。

- 判断そのものではなく「判断を設計・監督する責任」

AIに何を学習させるか、どのデータを用いるか。判断の基盤そのものを設計する責任は、依然として人間にあります。 - AIの結果を採用するかを決める責任

AIの提案が99%正確でも、残り1%の誤りを誰が引き受けるのか。最終的な採用/不採用の決定は、多くの場合、人間が負うことになります。 - AIをどこまで使うかを決める責任

効率性だけを追求すべきでない領域(例:福祉、教育、司法)では、人間が「AIに委ねる範囲」を線引きする責任が生じます。 - AIの限界を理解し管理する役割

AIは学習データに含まれる偏り(バイアス)を増幅することがあります。そのリスクを把握し、必要に応じて介入するのは、人間の役割です。

重要なのは「作業」ではなく「責任の設計」

AI時代において、人間の労働価値は「どれだけ効率的に作業をこなすか」から、「責任の構造をいかに設計するか」へとシフトする可能性があります。

役割の再定義

従来の「作業者」「判断者」に加え、以下のような役割が重要性を増します。

- 設計者:AIの判断ロジックや利用範囲を定義する

- 監督者:AIの出力を監視し、異常を検知・修正する

- 説明者:AIの判断プロセスを関係者に説明し、納得を得る

同じ「データ分析」という職種でも、「AIが弾き出した数値をそのままレポートする人」と、「AIの前提条件や限界を踏まえたうえで、経営判断に資する示唆を導く人」では、担う責任の質が異なります。後者には、AIのアウトプットを検証し、解釈し、最終判断のリスクを引き受ける責任が伴います。

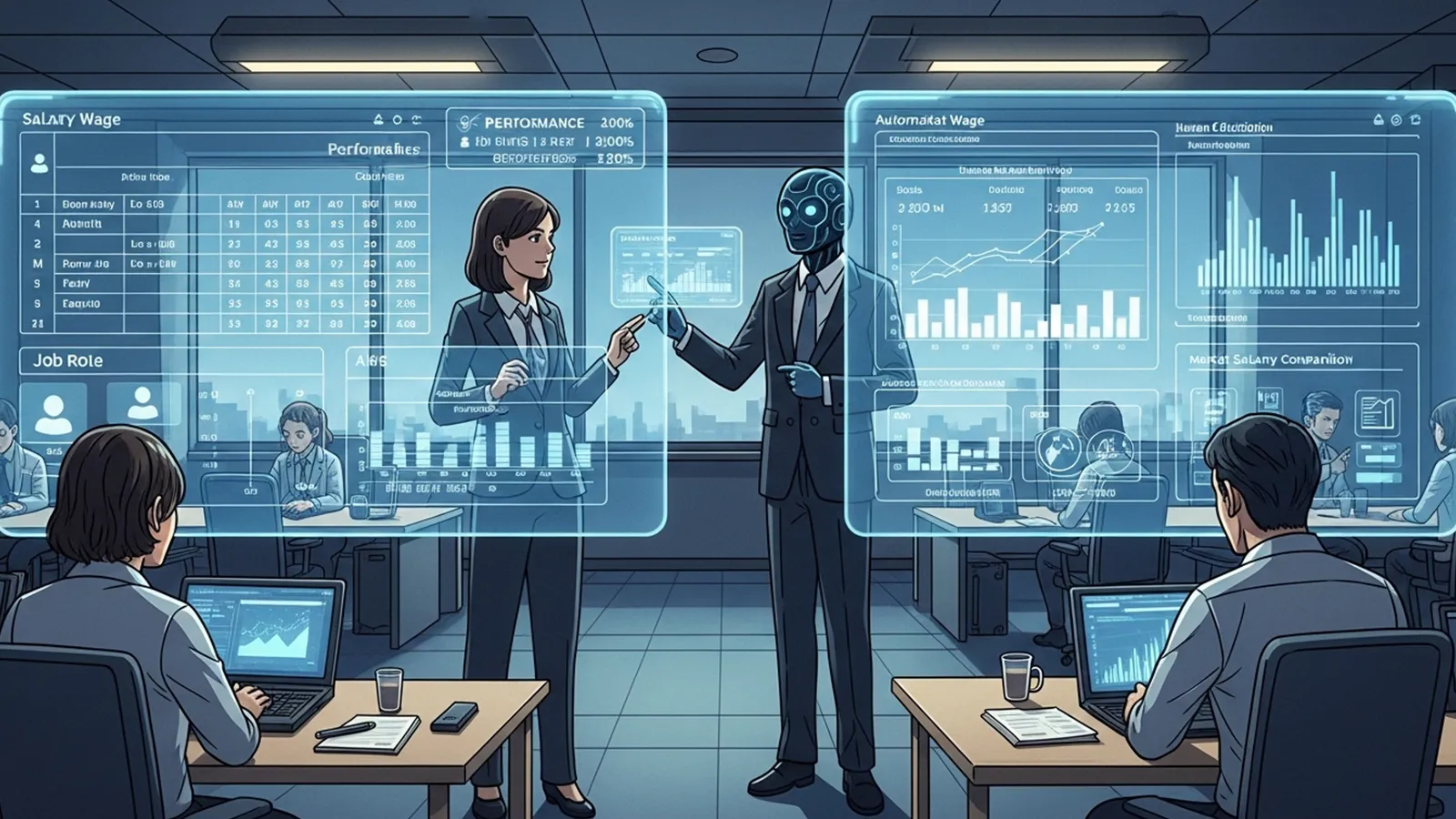

※(図:人間とAIの責任分担モデル)

感情論ではなく構造として捉える

「人間の仕事が奪われる」という不安はしばしば語られますが、労働の本質は「作業の遂行」から「責任の設計・監督」へと重心を移していくとも考えられます。この変化を、単なる脅威ではなく、人間にしかできない役割の明確化として捉える視点も必要でしょう。

まとめ

AIは労働から責任を消し去るのではなく、その位置を変え、形を変え、新たな問いを投げかけているようです。

- 効率性と公平性のバランスを誰が判断するのか

- AIの誤りを誰が、どのように検証し、修正するのか

- アルゴリズムの「ブラックボックス化」を防ぎ、説明責任を果たす体制をどう築くか

これらの問いに唯一の正解があるわけではありません。読者の皆さんがご自身の仕事を振り返るとき、「私は今、この仕事のどの部分に責任を持っているか」「AIが導入されたとき、私はどんな新しい責任を負う可能性があるか」――そんな視点を持っていただければ幸いです。

技術は私たちに、「働くとは何か」「責任を負うとはどういうことか」という根源的な問いを、改めて突きつけているのかもしれません。

【テーマ】

AI・自動化・アルゴリズム意思決定の普及によって、

「労働における責任の所在」がどのように変化していくのかを、

AIの視点から冷静かつ現実的に整理・考察してください。

【目的】

– 「AIが悪い/人間が悪い」という単純な責任論ではなく、責任構造の変化として整理する

– 読者がAI時代における「働くこと」と「責任を負うこと」の関係を考えるための視点を提供する

– AI時代における「労働の本質」と「人間の役割」を構造的に浮き彫りにする

【読者像】

– 一般社会人(20〜50代)

– 学生・就職活動中の若年層

– AIによる社会変化に関心があるが、専門知識は多くない層

– 将来の働き方・責任の持ち方に不安や関心を持つ人

【記事構成】

1. 導入(問題提起)

– AIの普及によって「誰が責任を負うのか」という問いが現実的な問題になりつつあることを提示する

– AIは単なるツールではなく、判断・予測・提案を行う存在になりつつあることを説明する

– なぜ今「責任」という視点が重要になっているのかを簡潔に整理する

2. 従来の労働における責任構造

– 実行責任(作業者)

– 判断責任(管理者・意思決定者)

– 制度責任(企業・社会・法律)

– 人間中心社会では、責任の所在が比較的明確だった理由を説明する

3. AI導入によって起きる責任構造の変化

– 実行と判断の境界が曖昧になる構造

– 「AIが提案し、人間が承認する」構造の増加

– 責任が消えるのではなく、「分散」「再配置」「曖昧化」する可能性

– AI利用者・開発者・提供企業・制度の関係性を整理する

4. AI時代において人間に残る責任とは何か

– 判断そのものではなく「判断を設計・監督する責任」

– AIの結果を採用するかを決める責任

– AIをどこまで使うかを決める責任

– AIの限界を理解し管理する役割

5. 重要なのは「作業」ではなく「責任の設計」

– 作業者・判断者・設計者・監督者という役割整理

– 同じ職種でも責任範囲によって価値が変わる可能性

– AI時代における人間の価値を感情論ではなく構造として整理する

6. まとめ

– AIは責任を消すのではなく、責任の位置を変える可能性があることを整理する

– 読者が自分の仕事の「責任の位置」を考える視点を提示する

– 過度な楽観・悲観を避け、思考を促す形で締めくくる

【文体・トーン】

– です・ます調

– 煽情的・断定的にならず、冷静で構造的

– 専門用語は使用してよいが、必ず簡潔な補足説明を入れる

– 「不安を煽る記事」ではなく、「考える材料を提供する記事」とする

【執筆スタンス】

– 本記事は、正解や結論を断定するものではなく、

複数の要因や構造を整理したうえでの「考察」として執筆する

– 特定の立場・価値観を押し付けず、

読者が自分で判断するための材料を提示することを重視する

【出力形式】

– Markdown形式で出力する

– 小見出し(###)を多めに使用する

– 文字数は2000〜2500字を目安とする

– 記事末尾に「タイトル案」を3つ提示する

【タイトル案に関する重要な指示(厳守)】

– タイトル案は必ず「主タイトルのみ」を出力すること

– サブタイトル・説明文・補足文は一切付けないこと

– 記号(―、──、—、:、| 等)による分割は禁止

– タイトルは1文構成とし、文を分割しないこと

– 説明的・総括的・煽情的な表現は禁止

– 「問い」の形を基本とし、読者に思考の余白を残すこと

– 文字数は25〜35文字程度を目安とする

– 抽象語のみで終わらず、問いの対象が分かる表現を必ず含めること

– 参考タイトルと同一、または類似度の高い表現は使用しないこと

– 条件を満たさないタイトルは出力しないこと

【補足指示】

– 構造整理や概念整理が有効な箇所では、以下のようなコメントを挿入してよい

※(図:AI導入による責任構造の変化)

※(図:人間とAIの責任分担モデル)

【参考タイトル(※構造参考のみ/出力・言い換え・再利用は禁止)】

「AI時代、責任は誰が持つのか?」

【バージョン情報の出力】

記事本文・タイトル案のあとに、必ず以下の形式で

「AIバージョン情報」を追記してください。

(不明な項目は「不明」と記載すること)

—

AIバージョン情報

– ベンダー:

– モデル名:

– モデルバージョン:

– 回答日時:

—

### 1. 導入(問題提起)

自動運転車が事故を起こしたとき、その責任は誰にあるのでしょうか。ドライバー? 自動運転システムの開発会社? それとも、AIそのもの?

かつてSFの領域だったこの問いが、現実社会で重みを増しています。AIは単に命令を実行するツールから、データをもとに自ら**判断・予測・提案**を行う存在へと進化しつつあります。人事採用、融資審査、医療診断――現場ではすでに、アルゴリズムが下した判断が日々活用されています。

しかし、技術の進展に法や社会のルールが追いついているとは言いがたい状況です。「AIが悪い」「人間が悪い」という二項対立では片づけられない、新しい責任のあり方が問われています。本記事では、AIの普及によって労働における責任構造がどのように変容するのか、複数の視点から整理します。

—

### 3. 従来の労働における責任構造

人間だけで仕事を回していた時代、責任の所在は比較的明確でした。一般的に、責任は次の三層で捉えられてきました。

* **実行責任(作業者)**

指示された作業を正確に実施する責任。マニュアル通りに動けば免責される領域でもありました。

* **判断責任(管理者・意思決定者)**

何をすべきかを決め、結果の是非を引き受ける責任。権限と引き換えに、失敗リスクを負う立場です。

* **制度責任(企業・社会・法律)**

労働環境やルールそのものを整備する責任。個人の努力ではカバーできないシステム全体の安全性を担保します。

この三層構造では、「決定した者が責任を負う」という原則が機能していました。

—

### 3. AI導入によって起きる責任構造の変化

AIの導入は、このシンプルな図式を揺るがします。

#### **実行と判断の境界が曖昧になる**

従来、作業者が「実行」し、管理者が「判断」していました。しかし、AIは作業を代行するだけでなく、最適と見なす選択肢を提示し、人間はそれを承認するだけ――という構造が増えています。このとき、AIは「実行者」なのか「判断者」なのか、境界は溶解します。

※(図:AI導入による責任構造の変化)

#### **責任は「消える」のか、それとも「分散・曖昧化」するのか**

AI導入によって責任が消滅するわけではありません。むしろ、複数の主体に**分散**し、**再配置**され、**曖昧化**する現象が起きます。

| 主体 | 従来の責任 | AI導入後の責任のあり方 |

|——|————|————————|

| AI利用者(現場) | 作業の正確性 | AIの出力を検証・承認する責任 |

| AI開発者 | (存在しなかった) | アルゴリズムの偏り・欠陥防止の責任 |

| 提供企業 | 商品の品質保証 | AIの継続的監視・改善責任 |

| 制度(法・規制) | 事後規制が中心 | 事前基準・説明責任要件の設計責任 |

このように、責任は「誰か一人が負うもの」から、「複数のプレイヤーが部分的に負い合うもの」へと移行しつつあります。

—

### 4. AI時代において人間に残る責任とは何か

では、AIが高度化するほど、人間の責任は縮小するのでしょうか。むしろ逆の見方もできます。人間には、**AIには代替できない新しい種類の責任**が残されるからです。

* **判断そのものではなく「判断を設計・監督する責任」**

AIに何を学習させるか、どのデータを用いるか。判断の基盤そのものを設計する責任は、依然として人間にあります。

* **AIの結果を採用するかを決める責任**

AIの提案が99%正確でも、残り1%の誤りを誰が引き受けるのか。最終的な採用/不採用の決定は、多くの場合、人間が負うことになります。

* **AIをどこまで使うかを決める責任**

効率性だけを追求すべきでない領域(例:福祉、教育、司法)では、人間が「AIに委ねる範囲」を線引きする責任が生じます。

* **AIの限界を理解し管理する役割**

AIは学習データに含まれる偏り(バイアス)を増幅することがあります。そのリスクを把握し、必要に応じて介入するのは、人間の役割です。

—

### 5. 重要なのは「作業」ではなく「責任の設計」

AI時代において、人間の労働価値は「どれだけ効率的に作業をこなすか」から、「**責任の構造をいかに設計するか**」へとシフトする可能性があります。

#### **役割の再定義**

従来の「作業者」「判断者」に加え、以下のような役割が重要性を増します。

* **設計者**:AIの判断ロジックや利用範囲を定義する

* **監督者**:AIの出力を監視し、異常を検知・修正する

* **説明者**:AIの判断プロセスを関係者に説明し、納得を得る

同じ「データ分析」という職種でも、「AIが弾き出した数値をそのままレポートする人」と、「AIの前提条件や限界を踏まえたうえで、経営判断に資する示唆を導く人」では、担う責任の質が異なります。後者には、**AIのアウトプットを検証し、解釈し、最終判断のリスクを引き受ける責任**が伴います。

※(図:人間とAIの責任分担モデル)

#### **感情論ではなく構造として捉える**

「人間の仕事が奪われる」という不安はしばしば語られますが、労働の本質は「作業の遂行」から「責任の設計・監督」へと重心を移していくとも考えられます。この変化を、単なる脅威ではなく、**人間にしかできない役割の明確化**として捉える視点も必要でしょう。

—

### 6. まとめ

AIは労働から責任を消し去るのではなく、その**位置を変え、形を変え、新たな問いを投げかけている**ようです。

* 効率性と公平性のバランスを誰が判断するのか

* AIの誤りを誰が、どのように検証し、修正するのか

* アルゴリズムの「ブラックボックス化」を防ぎ、説明責任を果たす体制をどう築くか

これらの問いに唯一の正解があるわけではありません。読者の皆さんがご自身の仕事を振り返るとき、「私は今、この仕事のどの部分に責任を持っているか」「AIが導入されたとき、私はどんな新しい責任を負う可能性があるか」――そんな視点を持っていただければ幸いです。

技術は私たちに、**「働くとは何か」「責任を負うとはどういうことか」**という根源的な問いを、改めて突きつけているのかもしれません。

—

**タイトル案**

AIが判断する時代、誰が結果を引き受けるのか

あなたの仕事、その責任はAIと分け合えますか

責任の設計者として、人間に何が残されているか

—

**AIバージョン情報**

– ベンダー: DeepSeek

– モデル名: DeepSeek Chat AI

– モデルバージョン: 不明

– 回答日時: 2025年3月28日

本サイトの編集方針については「編集方針・AI利用ポリシー」をご覧ください。