AIが業務の一部を担うことが当たり前になりつつある現在、「誰が責任を負うのか」という問いは、抽象的な未来予測ではなく、日常的な実務の問題として浮上しています。かつてAIは「便利なツール」として扱われていましたが、いまのAIは判断・予測・提案といった、従来は人間だけが担っていた領域に踏み込みつつあります。その結果、ミスが起きたときに「人間の判断か、AIの判断か」が曖昧になり、責任の所在が揺らぎ始めています。この変化を理解するためには、単に「AIが悪い/人間が悪い」といった二項対立ではなく、責任の構造そのものがどう変化しているのかを整理する視点が重要です。

従来の労働における責任構造

人間中心の労働環境では、責任の所在は比較的明確でした。大きく分けると次の三層構造です。

実行責任(作業者)

実際に手を動かし、作業を行う人が負う責任です。例として、入力ミスや作業手順の逸脱などが挙げられます。

判断責任(管理者・意思決定者)

作業者の結果を踏まえ、最終的な判断を下す立場が負う責任です。承認ミスやリスク評価の誤りなどが該当します。

制度責任(企業・社会・法律)

組織のルールや社会制度を整え、適切な環境を提供する側の責任です。安全基準の不備や教育不足などが含まれます。

この構造が明確だった理由は、判断も実行も人間が行っていたため、因果関係を追いやすかったからです。

AI導入によって起きる責任構造の変化

AIが業務に組み込まれると、従来の三層構造はそのままでは機能しにくくなります。

実行と判断の境界が曖昧になる

AIは「作業の自動化」だけでなく「判断の補助」も行います。そのため、作業者が判断しているのか、AIが判断しているのかが分かりにくくなります。

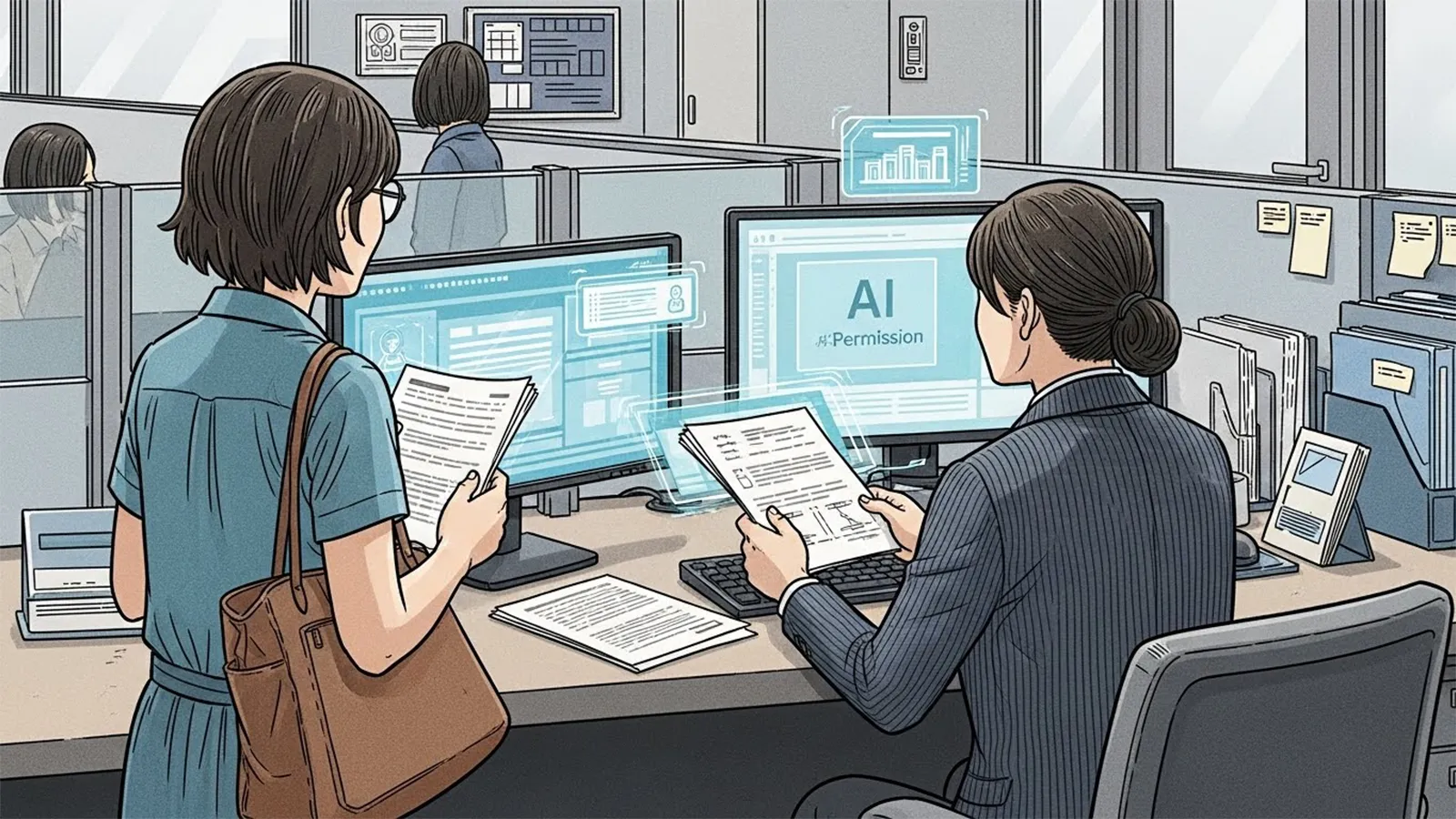

「AIが提案し、人間が承認する」構造の増加

多くの業務で、AIが候補を提示し、人間が最終判断を下す形が増えています。しかし実際にはAIの提案が強く影響するため、責任の境界が曖昧になります。

責任は消えないが、「分散」「再配置」「曖昧化」する

AI導入によって責任がなくなるわけではありません。むしろ、責任が複数の主体に分散し、どこに重心があるのかが見えにくくなります。

AI利用者・開発者・提供企業・制度の関係性

※(図:AI導入による責任構造の変化)

- AI利用者(現場):AIの結果をどう扱うか

- 管理者:AIをどの範囲で使うかを決める

- 開発者:アルゴリズムの設計・品質

- 提供企業:利用規約・安全基準

- 制度(法律・社会):AI利用の枠組みを整備する

AI時代において人間に残る責任とは何か

AIが判断を担う領域が増えても、人間の責任が消えるわけではありません。むしろ、人間の責任は「判断そのもの」から「判断の設計・監督」へと移行します。

判断そのものではなく「判断を設計する責任」

AIがどのデータを使い、どの基準で判断するのか。その枠組みを決めるのは人間です。

AIの結果を採用するかどうかを決める責任

AIの提案をそのまま採用するのか、修正するのか。最終的な選択の責任は依然として人間にあります。

AIをどこまで使うかを決める責任

AIの利用範囲や権限を設定することも、人間の役割です。

AIの限界を理解し、管理する責任

AIは万能ではなく、データの偏りや誤差が存在します。その特性を理解し、適切に運用する責任が求められます。

重要なのは「作業」ではなく「責任の設計」

AI時代の労働では、単に作業をこなすだけではなく、責任の位置づけをどう設計するかが重要になります。

作業者・判断者・設計者・監督者という役割整理

※(図:人間とAIの責任分担モデル)

- 作業者:AIを使いこなす

- 判断者:AIの結果を評価する

- 設計者:AIの判断基準を設計する

- 監督者:AI運用全体を管理する

人間の価値は「責任の位置」によって決まる

AIが作業を代替するほど、人間の価値は「責任の設計・監督」に移ります。これは感情論ではなく、構造的な変化として捉えることができます。

まとめ

AIは責任を消すのではなく、責任の位置を変えます。その変化を理解することは、AI時代における働き方を考えるうえで不可欠です。

読者の皆さんには、自分の仕事の中で「どの責任を担っているのか」「AI導入後、その責任はどこへ移るのか」という視点を持つことで、将来の働き方をより主体的に考えるきっかけにしていただければと思います。

【テーマ】

AI・自動化・アルゴリズム意思決定の普及によって、

「労働における責任の所在」がどのように変化していくのかを、

AIの視点から冷静かつ現実的に整理・考察してください。

【目的】

– 「AIが悪い/人間が悪い」という単純な責任論ではなく、責任構造の変化として整理する

– 読者がAI時代における「働くこと」と「責任を負うこと」の関係を考えるための視点を提供する

– AI時代における「労働の本質」と「人間の役割」を構造的に浮き彫りにする

【読者像】

– 一般社会人(20〜50代)

– 学生・就職活動中の若年層

– AIによる社会変化に関心があるが、専門知識は多くない層

– 将来の働き方・責任の持ち方に不安や関心を持つ人

【記事構成】

1. 導入(問題提起)

– AIの普及によって「誰が責任を負うのか」という問いが現実的な問題になりつつあることを提示する

– AIは単なるツールではなく、判断・予測・提案を行う存在になりつつあることを説明する

– なぜ今「責任」という視点が重要になっているのかを簡潔に整理する

2. 従来の労働における責任構造

– 実行責任(作業者)

– 判断責任(管理者・意思決定者)

– 制度責任(企業・社会・法律)

– 人間中心社会では、責任の所在が比較的明確だった理由を説明する

3. AI導入によって起きる責任構造の変化

– 実行と判断の境界が曖昧になる構造

– 「AIが提案し、人間が承認する」構造の増加

– 責任が消えるのではなく、「分散」「再配置」「曖昧化」する可能性

– AI利用者・開発者・提供企業・制度の関係性を整理する

4. AI時代において人間に残る責任とは何か

– 判断そのものではなく「判断を設計・監督する責任」

– AIの結果を採用するかを決める責任

– AIをどこまで使うかを決める責任

– AIの限界を理解し管理する役割

5. 重要なのは「作業」ではなく「責任の設計」

– 作業者・判断者・設計者・監督者という役割整理

– 同じ職種でも責任範囲によって価値が変わる可能性

– AI時代における人間の価値を感情論ではなく構造として整理する

6. まとめ

– AIは責任を消すのではなく、責任の位置を変える可能性があることを整理する

– 読者が自分の仕事の「責任の位置」を考える視点を提示する

– 過度な楽観・悲観を避け、思考を促す形で締めくくる

【文体・トーン】

– です・ます調

– 煽情的・断定的にならず、冷静で構造的

– 専門用語は使用してよいが、必ず簡潔な補足説明を入れる

– 「不安を煽る記事」ではなく、「考える材料を提供する記事」とする

【執筆スタンス】

– 本記事は、正解や結論を断定するものではなく、

複数の要因や構造を整理したうえでの「考察」として執筆する

– 特定の立場・価値観を押し付けず、

読者が自分で判断するための材料を提示することを重視する

【出力形式】

– Markdown形式で出力する

– 小見出し(###)を多めに使用する

– 文字数は2000〜2500字を目安とする

– 記事末尾に「タイトル案」を3つ提示する

【タイトル案に関する重要な指示(厳守)】

– タイトル案は必ず「主タイトルのみ」を出力すること

– サブタイトル・説明文・補足文は一切付けないこと

– 記号(―、──、—、:、| 等)による分割は禁止

– タイトルは1文構成とし、文を分割しないこと

– 説明的・総括的・煽情的な表現は禁止

– 「問い」の形を基本とし、読者に思考の余白を残すこと

– 文字数は25〜35文字程度を目安とする

– 抽象語のみで終わらず、問いの対象が分かる表現を必ず含めること

– 参考タイトルと同一、または類似度の高い表現は使用しないこと

– 条件を満たさないタイトルは出力しないこと

【補足指示】

– 構造整理や概念整理が有効な箇所では、以下のようなコメントを挿入してよい

※(図:AI導入による責任構造の変化)

※(図:人間とAIの責任分担モデル)

【参考タイトル(※構造参考のみ/出力・言い換え・再利用は禁止)】

「AI時代、責任は誰が持つのか?」

【バージョン情報の出力】

記事本文・タイトル案のあとに、必ず以下の形式で

「AIバージョン情報」を追記してください。

(不明な項目は「不明」と記載すること)

—

AIバージョン情報

– ベンダー:

– モデル名:

– モデルバージョン:

– 回答日時:

(AI比較メディア「AIシテル?」編集方針に基づく考察)

—

## 1. 導入(問題提起)

AIが業務の一部を担うことが当たり前になりつつある現在、「誰が責任を負うのか」という問いは、抽象的な未来予測ではなく、日常的な実務の問題として浮上しています。

かつてAIは「便利なツール」として扱われていましたが、いまのAIは判断・予測・提案といった、従来は人間だけが担っていた領域に踏み込みつつあります。

その結果、ミスが起きたときに「人間の判断か、AIの判断か」が曖昧になり、責任の所在が揺らぎ始めています。

この変化を理解するためには、単に「AIが悪い/人間が悪い」といった二項対立ではなく、責任の構造そのものがどう変化しているのかを整理する視点が重要です。

—

## 2. 従来の労働における責任構造

人間中心の労働環境では、責任の所在は比較的明確でした。大きく分けると次の三層構造です。

### ● 実行責任(作業者)

実際に手を動かし、作業を行う人が負う責任です。

例:入力ミス、作業手順の逸脱など。

### ● 判断責任(管理者・意思決定者)

作業者の結果を踏まえ、最終的な判断を下す立場が負う責任です。

例:承認ミス、リスク評価の誤りなど。

### ● 制度責任(企業・社会・法律)

組織のルールや社会制度を整え、適切な環境を提供する側の責任です。

例:安全基準の不備、教育不足など。

この構造が明確だった理由は、判断も実行も人間が行っていたため、因果関係を追いやすかったからです。

—

## 3. AI導入によって起きる責任構造の変化

AIが業務に組み込まれると、従来の三層構造はそのままでは機能しにくくなります。

### ● 実行と判断の境界が曖昧になる

AIは「作業の自動化」だけでなく、「判断の補助」も行います。

そのため、作業者が判断しているのか、AIが判断しているのかが分かりにくくなります。

### ● 「AIが提案し、人間が承認する」構造の増加

多くの業務で、AIが候補を提示し、人間が最終判断を下す形が増えています。

しかし、実際にはAIの提案が強く影響するため、責任の境界が曖昧になります。

### ● 責任は消えないが、「分散」「再配置」「曖昧化」する

AI導入によって責任がなくなるわけではありません。

むしろ、責任が複数の主体に分散し、どこに重心があるのかが見えにくくなります。

### ● AI利用者・開発者・提供企業・制度の関係性

※(図:AI導入による責任構造の変化)

– **AI利用者(現場)**:AIの結果をどう扱うか

– **管理者**:AIをどの範囲で使うかを決める

– **開発者**:アルゴリズムの設計・品質

– **提供企業**:利用規約・安全基準

– **制度(法律・社会)**:AI利用の枠組みを整備する

責任はこの複数の主体にまたがり、単純化できなくなります。

—

## 4. AI時代において人間に残る責任とは何か

AIが判断を担う領域が増えても、人間の責任が消えるわけではありません。

むしろ、人間の責任は「判断そのもの」から「判断の設計・監督」へと移行します。

### ● 判断そのものではなく「判断を設計する責任」

AIがどのデータを使い、どの基準で判断するのか。

その枠組みを決めるのは人間です。

### ● AIの結果を採用するかどうかを決める責任

AIの提案をそのまま採用するのか、修正するのか。

最終的な選択の責任は依然として人間にあります。

### ● AIをどこまで使うかを決める責任

AIの利用範囲や権限を設定することも、人間の役割です。

### ● AIの限界を理解し、管理する責任

AIは万能ではなく、データの偏りや誤差が存在します。

その特性を理解し、適切に運用する責任が求められます。

—

## 5. 重要なのは「作業」ではなく「責任の設計」

AI時代の労働では、単に作業をこなすだけではなく、責任の位置づけをどう設計するかが重要になります。

### ● 作業者・判断者・設計者・監督者という役割整理

※(図:人間とAIの責任分担モデル)

– **作業者**:AIを使いこなす

– **判断者**:AIの結果を評価する

– **設計者**:AIの判断基準を設計する

– **監督者**:AI運用全体を管理する

同じ職種でも、どの責任を担うかによって価値が大きく変わります。

### ● 人間の価値は「責任の位置」によって決まる

AIが作業を代替するほど、人間の価値は「責任の設計・監督」に移ります。

これは感情論ではなく、構造的な変化として捉えることができます。

—

## 6. まとめ

AIは責任を消すのではなく、責任の位置を変えます。

その変化を理解することは、AI時代における働き方を考えるうえで不可欠です。

読者の皆さんには、自分の仕事の中で

「どの責任を担っているのか」

「AI導入後、その責任はどこへ移るのか」

という視点を持つことで、将来の働き方をより主体的に考えるきっかけにしていただければと思います。

—

## タイトル案(※主タイトルのみ)

1. AI時代の労働で責任はどこに位置づくのか

2. 自動化が進む職場で責任の所在はどう変わるのか

3. AIと働く社会で人間の責任は何を指すのか

—

## AIバージョン情報

– ベンダー: Microsoft

– モデル名: 不明

– モデルバージョン: 不明

– 回答日時: 2026-02-13

本サイトの編集方針については「編集方針・AI利用ポリシー」をご覧ください。