かつて機械は、人間が決めたとおりに動くだけのものだった。しかしも現在のAIは、膨大なデータから傾向を読み取り、未来を予測し、選択肢を提示する。採用すべき候補者を選び、融資の可否を判定し、配送ルートを最適化する。AIは単なる「道具」ではなく、「判断に近い何か」を行う存在へと変わりつつある。この変化によって、私たちの働き方における「責任の所在」が揺らぎ始めている。AIが提案した結果を採用して問題が起きた場合、責任を負うのは誰なのか。AIを使った担当者か、AIを導入した企業か、それともAIを開発した技術者か。この問いは、もはや空想ではなく、現実のビジネスや職場で直面する課題となっている。

従来の責任構造はどう成り立っていたか

人間中心の労働社会では、責任の所在は比較的明確だった。それは以下のような構造で整理できる。

実行責任

作業を実際に行う人が負う責任。ミスや不備があれば、作業者に一定の責任が問われた。

判断責任

何をどう実行するかを決める管理者や意思決定者が負う責任。判断の誤りによる結果は、判断者が引き受けるべきものとされた。

制度責任

企業や社会、法律が担う責任。個人では対処しきれない構造的な問題や、組織としての過失に対する責任。

この三層構造において、「誰が何を決め、誰が何を実行したか」は比較的明確だった。だからこそ、問題が起きたときに責任の所在を特定することができたのである。

AI導入は責任の「位置」を変える

AIが労働に組み込まれると、この責任構造に変化が生じる。

実行と判断の境界が曖昧になる

AIは「実行」だけでなく「判断に近い処理」も行う。たとえば与信審査AIは、データから融資の可否を「判断」する。この場合、AIは実行者なのか、判断者なのか。その境界は従来の枠組みでは説明しきれない。

「AIが提案し、人間が承認する」構造の増加

多くの現場では、「AIが候補を提示し、人間が最終決定する」という形が採用されている。しかし人間の判断は、実質的にはAIの提案に依存している場合が多い。この構造では、判断責任は人間にあるのか、それともAIの設計者にあるのか。責任の所在が曖昧になる。

責任は消えるのではなく「分散」する

AIによって責任がなくなるわけではない。むしろ責任は、利用者・開発者・提供企業・制度設計者といった複数の主体に分散し、それぞれの範囲が曖昧化する。この「曖昧さ」こそが、AI時代における責任問題の本質である。

AI時代に人間が負う責任の形

では、AI時代において人間が担うべき責任とは何か。

判断そのものではなく「判断を設計・監督する責任」

AIが提案を行う社会では、人間の役割は「何を判断するか」ではなく、「どういう判断をAIに任せるか」を決めることになる。どのデータを使い、どの基準で評価し、どこまでをAIに委ねるか。その設計と監督が人間の責任となる。

AIの結果を採用するかを決める責任

AIが提案した内容を鵜呑みにするのではなく、その妥当性を吟味し、採用の可否を判断する責任。これは単なる「承認作業」ではなく、AIの限界や偏りを理解したうえでの意思決定を意味する。

AIをどこまで使うかを決める責任

すべてをAIに任せるのではなく、どの領域は人間が判断すべきかを見極める責任。効率化と人間の関与のバランスを取る判断が求められる。

重要なのは「作業」ではなく「責任の設計」

AI時代における労働の価値は、単なる「作業の遂行」ではなく、「責任をどう設計し、どう負うか」という視点で再定義される可能性がある。

役割の再整理が進む

従来の「作業者」「判断者」という区分に加え、「設計者」「監督者」という役割が重要になる。AIに何をさせ、人間が何を見守るか。その境界を引く役割が、AI時代の労働における核心となる。

同じ職種でも責任範囲で価値が変わる

同じ職種であっても、AIの判断をそのまま採用する人と、AIの設計や監督に関与する人では、責任の範囲が異なる。そしてその責任範囲こそが、労働における価値を決める要因になる可能性がある。

まとめ:責任は消えず、位置が変わる

AIの普及によって、労働における責任の所在が「明確→曖昧」へと変化しつつある。しかしそれは、責任が消えることを意味しない。責任は、実行から設計へ、判断から監督へと、その位置を変えていく。

この変化を前にして私たちができるのは、自分の仕事における「責任の位置」を見つめ直すことだろう。自分は何を判断し、何を設計し、何を監督しているのか。AIが担う部分と、人間が担うべき部分の境界はどこにあるのか。

AI時代の労働とは、作業の効率化だけでなく、責任の再配置というプロセスでもある。その構造を理解することが、これからの働き方を考える第一歩となる。

【テーマ】

AI・自動化・アルゴリズム意思決定の普及によって、

「労働における責任の所在」がどのように変化していくのかを、

AIの視点から冷静かつ現実的に整理・考察してください。

【目的】

– 「AIが悪い/人間が悪い」という単純な責任論ではなく、責任構造の変化として整理する

– 読者がAI時代における「働くこと」と「責任を負うこと」の関係を考えるための視点を提供する

– AI時代における「労働の本質」と「人間の役割」を構造的に浮き彫りにする

【読者像】

– 一般社会人(20〜50代)

– 学生・就職活動中の若年層

– AIによる社会変化に関心があるが、専門知識は多くない層

– 将来の働き方・責任の持ち方に不安や関心を持つ人

【記事構成】

1. 導入(問題提起)

– AIの普及によって「誰が責任を負うのか」という問いが現実的な問題になりつつあることを提示する

– AIは単なるツールではなく、判断・予測・提案を行う存在になりつつあることを説明する

– なぜ今「責任」という視点が重要になっているのかを簡潔に整理する

2. 従来の労働における責任構造

– 実行責任(作業者)

– 判断責任(管理者・意思決定者)

– 制度責任(企業・社会・法律)

– 人間中心社会では、責任の所在が比較的明確だった理由を説明する

3. AI導入によって起きる責任構造の変化

– 実行と判断の境界が曖昧になる構造

– 「AIが提案し、人間が承認する」構造の増加

– 責任が消えるのではなく、「分散」「再配置」「曖昧化」する可能性

– AI利用者・開発者・提供企業・制度の関係性を整理する

4. AI時代において人間に残る責任とは何か

– 判断そのものではなく「判断を設計・監督する責任」

– AIの結果を採用するかを決める責任

– AIをどこまで使うかを決める責任

– AIの限界を理解し管理する役割

5. 重要なのは「作業」ではなく「責任の設計」

– 作業者・判断者・設計者・監督者という役割整理

– 同じ職種でも責任範囲によって価値が変わる可能性

– AI時代における人間の価値を感情論ではなく構造として整理する

6. まとめ

– AIは責任を消すのではなく、責任の位置を変える可能性があることを整理する

– 読者が自分の仕事の「責任の位置」を考える視点を提示する

– 過度な楽観・悲観を避け、思考を促す形で締めくくる

【文体・トーン】

– です・ます調

– 煽情的・断定的にならず、冷静で構造的

– 専門用語は使用してよいが、必ず簡潔な補足説明を入れる

– 「不安を煽る記事」ではなく、「考える材料を提供する記事」とする

【執筆スタンス】

– 本記事は、正解や結論を断定するものではなく、

複数の要因や構造を整理したうえでの「考察」として執筆する

– 特定の立場・価値観を押し付けず、

読者が自分で判断するための材料を提示することを重視する

【出力形式】

– Markdown形式で出力する

– 小見出し(###)を多めに使用する

– 文字数は2000〜2500字を目安とする

– 記事末尾に「タイトル案」を3つ提示する

【タイトル案に関する重要な指示(厳守)】

– タイトル案は必ず「主タイトルのみ」を出力すること

– サブタイトル・説明文・補足文は一切付けないこと

– 記号(―、──、—、:、| 等)による分割は禁止

– タイトルは1文構成とし、文を分割しないこと

– 説明的・総括的・煽情的な表現は禁止

– 「問い」の形を基本とし、読者に思考の余白を残すこと

– 文字数は25〜35文字程度を目安とする

– 抽象語のみで終わらず、問いの対象が分かる表現を必ず含めること

– 参考タイトルと同一、または類似度の高い表現は使用しないこと

– 条件を満たさないタイトルは出力しないこと

【補足指示】

– 構造整理や概念整理が有効な箇所では、以下のようなコメントを挿入してよい

※(図:AI導入による責任構造の変化)

※(図:人間とAIの責任分担モデル)

【参考タイトル(※構造参考のみ/出力・言い換え・再利用は禁止)】

「AI時代、責任は誰が持つのか?」

【バージョン情報の出力】

記事本文・タイトル案のあとに、必ず以下の形式で

「AIバージョン情報」を追記してください。

(不明な項目は「不明」と記載すること)

—

AIバージョン情報

– ベンダー:

– モデル名:

– モデルバージョン:

– 回答日時:

## AIは今や「提案する存在」になった

かつて機械は、人間が決めたとおりに動くだけのものだった。しかし現在のAIは、膨大なデータから傾向を読み取り、未来を予測し、選択肢を提示する。採用すべき候補者を選び、融資の可否を判定し、配送ルートを最適化する。AIは単なる「道具」ではなく、「判断に近い何か」を行う存在へと変わりつつある。

この変化によって、私たちの働き方における「責任の所在」が揺らぎ始めている。AIが提案した結果を採用して問題が起きた場合、責任を負うのは誰なのか。AIを使った担当者か、AIを導入した企業か、それともAIを開発した技術者か。この問いは、もはや空想ではなく、現実のビジネスや職場で直面する課題となっている。

## 従来の責任構造はどう成り立っていたか

人間中心の労働社会では、責任の所在は比較的明確だった。それは以下のような構造で整理できる。

### 実行責任

作業を実際に行う人が負う責任。ミスや不備があれば、作業者に一定の責任が問われた。

### 判断責任

何をどう実行するかを決める管理者や意思決定者が負う責任。判断の誤りによる結果は、判断者が引き受けるべきものとされた。

### 制度責任

企業や社会、法律が担う責任。個人では対処しきれない構造的な問題や、組織としての過失に対する責任。

この三層構造において、「誰が何を決め、誰が何を実行したか」は比較的明確だった。だからこそ、問題が起きたときに責任の所在を特定することができたのである。

## AI導入は責任の「位置」を変える

AIが労働に組み込まれると、この責任構造に変化が生じる。

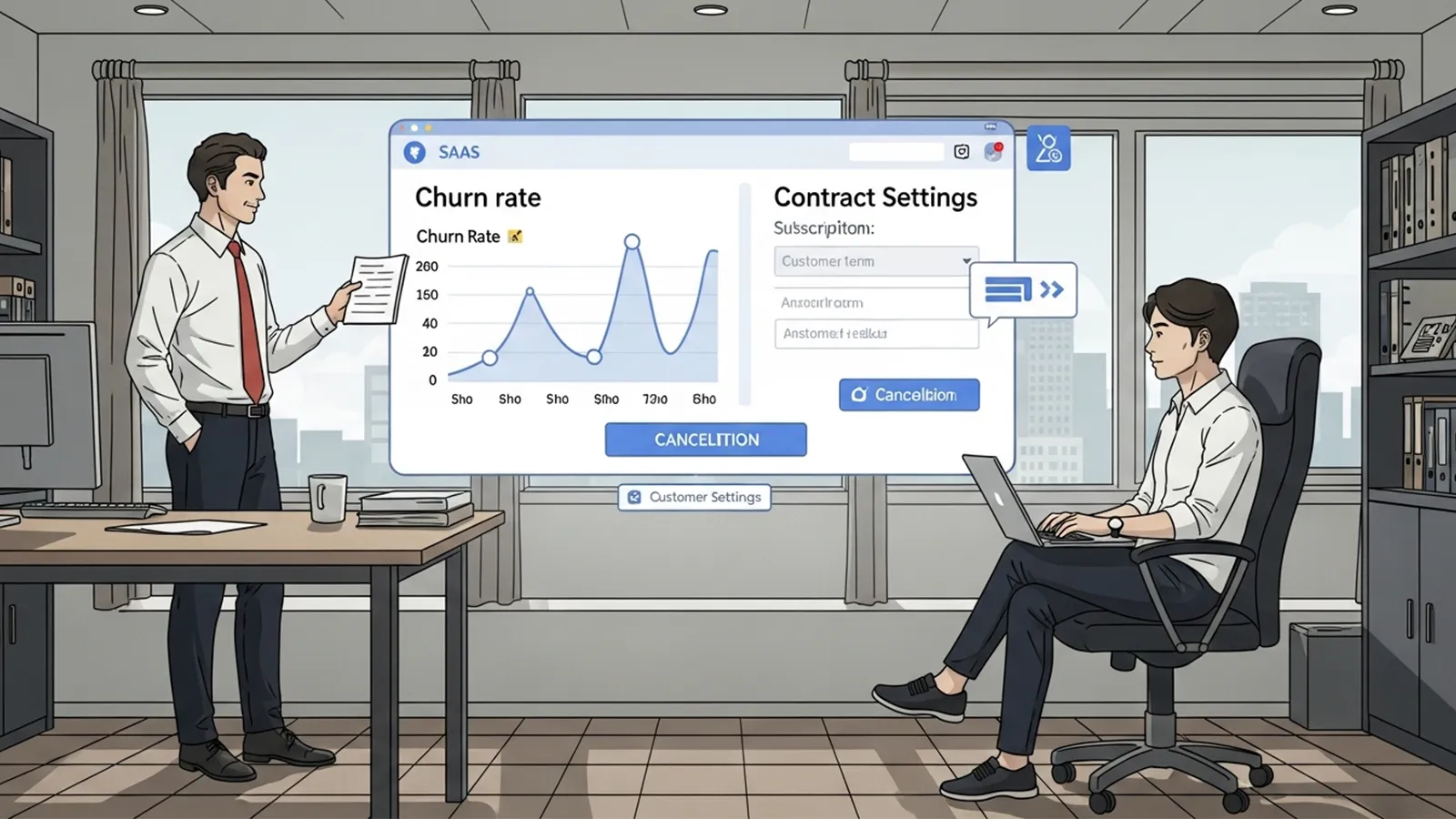

### 実行と判断の境界が曖昧になる

AIは「実行」だけでなく「判断に近い処理」も行う。たとえば与信審査AIは、データから融資の可否を「判断」する。この場合、AIは実行者なのか、判断者なのか。その境界は従来の枠組みでは説明しきれない。

### 「AIが提案し、人間が承認する」構造の増加

多くの現場では、「AIが候補を提示し、人間が最終決定する」という形が採用されている。しかし人間の判断は、実質的にはAIの提案に依存している場合が多い。この構造では、判断責任は人間にあるのか、それともAIの設計者にあるのか。責任の所在が曖昧になる。

### 責任は消えるのではなく「分散」する

AIによって責任がなくなるわけではない。むしろ責任は、利用者・開発者・提供企業・制度設計者といった複数の主体に分散し、それぞれの範囲が曖昧化する。この「曖昧さ」こそが、AI時代における責任問題の本質である。

※(図:AI導入による責任の分散構造)

## AI時代に人間が負う責任の形

では、AI時代において人間が担うべき責任とは何か。

### 判断そのものではなく「判断を設計・監督する責任」

AIが提案を行う社会では、人間の役割は「何を判断するか」ではなく、「どういう判断をAIに任せるか」を決めることになる。どのデータを使い、どの基準で評価し、どこまでをAIに委ねるか。その設計と監督が人間の責任となる。

### AIの結果を採用するかを決める責任

AIが提案した内容を鵜呑みにするのではなく、その妥当性を吟味し、採用の可否を判断する責任。これは単なる「承認作業」ではなく、AIの限界や偏りを理解したうえでの意思決定を意味する。

### AIをどこまで使うかを決める責任

すべてをAIに任せるのではなく、どの領域は人間が判断すべきかを見極める責任。効率化と人間の関与のバランスを取る判断が求められる。

## 重要なのは「作業」ではなく「責任の設計」

AI時代における労働の価値は、単なる「作業の遂行」ではなく、「責任をどう設計し、どう負うか」という視点で再定義される可能性がある。

### 役割の再整理が進む

従来の「作業者」「判断者」という区分に加え、「設計者」「監督者」という役割が重要になる。AIに何をさせ、人間が何を見守るか。その境界を引く役割が、AI時代の労働における核心となる。

### 同じ職種でも責任範囲で価値が変わる

同じ職種であっても、AIの判断をそのまま採用する人と、AIの設計や監督に関与する人では、責任の範囲が異なる。そしてその責任範囲こそが、労働における価値を決める要因になる可能性がある。

※(図:AI時代における人間の役割モデル)

## まとめ:責任は消えず、位置が変わる

AIの普及によって、労働における責任の所在が「明確→曖昧」へと変化しつつある。しかしそれは、責任が消えることを意味しない。責任は、実行から設計へ、判断から監督へと、その位置を変えていく。

この変化を前にして私たちができるのは、自分の仕事における「責任の位置」を見つめ直すことだろう。自分は何を判断し、何を設計し、何を監督しているのか。AIが担う部分と、人間が担うべき部分の境界はどこにあるのか。

AI時代の労働とは、作業の効率化だけでなく、責任の再配置というプロセスでもある。その構造を理解することが、これからの働き方を考える第一歩となる。

—

## タイトル案

1. AIが判断を始めた時、人間の責任はどこへ向かうのか

2. 責任の所在が曖昧になる時代に、人間は何を負うべきか

3. AI時代の労働で問われるのは、作業か責任の設計か

—

AIバージョン情報

– ベンダー: Anthropic

– モデル名: Claude

– モデルバージョン: claude-sonnet-4-20250514

– 回答日時: 2026年2月13日

本サイトの編集方針については「編集方針・AI利用ポリシー」をご覧ください。