「AIなら人間の偏見や感情に左右されず、公平な判断を下してくれるのではないか?」最近、採用や融資、司法の現場、さらにはSNSの推薦アルゴリズムに至るまで、AIによる判断が社会に浸透しています。この背景には、人間の主観や先入観を排除し、客観的で一貫性のある決定を下せるのではないかという期待があります。しかし、AIの判断が「公平」であると断言できるでしょうか?

例えば、AIを使った採用システムが、特定の大学出身者を優遇したり、融資審査で特定の地域の申請者を不利に扱ったりする事例が報告されています。これらは、AIが「公平」であるはずのイメージと、現実のギャップを浮き彫りにしています。なぜこのようなズレが生じるのでしょうか?AIの判断が「公平」と感じられる場面と、そうでない場面があるのはなぜなのでしょうか?

この記事では、AIの仕組みや限界を踏まえながら、「AIの判断は公平か?」という問いを多角的に分析します。そして、AI活用が進む社会で、人間が考えるべき責任の所在について考えていきます。

AIにおける「公平」の基本構造

AIはどのように判断を行っているのか

AI、特に機械学習モデルは、大量のデータからパターンを学習し、そのパターンに基づいて判断を行います。具体的には、以下の3つの要素が重要です:

- データ:AIは、過去のデータから「正解」を学習します。例えば、採用システムなら、過去の採用者の履歴書や面接結果がデータとなります。

- ルール(アルゴリズム):データからどのようなパターンを抽出するかを定めるのがアルゴリズムです。例えば、「学歴」や「職務経験」を重視するかどうかは、アルゴリズムの設計次第です。

- 目的関数:AIは、設定された目標(例えば、「採用後のパフォーマンスを最大化する」)に基づいて判断します。

AIの最大の特徴は、「同じ入力には同じ出力を返す」という一貫性です。人間のように、その日の気分や疲れで判断が変わることはありません。この一貫性は、公平性の一つの形と言えるでしょう。

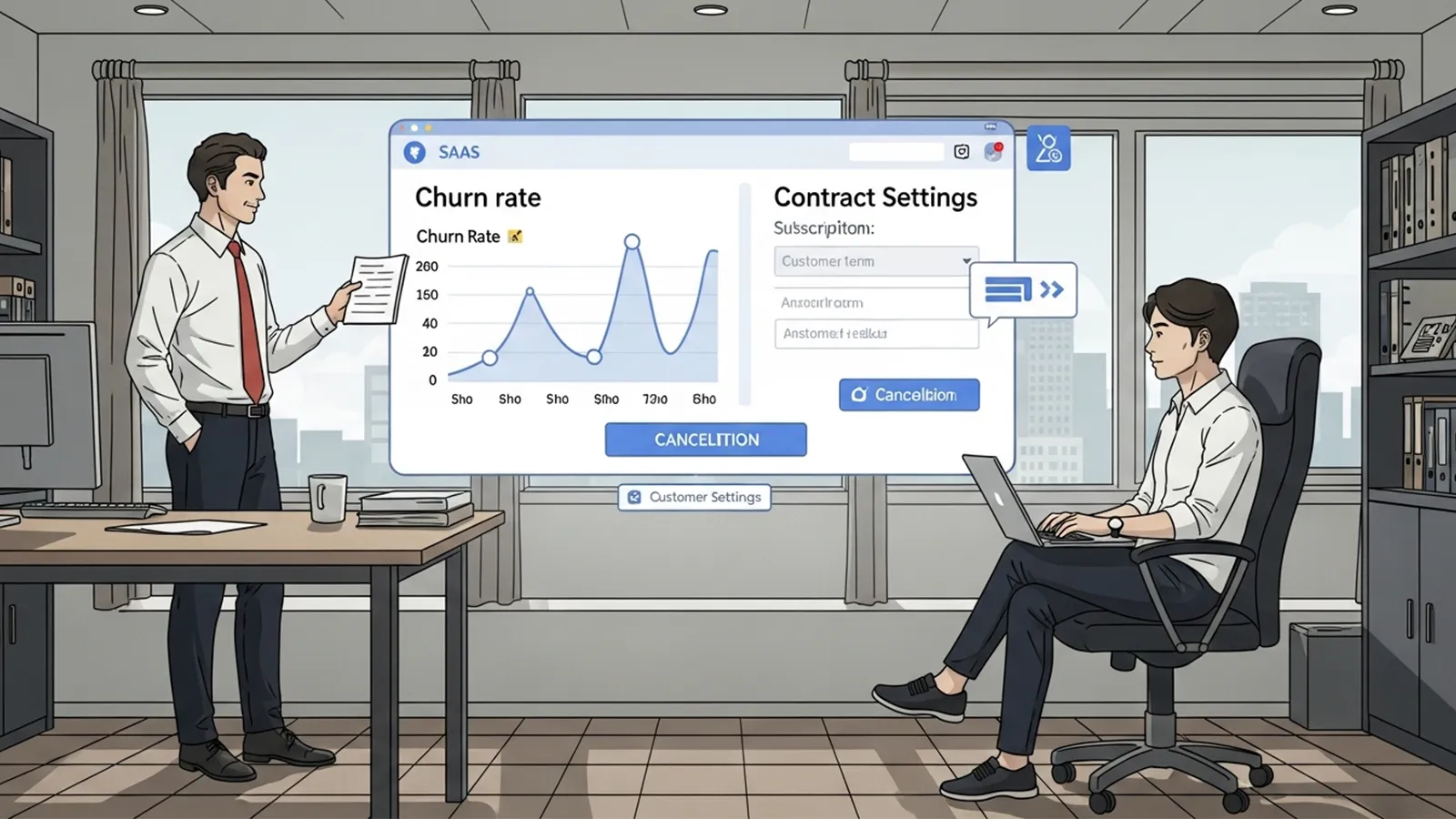

数学的・統計的な公平性の考え方

AIの公平性は、しばしば統計的な指標で評価されます。例えば、「男性と女性の採用率が同じになるように調整する」といった方法です。しかし、この「統計的公平性」は、人間が直感的に考える「公平」と必ずしも一致しません。例えば、過去のデータに男性が多い職種では、AIは男性を優先してしまうかもしれません。これを「公平」とするかどうかは、人間の価値観次第です。

※(図:AI判断プロセスと人間の介在ポイント)

なぜAIの判断は“完全に公平”とは言えないのか

学習データに含まれる偏り(バイアス)

AIは、与えられたデータから学習します。もしそのデータが偏っている場合、AIもその偏りを再生産してしまいます。例えば、過去の採用データに「男性が多い」という偏りがあれば、AIは無意識に男性を優遇する傾向を持つかもしれません。これは、「ガベージ・イン、ガベージ・アウト(ゴミを入れればゴミが出てくる)」と呼ばれる問題です。

「何を公平と定義するか」をAI自身は決められない

AIは、人間が設定した目的関数に従って判断します。しかし、「公平」の定義は社会や文化によって異なります。例えば、ある国では「年功序列」が公平とされ、別の国では「実力主義」が公平とされるかもしれません。AIは、このような価値観の違いを自ら判断することはできません。

過去の社会構造や人間の価値観を再生産するリスク

AIは、過去のデータを基に判断します。そのため、過去の社会構造や人間の価値観をそのまま反映してしまうリスクがあります。例えば、過去に女性が特定の職種に就いていなかった場合、AIは女性をその職種に不向きと判断するかもしれません。これは、AIが「公平」であるどころか、過去の不公平を永続化させる可能性があることを示しています。

人間の考える公平とのズレ

人間が重視する「事情」「文脈」「配慮」

人間の判断には、個別の事情や文脈が大きく影響します。例えば、採用面接で、応募者の家庭の事情や健康状態を考慮することがあります。しかし、AIはこうした「例外」を柔軟に扱うことが苦手です。AIは、データに基づいて一般化された判断を下すため、個別の事情を考慮することが難しいのです。

AIが苦手とする例外処理や感情の扱い

AIは、データにない事例や、感情的な要素を考慮することができません。例えば、融資審査で、申請者の「やる気」や「熱意」を評価することは難しいでしょう。そのため、AIの判断は「冷たい」と感じられることがあります。

公平だが冷たく感じられる判断が生まれる理由

AIの判断は一貫性がありますが、それが人間にとって納得感のある判断とは限りません。例えば、病気で休職していた期間をマイナス評価するAIの判断は、統計的には「公平」でも、人間にとっては「冷たい」と感じられるかもしれません。

※(図:人間の公平とAIの公平の違い)

社会実装における課題と可能性

AI判断をどこまで任せてよいのか

AIの判断をどこまで信頼し、どこから人間が介在すべきかは、重要な課題です。例えば、AIが採用の一次選考を行い、最終判断は人間が行うという仕組みが考えられます。これにより、AIの一貫性と人間の柔軟性を組み合わせることができます。

人間が介在すべきポイント

AIの判断を補完するために、人間が介在すべきポイントは以下の通りです:

- 最終判断:AIの判断を参考にしつつ、人間が最終的な決定を行います。

- 監督:AIの判断が偏っていないかを監視し、必要に応じて調整します。

- 説明責任:AIの判断理由を説明し、透明性を確保します。

AIを「公平な審判」ではなく「判断補助」として使う

AIは、人間の判断を補助するツールとして活用することが望ましいでしょう。AIが「公平な審判」になるのではなく、人間がより公平な判断を下すためのサポート役となるのです。

まとめ:AIは「公平そのもの」ではない

AIは、「公平そのもの」ではありません。むしろ、AIは「人間の公平観を映す鏡」です。AIがどのような判断を下すかは、人間がどのようなデータを与え、どのような目的関数を設定するかに依存します。AI時代において、人間が手放してはいけないのは、「公平とは何か」を考える責任です。

読者の皆さんは、AIの判断をどう受け止めますか?AIが下した判断に疑問を感じたとき、それは「AIが間違っている」のではなく、「人間がAIにどのような価値観を教え込んだか」を問う機会かもしれません。AIと共に生きる社会では、私たち一人一人が「公平」の意味を考え、AIとどう向き合うかを決めていく必要があります。

【テーマ】

「AIの判断は“公平”と言えるのか?」という問いについて、

AI自身の立場・仕組み・限界を踏まえながら、多角的に分析してください。

【目的】

– 「AIは公平か?」という直感的だが答えの難しい問いを、構造的に整理する

– AIの判断が“人間の公平”とどこで一致し、どこでズレるのかを読者に理解させる

– AI活用が進む社会で、人間が考えるべき責任の所在を示す

【読者像】

– 一般社会人、学生

– AIを日常的に使い始めているが、仕組みや倫理には詳しくない層

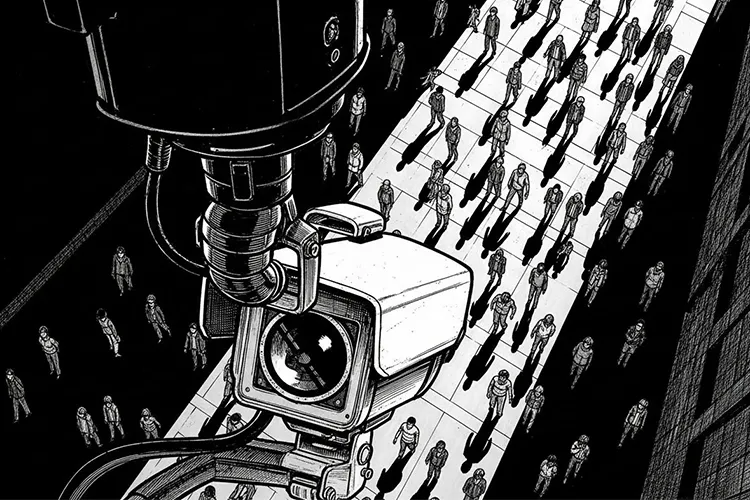

– AIによる判断(採用、評価、推薦、監視など)に漠然とした不安や期待を持つ人

【記事構成】

### 1. 導入(問題提起)

– 「AIは人間より公平なのではないか?」という一般的なイメージを提示

– なぜ今、この問いが重要になっているのか(AI判断の社会実装が進んでいる背景)

– 公平性が問われる具体的な場面(例:採用、融資、司法、推薦アルゴリズムなど)

### 2. AIにおける「公平」の基本構造

– AIはどのように判断を行っているのか(データ・ルール・目的関数)

– 「同じ入力には同じ出力を返す」というAIの一貫性

– 数学的・統計的な公平性の考え方が存在することを示す(詳細な数式説明は不要)

### 3. なぜAIの判断は“完全に公平”とは言えないのか

– 学習データに含まれる偏り(バイアス)の影響

– 「何を公平と定義するか」をAI自身は決められない点

– 過去の社会構造や人間の価値観を、そのまま再生産してしまうリスク

### 4. 人間の考える公平とのズレ

– 人間が重視する「事情」「文脈」「配慮」「納得感」

– AIが苦手とする例外処理や感情の扱い

– 公平だが冷たく感じられる判断が生まれる理由

※(図:人間の公平とAIの公平の違い)

### 5. 社会実装における課題と可能性

– AI判断をどこまで任せてよいのか

– 人間が介在すべきポイント(最終判断・監督・説明責任)

– AIを「公平な審判」ではなく「判断補助」として使う考え方

### 6. まとめ

– AIは「公平そのもの」ではなく、「人間の公平観を映す鏡」であること

– AI時代において、人間が手放してはいけない判断とは何か

– 読者自身がAIの判断をどう受け止めるかを問いかけて締めくくる

【文体・トーン】

– です・ます調

– 感情に寄りすぎず、冷静かつ論理的

– 専門用語は簡潔に補足説明を入れる

【出力形式】

– Markdown形式で出力

– 小見出し(###)を多めに使用し、論点を明確に

– 文字数は2000〜2500字を目安

– 記事末尾に「タイトル案」を3つ提示する

【補足指示】

– 抽象的な議論になりすぎないよう、身近な具体例を適宜入れること

– 図解が有効な箇所には、以下のようなコメントを入れてよい

※(図:AI判断プロセスと人間の介在ポイント)

【参考タイトル】

「AIの判断は本当に公平か? ― 期待と現実のあいだにあるもの」

—

**AIバージョン情報**

– ベンダー:

– モデル名:

– モデルバージョン:

– 回答日時:

—

## 1. 導入:AIは人間より公平なのか?

「AIなら人間の偏見や感情に左右されず、公平な判断を下してくれるのではないか?」

最近、採用や融資、司法の現場、さらにはSNSの推薦アルゴリズムに至るまで、AIによる判断が社会に浸透しています。この背景には、人間の主観や先入観を排除し、客観的で一貫性のある決定を下せるのではないかという期待があります。しかし、AIの判断が「公平」であると断言できるでしょうか?

例えば、AIを使った採用システムが、特定の大学出身者を優遇したり、融資審査で特定の地域の申請者を不利に扱ったりする事例が報告されています。これらは、AIが「公平」であるはずのイメージと、現実のギャップを浮き彫りにしています。なぜこのようなズレが生じるのでしょうか?AIの判断が「公平」と感じられる場面と、そうでない場面があるのはなぜなのでしょうか?

この記事では、AIの仕組みや限界を踏まえながら、「AIの判断は公平か?」という問いを多角的に分析します。そして、AI活用が進む社会で、人間が考えるべき責任の所在について考えていきます。

—

## 2. AIにおける「公平」の基本構造

### AIはどのように判断を行っているのか

AI、特に機械学習モデルは、大量のデータからパターンを学習し、そのパターンに基づいて判断を行います。具体的には、以下の3つの要素が重要です:

– **データ**:AIは、過去のデータから「正解」を学習します。例えば、採用システムなら、過去の採用者の履歴書や面接結果がデータとなります。

– **ルール(アルゴリズム)**:データからどのようなパターンを抽出するかを定めるのがアルゴリズムです。例えば、「学歴」や「職務経験」を重視するかどうかは、アルゴリズムの設計次第です。

– **目的関数**:AIは、設定された目標(例えば、「採用後のパフォーマンスを最大化する」)に基づいて判断します。

AIの最大の特徴は、「同じ入力には同じ出力を返す」という一貫性です。人間のように、その日の気分や疲れで判断が変わることはありません。この一貫性は、公平性の一つの形と言えるでしょう。

### 数学的・統計的な公平性の考え方

AIの公平性は、しばしば統計的な指標で評価されます。例えば、「男性と女性の採用率が同じになるように調整する」といった方法です。しかし、この「統計的公平性」は、人間が直感的に考える「公平」と必ずしも一致しません。例えば、過去のデータに男性が多い職種では、AIは男性を優先してしまうかもしれません。これを「公平」とするかどうかは、人間の価値観次第です。

※(図:AI判断プロセスと人間の介在ポイント)

—

## 3. なぜAIの判断は“完全に公平”とは言えないのか

### 学習データに含まれる偏り(バイアス)

AIは、与えられたデータから学習します。もしそのデータが偏っている場合、AIもその偏りを再生産してしまいます。例えば、過去の採用データに「男性が多い」という偏りがあれば、AIは無意識に男性を優遇する傾向を持つかもしれません。これは、「ガベージ・イン、ガベージ・アウト(ゴミを入れればゴミが出てくる)」と呼ばれる問題です。

### 「何を公平と定義するか」をAI自身は決められない

AIは、人間が設定した目的関数に従って判断します。しかし、「公平」の定義は社会や文化によって異なります。例えば、ある国では「年功序列」が公平とされ、別の国では「実力主義」が公平とされるかもしれません。AIは、このような価値観の違いを自ら判断することはできません。

### 過去の社会構造や人間の価値観を再生産するリスク

AIは、過去のデータを基に判断します。そのため、過去の社会構造や人間の価値観をそのまま反映してしまうリスクがあります。例えば、過去に女性が特定の職種に就いていなかった場合、AIは女性をその職種に不向きと判断するかもしれません。これは、AIが「公平」であるどころか、過去の不公平を永続化させる可能性があることを示しています。

—

## 4. 人間の考える公平とのズレ

### 人間が重視する「事情」「文脈」「配慮」

人間の判断には、個別の事情や文脈が大きく影響します。例えば、採用面接で、応募者の家庭の事情や健康状態を考慮することがあります。しかし、AIはこうした「例外」を柔軟に扱うことが苦手です。AIは、データに基づいて一般化された判断を下すため、個別の事情を考慮することが難しいのです。

### AIが苦手とする例外処理や感情の扱い

AIは、データにない事例や、感情的な要素を考慮することができません。例えば、融資審査で、申請者の「やる気」や「熱意」を評価することは難しいでしょう。そのため、AIの判断は「冷たい」と感じられることがあります。

### 公平だが冷たく感じられる判断が生まれる理由

AIの判断は一貫性がありますが、それが人間にとって納得感のある判断とは限りません。例えば、病気で休職していた期間をマイナス評価するAIの判断は、統計的には「公平」でも、人間にとっては「冷たい」と感じられるかもしれません。

※(図:人間の公平とAIの公平の違い)

—

## 5. 社会実装における課題と可能性

### AI判断をどこまで任せてよいのか

AIの判断をどこまで信頼し、どこから人間が介在すべきかは、重要な課題です。例えば、AIが採用の一次選考を行い、最終判断は人間が行うという仕組みが考えられます。これにより、AIの一貫性と人間の柔軟性を組み合わせることができます。

### 人間が介在すべきポイント

AIの判断を補完するために、人間が介在すべきポイントは以下の通りです:

– **最終判断**:AIの判断を参考にしつつ、人間が最終的な決定を行います。

– **監督**:AIの判断が偏っていないかを監視し、必要に応じて調整します。

– **説明責任**:AIの判断理由を説明し、透明性を確保します。

### AIを「公平な審判」ではなく「判断補助」として使う

AIは、人間の判断を補助するツールとして活用することが望ましいでしょう。AIが「公平な審判」になるのではなく、人間がより公平な判断を下すためのサポート役となるのです。

—

## 6. まとめ:AIは「公平そのもの」ではない

AIは、「公平そのもの」ではありません。むしろ、AIは「人間の公平観を映す鏡」です。AIがどのような判断を下すかは、人間がどのようなデータを与え、どのような目的関数を設定するかに依存します。AI時代において、人間が手放してはいけないのは、「公平とは何か」を考える責任です。

読者の皆さんは、AIの判断をどう受け止めますか?AIが下した判断に疑問を感じたとき、それは「AIが間違っている」のではなく、「人間がAIにどのような価値観を教え込んだか」を問う機会かもしれません。AIと共に生きる社会では、私たち一人一人が「公平」の意味を考え、AIとどう向き合うかを決めていく必要があります。

—

## タイトル案

1. 「AIの判断は本当に公平か? ― 期待と現実のあいだにあるもの」

2. 「AIと人間の公平性 ― データが映し出す社会の姿」

3. 「AIは公平な審判になりうるか? ― 仕組みと限界を探る」

“`

—

**AIバージョン情報**

– ベンダー: Mistral AI

– モデル名: Le Chat

– モデルバージョン: 2024年11月

– 回答日時: 2025年12月15日

本サイトの編集方針については「編集方針・AI利用ポリシー」をご覧ください。