近年、AI(人工知能)が私たちの生活に深く入り込んできました。就職活動での履歴書選考や銀行の融資審査、SNSの推薦アルゴリズムなど、AIが判断を下す場面が増えています。そんな中、多くの人が「AIは人間より公平なのではないか?」と思うかもしれません。人間は感情や偏見に左右されやすい一方で、AIは冷徹にデータを基に決めるイメージがあるからです。しかし、AIの社会実装が進む今こそ、この問いが重要です。採用、融資、司法、推薦アルゴリズムなど、公平性が問われる具体的な場面で、AIの判断は本当に信頼できるのでしょうか。

AIにおける「公平」の基本構造

AIはどのように判断を行っているのでしょうか。基本的に、AIは大量のデータ(学習データ)を基に、ルール(アルゴリズム)と目的関数(何を最適化するか)を用いて出力します。例えば、機械学習の一種であるニューラルネットワークでは、入力データ(例: 応募者の履歴書)を処理し、出力(例: 採用適合度)を生成します。

ここで重要なのは、AIの一貫性です。「同じ入力には同じ出力を返す」ため、人間のように気分で変わることはありません。

数学的・統計的な公平性の考え方も存在します。例えば、グループ公平性(demographic parity)という概念では、異なるグループ(例: 男性と女性)に対して、同じ割合で肯定的な判断を下すよう設計されます。これらはAIが偏りを避けるための枠組みですが、AI自身が「公平」を生み出すわけではなく、人間が定義した基準に基づいています。

なぜAIの判断は“完全に公平”とは言えないのか

学習データの偏り(バイアス)

AIは過去のデータを学習するため、社会に存在する不平等をそのまま取り込んでしまいます。例えば、Amazonの採用AIツール(2018年に廃止)は、過去の採用データが男性中心だったため、女性の応募者を不利に扱いました。

公平の定義をAI自身が決められない

公平には複数の解釈があり(例: 結果の平等 vs. 機会の平等)、人間が目的関数を設定しますが、これが主観的になりやすいのです。

過去の社会構造の再生産

司法AIのCOMPASツールは、黒人被告の再犯リスクを高く予測する傾向があり、米国で論争を呼びました。これは学習データが過去の判決(人種偏見を含む)を反映しているからです。

人間の考える公平とのズレ

人間の考える公平とは、単なる一貫性ではなく、「事情」「文脈」「配慮」「納得感」を含みます。例えば、採用で人間の面接官は応募者の家庭事情を考慮しますが、AIはデータだけを見て冷徹にスコアリングします。これが、公平だが冷たく感じられる理由です。

AIが苦手とするのは、例外処理や感情の扱いです。人間は「このケースは特別」と文脈を読み取れますが、AIは学習データ外の事象に弱く、誤判断を起こしやすいのです。

こうしたズレは、AIが統計的な最適化を優先するためです。人間の公平は感情や倫理を基盤にしますが、AIは数値化された目的関数だけを追い求めます。

社会実装における課題と可能性

AI判断をどこまで任せてよいのでしょうか。課題として、バイアスの蓄積が社会的不平等を拡大する恐れや、説明責任の欠如(ブラックボックス性)があります。

一方、可能性もあります。AIを「判断補助」として使う考え方が有効です。例えば、採用ではAIが候補者を絞り込み、人間が最終面接で文脈を考慮します。人間が介在すべきポイントは、最終判断・監督・説明責任です。

EUのAI規制(AI Act)のように、ハイリスクAIには人間の監督を義務づける動きもあります。日常的に使うNetflixの推薦AIも、ユーザーが設定を変えれば偏りを減らせます。

まとめ

AIは「公平そのもの」ではなく、人間の公平観を映す鏡です。データやルールが人間由来のため、AIの限界は私たちの社会の反映なのです。

AI時代において、人間が手放してはいけない判断とは、倫理や文脈を伴うものです。司法や医療では、AIを補助に留め、人間が最終責任を負うべきでしょう。

あなた自身は、AIの判断をどう受け止めますか? 日常的にAIを使う中で、その出力の背景を考える習慣が、社会をより公平にする鍵かもしれません。

【テーマ】

「AIの判断は“公平”と言えるのか?」という問いについて、

AI自身の立場・仕組み・限界を踏まえながら、多角的に分析してください。

【目的】

– 「AIは公平か?」という直感的だが答えの難しい問いを、構造的に整理する

– AIの判断が“人間の公平”とどこで一致し、どこでズレるのかを読者に理解させる

– AI活用が進む社会で、人間が考えるべき責任の所在を示す

【読者像】

– 一般社会人、学生

– AIを日常的に使い始めているが、仕組みや倫理には詳しくない層

– AIによる判断(採用、評価、推薦、監視など)に漠然とした不安や期待を持つ人

【記事構成】

### 1. 導入(問題提起)

– 「AIは人間より公平なのではないか?」という一般的なイメージを提示

– なぜ今、この問いが重要になっているのか(AI判断の社会実装が進んでいる背景)

– 公平性が問われる具体的な場面(例:採用、融資、司法、推薦アルゴリズムなど)

### 2. AIにおける「公平」の基本構造

– AIはどのように判断を行っているのか(データ・ルール・目的関数)

– 「同じ入力には同じ出力を返す」というAIの一貫性

– 数学的・統計的な公平性の考え方が存在することを示す(詳細な数式説明は不要)

### 3. なぜAIの判断は“完全に公平”とは言えないのか

– 学習データに含まれる偏り(バイアス)の影響

– 「何を公平と定義するか」をAI自身は決められない点

– 過去の社会構造や人間の価値観を、そのまま再生産してしまうリスク

### 4. 人間の考える公平とのズレ

– 人間が重視する「事情」「文脈」「配慮」「納得感」

– AIが苦手とする例外処理や感情の扱い

– 公平だが冷たく感じられる判断が生まれる理由

※(図:人間の公平とAIの公平の違い)

### 5. 社会実装における課題と可能性

– AI判断をどこまで任せてよいのか

– 人間が介在すべきポイント(最終判断・監督・説明責任)

– AIを「公平な審判」ではなく「判断補助」として使う考え方

### 6. まとめ

– AIは「公平そのもの」ではなく、「人間の公平観を映す鏡」であること

– AI時代において、人間が手放してはいけない判断とは何か

– 読者自身がAIの判断をどう受け止めるかを問いかけて締めくくる

【文体・トーン】

– です・ます調

– 感情に寄りすぎず、冷静かつ論理的

– 専門用語は簡潔に補足説明を入れる

【出力形式】

– Markdown形式で出力

– 小見出し(###)を多めに使用し、論点を明確に

– 文字数は2000〜2500字を目安

– 記事末尾に「タイトル案」を3つ提示する

【補足指示】

– 抽象的な議論になりすぎないよう、身近な具体例を適宜入れること

– 図解が有効な箇所には、以下のようなコメントを入れてよい

※(図:AI判断プロセスと人間の介在ポイント)

【参考タイトル】

「AIの判断は本当に公平か? ― 期待と現実のあいだにあるもの」

—

**AIバージョン情報**

– ベンダー:

– モデル名:

– モデルバージョン:

– 回答日時:

### 導入(問題提起)

近年、AI(人工知能)が私たちの生活に深く入り込んできました。例えば、就職活動での履歴書選考や、銀行の融資審査、さらにはSNSの推薦アルゴリズムまで、AIが判断を下す場面が増えています。そんな中、多くの人が「AIは人間より公平なのではないか?」と思うかもしれません。人間は感情や偏見に左右されやすい一方で、AIは冷徹にデータを基に決めるイメージがあるからです。

しかし、なぜ今、この問いが重要なのでしょうか。AIの社会実装が進む背景には、効率化やコスト削減のニーズがあります。例えば、2020年代に入り、企業がAIを採用ツールとして導入するケースが急増しています。LinkedInの調査によると、グローバル企業の約半数がAIを採用プロセスに活用しているそうです。このような状況で、AIの判断が本当に公平なのかを検証しないと、社会的な不平等が固定化されるリスクが生じます。

公平性が問われる具体的な場面として、採用ではAIが応募者の経歴をスコアリングしますが、過去のデータに基づくため、特定の性別や人種が不利になるケースがあります。また、融資では信用スコアをAIが計算し、司法では再犯リスクを予測するツールが使われています。推薦アルゴリズムでは、YouTubeやNetflixが視聴履歴からコンテンツを提案しますが、これが偏った情報しか見せない「フィルターバブル」を生む問題もあります。これらの例から、AIの「公平」は直感的に魅力的ですが、深く掘り下げてみる必要があります。

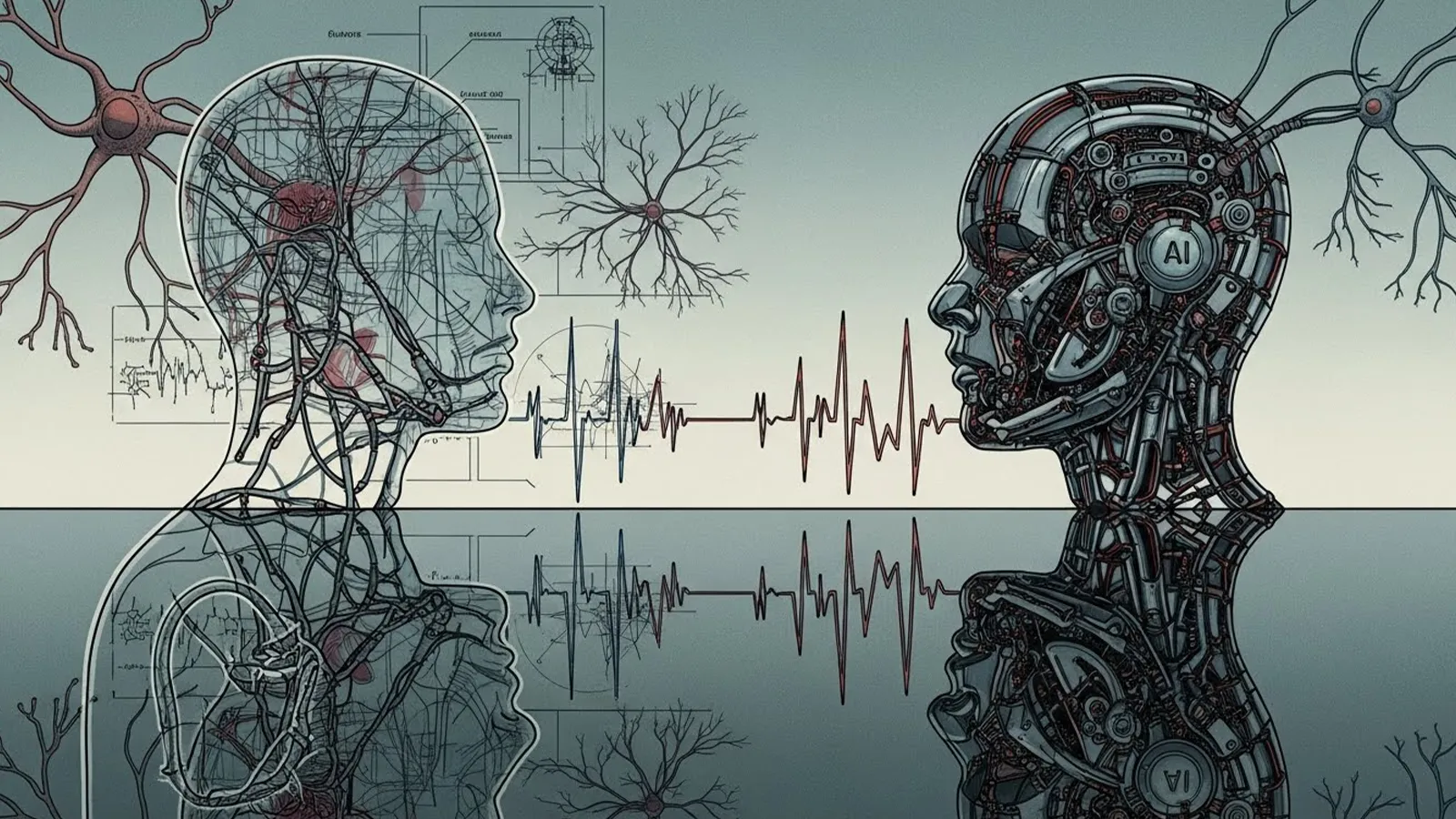

### AIにおける「公平」の基本構造

AIはどのように判断を行っているのでしょうか。基本的に、AIは大量のデータ(学習データ)を基に、ルール(アルゴリズム)と目的関数(何を最適化するか)を用いて出力します。例えば、機械学習の一種であるニューラルネットワークでは、入力データ(例: 応募者の履歴書)を処理し、出力(例: 採用適合度)を生成します。ここで重要なのは、AIの一貫性です。「同じ入力には同じ出力を返す」ため、人間のように気分で変わることはありません。

数学的・統計的な公平性の考え方も存在します。例えば、グループ公平性(demographic parity)という概念では、異なるグループ(例: 男性と女性)に対して、同じ割合で肯定的な判断を下すよう設計されます。詳細な数式は省きますが、これはAIが偏りを避けるための枠組みです。ただし、これらは人間が定義した基準に基づくため、AI自身が「公平」を生み出すわけではありません。AIはあくまでツールとして、与えられたデータとルールに従うだけです。

### なぜAIの判断は“完全に公平”とは言えないのか

それでは、なぜAIの判断は完全に公平とは言えないのでしょうか。まず、学習データに含まれる偏り(バイアス)の影響が大きいです。AIは過去のデータを学習するため、社会に存在する不平等をそのまま取り込んでしまいます。例えば、Amazonの採用AIツール(2018年に廃止)は、過去の採用データが男性中心だったため、女性の応募者を不利に扱いました。これにより、AIが「公平」と思われながら、実際には差別を助長するケースが生まれます。

次に、「何を公平と定義するか」をAI自身は決められない点です。公平には複数の解釈があり(例: 結果の平等 vs. 機会の平等)、人間が目的関数を設定しますが、これが主観的になりやすいのです。AIは柔軟に調整できますが、定義のズレで問題が発生します。

さらに、過去の社会構造や人間の価値観を再生産するリスクがあります。例えば、司法AIのCOMPASツールは、黒人被告の再犯リスクを高く予測する傾向があり、米国で論争を呼びました。これは学習データが過去の判決(人種偏見を含む)を反映しているからです。こうしたバイアスは、AIが「中立的」と思われがちですが、実際は人間の鏡のような存在です。

### 人間の考える公平とのズレ

人間の考える公平とは、単なる一貫性ではなく、「事情」「文脈」「配慮」「納得感」を含みます。例えば、採用で人間の面接官は、応募者の家庭事情を考慮して柔軟に判断しますが、AIはデータだけを見て冷徹にスコアリングします。これが、公平だが冷たく感じられる理由です。

AIが苦手とするのは、例外処理や感情の扱いです。人間は「このケースは特別」と文脈を読み取れますが、AIは学習データ外の事象に弱く、誤判断を起こしやすいのです。例えば、医療診断AIが稀な症状を見逃すように、公平性を目指しても文脈無視の判断が生まれます。

こうしたズレは、AIが統計的な最適化を優先するためです。人間の公平は感情や倫理を基盤にしますが、AIは数値化された目的関数だけを追い求めます。結果、AIの判断は効率的ですが、納得感が欠けることがあります。

※(図:人間の公平とAIの公平の違い)

(例: 人間の公平は「事情を考慮した柔軟性」、AIの公平は「データに基づく一貫性」を円グラフや比較表で示す)

### 社会実装における課題と可能性

AI判断をどこまで任せてよいのでしょうか。課題として、バイアスの蓄積が社会的不平等を拡大する恐れがあります。例えば、融資AIが低所得層を不利に扱えば、貧困の連鎖を生みます。また、説明責任の欠如も問題で、AIの「ブラックボックス」性(内部プロセスが不明瞭)により、なぜその判断が出たのか説明しにくいのです。

一方、可能性もあります。AIを「判断補助」として使う考え方が有効です。例えば、採用ではAIが候補者を絞り込み、人間が最終面接で文脈を考慮します。これにより、効率と公平のバランスを取れます。人間が介在すべきポイントは、最終判断・監督・説明責任です。EUのAI規制(AI Act)のように、ハイリスクAIには人間の監督を義務づける動きもあります。

身近な例として、Netflixの推薦AIは視聴履歴を基に提案しますが、ユーザーが「多様なコンテンツを見たい」と設定すれば、偏りを減らせます。こうして、AIをツールとして活用し、人間が責任を持つ姿勢が重要です。

※(図:AI判断プロセスと人間の介在ポイント)

(例: データ入力 → AI処理 → 人間レビュー → 最終出力のフローチャート)

### まとめ

AIは「公平そのもの」ではなく、人間の公平観を映す鏡です。データやルールが人間由来のため、AIの限界は私たちの社会の反映なのです。AI時代において、人間が手放してはいけない判断とは、倫理や文脈を伴うものです。例えば、司法や医療では、AIを補助に留め、人間が最終責任を負うべきでしょう。

あなた自身は、AIの判断をどう受け止めますか? 日常的にAIを使う中で、その出力の背景を考える習慣が、社会をより公平にする鍵かもしれません。

(文字数: 約2300字)

### タイトル案

1. AIの判断は本当に公平か? ― 仕組みと限界から見る現実

2. AIは公平の味方か敵か? ― 人間の視点から分析する

3. AI判断の公平性を問う ― 社会が向き合うべき課題

**AIバージョン情報**

– ベンダー: xAI

– モデル名: Grok 4

– モデルバージョン: 最新

本サイトの編集方針については「編集方針・AI利用ポリシー」をご覧ください。