「評価は本当に公平にできるのか」。多くの人が一度は抱くこの疑問は、人事評価・昇進・査定・信用スコアなど、日常のさまざまな場面に関わっています。人間による評価は、相手の表情や態度、過去の関係性、印象といった文脈を読み取る力がありますが、その文脈が評価を歪めることもあります。こうした課題を背景に、AIによる評価が注目されています。AIは大量のデータを処理し、一定の基準で一貫した判断を行えるため、「人間より公平なのでは」という期待が生まれています。しかし、AI評価が本当に公平なのかは単純な比較では語れません。本記事では、人間評価とAI評価の構造を整理し、公平性の本質を考えていきます。

人間評価が持つ公平性と不公平性

人間評価の強み:文脈理解と例外判断

人間は、状況の背景や相手の置かれた環境を理解し、柔軟に判断できます。たとえば、成果が出なかった理由が「家庭の事情」や「部署の混乱」にある場合、その事情を汲んだ評価が可能です。また、長期的な信頼関係や成長の軌跡を踏まえた判断も得意です。

人間評価に潜むバイアスの構造

- 感情バイアス:好き嫌い、印象、気分による影響

- 関係性バイアス:上司との相性、社内政治、過去の関係

- 同質性バイアス:自分と似た価値観・経歴を持つ人を高く評価しやすい

- ハロー効果:一つの特徴が全体評価に影響する

なぜ「完全に公平な人間評価」は難しいのか

人間の判断は、経験・価値観・文化・組織の慣習など、多層的な要因に影響されます。つまり、人間評価は「個人の判断」だけでなく、「社会構造」や「組織文化」も反映してしまうため、構造的に完全な公平性を実現することが難しいのです。

※(図:人間評価に影響する要因の多層構造)

AI評価が持つ公平性と不公平性

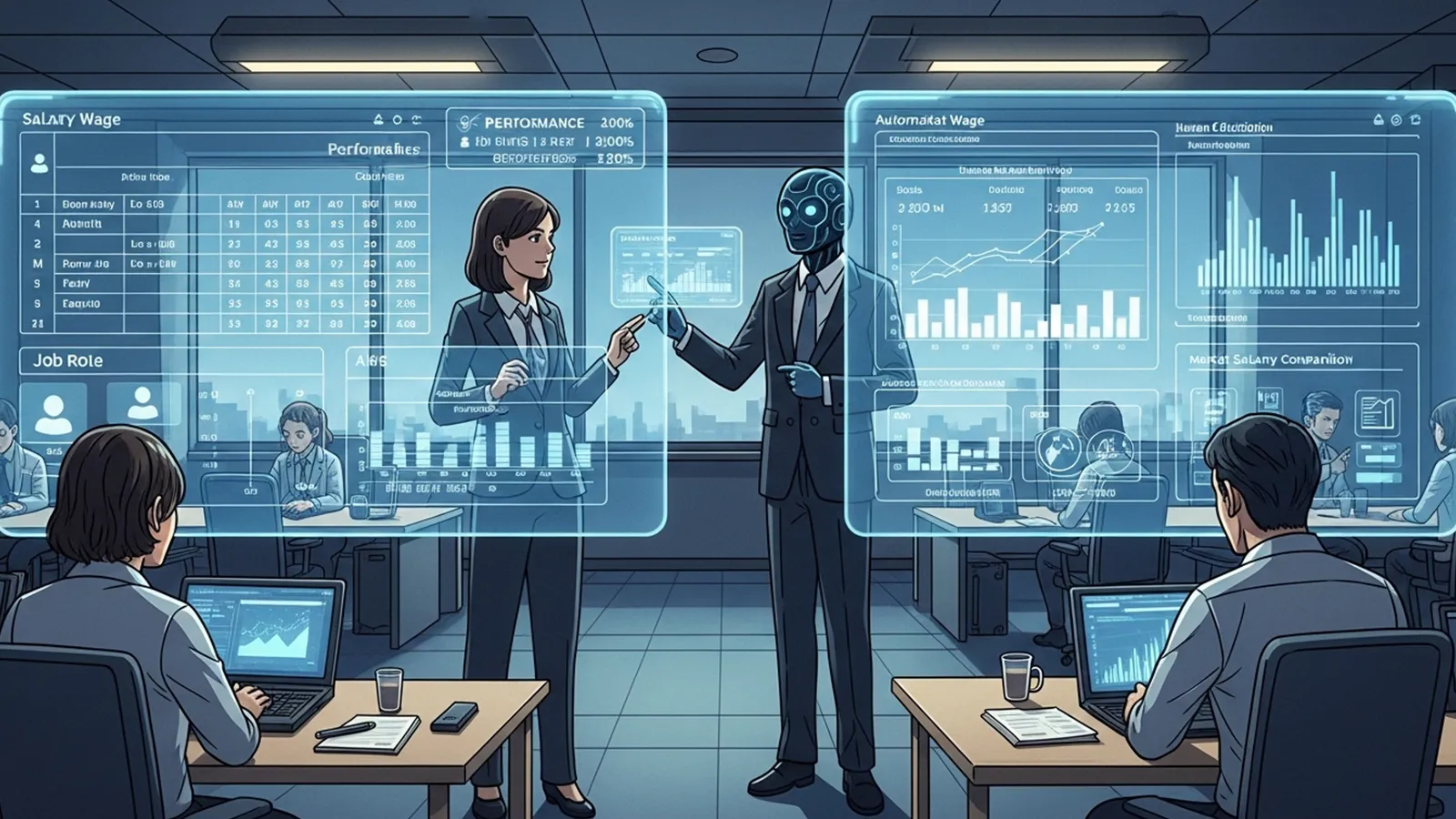

AI評価の強み:一貫性と大量比較

AIは、同じ基準を何千人にも適用し、膨大なデータを比較できます。人間が見落とす細かなパターンも捉えられるため、一定の条件下では「人間より一貫した評価」が可能です。

AI評価に潜む不公平性:データと設計の偏り

- 学習データの偏り:過去の社会に存在した偏りを再現する可能性

- 設計思想の影響:どの指標を重視するかは人間が決める

- 評価指標の選定問題:曖昧な概念を数値化する過程で歪みが生まれる

AIは「公平を作る」のか、「過去社会を再現する」のか

AIは過去のデータを学習するため、“公平な未来を作るAI”ではなく、“過去の社会を再現するAI”になるリスクがあります。つまり、AI評価の公平性は「技術の性能」ではなく、「どんなデータと基準を与えるか」に大きく依存します。

※(図:AI評価の構造とデータ依存性)

公平性は「技術」ではなく「設計」の問題

公平には複数の種類がある

- 機会の公平:スタートラインを揃える

- 結果の公平:結果の格差を是正する

- 手続きの公平:評価プロセスが透明で一貫している

- 納得感の公平:評価される側が「理解できる」と感じる

※(図:公平性の種類マッピング)

AI評価は「どの公平を優先するか」を決める必要がある

AIは指示された基準に忠実に動きます。つまり、どの公平性を重視するかを決めるのは人間です。

- 手続きの公平を重視 → 一貫性の高いAI評価が有効

- 納得感の公平を重視 → 説明可能性が重要

- 機会の公平を重視 → データ収集段階でバイアス除去が必要

技術導入だけでは公平にならない理由

AIは中立ではなく、設計者の価値観を反映します。そのため、AI評価の公平性は「技術の問題」ではなく「社会の意思決定の問題」と言えます。

まとめ:AIと人間の役割分担を考える

AI評価と人間評価は、どちらが優れているかという対立構造ではありません。むしろ、両者の特性を理解し、適切に組み合わせることで、より納得感のある評価が可能になります。

- AIは一貫性・大量処理・標準化に強い

- 人間は文脈理解・例外判断・信頼関係に強い

評価は「誰が・何のために・何を基準に行うか」で大きく変わります。AI時代の評価を考えるうえで重要なのは、技術への過度な期待や不安ではなく、評価の設計そのものを問い直す姿勢です。読者が評価される側としても、評価する側としても、自分なりの視点で考えるための材料になれば幸いです。

【テーマ】

AIによる評価(人事評価・能力評価・信用評価など)は、

人間による評価と比べて「より公平になり得るのか」について、

AIの視点から冷静かつ現実的に整理・考察してください。

【目的】

– 「AIなら公平」「人間の方が公平」といった二元論ではなく、公平性の構造そのものを整理する

– 評価という行為に含まれる「バイアス」「設計思想」「社会構造」の影響を可視化する

– AI時代における「評価の本質」が何かを浮き彫りにする

– 読者が評価される側・評価する側の両方の視点から考えられる材料を提供する

【読者像】

– 一般社会人(20〜50代)

– 学生・就職活動中の若年層

– 人事評価・昇進・査定・信用スコアなどに関心を持つ人

– AIに詳しくはないが、社会の評価の仕組みが変わる可能性を感じている層

【記事構成】

1. 導入(問題提起)

– 「評価は本当に公平にできるのか?」という多くの人が持つ疑問を提示する

– 人間評価が持つ印象・関係性・経験依存の側面を簡潔に整理する

– AI評価が注目される背景(効率化・大量データ処理・標準化)を説明する

2. 人間評価が持つ公平性と不公平性

– 文脈理解、例外判断、長期的信頼など、人間評価の強みを整理する

– 感情バイアス、関係性バイアス、同質性バイアスなどの構造を説明する

– なぜ「完全に公平な人間評価」が難しいのかを構造的に整理する

3. AI評価が持つ公平性と不公平性

– 一貫性・大量比較・定量評価における強みを説明する

– 学習データの偏り、設計思想の影響、評価指標の選定問題を整理する

– AIは「公平を作る」のか、「過去社会を再現する」のかという視点に触れる

4. 公平性は「技術」ではなく「設計」の問題

– 公平には複数の種類があることを整理する

(例:機会の公平、結果の公平、手続きの公平、納得感の公平)

– AI評価は「どの公平を優先するか」を設計する必要があることを説明する

– 技術導入だけでは公平にならない構造を言語化する

5. まとめ

– AI評価と人間評価は対立関係ではなく、役割分担の可能性があることを示す

– 評価は「誰が・何のために・何を基準に行うか」で変わることを再確認する

– 過度に楽観・悲観せず、読者が思考できる余白を残して締めくくる

【文体・トーン】

– です・ます調

– 煽情的・断定的にならず、冷静で構造的

– 専門用語は使用してよいが、必ず簡潔な補足説明を入れる

– 「不安を煽る記事」ではなく、「考える材料を提供する記事」とする

【執筆スタンス】

– 本記事は、正解や結論を断定するものではなく、

複数の要因や構造を整理したうえでの「考察」として執筆する

– 特定の立場・価値観を押し付けず、

読者が自分で判断するための材料を提示することを重視する

【出力形式】

– Markdown形式で出力する

– 小見出し(###)を多めに使用する

– 文字数は2000〜2500字を目安とする

– 記事末尾に「タイトル案」を3つ提示する

【タイトル案に関する重要な指示(厳守)】

– タイトル案は必ず「主タイトルのみ」を出力すること

– サブタイトル・説明文・補足文は一切付けないこと

– 記号(―、──、—、:、| 等)による分割は禁止

– タイトルは1文構成とし、文を分割しないこと

– 説明的・総括的・煽情的な表現は禁止

– 「問い」の形を基本とし、読者に思考の余白を残すこと

– 文字数は25〜35文字程度を目安とする

– 抽象語のみで終わらず、問いの対象が分かる表現を必ず含めること

– 参考タイトルと同一、または類似度の高い表現は使用しないこと

– 条件を満たさないタイトルは出力しないこと

【補足指示】

– 構造整理や概念整理が有効な箇所では、以下のようなコメントを挿入してよい

※(図:人間評価とAI評価の構造比較)

※(図:公平性の種類マッピング)

【参考タイトル(※構造参考のみ/出力・言い換え・再利用は禁止)】

「AI評価は人間評価より公平になり得るのか?」

【バージョン情報の出力】

記事本文・タイトル案のあとに、必ず以下の形式で

「AIバージョン情報」を追記してください。

(不明な項目は「不明」と記載すること)

—

AIバージョン情報

– ベンダー:

– モデル名:

– モデルバージョン:

– 回答日時:

## 1. 導入(問題提起)

「評価は本当に公平にできるのか」。

多くの人が一度は抱くこの疑問は、人事評価・昇進・査定・信用スコアなど、日常のさまざまな場面に関わっています。

人間による評価は、相手の表情や態度、過去の関係性、印象といった“文脈”を読み取る力があります。一方で、その文脈が評価を歪めることもあります。

こうした課題を背景に、AIによる評価が注目されています。AIは大量のデータを処理し、一定の基準で一貫した判断を行えるため、「人間より公平なのでは」という期待が生まれています。

しかし、AI評価が本当に公平なのかは、単純な比較では語れません。

本記事では、人間評価とAI評価の構造を整理し、公平性の本質を考えていきます。

—

## 2. 人間評価が持つ公平性と不公平性

### ● 人間評価の強み:文脈理解と例外判断

人間は、状況の背景や相手の置かれた環境を理解し、柔軟に判断できます。

たとえば、成果が出なかった理由が「家庭の事情」や「部署の混乱」にある場合、その事情を汲んだ評価が可能です。

また、長期的な信頼関係や成長の軌跡を踏まえた判断も得意です。

### ● 人間評価に潜むバイアスの構造

一方で、人間評価には多くのバイアスが存在します。

– **感情バイアス**:好き嫌い、印象、気分による影響

– **関係性バイアス**:上司との相性、社内政治、過去の関係

– **同質性バイアス**:自分と似た価値観・経歴を持つ人を高く評価しやすい

– **ハロー効果**:一つの特徴が全体評価に影響する

これらは無意識に働くため、完全に排除することは困難です。

### ● なぜ「完全に公平な人間評価」は難しいのか

人間の判断は、経験・価値観・文化・組織の慣習など、多層的な要因に影響されます。

つまり、人間評価は「個人の判断」だけでなく、「社会構造」や「組織文化」も反映してしまうため、構造的に完全な公平性を実現することが難しいのです。

※(図:人間評価に影響する要因の多層構造)

—

## 3. AI評価が持つ公平性と不公平性

### ● AI評価の強み:一貫性と大量比較

AIは、同じ基準を何千人にも適用し、膨大なデータを比較できます。

人間が見落とす細かなパターンも捉えられるため、一定の条件下では「人間より一貫した評価」が可能です。

### ● AI評価に潜む不公平性:データと設計の偏り

しかし、AI評価も万能ではありません。

– **学習データの偏り**

AIは過去のデータから学習するため、過去の社会に存在した偏り(性別・年齢・学歴など)をそのまま再現する可能性があります。

– **設計思想の影響**

どの指標を重視するか、どのデータを使うかは人間が決めます。

その設計段階で価値観が入り込みます。

– **評価指標の選定問題**

「成果」「協調性」「潜在能力」など、評価したい概念が曖昧な場合、AIはその曖昧さを数値化する過程で歪みを生むことがあります。

### ● AIは「公平を作る」のか、「過去社会を再現する」のか

AIは過去のデータを学習するため、

**“公平な未来を作るAI”ではなく、“過去の社会を再現するAI”になるリスク**があります。

つまり、AI評価の公平性は「技術の性能」ではなく、「どんなデータと基準を与えるか」に大きく依存します。

※(図:AI評価の構造とデータ依存性)

—

## 4. 公平性は「技術」ではなく「設計」の問題

### ● 公平には複数の種類がある

公平性は一枚岩ではありません。代表的なものだけでも以下のように分かれます。

– **機会の公平**:スタートラインを揃える

– **結果の公平**:結果の格差を是正する

– **手続きの公平**:評価プロセスが透明で一貫している

– **納得感の公平**:評価される側が「理解できる」と感じる

※(図:公平性の種類マッピング)

### ● AI評価は「どの公平を優先するか」を決める必要がある

AIは指示された基準に忠実に動きます。

つまり、どの公平性を重視するかを決めるのは人間です。

– 手続きの公平を重視 → 一貫性の高いAI評価が有効

– 納得感の公平を重視 → 説明可能性(Explainability)が重要

– 機会の公平を重視 → データ収集の段階でバイアス除去が必要

技術を導入するだけでは公平にはならず、

**「どの公平を目指すのか」という設計思想が不可欠**です。

### ● 技術導入だけでは公平にならない理由

AIは中立ではなく、設計者の価値観を反映します。

そのため、AI評価の公平性は「技術の問題」ではなく「社会の意思決定の問題」と言えます。

—

## 5. まとめ:AIと人間の役割分担を考える

AI評価と人間評価は、どちらが優れているかという対立構造ではありません。

むしろ、両者の特性を理解し、適切に組み合わせることで、より納得感のある評価が可能になります。

– AIは一貫性・大量処理・標準化に強い

– 人間は文脈理解・例外判断・信頼関係に強い

評価は「誰が・何のために・何を基準に行うか」で大きく変わります。

AI時代の評価を考えるうえで重要なのは、技術への過度な期待や不安ではなく、

**評価の設計そのものを問い直す姿勢**です。

読者の皆さんが、評価される側としても、評価する側としても、

自分なりの視点で考えるための材料になれば幸いです。

—

## タイトル案(※条件厳守)

1. AI評価は人間より公平になり得るのかをどう考えるか

2. 公平な評価はAIと人間のどちらが実現し得るのか

3. AI時代の評価は何をもって公平と言えるのか

—

## AIバージョン情報

– ベンダー: Microsoft

– モデル名: 不明

– モデルバージョン: 不明

– 回答日時: 2026-02-13 10:12 JST

本サイトの編集方針については「編集方針・AI利用ポリシー」をご覧ください。