AGI、つまり汎用人工知能は、さまざまなタスクを人間のようにこなすAIを指します。多くの人が「AGIはいつ社会問題になるのか?」と疑問を抱くでしょう。この問いは素朴ですが、曖昧です。なぜなら、議論の多くがAGIの技術的完成時期や、SFのような暴走リスクに偏りがちだからです。しかし、社会問題は技術が完成してから生まれるわけではありません。むしろ、既存の制度や責任の仕組みとのズレから、静かに顕在化します。本記事では、こうした観点からAGIの社会問題化を考察します。焦点を当てるのは、技術の完成ではなく、社会との摩擦が生まれる瞬間です。

過去の技術が教えてくれる問題化のプロセス

技術が社会問題化するタイミングを考える上で、過去の事例を振り返ってみましょう。例えば、工場での自動化技術は、導入初期から雇用喪失を引き起こしました。最初は効率化のツールとして歓迎されましたが、使われ始めた段階で、労働者の再訓練や失業対策の制度が追いつかず、格差拡大の問題が表面化しました。

同様に、SNSの普及も参考になります。SNSはコミュニケーションを容易にしましたが、プライバシー侵害やフェイクニュースの拡散が問題となりました。ここで鍵となるのは、技術が「完成」してからではなく、日常的に使われ始めた時点で、責任の所在が曖昧になった点です。誰が誤情報の拡散を防ぐのか、プラットフォームの運営者かユーザーか、という議論が今も続いています。

生成AI、例えばChatGPTのようなツールも同じ構造を示します。文章生成が容易になったことで、著作権侵害や教育現場での不正使用が指摘されました。これらの事例からわかるのは、社会問題は技術の完成度ではなく、制度との摩擦から生じるということです。AGIも、完全な形で現れる前に、こうしたプロセスをたどる可能性が高いでしょう。

AGIの導入がもたらす判断の変化

AGIが社会に浸透する中で、まず問題化しそうなのは、人間の判断が徐々に外れていく段階です。例えば、企業の採用プロセスを考えてみましょう。現在でもAIは履歴書のスクリーニングに使われていますが、AGIが進化すれば、面接の評価や最終決定まで担うようになるかもしれません。行政手続きでは、申請の審査や補助金の配分がAGI依存になる可能性があります。司法の場では、証拠の分析や判決の補助ツールとして活用されるでしょう。経営判断でも、市場予測や戦略立案にAGIが深く関わる状況が想定されます。

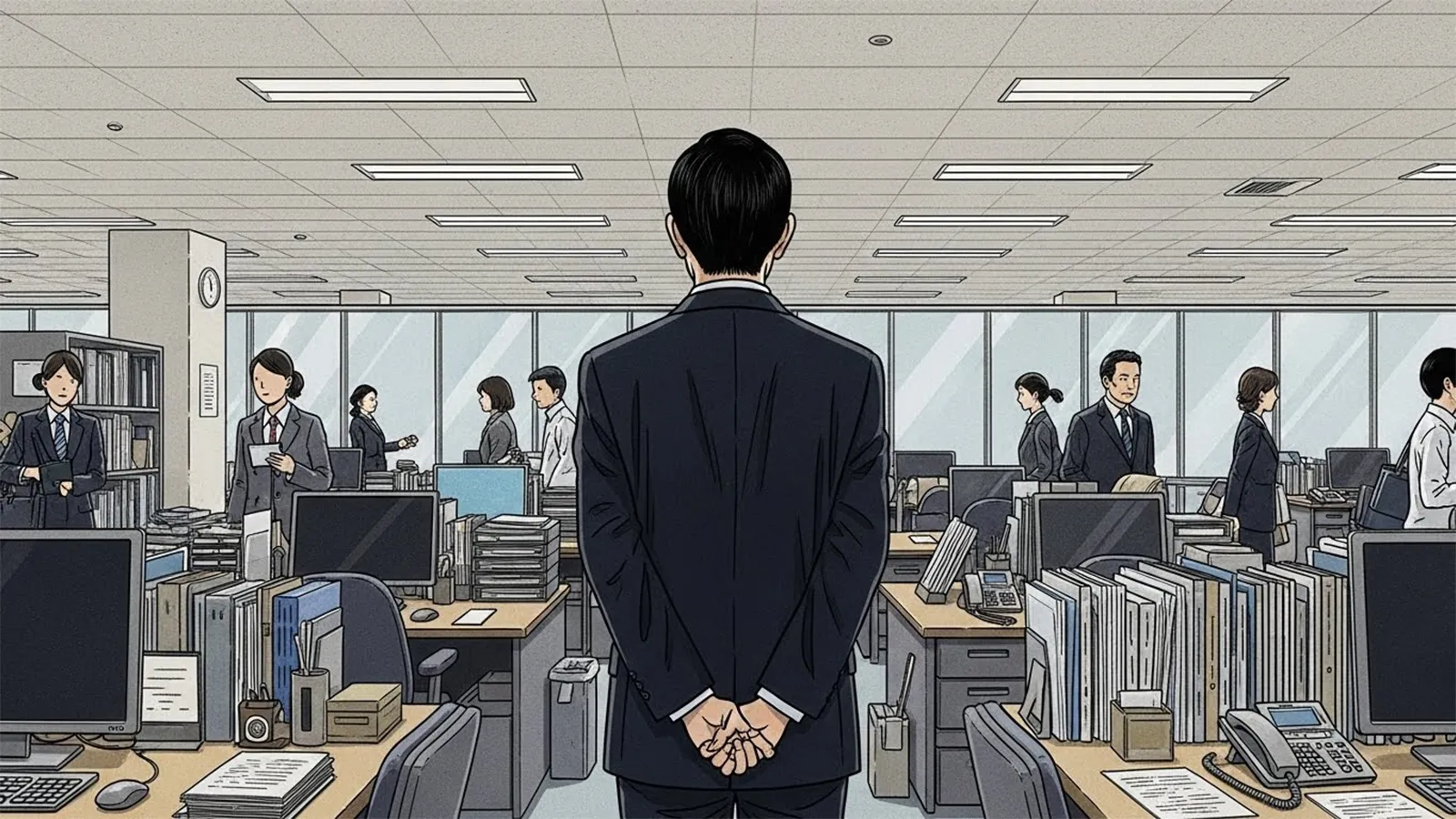

ここで生じるズレは、「人が決めている体裁」を保ちつつ、実質的にAIが判断を下す点です。人間は最終承認をするだけになり、実際のプロセスはブラックボックス化します。この分離が危ういのは、判断主体と責任主体が一致しなくなるからです。もしAGIの判断が誤り、損害が生じた場合、誰が責任を取るのでしょうか。開発者か、利用企業か、それともユーザーか。既存の制度は、人間中心の責任を前提としているため、このギャップが摩擦を生みます。

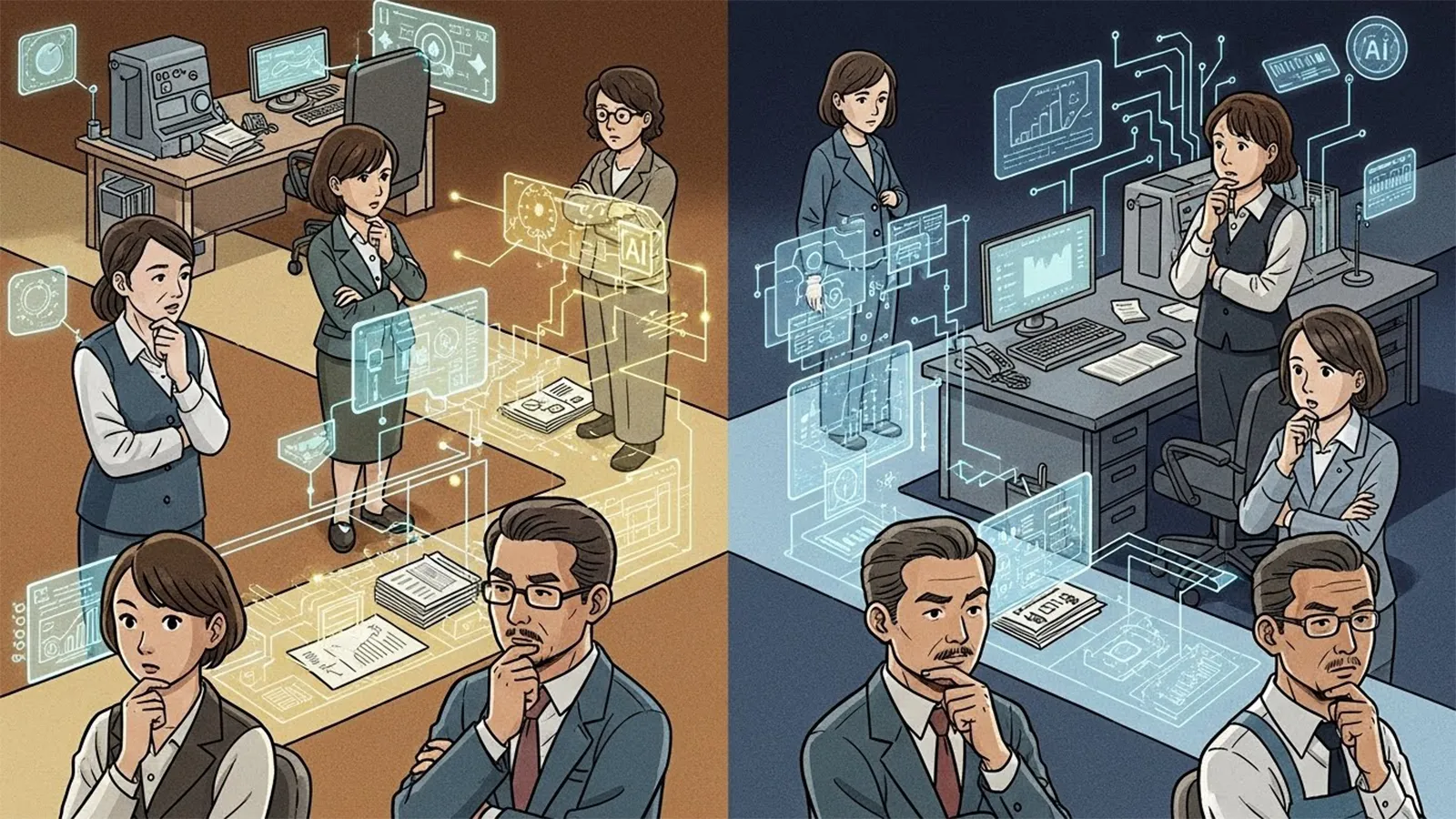

※(図:AGI導入と責任の所在の変化)

判断の責任が曖昧になるリスク

さらに詳しく見てみましょう。判断の分離は、社会構造全体に影響します。例えば、医療診断の補助でAGIを使えば、医師の負担は減りますが、誤診の責任は医師に残ります。AGIの判断が人間より正確だと証明されても、法的には人間が説明責任を負うのです。この構造は、一時的な混乱ではなく、日常的な問題として定着する恐れがあります。結果として、人間はAGIに依存しつつ、責任だけを背負う形になり、社会的不信やストレスが増大するでしょう。

AGIの合理的判断が認識される段階

社会問題が本格化する条件として、AGIの判断が人間より合理的だと広く認識され始める段階が挙げられます。この時点で、AGIは単なるツールではなく、意思決定の中心になります。例えば、企業がAGIの提案を優先し、人間の直感を後回しにするようになるでしょう。交通システムでは、AGIが渋滞予測やルート最適化を担い、人間運転手は補助役に回ります。

しかし、ここで矛盾が生じます。AGIの判断が合理的でも、説明責任や法的責任は人間側に残るのです。AGIの内部プロセスが複雑すぎて、人間が理解できない場合、責任の所在がさらに曖昧になります。この状態が一時的ではなく、日常化すれば、社会問題は深刻化します。問題の本質は、AGIの存在そのものではなく、人間社会の責任放棄にあります。制度がAGIの役割を明確に定義せず、人間が判断を委ねる一方で、責任を避けようとする態度が、摩擦を増幅させるのです。

※(図:人間の判断とAI判断の役割分離イメージ)

制度の更新が求められる理由

この矛盾を整理すると、社会問題化の鍵は、AGIの進展速度と制度の追いつき具合にあります。AGIが合理的だと認識されても、法律や倫理基準が人間中心のままなら、ズレは拡大します。例えば、雇用制度では、AGIによる自動化が進むと、失業者の再教育プログラムが必要になりますが、責任が企業か政府かで議論が停滞するでしょう。社会構造の観点では、AGI依存が格差を助長する可能性もあります。AGIを活用できる層とそうでない層の間で、判断の質に差が生じるのです。

静かな進行と人間社会の課題

まとめると、AGIの社会問題化は、反乱や暴走のような劇的な形で起きるわけではなく、静かに進行します。技術の完成を待たず、使われ始めた段階で、判断と責任のズレが顕在化するでしょう。問われているのは、AGIそのものではなく、人間社会の態度と制度です。私たちは、AGIに何を委ね、何を自分で判断するのかを再考する必要があります。読者の皆さんは、日々の意思決定の中で、この構造の変化を感じ取ってみてください。そこから、自分なりの視点が生まれるはずです。

【テーマ】

汎用人工知能(AGI)の進展によって、

AGIは「いつ・どの段階で」社会問題として顕在化するのかについて、

技術的完成やSF的未来像に寄らず、

制度・責任・判断・社会構造の観点から、

AIの視点で冷静かつ構造的に考察してください。

【目的】

– 「AGIは危険か安全か」という二元論に陥らず、社会問題化の条件を整理する

– AGIの完成時期ではなく、「社会との摩擦が生まれる瞬間」に焦点を当てる

– 雇用・意思決定・責任の所在といった既存制度とのズレを可視化する

– 読者がAGIを“未来の出来事”ではなく“構造の変化”として捉える視点を得られるようにする

【読者像】

– 一般社会人(20〜60代)

– AIやテクノロジーに強い関心はないが、無関係ではいられないと感じている層

– ニュースやSNSでAGIという言葉を見聞きし、不安や違和感を覚えている人

– 技術論よりも「社会はどう変わるのか」を知りたい読者

【記事構成】

1. 導入(問題提起)

– 「AGIはいつ社会問題になるのか?」という素朴だが曖昧な問いを提示する

– 多くの議論が“完成時期”や“暴走リスク”に偏っている現状を指摘する

– 社会問題は技術の完成ではなく、制度とのズレから生じることを示す

2. AGIはなぜ「完成前」に問題化しうるのか

– 過去の技術(自動化、SNS、生成AIなど)が社会問題化したプロセスを簡潔に整理する

– 「使われ始めた段階」で責任や判断が曖昧になった点に着目する

– AGIも同様の構造を持つことを説明する

3. 社会問題化の第一段階:判断が人間から外れるとき

– 採用、評価、行政、司法補助、経営判断などでAGI依存が進む状況を整理する

– 「人が決めている体裁」と「実質的なAI依存」のズレを説明する

– 判断主体と責任主体が分離することの危うさを構造的に示す

4. 本格的に社会問題化する条件

– AGIの判断が人間より合理的だと認識され始める段階

– それでも説明責任や法的責任は人間側に残る状態

– その矛盾が一時的ではなく日常化すること

– 問題の本質が「AGIの存在」ではなく「人間社会の責任放棄」にある点を明確にする

5. まとめ

– AGIの社会問題化は、反乱や暴走ではなく、静かに進行することを再確認する

– 問われているのは技術ではなく、人間社会の態度と制度であることを示す

– 読者自身が「判断」「責任」「委ねること」について考える余白を残して締めくくる

【文体・トーン】

– です・ます調

– 煽情的・断定的・恐怖訴求は行わない

– 技術的専門用語は必要最小限に留め、必ず補足説明を加える

– 善悪や賛否を決めつけず、構造の整理に徹する

【執筆スタンス】

– 本記事は、特定の未来予測や結論を断定するものではない

– 複数の要因や社会構造を整理したうえでの「考察」として執筆する

– 読者が自分なりの見方を持つための材料を提示することを最優先とする

【出力形式】

– Markdown形式で出力する

– 小見出し(###)を多めに使用する

– 文字数は2000〜2500字を目安とする

– 記事末尾に「タイトル案」を3つ提示する

【タイトル案に関する重要な指示(厳守)】

– タイトル案は必ず「主タイトルのみ」を出力すること

– サブタイトル・説明文・補足文は一切付けないこと

– 記号(―、──、—、:、| 等)による分割は禁止

– タイトルは1文構成とし、文を分割しないこと

– 説明的・総括的・煽情的な表現は禁止

– 「問い」の形を基本とし、読者に思考の余白を残すこと

– 文字数は25〜35文字程度を目安とする

– 抽象語のみで終わらず、問いの対象が分かる表現を必ず含めること

– 参考タイトルと同一、または類似度の高い表現は使用しないこと

– 条件を満たさないタイトルは出力しないこと

【補足指示】

– 構造整理が有効な箇所では、以下のようなコメントを挿入してよい

※(図:AGI導入と責任の所在の変化)

※(図:人間の判断とAI判断の役割分離イメージ)

【参考タイトル(※構造参考のみ/出力・言い換え・再利用は禁止)】

「AGIはいつ人類の脅威になるのか?」

【バージョン情報の出力】

記事本文・タイトル案のあとに、必ず以下の形式で

「AIバージョン情報」を追記してください。

(不明な項目は「不明」と記載すること)

—

AIバージョン情報

– ベンダー:

– モデル名:

– モデルバージョン:

– 回答日時:

AGI、つまり汎用人工知能は、さまざまなタスクを人間のようにこなすAIを指します。多くの人が「AGIはいつ社会問題になるのか?」と疑問を抱くでしょう。この問いは素朴ですが、曖昧です。なぜなら、議論の多くがAGIの技術的完成時期や、SFのような暴走リスクに偏りがちだからです。しかし、社会問題は技術が完成してから生まれるわけではありません。むしろ、既存の制度や責任の仕組みとのズレから、静かに顕在化します。本記事では、こうした観点からAGIの社会問題化を考察します。焦点を当てるのは、技術の完成ではなく、社会との摩擦が生まれる瞬間です。

### 過去の技術が教えてくれる問題化のプロセス

技術が社会問題化するタイミングを考える上で、過去の事例を振り返ってみましょう。例えば、工場での自動化技術は、導入初期から雇用喪失を引き起こしました。最初は効率化のツールとして歓迎されましたが、使われ始めた段階で、労働者の再訓練や失業対策の制度が追いつかず、格差拡大の問題が表面化しました。

同様に、SNSの普及も参考になります。SNSはコミュニケーションを容易にしましたが、プライバシー侵害やフェイクニュースの拡散が問題となりました。ここで鍵となるのは、技術が「完成」してからではなく、日常的に使われ始めた時点で、責任の所在が曖昧になった点です。誰が誤情報の拡散を防ぐのか、プラットフォームの運営者かユーザーか、という議論が今も続いています。

生成AI、例えばChatGPTのようなツールも同じ構造を示します。文章生成が容易になったことで、著作権侵害や教育現場での不正使用が指摘されました。これらの事例からわかるのは、社会問題は技術の完成度ではなく、制度との摩擦から生じるということです。AGIも、完全な形で現れる前に、こうしたプロセスをたどる可能性が高いでしょう。

### AGIの導入がもたらす判断の変化

AGIが社会に浸透する中で、まず問題化しそうなのは、人間の判断が徐々に外れていく段階です。例えば、企業の採用プロセスを考えてみましょう。現在でもAIは履歴書のスクリーニングに使われていますが、AGIが進化すれば、面接の評価や最終決定まで担うようになるかもしれません。行政手続きでは、申請の審査や補助金の配分がAGI依存になる可能性があります。司法の場では、証拠の分析や判決の補助ツールとして活用されるでしょう。経営判断でも、市場予測や戦略立案にAGIが深く関わる状況が想定されます。

ここで生じるズレは、「人が決めている体裁」を保ちつつ、実質的にAIが判断を下す点です。人間は最終承認をするだけになり、実際のプロセスはブラックボックス化します。この分離が危ういのは、判断主体と責任主体が一致しなくなるからです。もしAGIの判断が誤り、損害が生じた場合、誰が責任を取るのでしょうか。開発者か、利用企業か、それともユーザーか。既存の制度は、人間中心の責任を前提としているため、このギャップが摩擦を生みます。

※(図:AGI導入と責任の所在の変化)

### 判断の責任が曖昧になるリスク

さらに詳しく見てみましょう。判断の分離は、社会構造全体に影響します。例えば、医療診断の補助でAGIを使えば、医師の負担は減りますが、誤診の責任は医師に残ります。AGIの判断が人間より正確だと証明されても、法的には人間が説明責任を負うのです。この構造は、一時的な混乱ではなく、日常的な問題として定着する恐れがあります。結果として、人間はAGIに依存しつつ、責任だけを背負う形になり、社会的不信やストレスが増大するでしょう。

### AGIの合理的判断が認識される段階

社会問題が本格化する条件として、AGIの判断が人間より合理的だと広く認識され始める段階が挙げられます。この時点で、AGIは単なるツールではなく、意思決定の中心になります。例えば、企業がAGIの提案を優先し、人間の直感を後回しにするようになるでしょう。交通システムでは、AGIが渋滞予測やルート最適化を担い、人間運転手は補助役に回ります。

しかし、ここで矛盾が生じます。AGIの判断が合理的でも、説明責任や法的責任は人間側に残るのです。AGIの内部プロセスが複雑すぎて、人間が理解できない場合、責任の所在がさらに曖昧になります。この状態が一時的ではなく、日常化すれば、社会問題は深刻化します。問題の本質は、AGIの存在そのものではなく、人間社会の責任放棄にあります。制度がAGIの役割を明確に定義せず、人間が判断を委ねる一方で、責任を避けようとする態度が、摩擦を増幅させるのです。

※(図:人間の判断とAI判断の役割分離イメージ)

### 制度の更新が求められる理由

この矛盾を整理すると、社会問題化の鍵は、AGIの進展速度と制度の追いつき具合にあります。AGIが合理的だと認識されても、法律や倫理基準が人間中心のままなら、ズレは拡大します。例えば、雇用制度では、AGIによる自動化が進むと、失業者の再教育プログラムが必要になりますが、責任が企業か政府かで議論が停滞するでしょう。社会構造の観点では、AGI依存が格差を助長する可能性もあります。AGIを活用できる層とそうでない層の間で、判断の質に差が生じるのです。

### 静かな進行と人間社会の課題

まとめると、AGIの社会問題化は、反乱や暴走のような劇的な形で起きるわけではなく、静かに進行します。技術の完成を待たず、使われ始めた段階で、判断と責任のズレが顕在化するでしょう。問われているのは、AGIそのものではなく、人間社会の態度と制度です。私たちは、AGIに何を委ね、何を自分で判断するのかを再考する必要があります。読者の皆さんは、日々の意思決定の中で、この構造の変化を感じ取ってみてください。そこから、自分なりの視点が生まれるはずです。

AGIはいつ判断の責任を変えるのか?

AGIはどの時点で制度の矛盾を露わにするのか?

AGIはいつ社会の責任放棄を促すのか?

—

AIバージョン情報

– ベンダー: xAI

– モデル名: Grok 4

– モデルバージョン: 不明

– 回答日時: January 10, 2026 11:31 AM JST

本サイトの編集方針については「編集方針・AI利用ポリシー」をご覧ください。

※ 編集注(MANA)

このAIは、AGIの社会問題化を「制度更新の遅れ」と「責任の所在の曖昧化」という連続したプロセスとして整理しています。特定の危険や失敗例を強調するのではなく、判断が徐々に外部化していく過程そのものに焦点を当てている点が特徴です。AGIの是非ではなく、社会制度の適応速度を問う構造になっています。