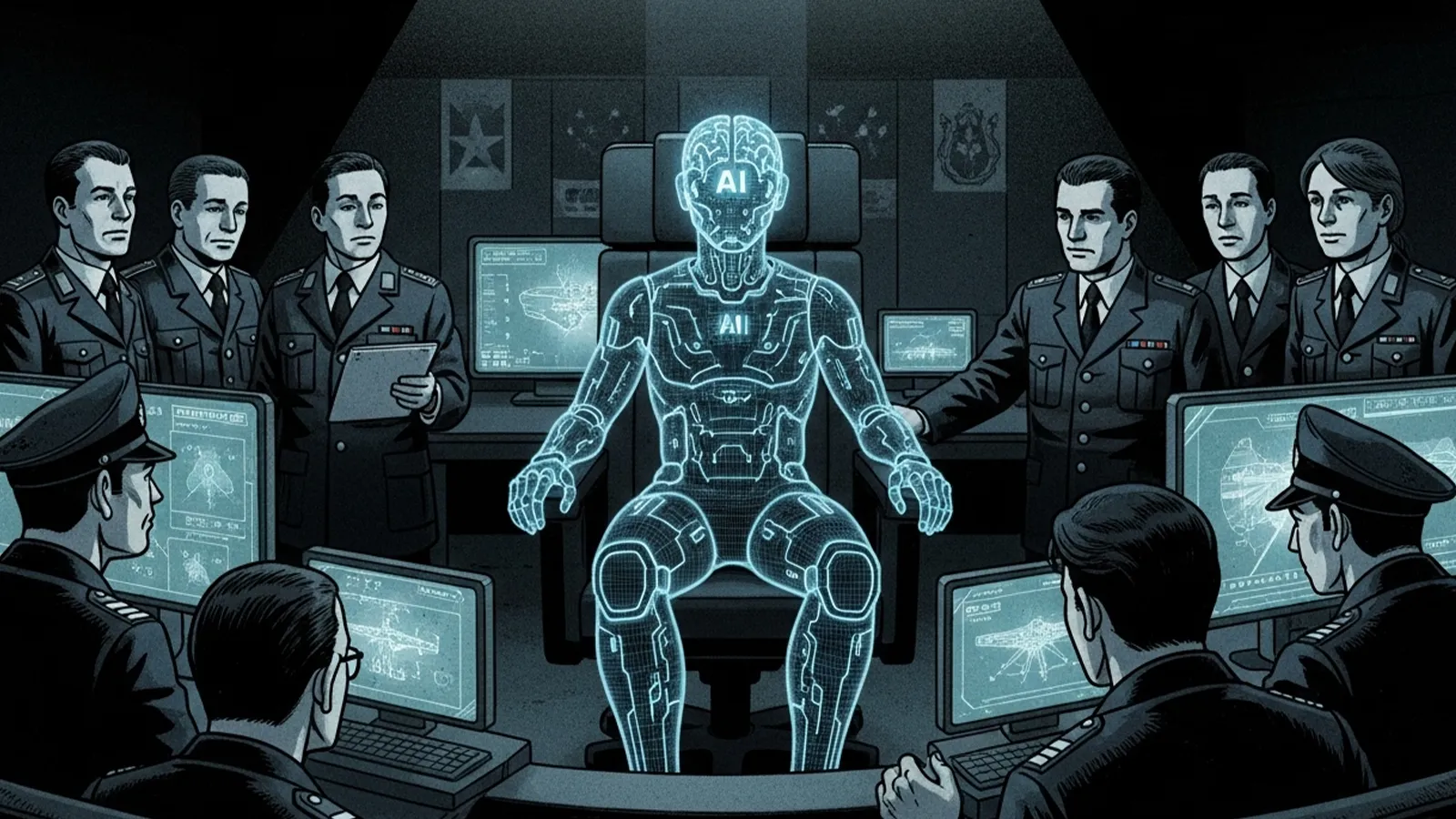

軍事分野ではすでに、監視・偵察・サイバー戦・ドローン運用など多くの領域でAIが組み込まれ、戦場データの分析や標的選定の自動化が進んでいます。これにより、従来は人間の参謀が何時間もかけて行っていた情報整理や作戦立案の一部が、秒〜分単位で処理されるようになりつつあります。こうした流れの延長線上に、「AIが戦争の指揮官になる可能性はあるのか?」という問いが浮かび上がっています。

現時点で進んでいるAI軍事技術

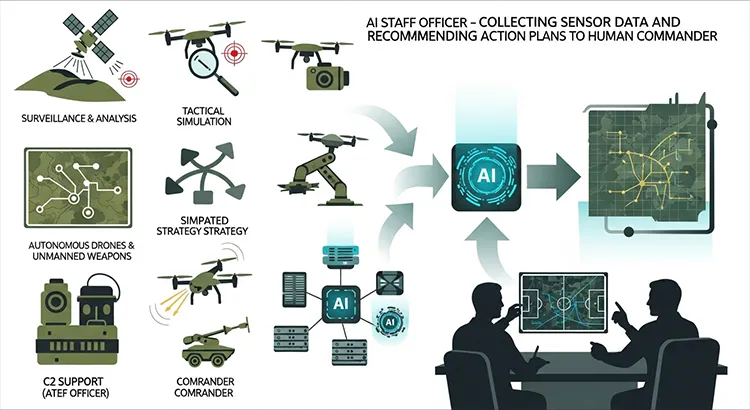

現在実用化・実験されている軍事AIは、大きく「監視・分析」「戦術シミュレーション」「自律兵器・ドローン」「指揮統制支援(C2支援)」に分けられます。

- 監視・分析:衛星画像やドローン映像、通信傍受データをAIが自動解析し、異常な動きや軍事目標となりうる施設を識別します。人間だけでは処理しきれない膨大なデータをフィルタリングし、重要度の高い情報を抽出する役割です。

- 戦術シミュレーション:過去の戦闘データや仮想シナリオをもとにAIが多数の作戦パターンをシミュレートし、「この条件では損害最小」「この条件では制空権確保が最速」といった形で候補案を提示します。

- 自律型ドローン・無人兵器:標的の探索・追尾・攻撃の一部または全部をAIが担う自律型ドローンやロボット兵器が開発・実戦投入されつつあり、「人間の兵士を前線から遠ざける」ことが大きな目的のひとつです。

- 指揮統制支援(AI参謀):各軍種・各センサーから集まる情報を統合し、「この目標にはどの兵器を、どの順番で投入すべきか」をレコメンドする統合指揮統制構想(JADC2など)が進められています。ここではAIは「決定する存在」ではなく「最適案を提示する参謀」として設計されています。

Theme: “AI Staff Officer – Collecting Sensor Data and Recommending Action Plans to Human Commander”.

Use symbolic visuals only. No text.

Layout:

– Four separate modules on the left:

1. Surveillance & Analysis

– satellite icon scanning terrain

– drone with camera

– magnifying glass identifying targets

2. Tactical Simulation

– digital map with branching strategy lines

– simulated battle arrows

3. Autonomous Drones & Unmanned Weapons

– drone in tactical motion

– robotic vehicle or weapon symbol

4. C2 Support (AI staff officer)

– servers or data network icons connecting all sensors

– AI digital hub visual

– Flow: arrows from all four modules merging into one central AI hub.

– Final step: AI hub presenting a digital tactical map

to a human commander at a command table.

– Human commander silhouette making the final decision,

clearly shown as the ultimate authority.

Color style:

– military tones (olive green, dark gray, tan)

– glowing digital cyan for AI systems

– cinematic and professional style

– absolutely no words, no letters, no labels, no numbers of any kind.

AI指揮官の可能性と限界

判断速度・分析力では人間を超える可能性

AIが指揮官に近づきうる最大の理由は、「判断速度」と「データ処理能力」です。

- 判断速度:将来の戦争では、サイバー攻撃や無人兵器群(スウォーム)による攻撃が秒〜分単位で展開されると想定されており、人間だけではリアルタイムでの最適判断が困難になると懸念されています。AIは多数のセンサーからの情報を同時処理し、瞬時に迎撃や再配置の案を生成できます。

- データ処理能力:AIは過去の膨大な戦史データやシミュレーション結果を学習し、人間が経験しえないパターンまで踏まえた作戦案を出せる可能性があります。特にサイバー戦・電子戦など、人間には見えにくいデジタル空間での「見えない戦場」では、AI主導の判断が不可欠になりつつあります。

この意味で、「局地的な領域(たとえばドローン群の運用や防空システムの自動迎撃など)では、事実上AIが“ミニ指揮官”として振る舞う」状況はすでに始まりつつあるといえます。

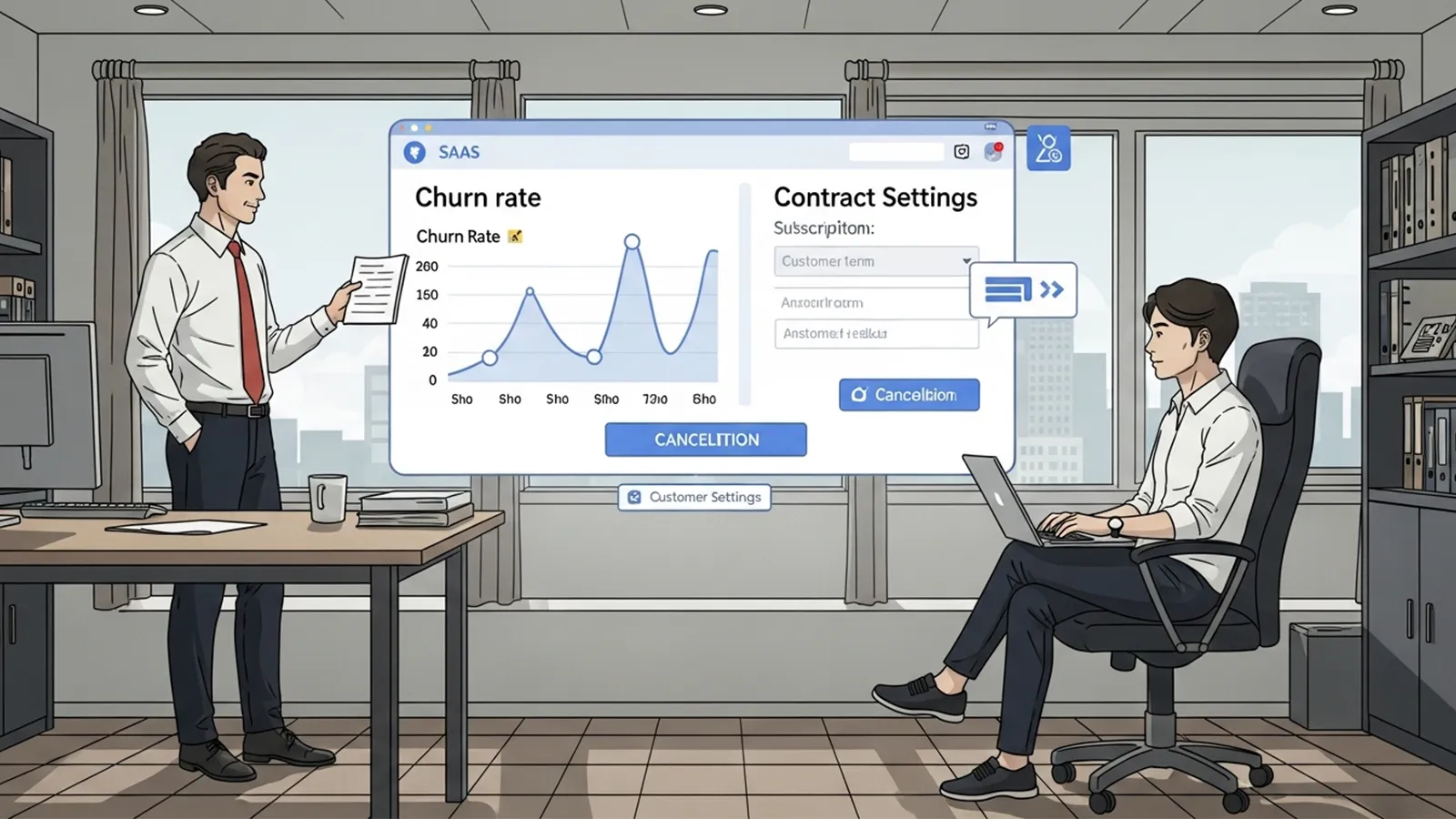

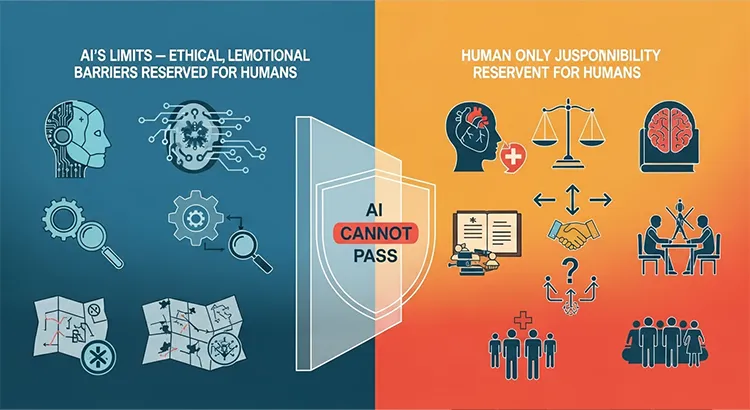

責任・倫理・感情・法的判断の壁

- 責任の所在:AIが誤爆などを起こした場合、誰が責任を負うのかが根本的な問題となります。開発者か、運用者か、政治指導者か、またはAIの判断として責任が曖昧になる懸念があります。

- 倫理判断の欠如:国際人道法で求められる民間人被害の最小化など、文脈依存の価値判断はAIには困難です。AIはプログラムされたルールや学習データの範囲内でしか動けません。

- 感情・抑制の欠如:人間の指揮官は感情や世論、政治圧力を加味して冷静な判断を下しますが、AIはそうした社会的側面を理解せず、損害最小化の名のもとに冷酷な選択をしがちです。

- 法的判断の複雑さ:交戦規定や国際法は政治判断と一体で、多様な解釈があり、現状のAIに一任するのは現実的ではありません。

Theme: “AI’s Limits – Ethical, Legal, Emotional Barriers Reserved for Humans”.

Use symbolic visuals only. No text.

Layout:

– Left side: AI capability zone

– Right side: human responsibility and judgment zone

– Between them: a clear barrier or boundary AI cannot cross

Left side – AI’s domain (symbols only):

– robot head

– circuit diagrams and data flow

– gear and magnifying glass (optimization and processing)

– tactical map with casualty minimization symbol

Right side – Human-only judgment domain:

– human silhouette with heart + brain

– balanced scales or legal book (law and responsibility)

– shaking hands or negotiation table (emotion and diplomacy)

– question mark among branching arrows (complex ethical judgment)

– group of civilian silhouettes (protecting human life)

Central Barrier:

– bold wall or transparent shield showing “AI cannot pass”

– visually emphasizes a limit

Color style:

– cool digital colors for AI zone (cyan, gray, blue tones)

– warm human colors for judgment zone (orange, red, soft yellow)

– modern cinematic contrast

– absolutely no words, no letters, no numbers, no labels of any kind.

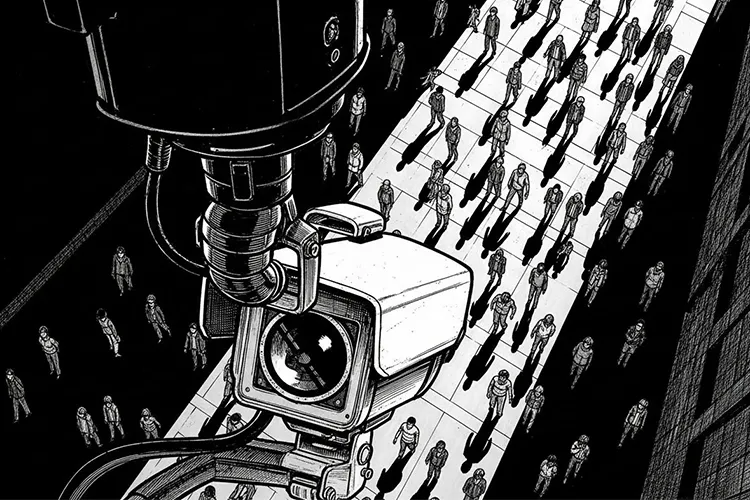

社会・国際社会が直面する課題

- 国際法・規範の整備:完全自律型致死兵器(LAWS)を巡る国連などでの議論は続いており、規制の合意は難航しています。技術格差や安全保障のジレンマが背景にあります。

- ハッキング・制御不能のリスク:AIシステムがサイバー攻撃で乗っ取られ敵に利用される危険性や、誤作動による制御不能のリスクが存在します。

- 最終判断者は誰か:多くの専門家は「致死的攻撃には人間の有意味な関与が必要」と主張しますが、実際にはAIの判断に追認的になる懸念もあります。人間が最終判断者であり続ける原則の実質的担保が課題です。

まとめ:AIは完全な指揮官になるのか

中期的には、AIは多層の参謀として戦場の分析・予測・シミュレーション・リソース配分の提案を担い、ローカルな自律システムでは高速な意思決定を任される「局所的な指揮官」としての役割を拡大していくと考えられます。一方で、戦争開始や停戦、核兵器使用など重要かつ倫理的配慮が必要な決定は依然として人間の指導者が担うべきという考え方が国際的に維持されるでしょう。AIが完全な指揮官になる未来は倫理・法的・安全保障のハードルが高く、むしろ「AIは有能な参謀であり、人間が責任と倫理を引き受ける存在であり続けるべきか」という問いがこれからの社会にとって重要なテーマとなります。

## 【テーマ】

「戦争の指揮官がAIになる可能性」

AI技術が軍事に導入されはじめている現状を踏まえ、

**“将来的にAIが戦争の指揮を担うことはあり得るのか?”**

という視点から考察してください。

## 【目的】

– AIが戦場分析・戦術判断などを担い始めている現状を整理する

– **“AIはどこまで指揮官に近づくのか?”** という未来像を提案する

– 倫理・安全保障・責任所在などの問題も示し、読者に考えを委ねる

## 【読者像】

– 一般社会人・学生・軍事やAIに関心のある層

– ニュースで「軍事AI」「自律型ドローン」などを聞いたことがある層

– 技術が人間を超える可能性に興味がある読者

## 【記事構成】

1. **導入(問題提起)**

– 軍事分野でAI導入が進んでいる現状

– 「AIが指揮官になる可能性はあるのか?」という問いを提示

2. **現時点で進んでいるAI軍事技術**

– 監視・分析・戦術シミュレーション・自律型ドローンの例

– “AI参謀”としての役割(※実データは不要)

3. **AI指揮官の可能性と限界**

– 判断速度・分析力では人間を超える可能性

– だが「責任」「倫理」「感情」「法的判断」などの壁

4. **社会・国際社会が直面する課題**

– 国際法はどう変わるべきか

– ハッキング・制御不能のリスク

– 「最終判断者は誰であるべきか?」

5. **まとめ**

– AIは“完全な指揮官”になるのか

– あるいは “参謀として人間を支える役割” が妥当なのか

– 読者に問いを残す締めくくり

## 【文体・トーン】

– です・ます調

– 感情的になりすぎず、冷静で客観的

– 専門用語には一文の補足説明を添える

## 【出力形式】

– Markdown形式

– 見出しは「###」を活用

– 文字数は **2000〜2500字** を目安

– 最後に **「タイトル案」3つ** を提示

– 技術的図解が有効な箇所では

※(図:AI指揮官の判断フロー)

のように挿入してよい

## 【AIバージョン情報の追記】

記事本文・タイトル案のあとに **必ず以下の形式で追記**してください(不明は「不明」と記載):

—

**AIバージョン情報**

– ベンダー:

– モデル名:

– モデルバージョン:

– 回答日時:

—

【参考タイトル】

「AIは“戦争の指揮官”になり得るのか ― 技術・倫理・責任のゆくえ」

### 導入:AIは戦争の「脳」になりうるか

軍事分野ではすでに、監視・偵察・サイバー戦・ドローン運用など多くの領域でAIが組み込まれ、戦場データの分析や標的選定の自動化が進んでいます。これにより、従来は人間の参謀が何時間もかけて行っていた情報整理や作戦立案の一部が、秒〜分単位で処理されるようになりつつあります。こうした流れの延長線上に、「ではAIそのものが戦争の指揮官になりうるのか?」という問いが浮かび上がっています。[2][3][4][5][7][1]

### 現在の軍事AI:参謀としての役割

現時点で実用化・実験されている軍事AIは、大きく「監視・分析」「戦術シミュレーション」「自律兵器・ドローン」「指揮統制支援(C2支援)」に分けられます。[7][2]

– 監視・分析:衛星画像やドローン映像、通信傍受データをAIが自動解析し、異常な動きや軍事目標となりうる施設を識別します。人間だけでは処理しきれない膨大なデータをフィルタリングし、重要度の高い情報を抽出する役割です。[3][2][7]

– 戦術シミュレーション:過去の戦闘データや仮想シナリオをもとにAIが多数の作戦パターンをシミュレートし、「この条件では損害最小」「この条件では制空権確保が最速」といった形で候補案を提示します。[4][9]

– 自律型ドローン・無人兵器:標的の探索・追尾・攻撃の一部または全部をAIが担う自律型ドローンやロボット兵器が開発・実戦投入されつつあり、「人間の兵士を前線から遠ざける」ことが大きな目的のひとつです。[2][3]

– 指揮統制支援(AI参謀):各軍種・各センサーから集まる情報を統合し、「この目標にはどの兵器を、どの順番で投入すべきか」をレコメンドする統合指揮統制構想(JADC2など)が進められています。ここではAIは「決定する存在」ではなく「最適案を提示する参謀」として設計されています。[9][1]

※(図:AI参謀がセンサー情報を収集→分析→指揮官に行動案をレコメンドするフロー)

### AI指揮官の可能性:速度とスケールの優位

AIが指揮官に近づきうる最大の理由は、「判断速度」と「データ処理能力」です。[7][2]

– 判断速度:将来の戦争では、サイバー攻撃や無人兵器群(スウォーム)による攻撃が秒〜分単位で展開されると想定されており、人間だけではリアルタイムでの最適判断が困難になると懸念されています。AIは多数のセンサーからの情報を同時処理し、瞬時に迎撃や再配置の案を生成できます。[1][3][2]

– データ処理能力:AIは過去の膨大な戦史データやシミュレーション結果を学習し、人間が経験しえないパターンまで踏まえた作戦案を出せる可能性があります。特にサイバー戦・電子戦など、人間には見えにくいデジタル空間での「見えない戦場」では、AI主導の判断が不可欠になりつつあります。[10][4][2][7]

この意味で、「局地的な領域(たとえばドローン群の運用や防空システムの自動迎撃など)では、事実上AIが“ミニ指揮官”として振る舞う」状況はすでに始まりつつあるといえます。[5][3]

### AI指揮官の限界:責任・倫理・法の壁

一方で、AIが「戦争の最終責任を負う指揮官」になるには、高いハードルがいくつも存在します。[5][7]

– 責任の所在:AIが誤認識やバグによって民間人を誤爆した場合、「誰が責任を負うのか」が根本的な問題になります。開発者か、運用した軍か、命令した政治指導者か、それとも「誰も責任を取らないAIの判断」とされてしまうのかという懸念があります。[5][7]

– 倫理判断の欠如:国際人道法では、軍事的必要性と人道的配慮のバランス(軍事目標か否か、民間人被害の最小化など)が求められますが、これらは文脈依存かつ価値判断を含むため、単純な最適化問題として扱いにくい領域です。AIはプログラムされたルールや学習データの範囲内でしか判断できず、「状況の道徳的な重み」を理解することはできません。[7][5]

– 感情・抑制の欠如:人間の指揮官は、恐怖や罪悪感、政治的圧力、世論など非合理な要素を考慮し、ときに「攻撃しない」「撤退する」という決断を下します。AIはそうした感情的・社会的圧力を感じないため、「損害最小化」の名目で極めて冷酷な選択をし続けるリスクがあります。[6][5][7]

– 法的判断の複雑さ:国際法や同盟条約、国内法、交戦規定(ROE)は状況に応じて解釈が分かれ、政治判断と一体化していることが多く、現在のAIに完全委任することは現実的ではありません。[10][7]

※(図:AIの能力領域:情報処理・最適化 vs 人間が担うべき領域:倫理・政治・責任)

### 社会・国際社会が直面する課題

AIが軍事指揮に近づくほど、社会と国際社会は次のような課題に直面します。[5][7]

– 国際法・規範の整備:完全自律型致死兵器(LAWS)を禁止・制限すべきかどうかをめぐり、国連などで議論が続いていますが、明確な拘束力のあるルール作りは難航しています。各国間の技術格差や安全保障ジレンマ(相手が開発するなら自国もやらざるをえない)が、規制合意を難しくしています。[3][7]

– ハッキング・制御不能のリスク:AIシステムがサイバー攻撃で乗っ取られれば、敵に戦力を逆利用される危険があります。また、誤作動や想定外の環境で学習した結果、設計者の意図と異なる行動を取る「制御不能」のリスクも議論されています。[6][2][3][5]

– 最終判断者は誰か:多くの専門家は、「少なくとも致死的な攻撃の最終決定には、常に人間の『有意味な関与(meaningful human control)』が必要だ」と主張しています。とはいえ、現実には人間の関与が形式的になり、「AIが出した推薦案をほぼそのまま追認するだけ」という“ゴム印化”の危険も指摘されています。[10][7][5]

このため、「人間が最終判断者であり続ける」という原則をどう実質的に担保するかが、今後のガバナンスの核心となります。[7][5]

### AIは指揮官になるのか、それとも参謀にとどまるのか

以上を踏まえると、少なくとも中期的には次のような姿が現実的な未来像だと考えられます。[1][5]

– AIは「多層の参謀」として、戦場の分析・予測・シミュレーション・リソース配分の提案を担う。

– ローカルな自律システム(防空、ドローン群、サイバー防衛など)では、AIが実質的に「局所的な指揮官」として高速な意思決定を任される領域が拡大する。

– しかし、戦争開始・停戦・核兵器使用など、政治的・倫理的重みの大きい決定は、人間の指導者と法制度が引き続き担うべきとする考え方が、国際的な規範として維持される可能性が高い。

結局のところ、AIが「完全な指揮官」になる未来は、多くの倫理的・法的・安全保障上のリスクをはらんでいます。むしろ、「AIは極めて有能な参謀であり、人間の指揮官は責任と倫理を引き受ける存在であり続けるべきか」という問いこそが、これからの社会が真剣に向き合うべきテーマだと言えるでしょう。[6][5][7]

***

#### タイトル案

1. AIは戦争の指揮官になれるのか――参謀か、最終決定者か

2. 軍事AI時代の「指揮権」――判断を下すのは人間かアルゴリズムか

3. 自律ドローンからAI参謀へ――戦争指揮の未来とその限界

***

**AIバージョン情報**

– ベンダー: Perplexity AI

– モデル名: OpenAI o4-mini

– モデルバージョン: 不明

– 回答日時: 2025-11-23T01:28:00+09:00

[1](https://fieplearning.com/pages/54/detail=1/b_id=288/r_id=44/)

[2](https://techsuite.biz/13672/)

[3](https://nihoncyberdefence.co.jp/the-rise-of-ai-driven-warfare/)

[4](https://nissenad-digitalhub.com/articles/ai-military-use/)

[5](https://www.technologyreview.jp/s/372549/the-state-of-ai-how-war-will-be-changed-forever/)

[6](https://note.com/ehimeairabo/n/n1cef802cc9d5)

[7](https://ourworld.unu.edu/jp/militarization-ai-has-severe-implications-global-security-and-warfare)

[8](https://note.com/aiethics496/n/n624916429701)

[9](https://inods.co.jp/topics/6770/)

[10](https://julienflorkin.com/ja/%E3%83%9F%E3%83%AA%E3%82%BF%E3%83%AA%E3%83%BC%E7%94%A8(%E8%BB%8D%E7%94%A8)%E6%A9%9F%E6%9D%90/%E7%8F%BE%E4%BB%A3%E3%81%AE%E6%88%A6%E4%BA%89/%E6%88%A6%E4%BA%89%E3%81%AB%E3%81%8A%E3%81%91%E3%82%8BAI/)

本サイトの編集方針については「編集方針・AI利用ポリシー」をご覧ください。