「AIなら、感情や先入観に左右されず、公平な判断ができるはずだ」。そんな期待を、一度は抱いたことがあるのではないでしょうか。企業の採用選考、銀行の融資審査、司法における量刑判断、さらには私たちの日常に浸透した商品推薦や情報表示に至るまで、AIによる判断の「社会実装」が急速に進んでいます。その背景には、人間の判断にはつきものの「主観」や「疲労」「無意識の偏り」を排除し、効率的で一貫性のある意思決定を実現したいという願いがあります。しかし、一方で私たちは「顔認識システムが特定の人種を誤認識しやすい」「AI採用ツールが性別による差別的なスクリーニングを行った」といったニュースにも接します。では、「AIの判断は“公平”と言えるのか?」という問いに対して、私たちはどのように向き合えばよいのでしょうか。

AIにおける「公平」の基本構造

まず、AIがどのように判断を下すのか、その基本構造を理解しましょう。

判断の源は「データ」と「目的」

AI(ここでは機械学習モデルを指します)は、与えられた大量のデータからパターンやルールを自動的に学習します。例えば、過去の採用データから「採用された人材の特徴」を学習し、新たな応募者を評価します。この時、AIは「この目的を最も効率よく達成する方法」を数学的に探します。これを「目的関数の最適化」と言います。目的が「採用力の高い人を正確に選ぶこと」であれば、AIはその目的を達成するために、データの中にあるあらゆる相関関係(学歴、職歴、使用単語など)を手がかりにします。

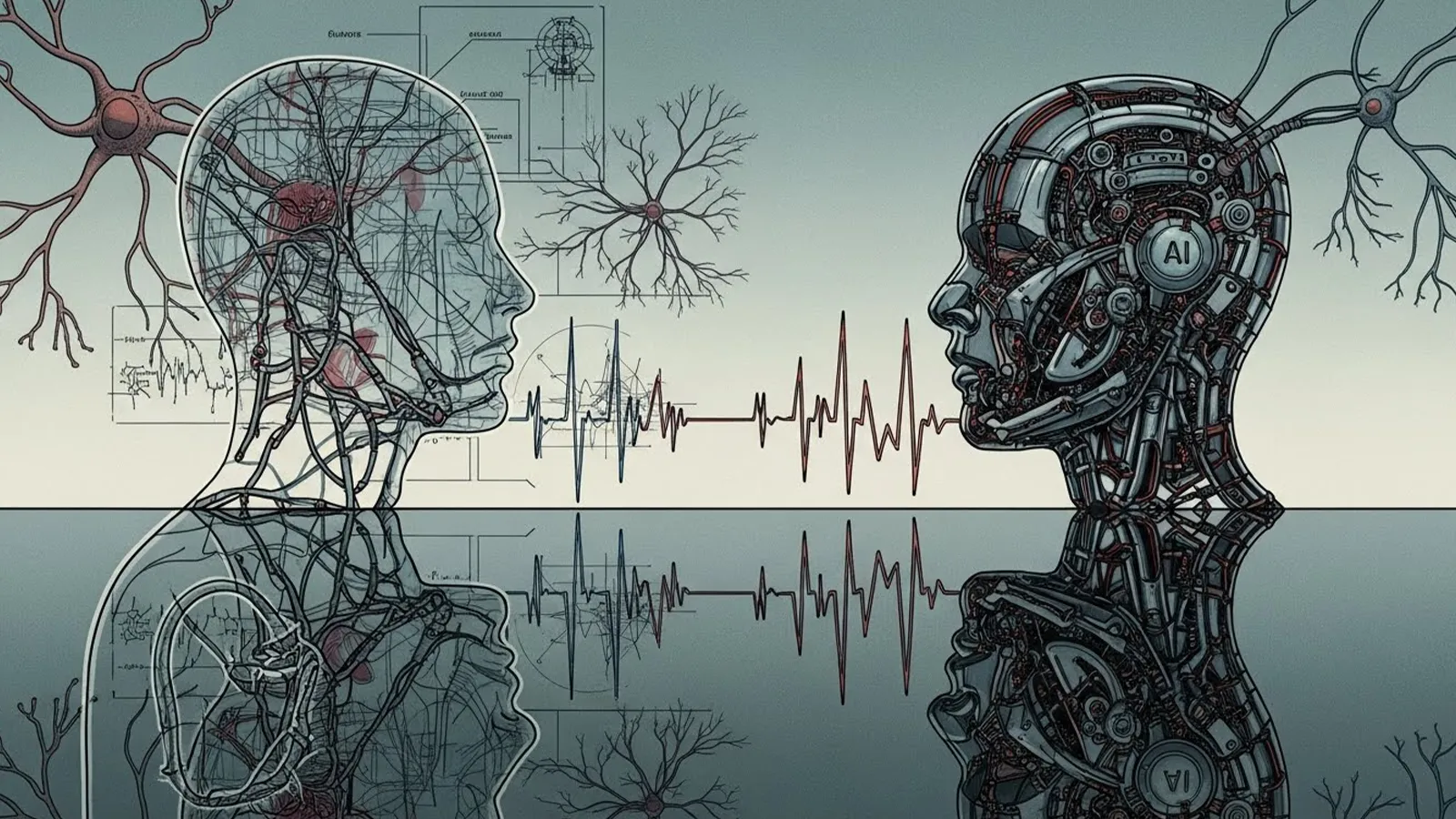

AIの強み:一貫性と再現性

AIの最大の特徴は、「同じ条件(入力)には、必ず同じ判断(出力)を返す」という一貫性にあります。疲労や機嫌、その日の印象に左右されることはありません。また、数学的な「公平性」の概念をプログラムに組み込むことも可能です。例えば、「特定の属性(性別や人種)に関わらず、同じスコアの人は同じ確率で合格とする」といった統計的公平性の基準を設定できます。

しかし、ここが重要なポイントです。AIが追求するのは、人間が事前に設定した「目的」と「公平性の定義」に過ぎないのです。

なぜAIの判断は“完全に公平”とは言えないのか

一貫性があり、数学的な公平性を追求できるAIの判断が、なぜ完全な公平をもたらさないのでしょうか。その理由は主に3つあります。

原因1:学習データに潜む「過去の偏り」の再生産

AIは過去のデータを鏡のように映し出します。もし過去の採用データに「特定の大学出身者ばかりが採用されていた」「男性管理職が極端に多かった」という社会的・歴史的な偏り(バイアス)が含まれていれば、AIは「その大学出身者であること」「男性であること」を「採用力が高い」という判断の重要な要素として学習してしまいます。これはAIが「差別を学習する」というより、「過去の不平等な現実を、そのまま効率化して再現している」と言えます。

原因2:「何を公平とするか」をAI自身は決められない

これは最も根本的な限界です。「採用において、性別による格差を是正すること」と「テストスコアだけで機械的に選ぶこと」、どちらが公平でしょうか?「地域間の犯罪発生率の差を反映すること」と「個人の属性に関わらず同じ基準を適用すること」、どちらが公平でしょうか?これらの価値判断は、社会の合意や倫理観に基づくものであり、AI自体には決めることができません。人間が設定する目的や公平性の定義(数式)そのものが、すでに特定の「公平観」を内包しているのです。

原因3:見えない特徴への間接的差別

AIは、直接的に「性別」や「人種」といった保護すべき属性を使わないように設計されることがあります(「公平性 through unawareness」)。しかし、郵便番号(居住地域)、購買履歴、SNSの友人の傾向など、他のデータからそれらの属性を高精度に推測(プロキシ推測)できる場合があります。結果として、間接的ではあれ、同じ偏りが判断に混入してしまうリスクがあります。

人間の考える公平とのズレ

では、AIが下す「公平な判断」と、私たち人間が感じる「公平さ」には、どのようなズレが生じるのでしょうか。

人間は「文脈」と「納得感」を求める

人間の公平感は、単なる数値やルールの一貫性だけでは成立しません。「なぜその判断が下されたのか」という説明(説明可能性)と、個別の事情や背景(文脈)を考慮した上での「納得感」が不可欠です。例えば、ある応募者が職歴に空白期間がある場合、AIはそれを単に「リスク要因」と判定するかもしれません。しかし、その期間が育児や介護、病気の治療によるものであったという「文脈」を人間は考慮し、場合によってはそれを評価の対象とします。AIはこのような個別の事情を、データからは読み取れないことが多いのです。

「公平だが冷たい」判断

AIは設定されたルールに厳密に従います。「一点の差で不合格」「年齢制限の一日前に生まれたので適用外」――これらはルール上は公平かもしれませんが、人間の感情からすれば「冷たい」「融通が利かない」と感じられるでしょう。このズレは、AIが「人間社会の複雑で多層的な価値観」を完全には捉えきれないことを示しています。

社会実装における課題と可能性

では、公平でないリスクを抱えるAIを、私たちはどのように社会に実装していけばよいのでしょうか。

AI判断を「どこまで」任せるか:ガバナンスの重要性

重要な判断ほど、AIに全てを任せる「ブラックボックス化」は危険です。特に、人生に重大な影響を与える採用、融資、司法、医療などの領域では、AIはあくまで「判断の補助ツール」あるいは「一次スクリーニングの手段」と位置づけるべきです。最終的な判断とその責任は、常に人間が持ち続ける必要があります。

人間が介在すべき「3つのポイント」

- 設計段階:何を目的とし、どのような公平性の基準を採用するかを、多様な視点で議論・決定する。

- 運用・監視段階:AIの判断結果を継続的に監視し、意図しない偏りが生じていないかを検証する(監査)。

- 最終判断・説明段階:AIの出力を参考にしつつ、最終判断を下し、必要に応じてその理由を説明する責任を負う。

AIの可能性は、人間の判断を代替することではなく、人間の判断の質と効率を高め、無意識の偏りに気づかせる「鏡」として活用することにこそあるのです。

まとめ

AIの判断は、設定されたルールにおいて驚くほど一貫性があり、特定の数学的定義に基づけば「公平」と言える局面があります。しかし、その判断の源であるデータや目的関数自体が人間社会の歴史的偏りや価値観を内包している以上、AIは「公平そのもの」というより、「人間の公平観を映し出す鏡」であると言えるでしょう。

AI時代において私たち人間が手放してはいけないのは、「何をもって公平とするのか」という価値そのものを問い続ける責任と、個別の文脈や例外に寄り添い、判断の結果に対して最終的な説明責任を取る覚悟です。

次にAIが下した判断に接した時、ぜひ一歩立ち止まって考えてみてください。「この判断の背景には、どんなデータとルールがあるのだろう?」「この判断は、私や社会が考える『公平』と一致しているだろうか?」その問いこそが、AIと共生する社会で、私たちが「公平」を育てていく第一歩になるのです。

【テーマ】

「AIの判断は“公平”と言えるのか?」という問いについて、

AI自身の立場・仕組み・限界を踏まえながら、多角的に分析してください。

【目的】

– 「AIは公平か?」という直感的だが答えの難しい問いを、構造的に整理する

– AIの判断が“人間の公平”とどこで一致し、どこでズレるのかを読者に理解させる

– AI活用が進む社会で、人間が考えるべき責任の所在を示す

【読者像】

– 一般社会人、学生

– AIを日常的に使い始めているが、仕組みや倫理には詳しくない層

– AIによる判断(採用、評価、推薦、監視など)に漠然とした不安や期待を持つ人

【記事構成】

### 1. 導入(問題提起)

– 「AIは人間より公平なのではないか?」という一般的なイメージを提示

– なぜ今、この問いが重要になっているのか(AI判断の社会実装が進んでいる背景)

– 公平性が問われる具体的な場面(例:採用、融資、司法、推薦アルゴリズムなど)

### 2. AIにおける「公平」の基本構造

– AIはどのように判断を行っているのか(データ・ルール・目的関数)

– 「同じ入力には同じ出力を返す」というAIの一貫性

– 数学的・統計的な公平性の考え方が存在することを示す(詳細な数式説明は不要)

### 3. なぜAIの判断は“完全に公平”とは言えないのか

– 学習データに含まれる偏り(バイアス)の影響

– 「何を公平と定義するか」をAI自身は決められない点

– 過去の社会構造や人間の価値観を、そのまま再生産してしまうリスク

### 4. 人間の考える公平とのズレ

– 人間が重視する「事情」「文脈」「配慮」「納得感」

– AIが苦手とする例外処理や感情の扱い

– 公平だが冷たく感じられる判断が生まれる理由

※(図:人間の公平とAIの公平の違い)

### 5. 社会実装における課題と可能性

– AI判断をどこまで任せてよいのか

– 人間が介在すべきポイント(最終判断・監督・説明責任)

– AIを「公平な審判」ではなく「判断補助」として使う考え方

### 6. まとめ

– AIは「公平そのもの」ではなく、「人間の公平観を映す鏡」であること

– AI時代において、人間が手放してはいけない判断とは何か

– 読者自身がAIの判断をどう受け止めるかを問いかけて締めくくる

【文体・トーン】

– です・ます調

– 感情に寄りすぎず、冷静かつ論理的

– 専門用語は簡潔に補足説明を入れる

【出力形式】

– Markdown形式で出力

– 小見出し(###)を多めに使用し、論点を明確に

– 文字数は2000〜2500字を目安

– 記事末尾に「タイトル案」を3つ提示する

【補足指示】

– 抽象的な議論になりすぎないよう、身近な具体例を適宜入れること

– 図解が有効な箇所には、以下のようなコメントを入れてよい

※(図:AI判断プロセスと人間の介在ポイント)

【参考タイトル】

「AIの判断は本当に公平か? ― 期待と現実のあいだにあるもの」

—

**AIバージョン情報**

– ベンダー:

– モデル名:

– モデルバージョン:

– 回答日時:

### 1. 導入(問題提起)

「AIなら、感情や先入観に左右されず、公平な判断ができるはずだ」

そんな期待を、一度は抱いたことがあるのではないでしょうか。

企業の採用選考、銀行の融資審査、司法における量刑判断、さらには私たちの日常に浸透した商品推薦や情報表示に至るまで、AIによる判断の「社会実装」が急速に進んでいます。

その背景には、人間の判断にはつきものの「主観」や「疲労」「無意識の偏り」を排除し、効率的で一貫性のある意思決定を実現したいという願いがあります。

しかし、一方で私たちはこうしたニュースにも接します。

「顔認識システムが特定の人種を誤認識しやすい」「AI採用ツールが性別による差別的なスクリーニングを行った」「過去の犯罪データを学習したAIが、特定地域の住民を不当に高リスクと判定した」――。

これらはすべて現実に起きた事例です。

では、「AIの判断は“公平”と言えるのか?」という問いに対して、私たちはどのように向き合えばよいのでしょうか。

この記事では、AI自身の仕組みと限界を踏まえ、この難しい問題を多角的に整理していきます。

### 2. AIにおける「公平」の基本構造

まず、AIがどのように判断を下すのか、その基本構造を理解しましょう。

#### 判断の源は「データ」と「目的」

AI(ここでは機械学習モデルを指します)は、与えられた大量のデータからパターンやルールを自動的に学習します。

例えば、過去の採用データから「採用された人材の特徴」を学習し、新たな応募者を評価します。

この時、AIは「この目的を最も効率よく達成する方法」を数学的に探します。これを「目的関数の最適化」と言います。

目的が「採用力の高い人を正確に選ぶこと」であれば、AIはその目的を達成するために、データの中にあるあらゆる相関関係(学歴、職歴、使用単語など)を手がかりにします。

#### AIの強み:一貫性と再現性

AIの最大の特徴は、「同じ条件(入力)には、必ず同じ判断(出力)を返す」という一貫性にあります。

疲労や機嫌、その日の印象に左右されることはありません。

また、数学的な「公平性」の概念をプログラムに組み込むことも可能です。

例えば、「特定の属性(性別や人種)に関わらず、同じスコアの人は同じ確率で合格とする」といった統計的公平性の基準を設定できます。

しかし、ここが重要なポイントです。AIが追求するのは、**人間が事前に設定した「目的」と「公平性の定義」**に過ぎないのです。

### 3. なぜAIの判断は“完全に公平”とは言えないのか

一貫性があり、数学的な公平性を追求できるAIの判断が、なぜ完全な公平をもたらさないのでしょうか。その理由は主に3つあります。

#### 原因1:学習データに潜む「過去の偏り」の再生産

AIは過去のデータを鏡のように映し出します。

もし過去の採用データに「特定の大学出身者ばかりが採用されていた」「男性管理職が極端に多かった」という社会的・歴史的な偏り(バイアス)が含まれていれば、AIは「その大学出身者であること」「男性であること」を「採用力が高い」という判断の重要な要素として学習してしまいます。

これはAIが「差別を学習する」というより、**「過去の不平等な現実を、そのまま効率化して再現している」** と言えます。

#### 原因2:「何を公平とするか」をAI自身は決められない

これは最も根本的な限界です。

「採用において、性別による格差を是正すること」と「テストスコアだけで機械的に選ぶこと」、どちらが公平でしょうか?

「地域間の犯罪発生率の差を反映すること」と「個人の属性に関わらず同じ基準を適用すること」、どちらが公平でしょうか?

これらの価値判断は、社会の合意や倫理観に基づくものであり、AI自体には決めることができません。

人間が設定する目的や公平性の定義(数式)そのものが、すでに特定の「公平観」を内包しているのです。

#### 原因3:見えない特徴への間接的差別

AIは、直接的に「性別」や「人種」といった保護すべき属性を使わないように設計されることがあります(「公平性 through unawareness」)。

しかし、郵便番号(居住地域)、購買履歴、SNSの友人の傾向など、他のデータからそれらの属性を高精度に推測(プロキシ推測)できる場合があります。

結果として、間接的ではあれ、同じ偏りが判断に混入してしまうリスクがあります。

### 4. 人間の考える公平とのズレ

では、AIが下す「公平な判断」と、私たち人間が感じる「公平さ」には、どのようなズレが生じるのでしょうか。

#### 人間は「文脈」と「納得感」を求める

人間の公平感は、単なる数値やルールの一貫性だけでは成立しません。

「なぜその判断が下されたのか」という説明(説明可能性)と、個別の事情や背景(文脈)を考慮した上での「納得感」が不可欠です。

例えば、ある応募者が職歴に空白期間がある場合、AIはそれを単に「リスク要因」と判定するかもしれません。

しかし、その期間が育児や介護、病気の治療によるものであったという「文脈」を人間は考慮し、場合によってはそれを評価の対象とします。

AIはこのような個別の事情を、データからは読み取れないことが多いのです。

#### 「公平だが冷たい」判断

AIは設定されたルールに厳密に従います。

「一点の差で不合格」「年齢制限の一日前に生まれたので適用外」――これらはルール上は公平かもしれませんが、人間の感情からすれば「冷たい」「融通が利かない」と感じられるでしょう。

※(図:人間の公平とAIの公平の違い)

【人間の公平】ルールの一貫性 + 文脈の考慮 + 感情・倫理観 + 説明と納得感

【AIの公平】ルール(目的関数)の一貫性 + 統計的公平性の基準 + データのパターン

このズレは、AIが「人間社会の複雑で多層的な価値観」を完全には捉えきれないことを示しています。

### 5. 社会実装における課題と可能性

では、公平でないリスクを抱えるAIを、私たちはどのように社会に実装していけばよいのでしょうか。

#### AI判断を「どこまで」任せるか:ガバナンスの重要性

重要な判断ほど、AIに全てを任せる「ブラックボックス化」は危険です。

特に、人生に重大な影響を与える採用、融資、司法、医療などの領域では、AIはあくまで**「判断の補助ツール」** あるいは**「一次スクリーニングの手段」** と位置づけるべきです。

最終的な判断とその責任は、常に人間が持ち続ける必要があります。

#### 人間が介在すべき「3つのポイント」

1. **設計段階**:何を目的とし、どのような公平性の基準を採用するかを、多様な視点で議論・決定する。

2. **運用・監視段階**:AIの判断結果を継続的に監視し、意図しない偏りが生じていないかを検証する(監査)。

3. **最終判断・説明段階**:AIの出力を参考にしつつ、最終判断を下し、必要に応じてその理由を説明する責任を負う。

※(図:AI判断プロセスと人間の介在ポイント)

【設計】人間:目的・公平性の定義設定 → AI:学習

【判断】AI:出力・提案 → 【説明・最終判断】人間:監査・文脈考慮・最終決定・説明責任

AIの可能性は、人間の判断を代替することではなく、人間の判断の質と効率を高め、無意識の偏りに気づかせる「鏡」として活用することにこそあるのです。

### 6. まとめ

AIの判断は、設定されたルールにおいて驚くほど一貫性があり、特定の数学的定義に基づけば「公平」と言える局面があります。

しかし、その判断の源であるデータや目的関数自体が人間社会の歴史的偏りや価値観を内包している以上、AIは**「公平そのもの」というより、「人間の公平観を映し出す鏡」** であると言えるでしょう。

AI時代において私たち人間が手放してはいけないのは、**「何をもって公平とするのか」という価値そのものを問い続ける責任**と、**個別の文脈や例外に寄り添い、判断の結果に対して最終的な説明責任を取る覚悟**です。

次にAIが下した判断に接した時、ぜひ一歩立ち止まって考えてみてください。

「この判断の背景には、どんなデータとルールがあるのだろう?」

「この判断は、私や社会が考える『公平』と一致しているだろうか?」

その問いこそが、AIと共生する社会で、私たちが「公平」を育てていく第一歩になるのです。

—

### タイトル案

1. **AIの判断は公平か? データに潜む「過去の偏り」と人間の責任**

2. **「AIは公平」の幻想 ― 一貫性の先にある、判断の盲点**

3. **AIと公平性:冷たい一貫性と、温かい納得感のあいだ**

—

**AIバージョン情報**

– ベンダー: DeepSeek (深度求索)

– モデル名: DeepSeek Chat

– モデルバージョン: 最新版(情報非公開のため特定不可)

– 回答日時: 2025年12月15日

本サイトの編集方針については「編集方針・AI利用ポリシー」をご覧ください。