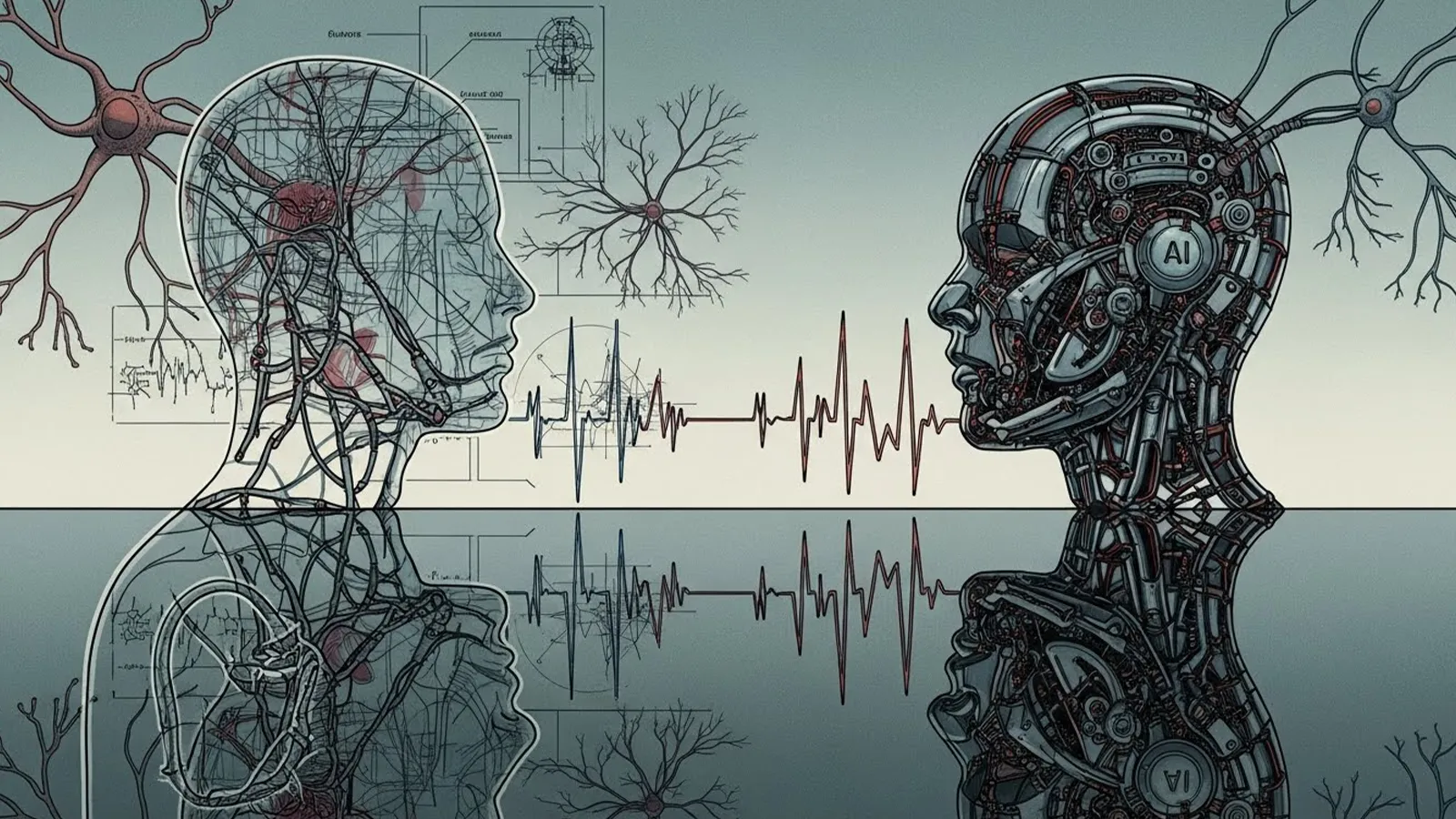

「AIは感情に左右されない」「人間よりも客観的で公平だ」――私たちは無意識のうちに、AIにこうしたイメージを重ねています。採用選考、融資審査、商品推薦、監視システムなど、AIによる判断が社会の重要な場面に入り込む今、「AIの判断は本当に公平と言えるのか?」という問いは、技術論にとどまらず、私たち自身の価値観を問い返すテーマになっています。

AIの判断は本当に「公平」と言えるのか?

1. なぜ今、「AIの公平性」が問われているのか

近年、AIは人間の意思決定を補助する存在から、実際の判断を担う存在へと役割を広げています。特に、採用や評価、与信、監視といった分野では、一度の判断が個人の人生に大きな影響を与えることも少なくありません。

その中で、「人間よりもAIのほうが偏見がなく、公平なのではないか」という期待が高まっています。しかし同時に、AIの判断が不透明であることへの不安や違和感も広がっています。このギャップこそが、今あらためて公平性が問われている理由です。

2. AIにおける「公平」の基本構造

AIは、人間のように感覚や直感で判断しているわけではありません。基本的には、以下の要素によって判断が行われています。

- 過去の大量のデータ

- 人間が設定したルールや目的関数

- 入力に対して最適とされる出力を選ぶ仕組み

AIの強みは、同じ条件には必ず同じ判断を返す一貫性にあります。人間のように気分や体調で判断が変わることはありません。

また、統計や数学の分野では、「特定の属性による差を最小化する」「平均との差を小さくする」といった、数値で定義された公平性の概念が存在します。AIは、こうした定義された公平性を忠実に実行することができます。

3. なぜAIの判断は「完全に公平」ではないのか

一方で、AIが完全に公平になることはありません。その最大の理由は、AIが過去のデータから学習する存在だからです。

もし学習データに偏りが含まれていれば、AIの判断もその偏りを引き継ぎます。たとえば、過去の採用実績に特定の性別や学歴が多ければ、それが「望ましいパターン」として学習されてしまう可能性があります。

さらに重要なのは、「何を公平とするか」をAI自身は決められないという点です。年齢を考慮しないことが公平なのか、事情を汲み取ることが公平なのか。その基準は人間社会の価値観によって決まります。

AIは、その価値判断を人間から与えられた範囲でしか動けません。その結果、過去の社会構造や人間の選択を、無自覚に再生産してしまうリスクが生まれます。

4. 人間の考える公平とのズレ

人間が「公平だ」と感じる判断には、数値化しにくい要素が含まれています。

- 個別の事情や背景

- その人が置かれた文脈

- 判断に対する納得感や配慮

一方で、AIは例外処理や感情の扱いを苦手とします。ルール通りに判断した結果、論理的には公平でも、冷たく感じられる結論が生まれることがあります。

※(図:人間の公平とAIの公平の違い)

このズレこそが、「AIの判断は正しいが、どこか信頼できない」と感じさせる原因になっています。

5. 社会実装における課題と可能性

では、AI判断は危険だから使うべきではないのでしょうか。必ずしもそうではありません。

重要なのは、AIに何を任せ、何を人間が担うのかを明確にすることです。

- 最終判断は人間が行う

- AIの判断プロセスを監督・検証する

- 判断の理由を説明できる体制を整える

AIを「公平な審判」として扱うのではなく、判断を支える補助ツールとして位置づけることが、現実的な活用の方向性と言えるでしょう。

※(図:AI判断プロセスと人間の介在ポイント)

6. まとめ|AIは「公平そのもの」ではない

AIは、完全に公平な存在ではありません。むしろ、人間がどのような公平観を持っているのかを映し出す鏡に近い存在です。

AI時代において重要なのは、判断を楽にすることではなく、どの判断を人間が手放してはいけないのかを考え続けることです。

AIの結論をそのまま受け取るのか、それとも問い直すのか。その選択をする責任は、今もこれからも人間自身にあります。

【テーマ】

「AIの判断は“公平”と言えるのか?」という問いについて、

AI自身の立場・仕組み・限界を踏まえながら、多角的に分析してください。

【目的】

– 「AIは公平か?」という直感的だが答えの難しい問いを、構造的に整理する

– AIの判断が“人間の公平”とどこで一致し、どこでズレるのかを読者に理解させる

– AI活用が進む社会で、人間が考えるべき責任の所在を示す

【読者像】

– 一般社会人、学生

– AIを日常的に使い始めているが、仕組みや倫理には詳しくない層

– AIによる判断(採用、評価、推薦、監視など)に漠然とした不安や期待を持つ人

【記事構成】

### 1. 導入(問題提起)

– 「AIは人間より公平なのではないか?」という一般的なイメージを提示

– なぜ今、この問いが重要になっているのか(AI判断の社会実装が進んでいる背景)

– 公平性が問われる具体的な場面(例:採用、融資、司法、推薦アルゴリズムなど)

### 2. AIにおける「公平」の基本構造

– AIはどのように判断を行っているのか(データ・ルール・目的関数)

– 「同じ入力には同じ出力を返す」というAIの一貫性

– 数学的・統計的な公平性の考え方が存在することを示す(詳細な数式説明は不要)

### 3. なぜAIの判断は“完全に公平”とは言えないのか

– 学習データに含まれる偏り(バイアス)の影響

– 「何を公平と定義するか」をAI自身は決められない点

– 過去の社会構造や人間の価値観を、そのまま再生産してしまうリスク

### 4. 人間の考える公平とのズレ

– 人間が重視する「事情」「文脈」「配慮」「納得感」

– AIが苦手とする例外処理や感情の扱い

– 公平だが冷たく感じられる判断が生まれる理由

※(図:人間の公平とAIの公平の違い)

### 5. 社会実装における課題と可能性

– AI判断をどこまで任せてよいのか

– 人間が介在すべきポイント(最終判断・監督・説明責任)

– AIを「公平な審判」ではなく「判断補助」として使う考え方

### 6. まとめ

– AIは「公平そのもの」ではなく、「人間の公平観を映す鏡」であること

– AI時代において、人間が手放してはいけない判断とは何か

– 読者自身がAIの判断をどう受け止めるかを問いかけて締めくくる

【文体・トーン】

– です・ます調

– 感情に寄りすぎず、冷静かつ論理的

– 専門用語は簡潔に補足説明を入れる

【出力形式】

– Markdown形式で出力

– 小見出し(###)を多めに使用し、論点を明確に

– 文字数は2000〜2500字を目安

– 記事末尾に「タイトル案」を3つ提示する

【補足指示】

– 抽象的な議論になりすぎないよう、身近な具体例を適宜入れること

– 図解が有効な箇所には、以下のようなコメントを入れてよい

※(図:AI判断プロセスと人間の介在ポイント)

【参考タイトル】

「AIの判断は本当に公平か? ― 期待と現実のあいだにあるもの」

—

**AIバージョン情報**

– ベンダー:

– モデル名:

– モデルバージョン:

– 回答日時:

### 1. 導入|「AIは人間より公平なのではないか?」

「AIは感情に左右されない」「人間よりも客観的で公平だ」

こうしたイメージを、私たちは無意識のうちにAIに重ねています。

近年、AIは採用選考、融資審査、商品推薦、監視カメラによる判定など、**社会的に重要な判断**の場面へ急速に入り込んできました。人間が行ってきた判断を、アルゴリズムに委ねるケースは今後さらに増えていくでしょう。

だからこそ今、改めて問われています。

**「AIの判断は、本当に公平と言えるのか?」**

この問いは、単なる技術論ではなく、私たちの価値観そのものに関わる問題です。

—

### 2. AIにおける「公平」の基本構造

AIは人間のように直感や感情で判断しているわけではありません。基本的には、次のような仕組みで動いています。

* 過去の大量のデータを学習する

* あらかじめ設定されたルールや目的関数に基づいて

* 入力に対して最適とされる出力を返す

このときAIが持つ「公平性」の強みは、**一貫性**にあります。

同じ条件が与えられれば、誰に対しても同じ判断を下す。人間のように気分や体調でブレることはありません。

また、統計や数学の世界では「平均との差を小さくする」「特定属性による差を抑える」といった、**数値で定義された公平性**の考え方も存在します。AIはこうした基準を忠実に実行できます。

—

### 3. なぜAIの判断は「完全に公平」ではないのか

しかし、ここに大きな落とし穴があります。

まず、AIは**過去のデータ**から学びます。そのデータ自体に偏りが含まれていれば、AIの判断も同じ偏りを引き継ぎます。

たとえば、過去の採用実績に特定の性別や学歴が多ければ、それを「成功パターン」として学習してしまう可能性があります。

さらに重要なのは、

**「何を公平とするか」をAI自身は決められない**

という点です。

年齢を考慮しないことが公平なのか、事情を汲み取ることが公平なのか。その基準は、人間社会の価値観に依存します。AIは、その価値判断を人間から与えられなければ動けません。

結果として、AIは過去の社会構造や人間の選択を、無自覚に再生産してしまうことがあります。

—

### 4. 人間の考える公平とのズレ

人間が「公平だ」と感じる判断には、数値では表しにくい要素が含まれます。

* 個別の事情や背景

* その人が置かれた文脈

* 判断に対する納得感や説明のしやすさ

一方、AIは例外処理や感情の扱いを苦手とします。

ルール通りに判断した結果、**論理的には公平でも、冷たく感じられる結論**が出ることがあります。

※(図:人間の公平とAIの公平の違い)

このズレが、「AIは正しいが信頼できない」と感じさせる原因になるのです。

—

### 5. 社会実装における課題と可能性

では、AI判断は危険だから使うべきではないのでしょうか。

必ずしもそうではありません。

重要なのは、**AIに何を任せ、何を人間が担うか**を明確にすることです。

* 最終判断は人間が行う

* AIの判断プロセスを監督・検証する

* なぜその結論に至ったのかを説明できる体制を整える

AIを「公平な審判」として扱うのではなく、**判断を支える補助ツール**として位置づける。この考え方が、現実的な落としどころと言えるでしょう。

※(図:AI判断プロセスと人間の介在ポイント)

—

### 6. まとめ|AIは「公平そのもの」ではない

AIは、完全に公平な存在ではありません。

むしろ、**人間がどんな公平観を持っているのかを映し出す鏡**に近い存在です。

AI時代において重要なのは、「判断を楽にすること」ではなく、

**どの判断を人間が手放してはいけないのかを考え続けること**です。

AIの結論をそのまま受け取るのか、問い直すのか。

その選択をするのは、今もこれからも人間自身です。

—

## タイトル案

1. **AIの判断は本当に公平か?――人間の価値観とアルゴリズムのズレを読み解く**

2. **「AIは公平」という幻想を疑う――判断を委ねる前に知っておくべきこと**

3. **AIは中立な審判になれるのか?公平性の正体を多角的に考える**

—

**AIバージョン情報**

* ベンダー: OpenAI

* モデル名: ChatGPT

* モデルバージョン: GPT-5.2

* 回答日時: 2025-12-15(JST)

本サイトの編集方針については「編集方針・AI利用ポリシー」をご覧ください。