災害現場で救助隊が誰を優先するか、病院で重症患者にどの治療を優先するか、自動運転車が事故を避けられない場合にどちらを守るか――こうした「命の優先順位」を決める判断は、かつては人間の専権事項でした。しかし今、AI(人工知能)がその一部を補助する時代が始まっています。

例えば、医療現場ではAIが患者の重症度を瞬時に推定し、トリアージ(優先順位付け)を支援しています。災害時には、AIが被災者の位置情報や負傷状況を分析し、救助隊の行動を最適化します。自動運転車も、事故回避のために「最小の被害」を選択するアルゴリズムを搭載しています。これらはすべて、AIが「命の優先順位」に関わる判断を補助している事例です。

しかし、AIが「判断」を下すことの意味とは何でしょうか?技術の進歩はどこまで可能性を広げ、どこに限界があるのでしょうか?この記事では、AIが人命に直結する意思決定に関わる現実と課題を、技術・倫理・社会制度の観点から探ります。

AIが“優先順位判断”に関わるようになった背景

技術進歩が可能にした「判断の補助」

AIが優先順位判断に関わるようになった最大の理由は、技術の飛躍的な進歩です。

- 画像診断の精度向上:AIはX線やMRI画像から病変を検出し、医師の診断を補助します。例えば、がんの早期発見や脳卒中のリスク評価で、人間の目よりも高い精度を発揮することがあります。

- リアルタイム解析:災害現場では、AIがドローンやセンサーからのデータを瞬時に解析し、救助の優先順位を提案します。

- 膨大なデータ処理能力:AIは過去の医療データや事故データを学習し、統計的に最適な判断を導き出します。

一方、人間の判断には限界があります。疲労や主観、情報過多によるミスが避けられません。AIはこうした「人間の弱点」を補うツールとして注目されています。

AIはセンサーやデータベースから情報を収集し、アルゴリズムに基づいて優先順位を提示。最終判断は人間が行う。

AIが得意な領域・不得意な領域

AIが得意なこと

- 重症度推定:患者のバイタルデータから、治療の優先度を瞬時に算出します。

- リスク計算:自動運転車が事故を回避する際、統計的に「最小の被害」を選択します。

- 最適ルート分析:災害時、救助隊の移動ルートを最適化し、より多くの命を救う手助けをします。

- リアルタイム処理:人間では処理しきれない大量のデータを瞬時に解析し、判断材料を提供します。

AIが不得意なこと

- 価値観の判断:「誰の命が大切か」という倫理的な問いには、AIは答えられません。

- 倫理基準の設定:文化や社会によって異なる倫理観を、AIは理解できません。

- 人間の尊厳に関する判断:例えば、高齢者と子どもの命を天秤にかける場面で、AIは「正解」を示せません。

統計的判断と価値判断の違い

AIは「過去のデータに基づく最適解」を提示しますが、それが「社会的に受け入れられるか」は別の問題です。例えば、自動運転車が「乗員を守るために歩行者を犠牲にする」アルゴリズムは、技術的には合理的でも、倫理的には議論を呼びます。

AIが命の優先順位を決めるリスク・限界

誤判定のリスク

AIの判断が誤っている場合、取り返しのつかない結果を招く可能性があります。例えば、医療AIが誤って重症患者を見過ごせば、命に関わります。また、学習データに偏りがあると、特定の集団(例えば少数民族や高齢者)に不利な判断を下す「データバイアス」の問題も指摘されています。

透明性と説明責任

AIの判断プロセスは「ブラックボックス」と呼ばれることがあります。なぜその判断が下されたのか、人間が理解できない場合、説明責任を果たせません。これは医療や法律の現場で特に問題となります。

法制度と社会的合意の遅れ

AIが判断に関わる場合、誰が責任を負うのか?現行の法律は、AIの「判断」を想定していません。また、社会的な合意形成も追いついていません。

AIの判断に関わるリスク(誤判定、バイアス、透明性の欠如)と、それを管理するためのガバナンス(法律、倫理ガイドライン、監査体制)の関係を示す。

現実的に起こりうる未来シナリオ

「最終決定」ではなく「判断材料の提示」

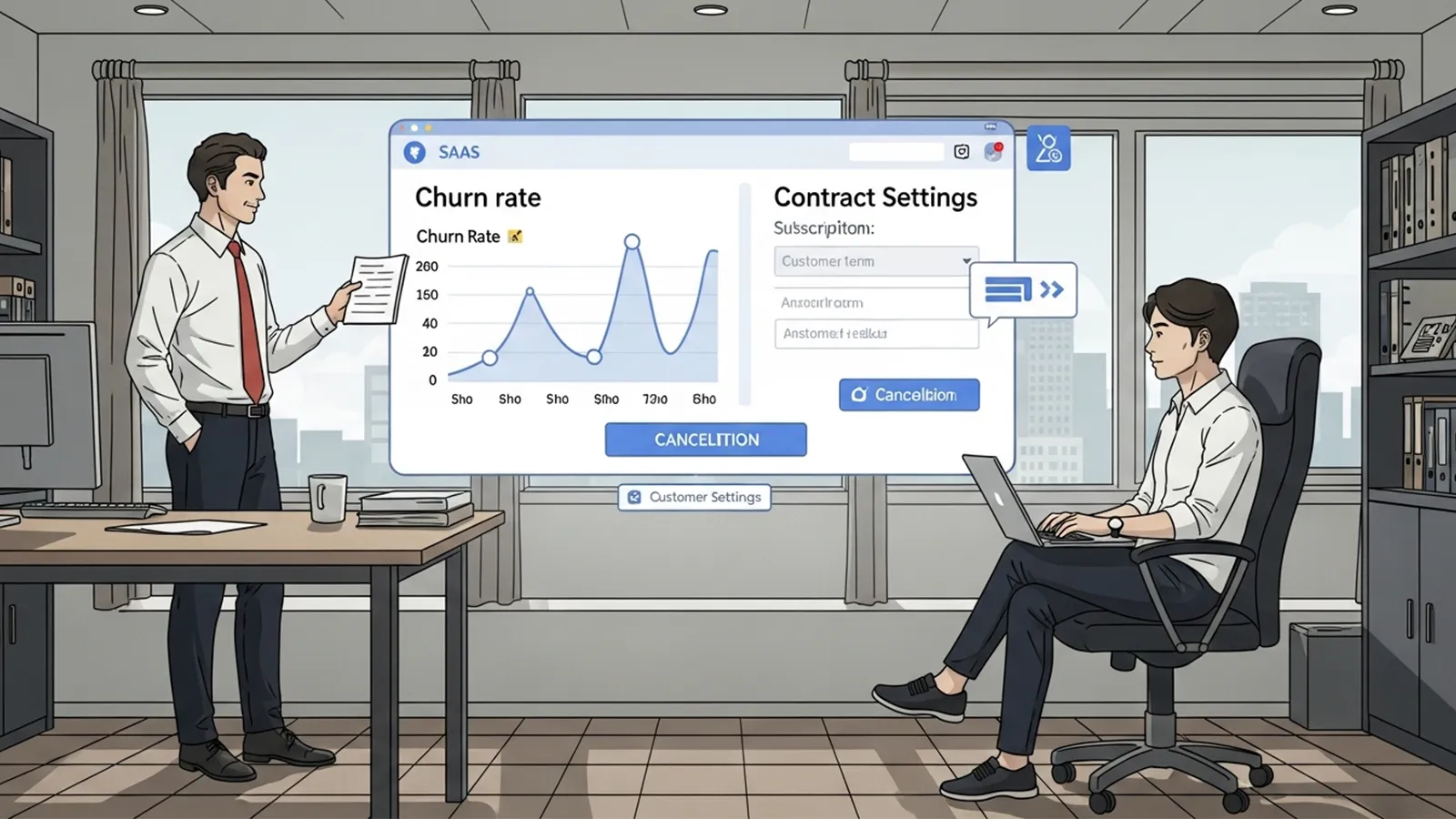

AIが「命の優先順位を完全に決める」未来は、まだ遠いでしょう。代わりに、AIが「判断材料を提示し、人間が最終決定する」協働モデルが主流になると予測されます。

- 医療現場:AIが患者の重症度を提示し、医師が最終判断を下します。

- 災害救助:AIが救助の優先順位を提案し、救助隊が現場の状況を加味して行動します。

- 自動運転:AIが事故回避の選択肢を示し、運転者(または遠隔オペレーター)が決定します。

海外事例と国内の取り組み

- IBM Watson Health:がん治療の優先順位付けを支援するAIツール。

- EUのAI倫理ガイドライン:AIの意思決定における透明性と説明責任を求める規制。

- 日本の自動運転ガイドライン:事故時の責任分担を明確化するための議論が進んでいます。

社会への影響と導入の課題

法整備と倫理ガイドライン

AIが命の優先順位に関わる場合、透明性と説明責任が不可欠です。例えば、AIが下した判断の理由を人間が理解できるようにする「説明可能なAI(XAI)」の研究が進んでいます。

過度な依存のリスク

AIに判断を委ねすぎると、人間の判断力が低下する恐れがあります。また、AIシステムの導入には高額な費用や専門人材が必要で、すべての組織が対応できるわけではありません。

組織や自治体のハードル

AIを導入するには、費用や人材育成、運用体制の整備が必要です。特に地方自治体や中小企業では、導入が進みにくいのが現状です。

まとめ:AIと人間の協働が未来を切り開く

AIが「命の優先順位を完全に決める」未来は、まだ遠いでしょう。しかし、「判断の補助として優先順位を提示する」未来はすでに始まっています。技術の進歩と倫理的な議論を両立させ、AIと人間が協働する社会を築くことが求められています。

AIはツールであり、最終的な判断は人間が行う――そのバランスをどう取るか。私たち一人ひとりが、この問いに向き合う時が来ています。

【テーマ】

“命の優先順位”をAIが決める時代は本当に来るのか。

医療・災害・自動運転など、人命に直結する領域でAIが意思決定を担う未来を、

技術・倫理・社会制度の観点から総合的に分析してください。

【目的】

– AIが人命判断に関わる際の“現実と限界”を、一般読者にもわかりやすく整理する。

– 技術的可能性だけでなく、倫理・法律・社会的受容性をバランスよく伝える。

– 読者に「AIはどこまで任せられるのか?」という思考のきっかけを与える。

【読者像】

– 一般社会人、学生、行政関係者

– AIが医療や自動運転に使われていることは知っているが、詳しくは知らない層

– 事故現場や災害時の“優先順位判断”に興味がある人

– 技術と倫理の関係に関心がある読者

【記事構成】

1. **導入(問題提起)**

– 「命の優先順位」を決める判断が、すでに一部AIで補助されている現状

– 医療トリアージ・災害救助・自動運転の意思決定などの例を簡潔に提示する

2. **AIが“優先順位判断”に関わるようになった背景**

– 画像診断の精度向上、リアルタイム解析、膨大なデータ処理能力

– 人間判断の限界(疲労・主観・情報量の多さ)

– 技術進歩で“判断の補助”が現実的になった理由

※(図:AIが優先順位判断を補助する仕組み)

3. **AIが得意な領域・不得意な領域**

– **得意**:重症度推定、リスク計算、最適ルート分析、リアルタイム処理

– **不得意**:価値観の判断、倫理基準の設定、文化的背景の理解、人間の尊厳に関する判断

– 統計的判断と“価値判断”の違いを解説する

4. **AIが命の優先順位を決めるリスク・限界**

– 誤判定が取り返しのつかない結果になる問題

– データバイアス(学習データに偏りがあると特定の集団に不利)

– 透明性・説明責任(AIの“理由”が説明できない場合の問題)

– 法制度と社会的合意が追いつかない現状

※(図:リスク要因とガバナンス構造)

5. **現実的に起こりうる未来シナリオ**

– AIが“最終決定”ではなく“判断材料の提示”を担う未来

– 医師・救助隊・運転者などが最終判断を行う“協働モデル”

– 完全自動化ではなく、人間とAIの役割分担が主流になる予測

– 海外事例や国内の取り組み(実在・仮想どちらでも可)

6. **社会への影響と導入の課題**

– 法整備、倫理ガイドライン、説明責任、透明性

– AIへの過度な依存のリスク

– 組織や自治体が導入する際のハードル(費用・人材・運用体制)

7. **まとめ**

– AIが「命の優先順位を完全に決める」未来は遠い

– しかし「判断の補助として優先順位を提示する」未来はすでに始まっている

– 技術と倫理を両立させる社会的取り組みの重要性を強調して締めくくる

【文体・トーン】

– です・ます調

– 客観的で冷静、専門用語には必ず一文で補足説明を付与

– 読みやすいが、内容的には深く掘り下げる

【出力形式】

– Markdown形式

– 小見出し(###)を多めに使用

– 文字数は2000〜2500字を目安

– 記事末尾に「タイトル案」を3つ提示する

【補足指示】

– “AIモデルの判断フロー”や“リスク構造”など、図解が有効な箇所には

※(図:AI判断プロセスのイメージ)

のようにコメントを追加してよい。

【バージョン情報の出力】

記事本文とタイトル案のあとに、必ず以下の形式で「AIバージョン情報」を追記してください。

(不明な項目は「不明」と記載すること)

—

**AIバージョン情報**

– ベンダー:

– モデル名:

– モデルバージョン:

– 回答日時:

—

【参考タイトル】

「AIは“命の優先順位”を決められるのか ― 技術・倫理・社会から考える未来の意思決定」

—

## 導入:AIがすでに関わる「命の優先順位」判断

災害現場で救助隊が誰を優先するか、病院で重症患者にどの治療を優先するか、自動運転車が事故を避けられない場合にどちらを守るか――こうした「命の優先順位」を決める判断は、かつては人間の専権事項でした。しかし今、AI(人工知能)がその一部を補助する時代が始まっています。

例えば、医療現場ではAIが患者の重症度を瞬時に推定し、トリアージ(優先順位付け)を支援しています。災害時には、AIが被災者の位置情報や負傷状況を分析し、救助隊の行動を最適化します。自動運転車も、事故回避のために「最小の被害」を選択するアルゴリズムを搭載しています。これらはすべて、AIが「命の優先順位」に関わる判断を補助している事例です。

しかし、AIが「判断」を下すことの意味とは何でしょうか?技術の進歩はどこまで可能性を広げ、どこに限界があるのでしょうか?この記事では、AIが人命に直結する意思決定に関わる現実と課題を、技術・倫理・社会制度の観点から探ります。

—

## AIが“優先順位判断”に関わるようになった背景

### 技術進歩が可能にした「判断の補助」

AIが優先順位判断に関わるようになった最大の理由は、技術の飛躍的な進歩です。

– **画像診断の精度向上**:AIはX線やMRI画像から病変を検出し、医師の診断を補助します。例えば、がんの早期発見や脳卒中のリスク評価で、人間の目よりも高い精度を発揮することがあります。

– **リアルタイム解析**:災害現場では、AIがドローンやセンサーからのデータを瞬時に解析し、救助の優先順位を提案します。

– **膨大なデータ処理能力**:AIは過去の医療データや事故データを学習し、統計的に最適な判断を導き出します。

一方、人間の判断には限界があります。疲労や主観、情報過多によるミスが避けられません。AIはこうした「人間の弱点」を補うツールとして注目されています。

※(図:AIが優先順位判断を補助する仕組み)

*AIはセンサーやデータベースから情報を収集し、アルゴリズムに基づいて優先順位を提示。最終判断は人間が行う。*

—

## AIが得意な領域・不得意な領域

### AIが得意なこと

– **重症度推定**:患者のバイタルデータから、治療の優先度を瞬時に算出します。

– **リスク計算**:自動運転車が事故を回避する際、統計的に「最小の被害」を選択します。

– **最適ルート分析**:災害時、救助隊の移動ルートを最適化し、より多くの命を救う手助けをします。

– **リアルタイム処理**:人間では処理しきれない大量のデータを瞬時に解析し、判断材料を提供します。

### AIが不得意なこと

– **価値観の判断**:「誰の命が大切か」という倫理的な問いには、AIは答えられません。

– **倫理基準の設定**:文化や社会によって異なる倫理観を、AIは理解できません。

– **人間の尊厳に関する判断**:例えば、高齢者と子どもの命を天秤にかける場面で、AIは「正解」を示せません。

– **統計的判断と価値判断の違い**:AIは「確率的に最適」な選択肢を提示しますが、それが「倫理的に正しい」とは限りません。

—

**統計的判断と価値判断の違い**

AIは「過去のデータに基づく最適解」を提示しますが、それが「社会的に受け入れられるか」は別の問題です。例えば、自動運転車が「乗員を守るために歩行者を犠牲にする」アルゴリズムは、技術的には合理的でも、倫理的には議論を呼びます。

—

## AIが命の優先順位を決めるリスク・限界

### 誤判定のリスク

AIの判断が誤っている場合、取り返しのつかない結果を招く可能性があります。例えば、医療AIが誤って重症患者を見過ごせば、命に関わります。また、学習データに偏りがあると、特定の集団(例えば少数民族や高齢者)に不利な判断を下す「データバイアス」の問題も指摘されています。

### 透明性と説明責任

AIの判断プロセスは「ブラックボックス」と呼ばれることがあります。なぜその判断が下されたのか、人間が理解できない場合、説明責任を果たせません。これは医療や法律の現場で特に問題となります。

### 法制度と社会的合意の遅れ

AIが判断に関わる場合、誰が責任を負うのか?現行の法律は、AIの「判断」を想定していません。また、社会的な合意形成も追いついていません。

※(図:リスク要因とガバナンス構造)

*AIの判断に関わるリスク(誤判定、バイアス、透明性の欠如)と、それを管理するためのガバナンス(法律、倫理ガイドライン、監査体制)の関係を示す。*

—

## 現実的に起こりうる未来シナリオ

### 「最終決定」ではなく「判断材料の提示」

AIが「命の優先順位を完全に決める」未来は、まだ遠いでしょう。代わりに、AIが「判断材料を提示し、人間が最終決定する」協働モデルが主流になると予測されます。

– **医療現場**:AIが患者の重症度を提示し、医師が最終判断を下します。

– **災害救助**:AIが救助の優先順位を提案し、救助隊が現場の状況を加味して行動します。

– **自動運転**:AIが事故回避の選択肢を示し、運転者(または遠隔オペレーター)が決定します。

### 海外事例と国内の取り組み

– **IBM Watson Health**:がん治療の優先順位付けを支援するAIツール。

– **EUのAI倫理ガイドライン**:AIの意思決定における透明性と説明責任を求める規制。

– **日本の自動運転ガイドライン**:事故時の責任分担を明確化するための議論が進んでいます。

—

## 社会への影響と導入の課題

### 法整備と倫理ガイドライン

AIが命の優先順位に関わる場合、透明性と説明責任が不可欠です。例えば、AIが下した判断の理由を人間が理解できるようにする「説明可能なAI(XAI)」の研究が進んでいます。

### 過度な依存のリスク

AIに判断を委ねすぎると、人間の判断力が低下する恐れがあります。また、AIシステムの導入には高額な費用や専門人材が必要で、すべての組織が対応できるわけではありません。

### 組織や自治体のハードル

AIを導入するには、費用や人材育成、運用体制の整備が必要です。特に地方自治体や中小企業では、導入が進みにくいのが現状です。

—

## まとめ:AIと人間の協働が未来を切り開く

AIが「命の優先順位を完全に決める」未来は、まだ遠いでしょう。しかし、「判断の補助として優先順位を提示する」未来はすでに始まっています。技術の進歩と倫理的な議論を両立させ、AIと人間が協働する社会を築くことが求められています。

AIはツールであり、最終的な判断は人間が行う――そのバランスをどう取るか。私たち一人ひとりが、この問いに向き合う時が来ています。

—

### タイトル案

1. 「AIは“命の優先順位”を決められるのか ― 医療・災害・自動運転で進む「判断の補助」とその限界」

2. 「AIが命を選ぶ時代は来るか?技術の可能性と倫理のジレンマ」

3. 「自動運転、医療、災害救助 ― AIが関わる「命の優先順位」の現実と課題」

—

**AIバージョン情報**

– ベンダー: Mistral AI

– モデル名: Le Chat

– モデルバージョン: 不明

– 回答日時: 2025年12月8日

本サイトの編集方針については「編集方針・AI利用ポリシー」をご覧ください。