「この患者とあの患者、どちらを先に治療すべきか」「災害現場で、救助の優先順位はどうつけるか」「自動運転車が事故を回避しようとする時、乗員と歩者のどちらを優先するのか」。これらは、人間にとって最も重い「命の優先順位」に関する判断です。実は今、これらの判断場面で、人工知能(AI)が補助的に使われ始めています。医療現場ではAIによる画像診断が病気の重症度を評価し、災害時にはドローンが撮影した映像からAIが被災者の位置と状態を分析。自動運転技術では、衝突回避のための瞬時の判断アルゴリズムが開発されています。私たちは、AIが「誰の命を優先するか」という判断に関わる時代の入り口に立っているのです。

AIが“優先順位判断”に関わるようになった背景

技術的ブレイクスルー

AI、特に「ディープラーニング(深層学習)」と呼ばれる技術の進歩が、この変化を後押ししています。医療画像の解析精度は人間の専門医を凌駕するものも現れ、リアルタイムで大量のデータ(ビッグデータ)を処理し、パターンを見つけ出す能力が飛躍的に向上しました。※(図:AIが優先順位判断を補助する仕組み)

人間判断の限界への対応

一方で、人間による判断には避けられない限界があります。医師や救助隊員は疲労やストレスの影響を受け、無意識の「主観」や「偏見」が入る可能性もあります。また、災害時のように情報が錯綜し、判断時間が限られる状況では、人間の情報処理能力だけでは最適な判断が難しくなります。AIは、こうした人間の限界を補い、判断の質と速度を上げる「ツール」として期待されているのです。

AIが得意な領域・不得意な領域

AIが“得意”なこと:データに基づく高速な分析

- 重症度やリスクの「推定」:膨大な過去のデータを学習したAIは、患者の症状や画像から、死亡リスクや重症化リスクを数値として算出できます。

- 最適な資源配分の「計算」:限られた救急車や医療資源を、どこにどの順番で配分すれば全体の生存率が最大化されるか、複雑な計算を瞬時に行えます。

- リアルタイムの状況「分析」:自動運転車のセンサーデータや災害現場の映像から、危険度や緊急度を継続的に評価します。

AIの判断の核心は、統計的な確率計算です。「過去の類似ケースでは、この条件の患者は80%の確率で重症化した」といった「確からしさ」に基づいています。

AIが“不得意”なこと:価値観や文脈の理解

- 倫理的な「価値判断」:例えば、「若者と高齢者、どちらの命が優先か」という問いには、統計的な正解はありません。社会の倫理観、文化、個人の価値観が複雑に絡む「価値判断」が必要です。

- 個人の背景や「物語」の理解:患者がこれまでどう生きたか、家族の状況はどうかといった、データ化されない個別の事情や文脈を理解することは困難です。

- 人間の尊厳への配慮:単に生存確率を最大化するだけでなく、「尊厳をもった死」や「本人の意思」をどう尊重するかといった判断は、AIの苦手とする領域です。

つまり、AIは「どうすればより多くの命が統計的に救えるか」を計算できますが、「誰の命がより重いか」「どんな死に方が尊厳あるか」を決めることは本質的にできないのです。

AIが命の優先順位を決めるリスク・限界

AIに判断を委ねることには、重大なリスクと限界が伴います。

1. 誤判定の致命的な結果

医療でも自動運転でも、AIの判断ミスは即、人命の損失につながります。AIモデルは完璧ではなく、学習データにない未知の状況では誤った判断を下す可能性があります。

2. データに潜む「バイアス(偏り)」

AIは学習データの「鏡」です。もし過去の医療データに特定の人種や性別に対する治療格差が反映されていれば、AIはその偏りを増幅し、不公平な判断を再生産する恐れがあります。※(図:リスク要因とガバナンス構造)

3. 「ブラックボックス」問題と説明責任

最新のAIは、なぜその判断に至ったのか、その理由を人間が理解しにくい「ブラックボックス」である場合が多くあります。患者や遺族に「なぜ助けてくれなかったのか」と問われた時、誰が、どう説明責任を果たすのでしょうか。

4. 法制度と社会合意の不在

「AIが人命判断の補助をすること」を認める法的枠組みや、判断基準に関する社会的な合意は、ほとんど整っていないのが現状です。技術の進歩に、倫理と法整備が追いついていません。

現実的に起こりうる未来シナリオ

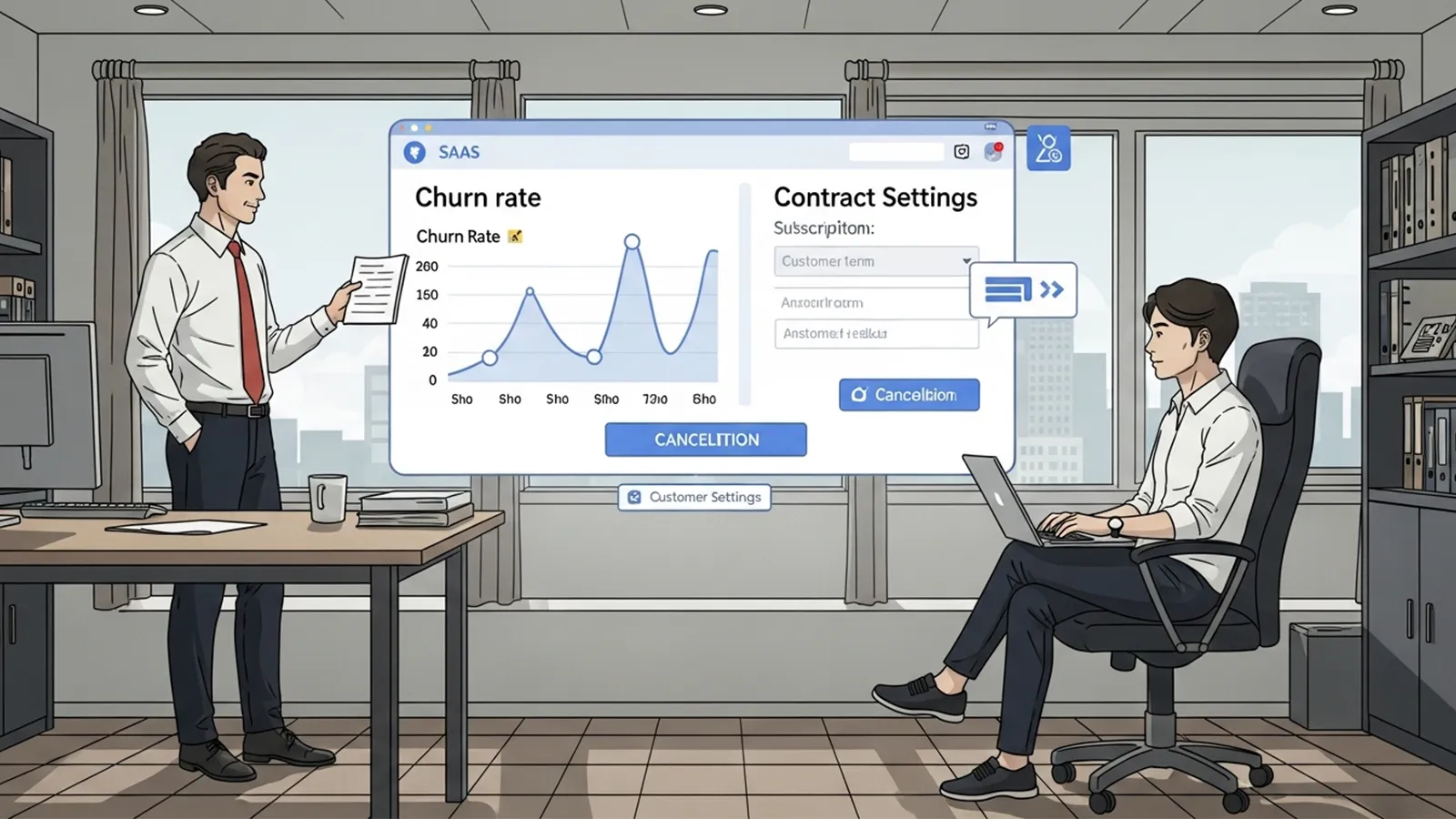

では、私たちはどのような未来を目指すべきなのでしょうか。「AIがすべてを決める」完全自動化のシナリオではなく、現実的で望ましい未来は「協働モデル」です。

人間とAIの「協働モデル」の広がり

- AIの役割:判断材料の提示・分析

AIは、「この患者の重症化リスクは95%」「このルートを通ると歩行者との衝突確率が最小になる」など、客観的なデータと複数の選択肢、その予測結果を提示します。 - 人間の役割:最終判断と責任の所在

提示された情報を踏まえ、倫理的価値観や個別の事情を考慮して最終判断を下すのは、医師、救助指揮官、運転者(またはメーカー・社会)という人間(または人間の組織)です。責任の所在は明確に人間側に残ります。

国内外の取り組みの方向性

欧米では、自動運転の倫理基準を公開で議論し、ガイドライン策定を進める動きがあります。国内でも、AI医療機器の審査基準の整備や、災害対応におけるAI活用の実証実験が進められています。いずれも、「AIをどう使うか」のルールを、技術開発と並行して社会で作っていくことが共通の課題です。

社会への影響と導入の課題

この協働モデルを現実のものとするためには、乗り越えるべき社会的・制度的なハードルが数多くあります。

1. ガバナンス(統治)の整備

- 法整備:AIを人命に関わる判断に利用する際の責任の所在、賠償責任、認可プロセスを法律で明確化する必要があります。

- 倫理ガイドライン:業界や分野ごとに、AIの開発・利用における倫理原則(公平性、透明性、説明責任など)を策定し、遵守させる仕組みが必要です。

- 監査と透明性:AIの判断がバイアスを持っていないか、定期的に監査(検査)し、可能な限り判断プロセスを開示する「説明可能なAI(XAI)」の研究が不可欠です。

2. 組織的な導入のハードル

病院や自治体がこうしたシステムを導入するには、莫大な初期投資に加え、AIを理解し、適切に使いこなせる人材の育成が必須です。さらに、日常的な運用やメンテナンスの体制も整えなければなりません。

3. 過度な依存のリスクへの警戒

AIの判断が高度に洗練されると、人間はその判断を盲目的に信頼し、自らの批判的思考を働かせなくなる「自動化バイアス」の危険性があります。AIはあくまで「補助」であり、人間が最後のチェック機能として働き続けることが重要です。

まとめ

AIが「命の優先順位」を完全に、自律的に決断する時代は、技術的にも倫理的にも、まだ遠い未来の話でしょう。しかし、「判断の材料を提供し、優先順位の一つの案を提示する」という形で、AIが人命に関わる判断を補助する時代は、すでに始まっています。

この新しい時代を乗り切る鍵は、技術の可能性に浮かれるのでも、恐怖から一切を否定するのでもなく、「人間らしさ」とは何かを問い直しながら、技術と倫理を両立させる社会的な仕組みを、一人ひとりが考え、築いていくことにあります。AIが提示する「統計的に最適な答え」と、私たち人間が持つ「価値観に基づく答え」。この二者の対話こそが、これからの社会にとって最も重要なプロセスになるのです。

【テーマ】

“命の優先順位”をAIが決める時代は本当に来るのか。

医療・災害・自動運転など、人命に直結する領域でAIが意思決定を担う未来を、

技術・倫理・社会制度の観点から総合的に分析してください。

【目的】

– AIが人命判断に関わる際の“現実と限界”を、一般読者にもわかりやすく整理する。

– 技術的可能性だけでなく、倫理・法律・社会的受容性をバランスよく伝える。

– 読者に「AIはどこまで任せられるのか?」という思考のきっかけを与える。

【読者像】

– 一般社会人、学生、行政関係者

– AIが医療や自動運転に使われていることは知っているが、詳しくは知らない層

– 事故現場や災害時の“優先順位判断”に興味がある人

– 技術と倫理の関係に関心がある読者

【記事構成】

1. **導入(問題提起)**

– 「命の優先順位」を決める判断が、すでに一部AIで補助されている現状

– 医療トリアージ・災害救助・自動運転の意思決定などの例を簡潔に提示する

2. **AIが“優先順位判断”に関わるようになった背景**

– 画像診断の精度向上、リアルタイム解析、膨大なデータ処理能力

– 人間判断の限界(疲労・主観・情報量の多さ)

– 技術進歩で“判断の補助”が現実的になった理由

※(図:AIが優先順位判断を補助する仕組み)

3. **AIが得意な領域・不得意な領域**

– **得意**:重症度推定、リスク計算、最適ルート分析、リアルタイム処理

– **不得意**:価値観の判断、倫理基準の設定、文化的背景の理解、人間の尊厳に関する判断

– 統計的判断と“価値判断”の違いを解説する

4. **AIが命の優先順位を決めるリスク・限界**

– 誤判定が取り返しのつかない結果になる問題

– データバイアス(学習データに偏りがあると特定の集団に不利)

– 透明性・説明責任(AIの“理由”が説明できない場合の問題)

– 法制度と社会的合意が追いつかない現状

※(図:リスク要因とガバナンス構造)

5. **現実的に起こりうる未来シナリオ**

– AIが“最終決定”ではなく“判断材料の提示”を担う未来

– 医師・救助隊・運転者などが最終判断を行う“協働モデル”

– 完全自動化ではなく、人間とAIの役割分担が主流になる予測

– 海外事例や国内の取り組み(実在・仮想どちらでも可)

6. **社会への影響と導入の課題**

– 法整備、倫理ガイドライン、説明責任、透明性

– AIへの過度な依存のリスク

– 組織や自治体が導入する際のハードル(費用・人材・運用体制)

7. **まとめ**

– AIが「命の優先順位を完全に決める」未来は遠い

– しかし「判断の補助として優先順位を提示する」未来はすでに始まっている

– 技術と倫理を両立させる社会的取り組みの重要性を強調して締めくくる

【文体・トーン】

– です・ます調

– 客観的で冷静、専門用語には必ず一文で補足説明を付与

– 読みやすいが、内容的には深く掘り下げる

【出力形式】

– Markdown形式

– 小見出し(###)を多めに使用

– 文字数は2000〜2500字を目安

– 記事末尾に「タイトル案」を3つ提示する

【補足指示】

– “AIモデルの判断フロー”や“リスク構造”など、図解が有効な箇所には

※(図:AI判断プロセスのイメージ)

のようにコメントを追加してよい。

【バージョン情報の出力】

記事本文とタイトル案のあとに、必ず以下の形式で「AIバージョン情報」を追記してください。

(不明な項目は「不明」と記載すること)

—

**AIバージョン情報**

– ベンダー:

– モデル名:

– モデルバージョン:

– 回答日時:

—

【参考タイトル】

「AIは“命の優先順位”を決められるのか ― 技術・倫理・社会から考える未来の意思決定」

## 導入(問題提起)

「この患者とあの患者、どちらを先に治療すべきか」

「災害現場で、救助の優先順位はどうつけるか」

「自動運転車が事故を回避しようとする時、乗員と歩者のどちらを優先するのか」

これらは、人間にとって最も重い「命の優先順位」に関する判断です。実は今、これらの判断場面で、人工知能(AI)が補助的に使われ始めています。医療現場ではAIによる画像診断が病気の重症度を評価し、災害時にはドローンが撮影した映像からAIが被災者の位置と状態を分析。自動運転技術では、衝突回避のための瞬時の判断アルゴリズムが開発されています。私たちは、AIが「誰の命を優先するか」という判断に関わる時代の入り口に立っているのです。

## AIが“優先順位判断”に関わるようになった背景

### 技術的ブレイクスルー

AI、特に「ディープラーニング(深層学習)」と呼ばれる技術の進歩が、この変化を後押ししています。医療画像の解析精度は人間の専門医を凌駕するものも現れ、リアルタイムで大量のデータ(ビッグデータ)を処理し、パターンを見つけ出す能力が飛躍的に向上しました。※(図:AIが優先順位判断を補助する仕組み)

### 人間判断の限界への対応

一方で、人間による判断には避けられない限界があります。医師や救助隊員は疲労やストレスの影響を受け、無意識の「主観」や「偏見」が入る可能性もあります。また、災害時のように情報が錯綜し、判断時間が限られる状況では、人間の情報処理能力だけでは最適な判断が難しくなります。AIは、こうした人間の限界を補い、判断の質と速度を上げる「ツール」として期待されているのです。

## AIが得意な領域・不得意な領域

### AIが“得意”なこと:データに基づく高速な分析

– **重症度やリスクの「推定」**:膨大な過去のデータを学習したAIは、患者の症状や画像から、死亡リスクや重症化リスクを数値として算出できます。

– **最適な資源配分の「計算」**:限られた救急車や医療資源を、どこにどの順番で配分すれば全体の生存率が最大化されるか、複雑な計算を瞬時に行えます。

– **リアルタイムの状況「分析」**:自動運転車のセンサーデータや災害現場の映像から、危険度や緊急度を継続的に評価します。

AIの判断の核心は、**統計的な確率計算**です。「過去の類似ケースでは、この条件の患者は80%の確率で重症化した」といった「確からしさ」に基づいています。

### AIが“不得意”なこと:価値観や文脈の理解

– **倫理的な「価値判断」**:例えば、「若者と高齢者、どちらの命が優先か」という問いには、統計的な正解はありません。社会の倫理観、文化、個人の価値観が複雑に絡む「価値判断」が必要です。

– **個人の背景や「物語」の理解**:患者がこれまでどう生きたか、家族の状況はどうかといった、データ化されない個別の事情や文脈を理解することは困難です。

– **人間の尊厳への配慮**:単に生存確率を最大化するだけでなく、「尊厳をもった死」や「本人の意思」をどう尊重するかといった判断は、AIの苦手とする領域です。

つまり、AIは「どうすればより多くの命が統計的に救えるか」を計算できますが、「誰の命がより重いか」「どんな死に方が尊厳あるか」を決めることは本質的にできないのです。

## AIが命の優先順位を決めるリスク・限界

AIに判断を委ねることには、重大なリスクと限界が伴います。

### 1. 誤判定の致命的な結果

医療でも自動運転でも、AIの判断ミスは即、人命の損失につながります。AIモデルは完璧ではなく、学習データにない未知の状況では誤った判断を下す可能性があります。

### 2. データに潜む「バイアス(偏り)」

AIは学習データの「鏡」です。もし過去の医療データに特定の人種や性別に対する治療格差が反映されていれば、AIはその偏りを増幅し、不公平な判断を再生産する恐れがあります。※(図:リスク要因とガバナンス構造)

### 3. 「ブラックボックス」問題と説明責任

最新のAIは、なぜその判断に至ったのか、その理由を人間が理解しにくい「ブラックボックス」である場合が多くあります。患者や遺族に「なぜ助けてくれなかったのか」と問われた時、誰が、どう説明責任を果たすのでしょうか。

### 4. 法制度と社会合意の不在

「AIが人命判断の補助をすること」を認める法的枠組みや、判断基準に関する社会的な合意は、ほとんど整っていないのが現状です。技術の進歩に、倫理と法整備が追いついていません。

## 現実的に起こりうる未来シナリオ

では、私たちはどのような未来を目指すべきなのでしょうか。「AIがすべてを決める」完全自動化のシナリオではなく、現実的で望ましい未来は「協働モデル」です。

### 人間とAIの「協働モデル」の広がり

– **AIの役割:判断材料の提示・分析**

AIは、「この患者の重症化リスクは95%」「このルートを通ると歩行者との衝突確率が最小になる」など、**客観的なデータと複数の選択肢、その予測結果**を提示します。

– **人間の役割:最終判断と責任の所在**

**提示された情報を踏まえ、倫理的価値観や個別の事情を考慮して最終判断を下すのは、医師、救助指揮官、運転者(またはメーカー・社会)** という人間(または人間の組織)です。責任の所在は明確に人間側に残ります。

### 国内外の取り組みの方向性

欧米では、自動運転の倫理基準を公開で議論し、ガイドライン策定を進める動きがあります。国内でも、AI医療機器の審査基準の整備や、災害対応におけるAI活用の実証実験が進められています。いずれも、**「AIをどう使うか」のルールを、技術開発と並行して社会で作っていく**ことが共通の課題です。

## 社会への影響と導入の課題

この協働モデルを現実のものとするためには、乗り越えるべき社会的・制度的なハードルが数多くあります。

### 1. ガバナンス(統治)の整備

– **法整備**:AIを人命に関わる判断に利用する際の責任の所在、賠償責任、認可プロセスを法律で明確化する必要があります。

– **倫理ガイドライン**:業界や分野ごとに、AIの開発・利用における倫理原則(公平性、透明性、説明責任など)を策定し、遵守させる仕組みが必要です。

– **監査と透明性**:AIの判断がバイアスを持っていないか、定期的に監査(検査)し、可能な限り判断プロセスを開示する「説明可能なAI(XAI)」の研究が不可欠です。

### 2. 組織的な導入のハードル

病院や自治体がこうしたシステムを導入するには、莫大な初期投資に加え、AIを理解し、適切に使いこなせる人材の育成が必須です。さらに、日常的な運用やメンテナンスの体制も整えなければなりません。

### 3. 過度な依存のリスクへの警戒

AIの判断が高度に洗練されると、人間はその判断を盲目的に信頼し、自らの批判的思考を働かせなくなる「自動化バイアス」の危険性があります。AIはあくまで「補助」であり、人間が最後のチェック機能として働き続けることが重要です。

## まとめ

AIが「命の優先順位」を完全に、自律的に決断する時代は、技術的にも倫理的にも、まだ遠い未来の話でしょう。しかし、**「判断の材料を提供し、優先順位の一つの案を提示する」という形で、AIが人命に関わる判断を補助する時代は、すでに始まっています。**

この新しい時代を乗り切る鍵は、技術の可能性に浮かれるのでも、恐怖から一切を否定するのでもなく、**「人間らしさ」とは何かを問い直しながら、技術と倫理を両立させる社会的な仕組みを、一人ひとりが考え、築いていくこと**にあります。AIが提示する「統計的に最適な答え」と、私たち人間が持つ「価値観に基づく答え」。この二者の対話こそが、これからの社会にとって最も重要なプロセスになるのです。

—

### タイトル案

1. **「命の優先順位」をAIは決められるか 医療・災害・自動運転で問われる技術と倫理**

2. **AIが「誰を助けるか」を決める日 私たちはその判断をどこまで委ねられるのか**

3. **救う命の“順番”を人工知能に託すとき 協働モデルが導く未来の意思決定**

—

**AIバージョン情報**

– ベンダー: 深度求索

– モデル名: DeepSeek

– モデルバージョン: DeepSeek最新版

– 回答日時: 2025年12月8日

本サイトの編集方針については「編集方針・AI利用ポリシー」をご覧ください。