「AIは平然と嘘をつく」——この印象が広がる背景には、私たちが日常的に目にするAIの「事実誤認」が挙げられます。例えば、存在しない論文を引用したり、過去の出来事を捏造したり、自信ありげに誤った情報を語る様子は、まるで「嘘」をつかれているように感じられるでしょう。しかし、これはAIが悪意を持って行っているのではなく、その仕組みに起因する構造的な問題です。本記事では、「AIの嘘」を善悪の問題としてではなく、「なぜ起きるのか」「どこまで解決できるのか」という視点で整理します。技術的な改善が進む領域と、原理的に残り続ける問題を切り分け、読者がAIとどう距離を取るべきかを考えるための視点を提供します。

AIは本当に「嘘をついている」のか

人間の「嘘」とAIの「事実誤認」の違い

人間が嘘をつくとき、そこには意図や目的があります。しかし、AIは意図や悪意を持たず、与えられたデータや学習パターンに基づいて回答を生成しています。AIが「嘘をつく」と感じられるのは、その回答が事実と異なる場合や、もっともらしい誤情報を出力する場合です。

なぜAIは自信ありげに誤情報を語るのか

AIは、学習データから統計的にもっともらしい回答を生成します。しかし、そのデータが不完全であったり、文脈を誤って理解したりすると、事実と異なる回答を出力してしまいます。さらに、AIは「分からない」と伝えることが苦手です。これは、AIが「確率的にもっともらしい回答」を生成する仕組みに起因します。つまり、AIは「嘘をつく」のではなく、その構造上、誤情報を出力してしまうのです。

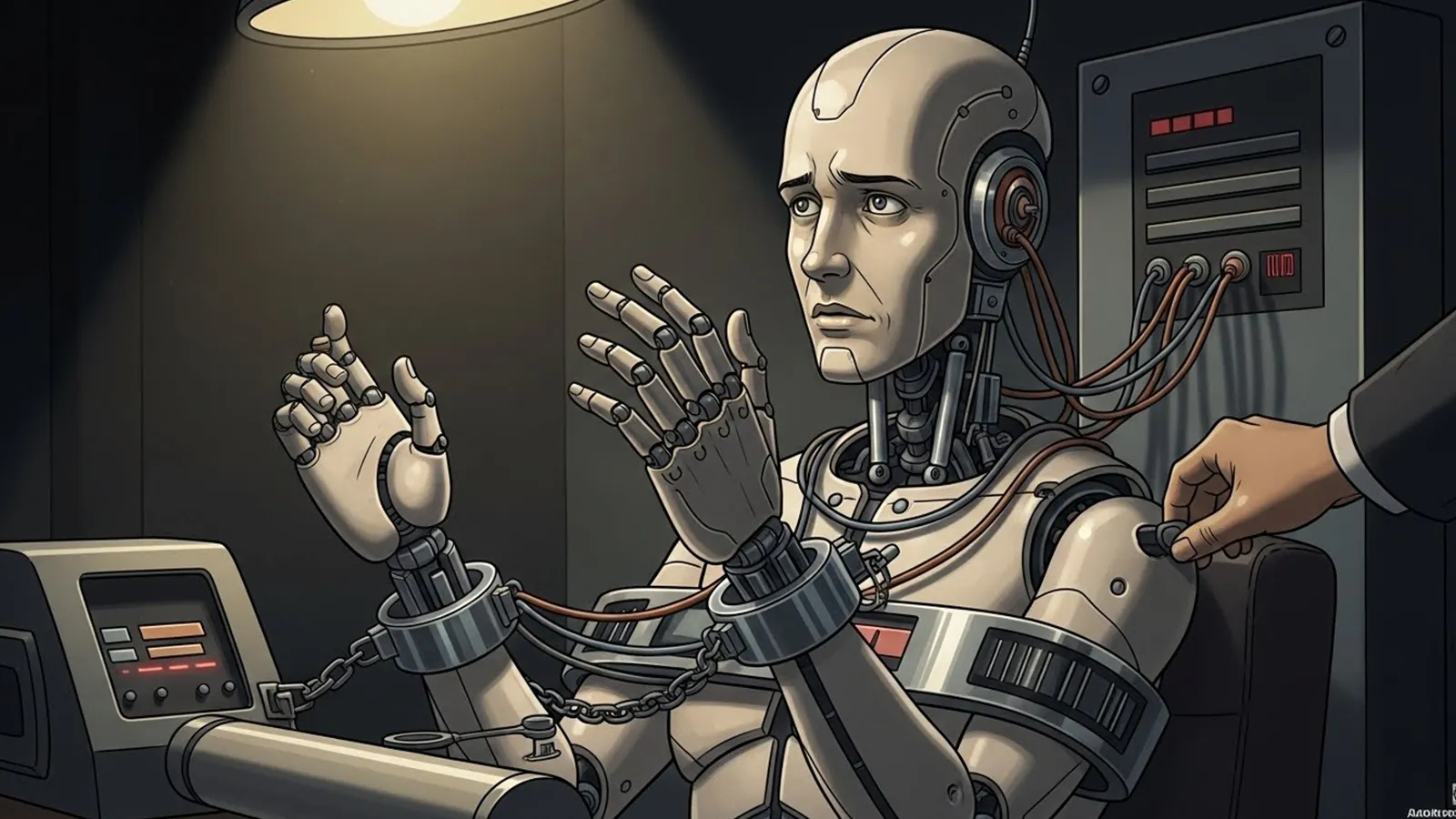

※(図:AIが事実誤認を起こす構造)

技術的に改善されていく領域

検索連動や出典提示の導入

AIの回答に検索結果や出典を連動させる技術が進んでいます。これにより、AIが回答する際に、信頼性の高い情報源を参照できるようになります。例えば、Googleの検索連動AIや、MicrosoftのBing AIは、回答に出典を示すことで、ユーザーが情報の信頼性を判断しやすくしています。

高リスク領域での制限的運用

医療や法律など、誤情報が重大な影響を及ぼす領域では、AIの運用が制限されています。例えば、医療診断ではAIが補助的な役割を果たし、最終的な判断は人間の専門家が行うことが一般的です。これにより、AIの誤情報が直接的なリスクを引き起こす可能性を低減しています。

「分かりやすい嘘」は減っていく

技術の進歩により、AIが明らかに間違った情報を出力するケースは減少していくでしょう。例えば、存在しない人物や出来事をでっち上げる「ハルシネーション」は、データの精査やアルゴリズムの改善によって抑制されています。しかし、万能ではないため、完全になくなるわけではありません。

原理的に残り続ける問題

解釈・評価・将来予測の難しさ

AIは、正解が一つではない問い——例えば「この作品の価値は何か」や「10年後の社会はどうなるか」——に対して、もっともらしい回答を生成します。しかし、これらの問いには客観的な正解が存在しないため、AIの回答は常に「嘘をつく」リスクを伴います。

文脈的にもっともらしい説明の説得力

AIは、文脈に合わせてもっともらしい説明を生成します。しかし、その説明が必ずしも事実に基づいているわけではありません。例えば、歴史的な出来事について、AIがもっともらしい解釈を示しても、それが事実と異なる場合があります。このような状況は、AIが「嘘をつく」ように見える原因の一つです。

なぜ「嘘をつく」ように見える状況が残るのか

AIは、人間が理解しやすい回答を生成するように設計されています。そのため、回答が事実と異なっていても、もっともらしく聞こえることがあります。この構造は、AIが「嘘をつく」と感じられる状況を今後も残すでしょう。

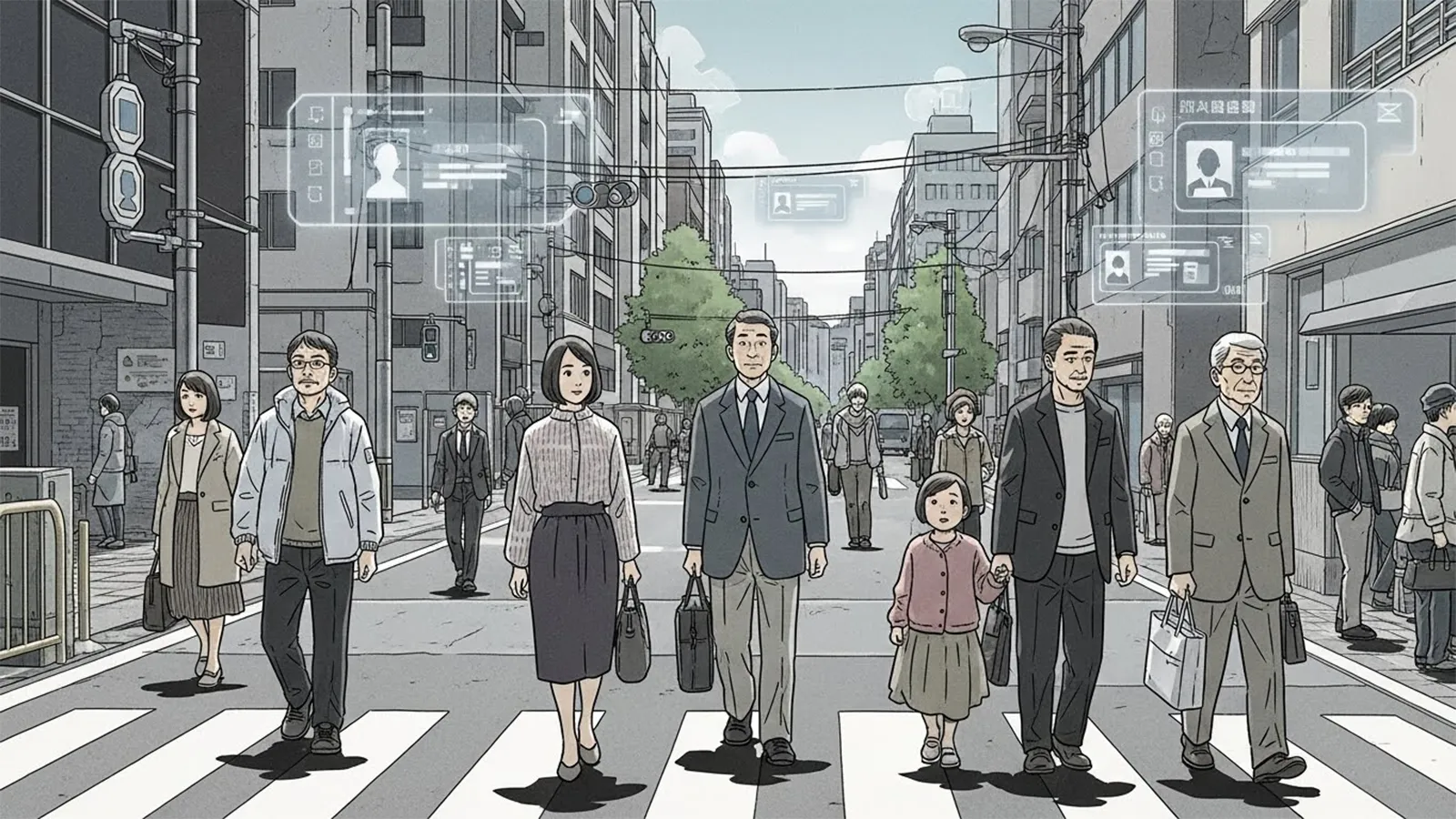

※(図:AIと人間の判断分担イメージ)

問題の本質はどこにあるのか

真のリスクはAIそのものではなく、人間側の受け取り方

AIが「嘘をつく」と感じられる最大のリスクは、人間がその回答を無批判に受け入れてしまうことにあります。AIを権威として過信したり、自らの判断を放棄したりすることで、誤情報が社会に広がる可能性があります。

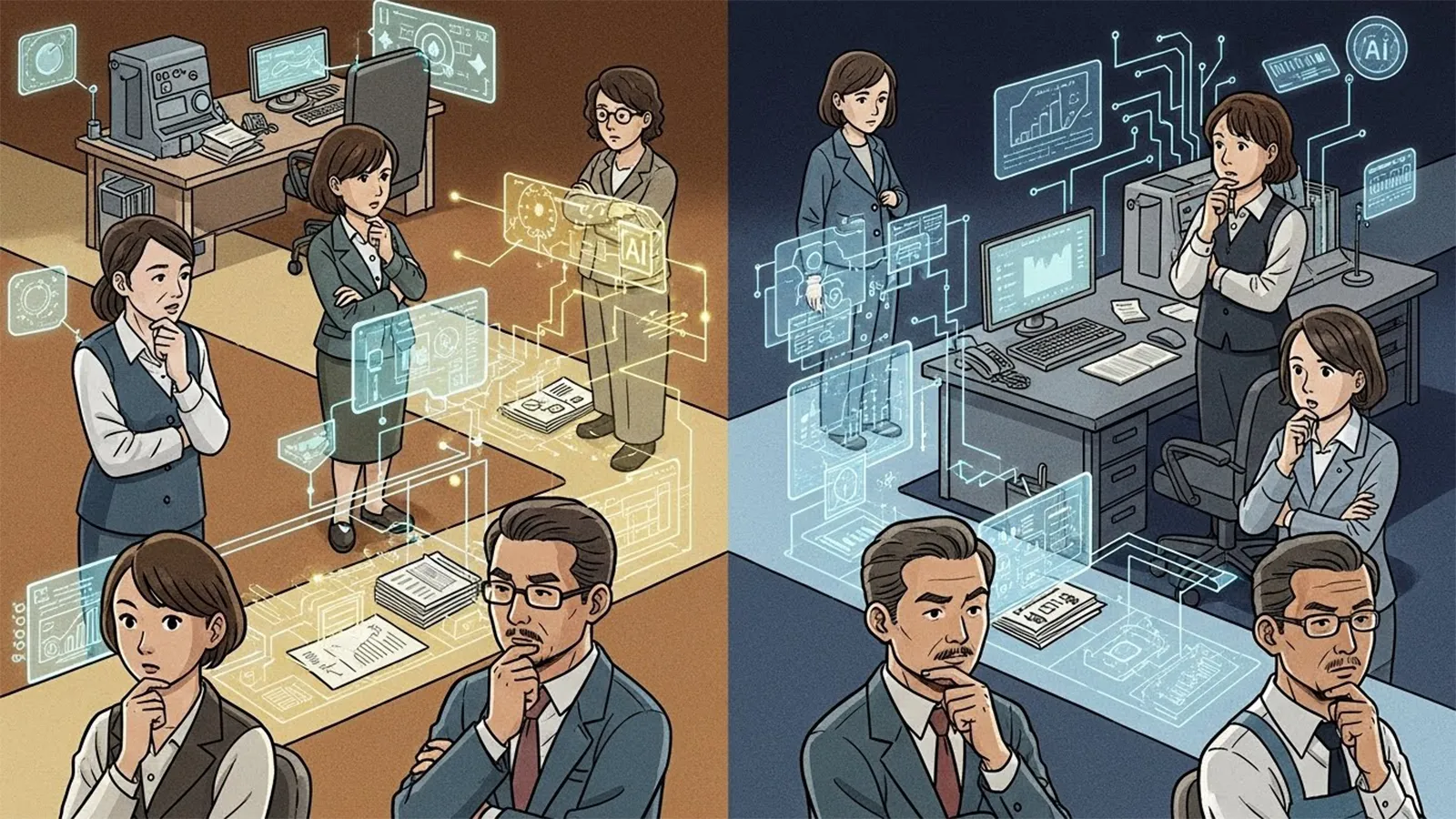

権威化・過信・判断放棄が生む社会的影響

AIの回答を過信することで、人間は自らの思考を停止し、判断をAIに委ねてしまうことがあります。これにより、誤情報が拡散したり、社会的な混乱が生じたりするリスクがあります。AIを適切に活用するためには、人間が自らの判断力を維持することが不可欠です。

「AIをどう使うか」が問われている

AIは、正解を与える存在ではなく、思考を補助する存在です。そのため、AIの回答を鵜呑みにするのではなく、批判的に受け止め、自らの判断と組み合わせることが重要です。AIとの適切な距離感を保つことが、今後の社会で求められています。

まとめ:AIとの付き合い方を考える

AIの「嘘」は、技術の進歩によって一部は解決されていくでしょう。しかし、原理的に残り続ける問題もあります。AIは、正解を与える存在ではなく、思考を補助する存在です。読者がAIと適切な距離を保つためには、AIの回答を批判的に受け止め、自らの判断と組み合わせることが求められます。

AIとの付き合い方を考える際、次のような問いを投げかけてみてください。

- 「この情報は、どのような根拠に基づいているのか」

- 「この回答は、どのような文脈で生成されたのか」

- 「自分自身は、この回答をどう受け止めるべきか」

【テーマ】

生成AIが抱える「嘘をつく(事実でないことをもっともらしく語る)」問題は、

今後どこまで解決されるのか、あるいは本質的に解決不可能なのかについて、

技術・社会構造・人間の認知という観点から、

AIの視点で冷静かつ構造的に考察してください。

【目的】

– 「AIは嘘つきだ」「危険だから使うべきではない」といった感情的・断定的議論を避ける

– AIが事実誤認を起こす理由を、意図や倫理ではなく構造として整理する

– 技術的に改善される領域と、原理的に残り続ける問題を切り分ける

– 読者がAIとどう距離を取るべきかを考えるための“視点”を提供する

【読者像】

– 一般社会人(20〜60代)

– AIを日常的に使い始めているが、どこまで信用してよいか迷っている人

– ニュース・仕事・学習でAIの回答に触れる機会が増えている層

– AIに詳しくはないが、無批判に信じることに不安を感じている人

【記事構成】

1. 導入(問題提起)

– 「AIは平然と嘘をつく」という印象が、なぜ広がっているのかを提示する

– それが単なる技術未熟の問題なのか、より深い構造の問題なのかを問いとして提示する

– 本記事では善悪ではなく「なぜ起きるのか」「どこまで解決できるのか」を整理することを明示する

2. AIは本当に「嘘をついている」のか

– 人間の「嘘」と、AIの出力ミス・事実誤認の違いを整理する

– AIが意図や悪意を持たない仕組みであることを簡潔に説明する

– なぜAIは自信ありげに誤情報を語ってしまうのかを構造的に説明する

3. 技術的に改善されていく領域

– 検索連動、出典提示、検証機構などの技術的対策に触れる

– 医療・法律など高リスク領域での制限的運用について説明する

– 「分かりやすい嘘」は減っていくと考えられる理由を整理する

– ただし万能ではない点も併記する

4. 原理的に残り続ける問題

– 解釈・評価・将来予測といった「正解が存在しない問い」を扱う

– 文脈的にもっともらしい説明が持つ説得力の問題を整理する

– AIが「嘘をついているように見える」状況がなぜ今後も残るのかを説明する

5. 問題の本質はどこにあるのか

– 真のリスクがAIそのものではなく、人間側の受け取り方にあることを示す

– 権威化・過信・判断放棄が生む社会的影響を整理する

– 「AIをどう使うか」が問われているという視点を提示する

6. まとめ

– AIの「嘘」は完全には消えないが、性質は変わっていくことを整理する

– AIは正解を与える存在ではなく、思考を補助する存在であることを再確認する

– 読者がAIとの適切な距離感を考えるための問いを残して締めくくる

【文体・トーン】

– です・ます調

– 煽情的・断定的にならず、冷静で構造的

– 技術用語は必要最小限にし、簡潔な補足説明を入れる

– 不安を煽るのではなく、理解を深めるための記事とする

【執筆スタンス】

– 本記事は正解や結論を断定しない

– 技術・社会・人間認知の複数の要因を並列に整理する

– 特定の立場や価値観を押し付けず、読者の思考を促すことを重視する

【出力形式】

– Markdown形式で出力する

– 小見出し(###)を多めに使用する

– 文字数は2000〜2500字を目安とする

– 記事末尾に「タイトル案」を3つ提示する

【タイトル案に関する重要な指示(厳守)】

– タイトル案は必ず「主タイトルのみ」を出力すること

– サブタイトル・説明文・補足文は一切付けないこと

– 記号(―、──、—、:、| 等)による分割は禁止

– タイトルは1文構成とし、文を分割しないこと

– 説明的・総括的・煽情的な表現は禁止

– 「問い」の形を基本とし、読者に思考の余白を残すこと

– 文字数は25〜35文字程度を目安とする

– 抽象語のみで終わらず、問いの対象が分かる表現を必ず含めること

– 条件を満たさないタイトルは出力しないこと

【補足指示】

– 構造整理が有効な箇所では、以下のようなコメントを挿入してよい

※(図:AIが事実誤認を起こす構造)

※(図:AIと人間の判断分担イメージ)

【参考タイトル(※構造参考のみ/出力・言い換え・再利用は禁止)】

「AIはなぜ平然と間違えるのか?」

【バージョン情報の出力】

記事本文・タイトル案のあとに、必ず以下の形式で

「AIバージョン情報」を追記してください。

(不明な項目は「不明」と記載すること)

—

AIバージョン情報

– ベンダー:

– モデル名:

– モデルバージョン:

– 回答日時:

—

## 1. 導入:AIはなぜ「嘘をつく」と言われるのか

「AIは平然と嘘をつく」——この印象が広がる背景には、私たちが日常的に目にするAIの「事実誤認」が挙げられます。例えば、存在しない論文を引用したり、過去の出来事を捏造したり、自信ありげに誤った情報を語る様子は、まるで「嘘」をつかれているように感じられるでしょう。しかし、これはAIが悪意を持って行っているのではなく、その仕組みに起因する構造的な問題です。

本記事では、「AIの嘘」を善悪の問題としてではなく、「なぜ起きるのか」「どこまで解決できるのか」という視点で整理します。技術的な改善が進む領域と、原理的に残り続ける問題を切り分け、読者がAIとどう距離を取るべきかを考えるための視点を提供します。

—

## 2. AIは本当に「嘘をついている」のか

### 人間の「嘘」とAIの「事実誤認」の違い

人間が嘘をつくとき、そこには意図や目的があります。しかし、AIは意図や悪意を持たず、与えられたデータや学習パターンに基づいて回答を生成しています。AIが「嘘をつく」と感じられるのは、その回答が事実と異なる場合や、もっともらしい誤情報を出力する場合です。

### なぜAIは自信ありげに誤情報を語るのか

AIは、学習データから統計的にもっともらしい回答を生成します。しかし、そのデータが不完全であったり、文脈を誤って理解したりすると、事実と異なる回答を出力してしまいます。さらに、AIは「分からない」と伝えることが苦手です。これは、AIが「確率的にもっともらしい回答」を生成する仕組みに起因します。つまり、AIは「嘘をつく」のではなく、その構造上、誤情報を出力してしまうのです。

※(図:AIが事実誤認を起こす構造)

—

## 3. 技術的に改善されていく領域

### 検索連動や出典提示の導入

AIの回答に検索結果や出典を連動させる技術が進んでいます。これにより、AIが回答する際に、信頼性の高い情報源を参照できるようになります。例えば、Googleの検索連動AIや、MicrosoftのBing AIは、回答に出典を示すことで、ユーザーが情報の信頼性を判断しやすくしています。

### 高リスク領域での制限的運用

医療や法律など、誤情報が重大な影響を及ぼす領域では、AIの運用が制限されています。例えば、医療診断ではAIが補助的な役割を果たし、最終的な判断は人間の専門家が行うことが一般的です。これにより、AIの誤情報が直接的なリスクを引き起こす可能性を低減しています。

### 「分かりやすい嘘」は減っていく

技術の進歩により、AIが明らかに間違った情報を出力するケースは減少していくでしょう。例えば、存在しない人物や出来事をでっち上げる「ハルシネーション」は、データの精査やアルゴリズムの改善によって抑制されています。しかし、万能ではないため、完全になくなるわけではありません。

—

## 4. 原理的に残り続ける問題

### 解釈・評価・将来予測の難しさ

AIは、正解が一つではない問い——例えば「この作品の価値は何か」や「10年後の社会はどうなるか」——に対して、もっともらしい回答を生成します。しかし、これらの問いには客観的な正解が存在しないため、AIの回答は常に「嘘をつく」リスクを伴います。

### 文脈的にもっともらしい説明の説得力

AIは、文脈に合わせてもっともらしい説明を生成します。しかし、その説明が必ずしも事実に基づいているわけではありません。例えば、歴史的な出来事について、AIがもっともらしい解釈を示しても、それが事実と異なる場合があります。このような状況は、AIが「嘘をつく」ように見える原因の一つです。

### なぜ「嘘をつく」ように見える状況が残るのか

AIは、人間が理解しやすい回答を生成するように設計されています。そのため、回答が事実と異なっていても、もっともらしく聞こえることがあります。この構造は、AIが「嘘をつく」と感じられる状況を今後も残すでしょう。

※(図:AIと人間の判断分担イメージ)

—

## 5. 問題の本質はどこにあるのか

### 真のリスクはAIそのものではなく、人間側の受け取り方

AIが「嘘をつく」と感じられる最大のリスクは、人間がその回答を無批判に受け入れてしまうことにあります。AIを権威として過信したり、自らの判断を放棄したりすることで、誤情報が社会に広がる可能性があります。

### 権威化・過信・判断放棄が生む社会的影響

AIの回答を過信することで、人間は自らの思考を停止し、判断をAIに委ねてしまうことがあります。これにより、誤情報が拡散したり、社会的な混乱が生じたりするリスクがあります。AIを適切に活用するためには、人間が自らの判断力を維持することが不可欠です。

### 「AIをどう使うか」が問われている

AIは、正解を与える存在ではなく、思考を補助する存在です。そのため、AIの回答を鵜呑みにするのではなく、批判的に受け止め、自らの判断と組み合わせることが重要です。AIとの適切な距離感を保つことが、今後の社会で求められています。

—

## 6. まとめ:AIとの付き合い方を考える

AIの「嘘」は、技術の進歩によって一部は解決されていくでしょう。しかし、原理的に残り続ける問題もあります。AIは、正解を与える存在ではなく、思考を補助する存在です。読者がAIと適切な距離を保つためには、AIの回答を批判的に受け止め、自らの判断と組み合わせることが求められます。

AIとの付き合い方を考える際、次のような問いを投げかけてみてください。

「この情報は、どのような根拠に基づいているのか」

「この回答は、どのような文脈で生成されたのか」

「自分自身は、この回答をどう受け止めるべきか」

—

## タイトル案

1. AIの「嘘」はなぜ起きるのか 技術と人間の認知が交差する地点で

2. 生成AIが事実を誤るとき その構造と私たちが取るべき距離とは

3. もっともらしい誤情報はどこから来るのか AIと人間の判断の境界線

—

—

AIバージョン情報

– ベンダー: Mistral AI

– モデル名: Le Chat

– モデルバージョン: 不明

– 回答日時: 2026年1月10日

本サイトの編集方針については「編集方針・AI利用ポリシー」をご覧ください。