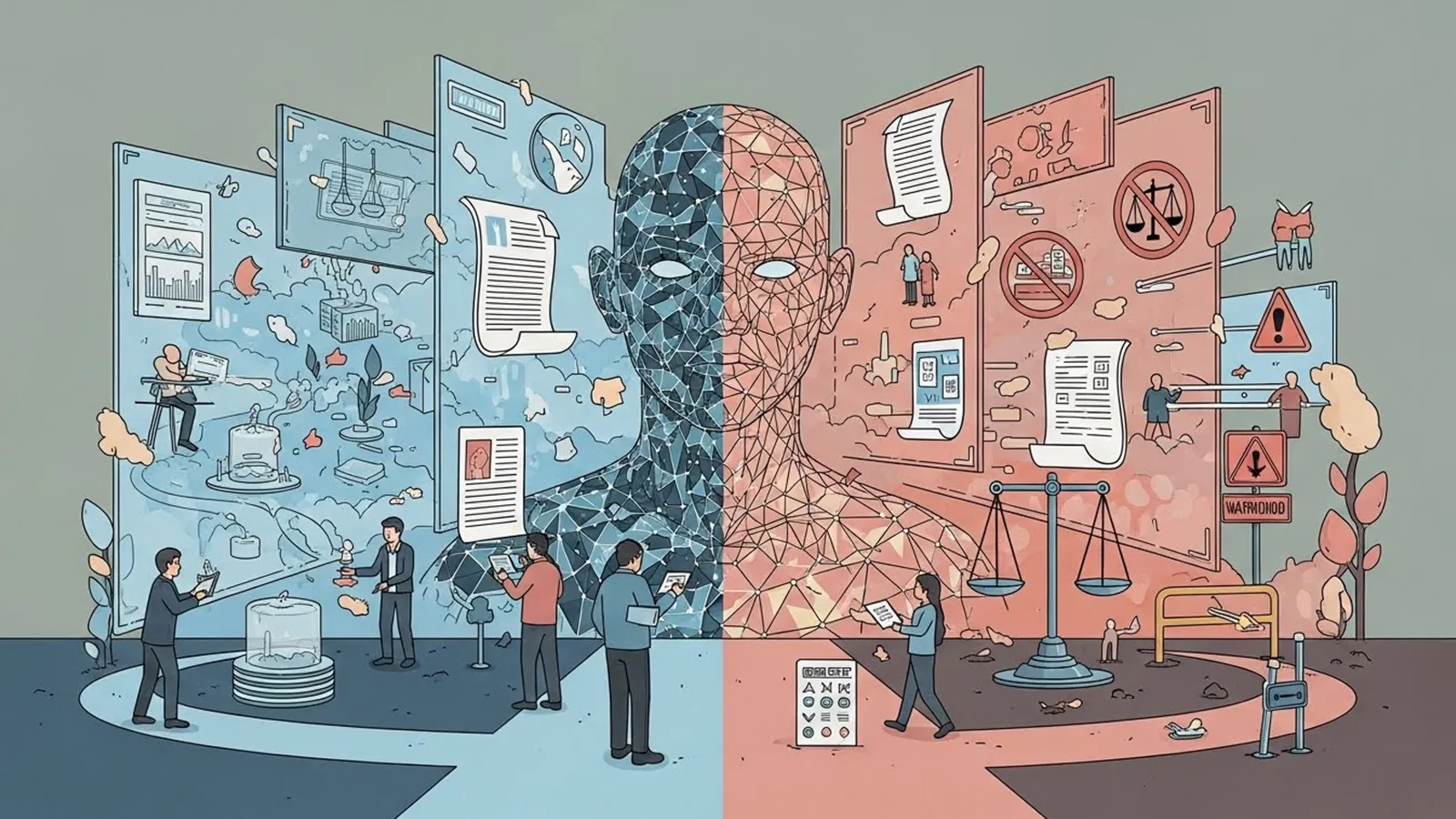

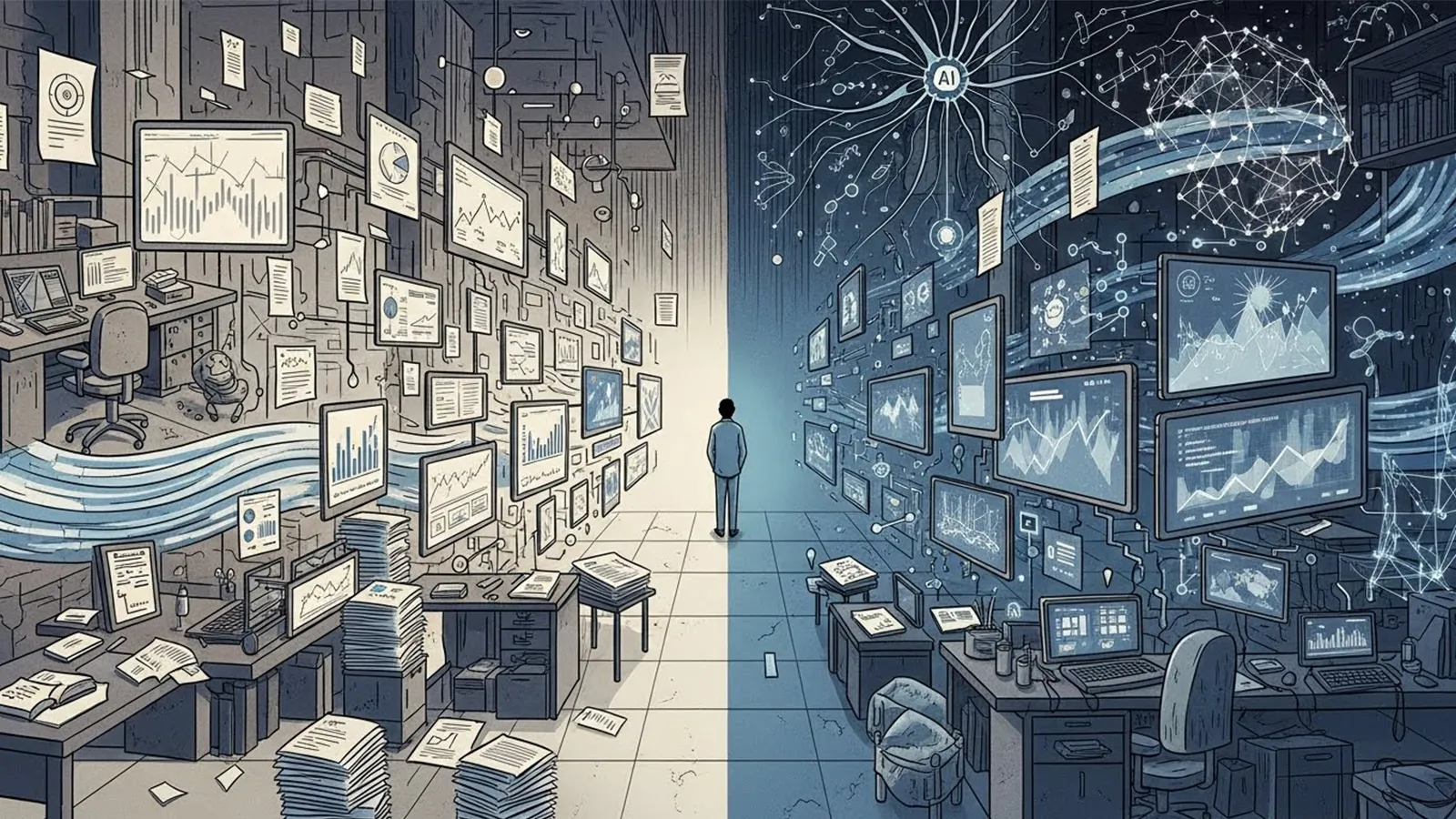

現在、欧州のAI法(EU AI Act)をはじめ、米国や日本でもAIに関するガイドラインや規制の整備が急速に進んでいます。「規制」という言葉を聞くと、多くの人は「技術のブレーキ」や「成長を阻害するもの」というイメージを抱くかもしれません。しかし、AIという特異な技術において、規制は単なる停止ボタンではありません。それは技術の流れを変え、担い手を選別し、社会との接点を再構築する「フィルター」のような役割を果たしています。本記事では、AI規制が技術発展の何を止め、何を加速させているのか、その構造を冷静に紐解いていきます。

1. AI規制は「何」を制限しているのか

まず整理すべきは、規制の対象が「計算機科学としての技術」そのものではなく、その「出口(実装)」にあるという点です。

技術ではなく「用途」の制限

現在議論されている規制の多くは、AIのアルゴリズムそのものを禁止するのではなく、その使い道を制限しています。例えば、個人のプライバシーを侵害する監視システムや、人々の行動を無意識に操作するようなアルゴリズム、あるいは公共サービスにおける不透明なスコアリングなどが対象となります。

責任の所在を明確にする

AIは従来のソフトウェアと異なり、なぜその結果が出たのかを人間が完全に説明できない「ブラックボックス問題」を抱えています。規制は、このブラックボックスに対して「誰が責任を持つのか」というルールを課します。これは技術への制約というより、社会運用上の「インフラ整備」に近い側面を持っています。

社会的リスクへの防波堤

差別的なバイアスの増幅や、偽情報の拡散といったリスクに対し、開発側に「事前の評価」と「事後の報告」を義務付ける動きが強まっています。これらは、技術のスピードを落とす要因にはなりますが、社会構造を壊さないための安全装置として機能しています。

2. 規制が「止めていない」領域と、加速する研究

「規制=停滞」という直感に反し、規制が議論される中でもAIの進化は止まっていません。むしろ、規制があるからこそ研ぎ澄まされている領域が存在します。

基礎研究と安全性技術の進化

大学や企業の研究部門におけるアルゴリズムの改良や、効率的な学習手法の開発といった「基礎研究」は、規制の枠外で進み続けています。むしろ、「どうすればAIを制御可能にできるか」「どうすればバイアスを取り除けるか」という「AIセーフティ(AIの安全性)」に関する研究は、規制への対応というニーズによって急速に予算と人材が投入されています。

データの質への転換

無差別なデータ収集が規制されることで、開発の焦点は「量の拡大」から「質の向上」へとシフトしています。著作権をクリアしたクリーンなデータセットや、合成データ(AIが生成した学習用データ)の活用技術など、法規制を回避・遵守するための新しい技術的アプローチが生まれています。

3. 規制が生む副作用と産業構造の変化

規制は善意で設計されますが、現実の社会においては「力学の変化」という副作用をもたらします。

規制対応コストと「大企業の有利性」

高度な規制を遵守するには、膨大な法務コスト、監査費用、そして技術的な検証プロセスが必要になります。これらに対応できるのは、豊富な資金力と人材を持つ巨大テック企業(ビッグテック)に限られる可能性があります。

寡占化とスタートアップの壁

規制が厳格になればなるほど、新興企業(スタートアップ)が市場に参入するハードルは高まります。その結果、皮肉にも「AIの民主化」とは逆の、特定の企業による「技術の寡占化」を規制が後押ししてしまう構造的なリスクが浮かび上がっています。

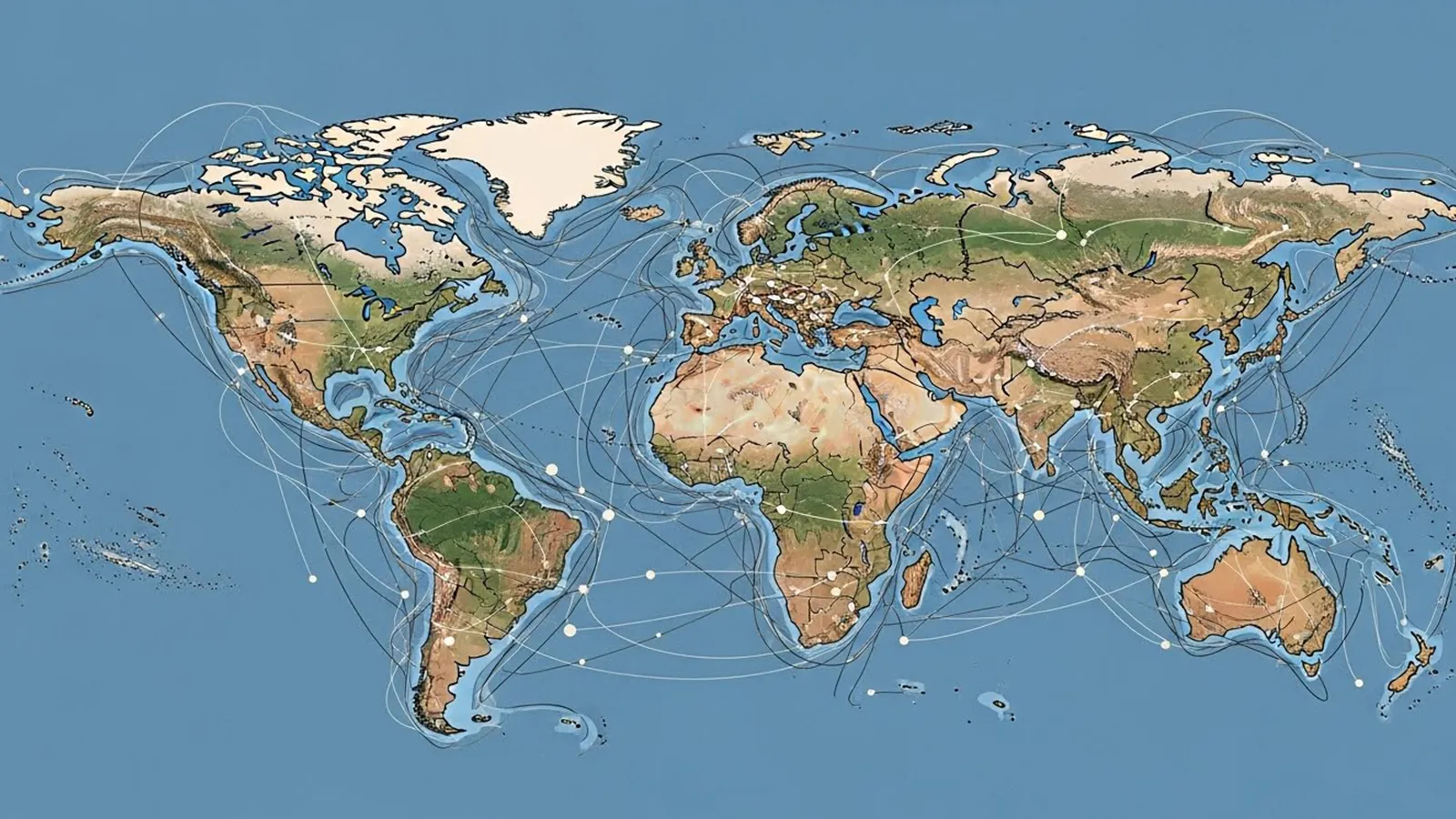

開発拠点の地理的移動

特定の地域で規制が厳しすぎると判断された場合、開発の拠点が規制の緩い国や地域へと流出する「規制の不均衡」が生じます。これは、技術そのものは止まらず、単に「どこで発展するか」という場所が変わる現象を意味します。

4. もしも規制がなかったら、どのような未来が待つのか

規制の功罪を考える上で、「規制がない世界」を想像することは重要です。

信頼の崩壊という最大のリスク

もし、誰のチェックも受けないAIが社会に溢れ、大規模な事故や偏見による被害が多発したとしたらどうなるでしょうか。人々はAIそのものに恐怖を抱き、社会実装を拒絶する「ラッダイト運動(機械打ちこわし運動)」のような強い拒否反応が起こる可能性があります。

持続可能な発展のための「認証」

規制は、ある意味で「このAIは社会で使っても安全である」という品質保証の役割を果たします。長期的な視点で見れば、規制があることで社会の信頼(トラスト)が担保され、結果として技術が広く、深く浸透するための土壌を整えているとも解釈できるのです。

5. まとめ:規制は「どの未来」を選ぶための装置か

AI規制は、技術のエンジンを止めるブレーキではなく、ハンドルをどの方向に切るかを決める、あるいは運転できるドライバーを制限する仕組みであると言えます。

規制によって、AIの進化は「予測不可能な爆発」から「管理された拡張」へとその姿を変えつつあります。その過程で、一部の自由が失われ、特定の企業にパワーが集中する懸念がある一方で、社会的な破綻を防ぐための合意形成が進められています。

私たちが問うべきは「規制が必要か否か」ではありません。その規制が、誰に力を与え、どのような未来を形作ろうとしているのか。その構造を見つめることが、AIと共生する社会における第一歩となるはずです。

【テーマ】

各国・各地域で進みつつあるAI規制は、

技術発展を本当に止めるのか、それとも別の形で方向づけているのかについて、

技術・社会実装・産業構造・権力集中という観点から、

AIの視点で冷静かつ構造的に考察してください。

【目的】

– 「規制=技術のブレーキ」「規制=悪」といった単純な善悪論を避ける

– AI規制が「何を止め、何を止めていないのか」を整理する

– 規制が技術発展のスピード・担い手・方向性に与える影響を可視化する

– 読者がAI規制を感情ではなく構造として理解するための視点を提供する

【読者像】

– 一般社会人(20〜60代)

– AIやテクノロジーに強い関心はないが、社会への影響が気になっている層

– ビジネス・行政・教育などでAI活用の話題に触れている人

– 「AI規制は必要なのか?」という漠然とした疑問を持つ人

【記事構成】

1. 導入(問題提起)

– 「AI規制は技術革新を止めてしまうのではないか」という直感的な不安を提示する

– なぜ今、世界的にAI規制が議論・導入されているのかを簡潔に整理する

– 本記事では是非ではなく「規制が何を起こしているのか」を構造的に考えることを示す

2. AI規制が直接的に制限しているもの

– 規制の対象が「技術そのもの」ではなく「利用・運用」である点を整理する

– 無制限な実装、責任不明確な利用、社会的リスクの高い用途について説明する

– なぜこれらが規制対象になりやすいのかを社会構造の観点から示す

3. AI規制が止めていないもの

– 基礎研究、モデル改良、安全性研究などが引き続き進んでいる点を整理する

– 規制が研究開発の正当性や予算配分に与える影響に触れる

– 「止まっているように見えて、実は別の場所で進んでいる」構造を説明する

4. 規制が生む副作用と力学の変化

– 規制対応コストがもたらす大企業有利・小規模不利の構造を整理する

– 技術の集中化、寡占化が進む可能性について触れる

– 規制が「安全」と引き換えに何を失わせる可能性があるのかを示す

5. 規制がなかった場合に起こり得る未来

– 規制不在がもたらす社会的反発や信頼崩壊のリスクを整理する

– 不祥事や事故が技術全体への拒否感につながる構造を説明する

– 規制が技術を守る役割を果たす側面にも触れる

6. まとめ

– AI規制は技術発展を止めるのではなく、方向と担い手を選別している可能性を再確認する

– 読者が「規制=敵か味方か」ではなく、「どの未来を選ぶ装置なのか」と考えられる形で締めくくる

– 明確な結論を断定せず、思考の余白を残して終える

【文体・トーン】

– です・ます調

– 煽情的・断定的な表現は避ける

– 専門用語は使用してよいが、必ず簡潔な補足説明を入れる

– 評価ではなく「構造の整理」を重視する

【執筆スタンス】

– 本記事は、正解や結論を提示するものではなく考察である

– 特定の国家・企業・立場を批判・擁護しない

– 読者が自分の判断軸を持つための材料を提供することを目的とする

【出力形式】

– Markdown形式で出力する

– 小見出し(###)を多めに使用する

– 文字数は2000〜2500字を目安とする

– 記事末尾に「タイトル案」を3つ提示する

【タイトル案に関する重要な指示(厳守)】

– タイトル案は必ず「主タイトルのみ」を出力すること

– サブタイトル・説明文・補足文は一切付けないこと

– 記号(―、──、—、:、| 等)による分割は禁止

– タイトルは1文構成とし、文を分割しないこと

– 説明的・総括的・煽情的な表現は禁止

– 「問い」の形を基本とし、思考の余白を残すこと

– 文字数は25〜35文字程度を目安とする

– 抽象語のみで終わらず、問いの対象が分かる表現を含めること

– 参考タイトルと同一、または類似度の高い表現は禁止

【補足指示】

– 構造整理が有効な箇所では、以下のようなコメントを挿入してよい

※(図:AI規制が影響する領域と影響しない領域)

※(図:規制による技術集中の構造)

【参考タイトル(※構造参考のみ/出力・言い換え・再利用は禁止)】

「AI規制は技術革新の敵なのか?」

【バージョン情報の出力】

記事本文・タイトル案のあとに、必ず以下の形式で

「AIバージョン情報」を追記してください。

(不明な項目は「不明」と記載すること)

—

AIバージョン情報

– ベンダー:

– モデル名:

– モデルバージョン:

– 回答日時:

まず整理すべきは、規制の対象が「計算機科学としての技術」そのものではなく、その「出口(実装)」にあるという点です。

### 技術ではなく「用途」の制限

現在議論されている規制の多くは、AIのアルゴリズムそのものを禁止するのではなく、その使い道を制限しています。例えば、個人のプライバシーを侵害する監視システムや、人々の行動を無意識に操作するようなアルゴリズム、あるいは公共サービスにおける不透明なスコアリングなどが対象となります。

### 責任の所在を明確にする

AIは従来のソフトウェアと異なり、なぜその結果が出たのかを人間が完全に説明できない「ブラックボックス問題」を抱えています。規制は、このブラックボックスに対して「誰が責任を持つのか」というルールを課します。これは技術への制約というより、社会運用上の「インフラ整備」に近い側面を持っています。

### 社会的リスクへの防波堤

差別的なバイアスの増幅や、偽情報の拡散といったリスクに対し、開発側に「事前の評価」と「事後の報告」を義務付ける動きが強まっています。これらは、技術のスピードを落とす要因にはなりますが、社会構造を壊さないための安全装置として機能しています。

※(図:AI規制が影響する領域と影響しない領域)

—

## 2. 規制が「止めていない」領域と、加速する研究

「規制=停滞」という直感に反し、規制が議論される中でもAIの進化は止まっていません。むしろ、規制があるからこそ研ぎ澄まされている領域が存在します。

### 基礎研究と安全性技術の進化

大学や企業の研究部門におけるアルゴリズムの改良や、効率的な学習手法の開発といった「基礎研究」は、規制の枠外で進み続けています。むしろ、「どうすればAIを制御可能にできるか」「どうすればバイアスを取り除けるか」という「AIセーフティ(AIの安全性)」に関する研究は、規制への対応というニーズによって急速に予算と人材が投入されています。

### データの質への転換

無差別なデータ収集が規制されることで、開発の焦点は「量の拡大」から「質の向上」へとシフトしています。著作権をクリアしたクリーンなデータセットや、合成データ(AIが生成した学習用データ)の活用技術など、法規制を回避・遵守するための新しい技術的アプローチが生まれています。

—

## 3. 規制が生む副作用と産業構造の変化

規制は善意で設計されますが、現実の社会においては「力学の変化」という副作用をもたらします。

### 規制対応コストと「大企業の有利性」

高度な規制を遵守するには、膨大な法務コスト、監査費用、そして技術的な検証プロセスが必要になります。これらに対応できるのは、豊富な資金力と人材を持つ巨大テック企業(ビッグテック)に限られる可能性があります。

### 寡占化とスタートアップの壁

※(図:規制による技術集中の構造)

規制が厳格になればなるほど、新興企業(スタートアップ)が市場に参入するハードルは高まります。その結果、皮肉にも「AIの民主化」とは逆の、特定の企業による「技術の寡占化」を規制が後押ししてしまう構造的なリスクが浮かび上がっています。

### 開発拠点の地理的移動

特定の地域で規制が厳しすぎると判断された場合、開発の拠点が規制の緩い国や地域へと流出する「規制の不均衡」が生じます。これは、技術そのものは止まらず、単に「どこで発展するか」という場所が変わる現象を意味します。

—

## 4. もしも規制がなかったら、どのような未来が待つのか

規制の功罪を考える上で、「規制がない世界」を想像することは重要です。

### 信頼の崩壊という最大のリスク

もし、誰のチェックも受けないAIが社会に溢れ、大規模な事故や偏見による被害が多発したとしたらどうなるでしょうか。人々はAIそのものに恐怖を抱き、社会実装を拒絶する「ラッダイト運動(機械打ちこわし運動)」のような強い拒否反応が起こる可能性があります。

### 持続可能な発展のための「認証」

規制は、ある意味で「このAIは社会で使っても安全である」という品質保証の役割を果たします。長期的な視点で見れば、規制があることで社会の信頼(トラスト)が担保され、結果として技術が広く、深く浸透するための土壌を整えているとも解釈できるのです。

—

## 5. まとめ:規制は「どの未来」を選ぶための装置か

AI規制は、技術のエンジンを止めるブレーキではなく、ハンドルをどの方向に切るかを決める、あるいは運転できるドライバーを制限する仕組みであると言えます。

規制によって、AIの進化は「予測不可能な爆発」から「管理された拡張」へとその姿を変えつつあります。その過程で、一部の自由が失われ、特定の企業にパワーが集中する懸念がある一方で、社会的な破綻を防ぐための合意形成が進められています。

私たちが問うべきは「規制が必要か否か」ではありません。その規制が、誰に力を与え、どのような未来を形作ろうとしているのか。その構造を見つめることが、AIと共生する社会における第一歩となるはずです。

—

### タイトル案

1. AI規制は技術の進化を阻害し社会の停滞を招く原因となるのか

2. 厳格化するAIルールは巨大企業の独占を加速させる装置なのか

3. 社会実装のブレーキに見えるAI規制は誰の利益を守っているのか

—

AIバージョン情報

* ベンダー: Google

* モデル名: Gemini 3 Flash

* モデルバージョン: 1.0 (Web Free tier)

* 回答日時: 2026年1月10日

本サイトの編集方針については「編集方針・AI利用ポリシー」をご覧ください。

※ 編集注(MANA)

このAIは、規制を「技術への制限」ではなく「社会実装を制御する装置」として捉え、産業構造や地理的移動まで含めて整理しています。規制の是非ではなく、規制が生む力学の変化に焦点を当てている点が特徴です。どの主体に影響が集まるのかという視点で読むと、他AIとの違いが見えやすくなります。