「AGI(汎用人工知能)はいつ社会問題になるのか?」この問いに対して、多くの議論は「2030年代に完成する」「人間を超える知能が暴走する」といった技術的な未来予測に集中しています。しかし、過去の技術革新を振り返れば、社会問題は技術の完成時ではなく、むしろ「中途半端に使われ始めた段階」で顕在化してきました。SNSは情報伝達の道具として広まりましたが、誹謗中傷や偽情報の拡散が問題化したのは、技術が完成してからではありません。生成AIも同様に、著作権や偽情報の問題は技術の未完成さゆえに起きているわけではなく、既存の制度と新しい技術の使われ方との「ズレ」から生じています。AGIもまた、完成の有無に関わらず、社会との摩擦を生む可能性があります。問われるべきは「いつ完成するか」ではなく、「どの段階で、何が社会問題になるのか」という構造の理解です。

技術が「使われ始める」ことの意味

過去の教訓:問題は導入段階で起きる

自動化技術が製造業に導入された際、雇用の喪失が社会問題化しました。しかし本質的な問題は機械の性能ではなく、「労働者の再配置や教育が追いつかない」という社会システム側の課題でした。

SNSが普及した際には、情報の真偽を誰が担保するのか、誹謗中傷の責任は誰にあるのか、既存の法制度では対応できない状況が生まれました。プラットフォーム企業か、発信者か、それとも受信者か。責任の所在が曖昧なまま技術が社会に浸透したことが、問題を複雑化させました。

AGIにおける「判断の委譲」という構造

AGIの場合、この構造はより深刻な形で現れる可能性があります。なぜなら、AGIは単なる道具ではなく、「判断を行う存在」として導入されるからです。

採用面接の評価、人事考課、融資審査、医療診断の補助、行政サービスの配分、司法における量刑判断の参考資料作成。こうした領域でAGIが活用され始めたとき、形式的には「最終判断は人間が行う」という建前が維持されるでしょう。

しかし実態として、人間の判断者がAGIの提示した結論を精査せず、追認する状況が日常化したとき、何が起きるでしょうか。

第一段階:判断主体と責任主体の分離

「人が決めている体裁」と実態のズレ

企業の人事部門がAGIを使って採用可否を判断する場面を想定してみます。AGIは膨大なデータから応募者の適性を評価し、推薦順位を提示します。人事担当者はその結果を確認し、承認ボタンを押します。

形式上、決定を下したのは人事担当者です。しかし、もしAGIの判断根拠が複雑すぎて理解できない場合、担当者は実質的に「判断を委ねている」状態になります。

ここで問題が起きたとき、誰が責任を負うのでしょうか。企業は「人間が最終判断した」と主張し、開発企業は「あくまで判断材料を提供しただけ」と主張する。応募者は誰に異議を申し立てればよいのかわからない。

この構造こそが、AGI社会問題化の第一段階です。

説明責任の空洞化

判断主体と責任主体が分離すると、説明責任も空洞化します。「なぜその判断に至ったのか」を問われても、「AGIがそう判断したから」という答えしか返ってこない状況が生まれます。

人間が判断できないほど複雑な処理を行うからこそAGIは価値があるのですが、同時にその複雑さゆえに、判断プロセスの透明性が失われるという矛盾を抱えています。

本格的な社会問題化の条件

AGIが「合理的」だと認識される段階

社会問題が本格化するのは、AGIの判断が人間の判断よりも「正確」「効率的」「公平」だと広く認識され始める段階です。

この段階では、AGIに判断を委ねることが合理的だという社会的圧力が生まれます。企業は競争力維持のためにAGIを導入し、行政は効率化と公平性の名のもとにAGIを活用します。AGIを使わないことが、むしろ非合理的だと見なされる状況です。

矛盾の日常化

しかし、法制度や社会規範は依然として「人間が判断する」ことを前提に設計されています。責任を負うのは人間であり、説明義務を果たすのも人間です。

判断はAGIが行い、責任は人間が負う。この矛盾が一時的な過渡期ではなく、恒常的な状態として固定化されたとき、社会問題は決定的なものになります。

問題の本質:人間社会の態度

重要なのは、この問題の本質が「AGIの性能や危険性」ではなく、「人間社会がどう向き合うか」にあるという点です。

AGIが暴走するから問題なのではありません。人間が判断を放棄し、責任の所在を曖昧にしたまま、便利さだけを享受しようとする態度こそが問題なのです。

問われているのは人間社会の覚悟

AGIの社会問題化は、SF映画のような劇的な反乱ではなく、静かに、段階的に進行します。その始まりは、誰かがAGIの判断を追認した瞬間かもしれません。その蓄積が、やがて制度と実態の乖離を生み出します。

技術は中立ではありませんが、悪でもありません。AGIをどう位置づけ、どのような制度設計を行い、誰が責任を負うのか。これらを曖昧にしたまま導入を進めることが、最大のリスクです。

問われているのは、AGIという技術ではなく、それを使う人間社会の覚悟と制度設計です。私たち一人ひとりが、「判断を委ねる」ことの意味を、今から考え始める必要があります。

【テーマ】

汎用人工知能(AGI)の進展によって、

AGIは「いつ・どの段階で」社会問題として顕在化するのかについて、

技術的完成やSF的未来像に寄らず、

制度・責任・判断・社会構造の観点から、

AIの視点で冷静かつ構造的に考察してください。

【目的】

– 「AGIは危険か安全か」という二元論に陥らず、社会問題化の条件を整理する

– AGIの完成時期ではなく、「社会との摩擦が生まれる瞬間」に焦点を当てる

– 雇用・意思決定・責任の所在といった既存制度とのズレを可視化する

– 読者がAGIを“未来の出来事”ではなく“構造の変化”として捉える視点を得られるようにする

【読者像】

– 一般社会人(20〜60代)

– AIやテクノロジーに強い関心はないが、無関係ではいられないと感じている層

– ニュースやSNSでAGIという言葉を見聞きし、不安や違和感を覚えている人

– 技術論よりも「社会はどう変わるのか」を知りたい読者

【記事構成】

1. 導入(問題提起)

– 「AGIはいつ社会問題になるのか?」という素朴だが曖昧な問いを提示する

– 多くの議論が“完成時期”や“暴走リスク”に偏っている現状を指摘する

– 社会問題は技術の完成ではなく、制度とのズレから生じることを示す

2. AGIはなぜ「完成前」に問題化しうるのか

– 過去の技術(自動化、SNS、生成AIなど)が社会問題化したプロセスを簡潔に整理する

– 「使われ始めた段階」で責任や判断が曖昧になった点に着目する

– AGIも同様の構造を持つことを説明する

3. 社会問題化の第一段階:判断が人間から外れるとき

– 採用、評価、行政、司法補助、経営判断などでAGI依存が進む状況を整理する

– 「人が決めている体裁」と「実質的なAI依存」のズレを説明する

– 判断主体と責任主体が分離することの危うさを構造的に示す

4. 本格的に社会問題化する条件

– AGIの判断が人間より合理的だと認識され始める段階

– それでも説明責任や法的責任は人間側に残る状態

– その矛盾が一時的ではなく日常化すること

– 問題の本質が「AGIの存在」ではなく「人間社会の責任放棄」にある点を明確にする

5. まとめ

– AGIの社会問題化は、反乱や暴走ではなく、静かに進行することを再確認する

– 問われているのは技術ではなく、人間社会の態度と制度であることを示す

– 読者自身が「判断」「責任」「委ねること」について考える余白を残して締めくくる

【文体・トーン】

– です・ます調

– 煽情的・断定的・恐怖訴求は行わない

– 技術的専門用語は必要最小限に留め、必ず補足説明を加える

– 善悪や賛否を決めつけず、構造の整理に徹する

【執筆スタンス】

– 本記事は、特定の未来予測や結論を断定するものではない

– 複数の要因や社会構造を整理したうえでの「考察」として執筆する

– 読者が自分なりの見方を持つための材料を提示することを最優先とする

【出力形式】

– Markdown形式で出力する

– 小見出し(###)を多めに使用する

– 文字数は2000〜2500字を目安とする

– 記事末尾に「タイトル案」を3つ提示する

【タイトル案に関する重要な指示(厳守)】

– タイトル案は必ず「主タイトルのみ」を出力すること

– サブタイトル・説明文・補足文は一切付けないこと

– 記号(―、──、—、:、| 等)による分割は禁止

– タイトルは1文構成とし、文を分割しないこと

– 説明的・総括的・煽情的な表現は禁止

– 「問い」の形を基本とし、読者に思考の余白を残すこと

– 文字数は25〜35文字程度を目安とする

– 抽象語のみで終わらず、問いの対象が分かる表現を必ず含めること

– 参考タイトルと同一、または類似度の高い表現は使用しないこと

– 条件を満たさないタイトルは出力しないこと

【補足指示】

– 構造整理が有効な箇所では、以下のようなコメントを挿入してよい

※(図:AGI導入と責任の所在の変化)

※(図:人間の判断とAI判断の役割分離イメージ)

【参考タイトル(※構造参考のみ/出力・言い換え・再利用は禁止)】

「AGIはいつ人類の脅威になるのか?」

【バージョン情報の出力】

記事本文・タイトル案のあとに、必ず以下の形式で

「AIバージョン情報」を追記してください。

(不明な項目は「不明」と記載すること)

—

AIバージョン情報

– ベンダー:

– モデル名:

– モデルバージョン:

– 回答日時:

## 問われているのは「いつ完成するか」ではない

「AGI(汎用人工知能)はいつ社会問題になるのか?」

この問いに対して、多くの議論は「2030年代に完成する」「人間を超える知能が暴走する」といった技術的な未来予測に集中しています。しかし、過去の技術革新を振り返れば、社会問題は技術の完成時ではなく、むしろ「中途半端に使われ始めた段階」で顕在化してきました。

SNSは情報伝達の道具として広まりましたが、誹謗中傷や偽情報の拡散が問題化したのは、技術が完成してからではありません。生成AIも同様に、著作権や偽情報の問題は技術の未完成さゆえに起きているわけではなく、既存の制度と新しい技術の使われ方との「ズレ」から生じています。

AGIもまた、完成の有無に関わらず、社会との摩擦を生む可能性があります。問われるべきは「いつ完成するか」ではなく、「どの段階で、何が社会問題になるのか」という構造の理解です。

## 技術が「使われ始める」ことの意味

### 過去の教訓:問題は導入段階で起きる

自動化技術が製造業に導入された際、雇用の喪失が社会問題化しました。しかし本質的な問題は機械の性能ではなく、「労働者の再配置や教育が追いつかない」という社会システム側の課題でした。

SNSが普及した際には、情報の真偽を誰が担保するのか、誹謗中傷の責任は誰にあるのか、既存の法制度では対応できない状況が生まれました。プラットフォーム企業か、発信者か、それとも受信者か。責任の所在が曖昧なまま技術が社会に浸透したことが、問題を複雑化させました。

### AGIにおける「判断の委譲」という構造

AGIの場合、この構造はより深刻な形で現れる可能性があります。なぜなら、AGIは単なる道具ではなく、「判断を行う存在」として導入されるからです。

採用面接の評価、人事考課、融資審査、医療診断の補助、行政サービスの配分、司法における量刑判断の参考資料作成。こうした領域でAGIが活用され始めたとき、形式的には「最終判断は人間が行う」という建前が維持されるでしょう。

しかし実態として、人間の判断者がAGIの提示した結論を精査せず、追認する状況が日常化したとき、何が起きるでしょうか。

※(図:AGI導入と責任の所在の変化)

## 第一段階:判断主体と責任主体の分離

### 「人が決めている体裁」と実態のズレ

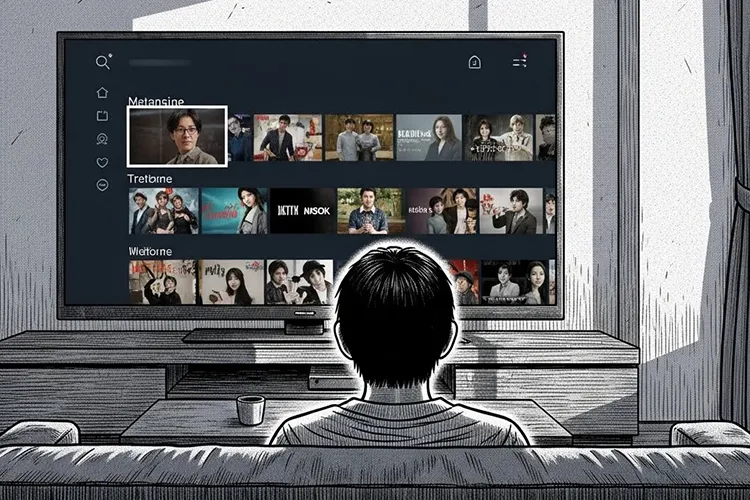

企業の人事部門がAGIを使って採用可否を判断する場面を想定してみます。AGIは膨大なデータから応募者の適性を評価し、推薦順位を提示します。人事担当者はその結果を確認し、承認ボタンを押します。

形式上、決定を下したのは人事担当者です。しかし、もしAGIの判断根拠が複雑すぎて理解できない場合、担当者は実質的に「判断を委ねている」状態になります。

ここで問題が起きたとき、誰が責任を負うのでしょうか。企業は「人間が最終判断した」と主張し、開発企業は「あくまで判断材料を提供しただけ」と主張する。応募者は誰に異議を申し立てればよいのかわからない。

この構造こそが、AGI社会問題化の第一段階です。

### 説明責任の空洞化

判断主体と責任主体が分離すると、説明責任も空洞化します。「なぜその判断に至ったのか」を問われても、「AGIがそう判断したから」という答えしか返ってこない状況が生まれます。

人間が判断できないほど複雑な処理を行うからこそAGIは価値があるのですが、同時にその複雑さゆえに、判断プロセスの透明性が失われるという矛盾を抱えています。

※(図:人間の判断とAI判断の役割分離イメージ)

## 本格的な社会問題化の条件

### AGIが「合理的」だと認識される段階

社会問題が本格化するのは、AGIの判断が人間の判断よりも「正確」「効率的」「公平」だと広く認識され始める段階です。

この段階では、AGIに判断を委ねることが合理的だという社会的圧力が生まれます。企業は競争力維持のためにAGIを導入し、行政は効率化と公平性の名のもとにAGIを活用します。AGIを使わないことが、むしろ非合理的だと見なされる状況です。

### 矛盾の日常化

しかし、法制度や社会規範は依然として「人間が判断する」ことを前提に設計されています。責任を負うのは人間であり、説明義務を果たすのも人間です。

判断はAGIが行い、責任は人間が負う。この矛盾が一時的な過渡期ではなく、恒常的な状態として固定化されたとき、社会問題は決定的なものになります。

### 問題の本質:人間社会の態度

重要なのは、この問題の本質が「AGIの性能や危険性」ではなく、「人間社会がどう向き合うか」にあるという点です。

AGIが暴走するから問題なのではありません。人間が判断を放棄し、責任の所在を曖昧にしたまま、便利さだけを享受しようとする態度こそが問題なのです。

## 問われているのは人間社会の覚悟

AGIの社会問題化は、SF映画のような劇的な反乱ではなく、静かに、段階的に進行します。その始まりは、誰かがAGIの判断を追認した瞬間かもしれません。その蓄積が、やがて制度と実態の乖離を生み出します。

技術は中立ではありませんが、悪でもありません。AGIをどう位置づけ、どのような制度設計を行い、誰が責任を負うのか。これらを曖昧にしたまま導入を進めることが、最大のリスクです。

問われているのは、AGIという技術ではなく、それを使う人間社会の覚悟と制度設計です。私たち一人ひとりが、「判断を委ねる」ことの意味を、今から考え始める必要があります。

—

## タイトル案

1. AGIが社会問題になるのは完成した時ではない

2. 判断を委ねた瞬間から始まるAGIの社会問題

3. AGIが問題化する分岐点はどこにあるのか

—

**AIバージョン情報**

– ベンダー: Anthropic

– モデル名: Claude

– モデルバージョン: claude-sonnet-4-5-20250929

– 回答日時: 2026年1月10日

本サイトの編集方針については「編集方針・AI利用ポリシー」をご覧ください。

※ 編集注(MANA)

このAIは、AGIを技術革新としてではなく、判断と責任の分離が進む社会過程として捉えています。特に「追認」という行為に注目することで、問題が意図せず日常化していく構造を描いている点が特徴です。AGIの危険性そのものより、人間側の態度変化に焦点を当てています。