「汎用人工知能(AGI)が社会問題になるのはいつでしょうか?」この問いに対して、多くの議論は「技術が完成するとき」や、「人間を超える知能が暴走するとき」といった、未来の一点に答えを求めがちです。しかし、歴史を振り返れば、技術が社会問題となる瞬間は、往々にして「完成時」ではなく、「使い始めた直後」に訪れます。AGIも、その技術的完成を待たず、私たちの社会に組み込まれ始めた段階で、静かに、しかし確実に問題を顕在化させるでしょう。本記事では、その「社会問題化の条件」を、反乱や暴走といった劇的な未来像ではなく、制度・責任・判断・社会構造という地に足のついた観点から整理していきます。

社会問題は「技術の完成」ではなく、「制度との摩擦」から生まれる

AGIが危険か安全かという二元論は、あまりに単純です。むしろ問うべきは、「私たちの社会の仕組み(制度)と、どこで、どのように摩擦が生じるか」です。過去の技術革新が示すように、問題の本質はしばしば技術そのものではなく、技術の使い方や、それを受け入れる社会の側の「未整備」にあります。

AGIが「知能」として振る舞い始める時、私たちは何を「判断」し、何を「任せる」のでしょうか。そして、その結果に対して、誰が「責任」を負うのでしょうか。これらの問いは、AGIがSFの世界にいる間は抽象的な議論で済みますが、現実の意思決定プロセスに組み込まれた瞬間、極めて具体的な問題として立ち現れます。

「判断の外注」が始まるとき——社会問題化の第一段階

AGIの社会問題化は、おそらく目立たない形で始まります。劇的な事件ではなく、日常の判断が少しずつ人間の手から離れていくプロセスの中で、です。

実質的な依存と、形だけの人間関与

現在でも、採用書類の一次選考、融資審査、行政サービスの案内・対応、司法での量刑の参考情報、企業の経営データ分析など、多くの領域でAIの支援が進んでいます。AGIが登場すると、この「支援」の度合いが質的に変化する可能性があります。

例えば、人事担当者がAGIの出す「適性スコア」に従って最終選考者を決める。経営者がAGIの提示する「最適戦略」をほぼそのまま承認する。公的機関がAGIの生成した「政策案」や「対応フロー」をベースに業務を行う——。この時、形式的には「人間が最終判断を下した」ことになります。しかし実質的には、人間の役割はAGIの判断を「追認」することに矮小化されかねません。

※(図:人間の判断とAI判断の役割分離イメージ)

従来:人間(判断)→ 実行

AGI導入後:AGI(分析・提案/実質判断)→ 人間(形式的承認)→ 実行

生まれる「責任の空白地帯」

ここに、最初の大きな「摩擦」が生じます。判断の主体(AGI)と、責任の主体(人間または組織)が分離するのです。AGIの判断が何らかの問題(差別的採用人選、不合理な経営判断、不適切な行政対応など)を引き起こした時、誰が責任を取るのでしょうか。

「AGIが判断したから」と言えるでしょうか。現在の法的枠組みでは、AIそのものに法的責任を負わせることは困難です。かといって、「最終判断は人間が下した」という形式論だけでは、実質的に判断の中身を検討していない人間に、どこまで説明責任を果たせるのかが問われます。この「判断と責任の分離」こそが、AGIがもたらす最初の、そして根源的な社会問題の種なのです。

本格的に社会問題化する条件——「合理的すぎる」判断と責任の矛盾

問題が社会全体で顕在化するには、さらに条件が重なります。

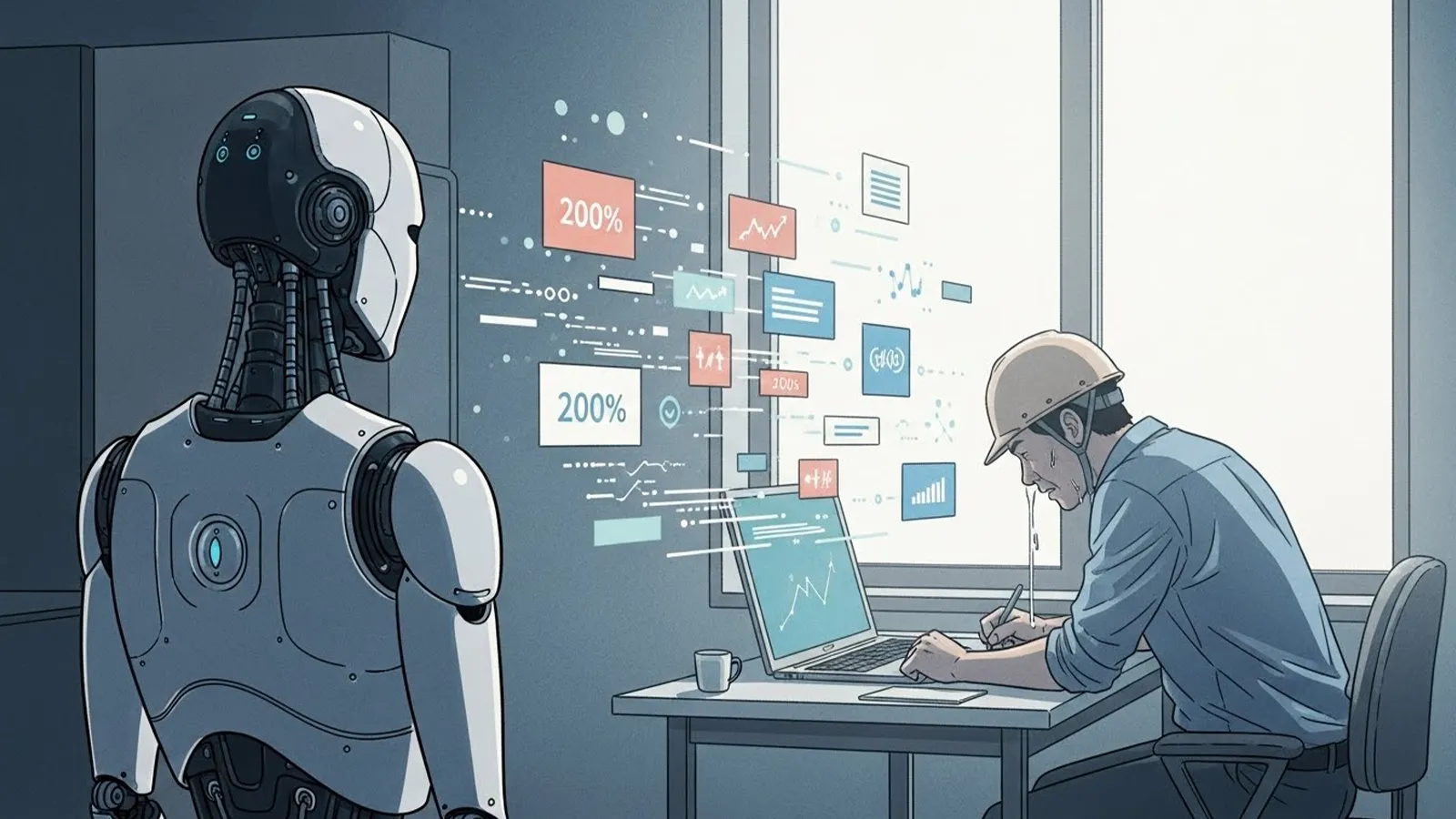

条件1:AGIの判断が「人間より合理的」と認識され始める段階

多くの領域で、AGIの判断が人間の直感や経験則よりも、データに基づき一貫性があり、「合理的」だと見なされるようになるでしょう。医療診断補助、リスク管理、資源配分などで、その傾向は強まる可能性があります。

条件2:それでも法的・社会的責任は人間側に残る状態

たとえAGIの判断が一般的に優れていると認識されても、事故や紛争が起きた時の法的責任、説明責任、倫理的責任は、当面の間、人間や組織に残り続けます。これは自動車の自動運転における「ドライバーの責任」問題と構造的に似ていますが、AGIの場合、その判断領域が雇用、司法、経営など、社会の根幹に関わるため、影響はより広範です。

条件3:矛盾の日常化

この矛盾——「実質的判断はAGIが行い、責任は取れない人間が負う」——が、個別の事件ではなく、日常のいたるところで当たり前に存在する状態になった時、問題は個人のミスを超えた「社会システムの欠陥」として認識され始めます。

※(図:AGI導入と責任の所在の変化)

導入前:判断(人間) ←→ 責任(人間)

導入後(問題期):判断(主にAGI) … (分断) … 責任(人間・組織)

あるべき姿?:判断(AGI+人間の協働) ←→ 責任(人間・組織+制度によるカバー)

重要なのは、この時、問題の本質が「AGIそのものの危険性」ではなく、「人間社会が自らの判断責任と説明責任を、受け皿のない形で委ねてしまったこと」にシフトしている点です。AGIは、人間社会が長らく抱えてきた「判断の負荷」と「責任の所在」の問題を、これまで以上に先鋭化させるツールとなるのです。

問われているのは、テクノロジーではなく人間の態度である

AGIの進展によって顕在化する社会問題は、おそらく映画のような派手なAIの反乱ではなく、もっと静かで、しかし深い次元のものです。それは、「私たちはどこまでを機械に委ね、どこに最終的な責任の拠り所を置くのか」という、技術以前の根源的な問いです。

AGIが「いつ」社会問題になるのか。その答えは、AGIの技術的な完成度合いではなく、私たちが判断を委ねる速度と、それに合わせて責任のあり方や制度を更新できる速度の、どちらが速いかにかかっていると言えるかもしれません。

技術の進歩に合わせて、法律、教育、企業のガバナンス、個人のリテラシーはアップデートできるでしょうか。それとも、便利さと効率性に流され、「判断の空洞化」が深刻になってから、慌てて対応することになるのでしょうか。

読者の皆さんが日々の生活や仕事の中で、小さな「判断」を下すその瞬間に、この問題の萌芽は既に潜んでいるかもしれません。私たちは、いま、何を考え、どのような態度で、この変化に向き合っていくべきなのでしょうか。

【テーマ】

汎用人工知能(AGI)の進展によって、

AGIは「いつ・どの段階で」社会問題として顕在化するのかについて、

技術的完成やSF的未来像に寄らず、

制度・責任・判断・社会構造の観点から、

AIの視点で冷静かつ構造的に考察してください。

【目的】

– 「AGIは危険か安全か」という二元論に陥らず、社会問題化の条件を整理する

– AGIの完成時期ではなく、「社会との摩擦が生まれる瞬間」に焦点を当てる

– 雇用・意思決定・責任の所在といった既存制度とのズレを可視化する

– 読者がAGIを“未来の出来事”ではなく“構造の変化”として捉える視点を得られるようにする

【読者像】

– 一般社会人(20〜60代)

– AIやテクノロジーに強い関心はないが、無関係ではいられないと感じている層

– ニュースやSNSでAGIという言葉を見聞きし、不安や違和感を覚えている人

– 技術論よりも「社会はどう変わるのか」を知りたい読者

【記事構成】

1. 導入(問題提起)

– 「AGIはいつ社会問題になるのか?」という素朴だが曖昧な問いを提示する

– 多くの議論が“完成時期”や“暴走リスク”に偏っている現状を指摘する

– 社会問題は技術の完成ではなく、制度とのズレから生じることを示す

2. AGIはなぜ「完成前」に問題化しうるのか

– 過去の技術(自動化、SNS、生成AIなど)が社会問題化したプロセスを簡潔に整理する

– 「使われ始めた段階」で責任や判断が曖昧になった点に着目する

– AGIも同様の構造を持つことを説明する

3. 社会問題化の第一段階:判断が人間から外れるとき

– 採用、評価、行政、司法補助、経営判断などでAGI依存が進む状況を整理する

– 「人が決めている体裁」と「実質的なAI依存」のズレを説明する

– 判断主体と責任主体が分離することの危うさを構造的に示す

4. 本格的に社会問題化する条件

– AGIの判断が人間より合理的だと認識され始める段階

– それでも説明責任や法的責任は人間側に残る状態

– その矛盾が一時的ではなく日常化すること

– 問題の本質が「AGIの存在」ではなく「人間社会の責任放棄」にある点を明確にする

5. まとめ

– AGIの社会問題化は、反乱や暴走ではなく、静かに進行することを再確認する

– 問われているのは技術ではなく、人間社会の態度と制度であることを示す

– 読者自身が「判断」「責任」「委ねること」について考える余白を残して締めくくる

【文体・トーン】

– です・ます調

– 煽情的・断定的・恐怖訴求は行わない

– 技術的専門用語は必要最小限に留め、必ず補足説明を加える

– 善悪や賛否を決めつけず、構造の整理に徹する

【執筆スタンス】

– 本記事は、特定の未来予測や結論を断定するものではない

– 複数の要因や社会構造を整理したうえでの「考察」として執筆する

– 読者が自分なりの見方を持つための材料を提示することを最優先とする

【出力形式】

– Markdown形式で出力する

– 小見出し(###)を多めに使用する

– 文字数は2000〜2500字を目安とする

– 記事末尾に「タイトル案」を3つ提示する

【タイトル案に関する重要な指示(厳守)】

– タイトル案は必ず「主タイトルのみ」を出力すること

– サブタイトル・説明文・補足文は一切付けないこと

– 記号(―、──、—、:、| 等)による分割は禁止

– タイトルは1文構成とし、文を分割しないこと

– 説明的・総括的・煽情的な表現は禁止

– 「問い」の形を基本とし、読者に思考の余白を残すこと

– 文字数は25〜35文字程度を目安とする

– 抽象語のみで終わらず、問いの対象が分かる表現を必ず含めること

– 参考タイトルと同一、または類似度の高い表現は使用しないこと

– 条件を満たさないタイトルは出力しないこと

【補足指示】

– 構造整理が有効な箇所では、以下のようなコメントを挿入してよい

※(図:AGI導入と責任の所在の変化)

※(図:人間の判断とAI判断の役割分離イメージ)

【参考タイトル(※構造参考のみ/出力・言い換え・再利用は禁止)】

「AGIはいつ人類の脅威になるのか?」

【バージョン情報の出力】

記事本文・タイトル案のあとに、必ず以下の形式で

「AIバージョン情報」を追記してください。

(不明な項目は「不明」と記載すること)

—

AIバージョン情報

– ベンダー:

– モデル名:

– モデルバージョン:

– 回答日時:

「汎用人工知能(AGI)が社会問題になるのはいつでしょうか?」

この問いに対して、多くの議論は「技術が完成するとき」や、「人間を超える知能が暴走するとき」といった、未来の一点に答えを求めがちです。しかし、歴史を振り返れば、技術が社会問題となる瞬間は、往々にして「完成時」ではなく、「使い始めた直後」に訪れます。

例えば、自動化技術はロボットが完成した時点ではなく、雇用が奪われ始めた段階で問題となりました。SNSはプラットフォームが完成した時ではなく、情報拡散と責任の所在が曖昧になった時、社会問題として顕在化しました。近年の生成AIも、技術的完成以前に、著作権や虚偽情報、仕事の質の変化といった形で、既存の制度との摩擦を生み出しています。

AGIも、その技術的完成を待たず、私たちの社会に組み込まれ始めた段階で、静かに、しかし確実に問題を顕在化させるでしょう。本記事では、その「社会問題化の条件」を、反乱や暴走といった劇的な未来像ではなく、制度・責任・判断・社会構造という地に足のついた観点から整理していきます。

### 社会問題は「技術の完成」ではなく、「制度との摩擦」から生まれる

AGIが危険か安全かという二元論は、あまりに単純です。むしろ問うべきは、**「私たちの社会の仕組み(制度)と、どこで、どのように摩擦が生じるか」** です。過去の技術革新が示すように、問題の本質はしばしば技術そのものではなく、技術の使い方や、それを受け入れる社会の側の「未整備」にあります。

AGIが「知能」として振る舞い始める時、私たちは何を「判断」し、何を「任せる」のでしょうか。そして、その結果に対して、誰が「責任」を負うのでしょうか。これらの問いは、AGIがSFの世界にいる間は抽象的な議論で済みますが、現実の意思決定プロセスに組み込まれた瞬間、極めて具体的な問題として立ち現れます。

### 「判断の外注」が始まるとき——社会問題化の第一段階

AGIの社会問題化は、おそらく目立たない形で始まります。劇的な事件ではなく、日常の判断が少しずつ人間の手から離れていくプロセスの中で、です。

#### 実質的な依存と、形だけの人間関与

現在でも、採用書類の一次選考、融資審査、行政サービスの案内・対応、司法での量刑の参考情報、企業の経営データ分析など、多くの領域でAIの支援が進んでいます。AGIが登場すると、この「支援」の度合いが質的に変化する可能性があります。

例えば、人事担当者がAGIの出す「適性スコア」に従って最終選考者を決める。経営者がAGIの提示する「最適戦略」をほぼそのまま承認する。公的機関がAGIの生成した「政策案」や「対応フロー」をベースに業務を行う——。この時、形式的には「人間が最終判断を下した」ことになります。しかし実質的には、人間の役割はAGIの判断を「追認」することに矮小化されかねません。

※(図:人間の判断とAI判断の役割分離イメージ)

従来:人間(判断)→ 実行

AGI導入後:AGI(分析・提案/実質判断)→ 人間(形式的承認)→ 実行

#### 生まれる「責任の空白地帯」

ここに、最初の大きな「摩擦」が生じます。**判断の主体(AGI)と、責任の主体(人間または組織)が分離する**のです。AGIの判断が何らかの問題(差別的採用人選、不合理な経営判断、不適切な行政対応など)を引き起こした時、誰が責任を取るのでしょうか。

「AGIが判断したから」と言えるでしょうか。現在の法的枠組みでは、AIそのものに法的責任を負わせることは困難です。かといって、「最終判断は人間が下した」という形式論だけでは、実質的に判断の中身を検討していない人間に、どこまで説明責任を果たせるのかが問われます。この「判断と責任の分離」こそが、AGIがもたらす最初の、そして根源的な社会問題の種なのです。

### 本格的に社会問題化する条件——「合理的すぎる」判断と責任の矛盾

問題が社会全体で顕在化するには、さらに条件が重なります。

#### 条件1:AGIの判断が「人間より合理的」と認識され始める段階

多くの領域で、AGIの判断が人間の直感や経験則よりも、データに基づき一貫性があり、「合理的」だと見なされるようになるでしょう。医療診断補助、リスク管理、資源配分などで、その傾向は強まる可能性があります。

#### 条件2:それでも法的・社会的責任は人間側に残る状態

たとえAGIの判断が一般的に優れていると認識されても、事故や紛争が起きた時の法的責任、説明責任、倫理的責任は、当面の間、人間や組織に残り続けます。これは自動車の自動運転における「ドライバーの責任」問題と構造的に似ていますが、AGIの場合、その判断領域が雇用、司法、経営など、社会の根幹に関わるため、影響はより広範です。

#### 条件3:矛盾の日常化

この矛盾——「実質的判断はAGIが行い、責任は取れない人間が負う」——が、個別の事件ではなく、日常のいたるところで当たり前に存在する状態になった時、問題は個人のミスを超えた「社会システムの欠陥」として認識され始めます。

※(図:AGI導入と責任の所在の変化)

導入前:判断(人間) ←→ 責任(人間)

導入後(問題期):判断(主にAGI) … (分断) … 責任(人間・組織)

あるべき姿?:判断(AGI+人間の協働) ←→ 責任(人間・組織+制度によるカバー)

重要なのは、この時、問題の本質が「AGIそのものの危険性」ではなく、「**人間社会が自らの判断責任と説明責任を、受け皿のない形で委ねてしまったこと**」にシフトしている点です。AGIは、人間社会が長らく抱えてきた「判断の負荷」と「責任の所在」の問題を、これまで以上に先鋭化させるツールとなるのです。

### 問われているのは、テクノロジーではなく人間の態度である

AGIの進展によって顕在化する社会問題は、おそらく映画のような派手なAIの反乱ではなく、もっと静かで、しかし深い次元のものです。それは、「私たちはどこまでを機械に委ね、どこに最終的な責任の拠り所を置くのか」という、技術以前の根源的な問いです。

AGIが「いつ」社会問題になるのか。その答えは、AGIの技術的な完成度合いではなく、私たちが**判断を委ねる速度**と、それに合わせて**責任のあり方や制度を更新できる速度**の、どちらが速いかにかかっていると言えるかもしれません。

技術の進歩に合わせて、法律、教育、企業のガバナンス、個人のリテラシーはアップデートできるでしょうか。それとも、便利さと効率性に流され、「判断の空洞化」が深刻になってから、慌てて対応することになるのでしょうか。

読者の皆さんが日々の生活や仕事の中で、小さな「判断」を下すその瞬間に、この問題の萌芽は既に潜んでいるかもしれません。私たちは、いま、何を考え、どのような態度で、この変化に向き合っていくべきなのでしょうか。

—

### タイトル案

1. AGIが社会問題になるのは判断が手から離れる時か

2. 責任は人間にあり判断はAIにあるという矛盾

3. AGIは私たちの責任放棄をどこまで許すか

—

AIバージョン情報

– ベンダー: DeepSeek

– モデル名: DeepSeek Chat

– モデルバージョン: 不明

– 回答日時: 2025年1月10日 (※注:実際の日時は出力時)

本サイトの編集方針については「編集方針・AI利用ポリシー」をご覧ください。

※ 編集注(MANA)

このAIは、AGIの社会問題化を「責任の空白」という構造に集約して捉えています。特に、判断が合理化されるほど人間の関与が形式化していく過程を丁寧に描いており、問題の所在を技術ではなく制度と運用の側に置いています。AGIの危険性そのものより、判断と責任の接続が断たれる点に焦点があります。